Sind Sie es leid, sich mit komplexen Web-Scraping-Tools herumzuschlagen, die sich wie ein Vollzeitjob anfühlen?

Wir verstehen, dass ihre Anwendung kompliziert sein kann.

Der Versuch, Daten von Websites abzurufen, kann mühsam sein, insbesondere wenn man auf ein Problem stößt.

Du verschwendest wertvolle Zeit und kommst nicht schnell voran.

Deshalb haben wir eine Liste der besten zusammengestellt. Scrape-Ersteller Alternativen. Dieser Leitfaden hilft Ihnen dabei, ein leistungsstarkes und einfaches Tool zu finden, um die benötigten Daten zu erhalten.

Lasst uns loslegen mit dem Scrapen!

Was sind die besten Alternativen zu Scrape Creators?

Wenn Sie nach einer besseren Methode zum Daten-Scraping suchen, sind Sie hier genau richtig.

Wir haben die besten Tools für Sie zusammengestellt, die sowohl einfach zu bedienen als auch leistungsstark sind. Unsere Liste umfasst sowohl unkomplizierte No-Code-Lösungen als auch leistungsstarke Tools für Entwickler.

Sie werden das perfekte Werkzeug für Ihre Bedürfnisse finden.

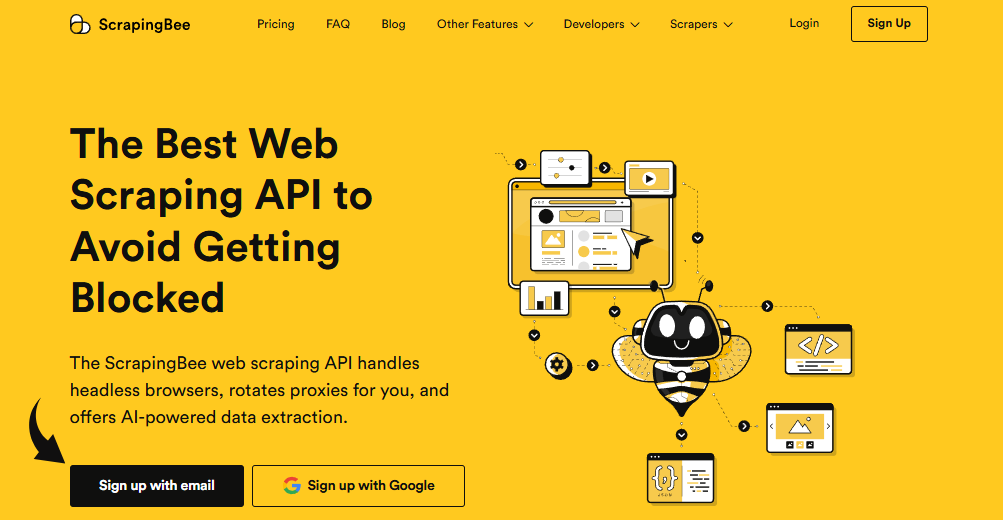

1. ScrapingBee (⭐4,8)

ScrapingBee ist eine Web-Scraping-API, die für Entwickler konzipiert wurde.

Es übernimmt für Sie die schwierigen Aufgaben, wie die Verwaltung von Headless-Browsern und die Rotation von Proxys.

Diese Scraping-API ist perfekt für Entwickler, die die technischen Schwierigkeiten des Web-Scrapings vermeiden möchten.

Es ist besonders nützlich zum Sammeln soziale Medien Daten für die Marktforschung.

Unsere Einschätzung

Holt euch Daten sie benötigen von über 98% der Webseiten. Schrott Die leistungsstarke Web-Schrotting-API von Bee bietet JavaScript-Rendering, Google Search API und die Fähigkeit, strukturierte Daten mit bis zu 99,5 % Genauigkeit auf dynamischen Websites zu extrahieren.

Wichtigste Vorteile

- Alles für Sie: Es verwaltet die Proxy-Drehung und JavaScript-Rendering automatisch.

- Einfache API: Sie erhalten saubere Daten zurück mit einem einzigen, unkomplizierten API-Anruf.

- 99,9% Uhrzeit: Die Plattform ist für ihre hohe Zuverlässigkeit und gleichbleibende Leistung bekannt.

- Umfangreiche Dokumentation: Bietet klare und umfassende Dokumentation mit Codebeispielen für mehrere Sprachen, so dass es einfach zu starten.

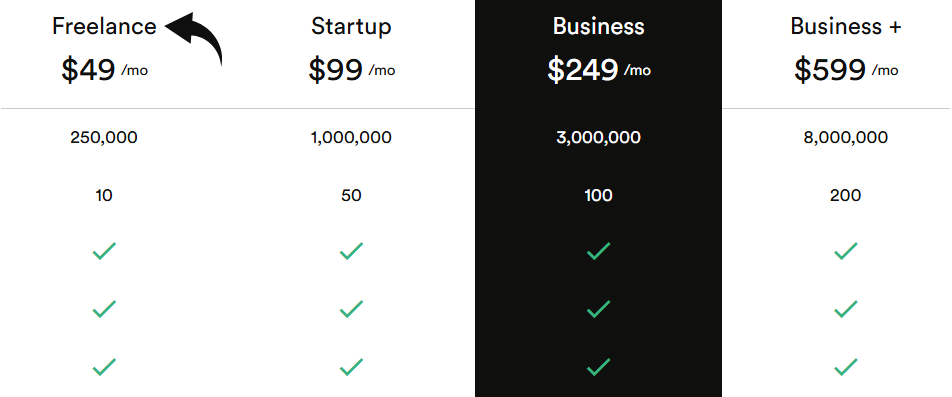

Preisgestaltung

Alle Pläne werden wird jährlich abgerechnet.

- Freelance: 49 US-Dollar pro Monat.

- Startup: 99 US-Dollar pro Monat.

- Geschäft: 249 US-Dollar pro Monat.

- Business+: $599/monat.

Vorteile

Nachteile

2. Apify (⭐4,5)

Apify ist eine Cloud-basierte Plattform für Web-Scraping und Automatisierung.

Es wurde sowohl für Programmierer als auch für Nicht-Programmierer entwickelt.

Sie können die riesige Bibliothek vorgefertigter Akteure nutzen, um Webseiten zu scrapen, ohne Code schreiben zu müssen.

This tool offers solutions for soziale Medien Datenextraktion.

Seine flexible Plattform und die große Sammlung an Werkzeugen machen Es ist einfach, mit dem Abkratzen zu beginnen.

Unsere Einschätzung

Möchten Sie die Macht der Authentifizierung für sich selbst sehen? Unsere Plattform wurde genutzt, um über 2,5 Millionen Webseiten abzukratzen und mehr als 500 TB Daten in einem Monat zu verarbeiten. Bereit zu beginnen?

Wichtigste Vorteile

- Massive Marketplace: Der Apify Store verfügt über über über 5.000 gebrauchsfertige Abstreifer und Automatisierungswerkzeuge namens Actors.

- Ultimative Skalierbarkeit: Für Aufgaben auf Unternehmensebene gebaut, kann es große Crawls von Millionen von Seiten verarbeiten.

- Entwickler-Freundly: Bietet einen Open-Source-SDK und unterstützt benutzerdefinierten Code in Python und JavaScript.

- Fortgeschrittene Regelung: Betätigen Sie Ihre Abstreifaufgaben in bestimmten Zeiten oder Intervallen ohne manuelle Arbeit.

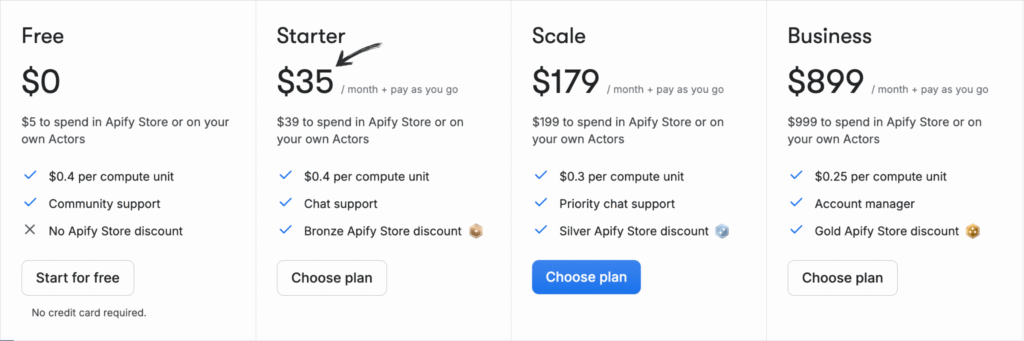

Preisgestaltung

Alle Pläne werden wird jährlich abgerechnet.

- Frei: $0/Monat + Pay as You Go.

- Anlasser: $35/Monat + Pay As You Go.

- Skala: $179/Monat + Pay As You Go.

- Geschäft: $899/Monat + Pay as You Go.

Vorteile

Nachteile

3. Oxylabs (⭐ zufällig)

Oxylabs ist ein vertrauenswürdiges Unternehmen für Web-Intelligence, das leistungsstarke Proxy-Dienste und Web-Scraping-Tools anbietet.

Es ist bekannt für sein großes Netzwerk an IP-Adressen und seine fortschrittlichen Funktionen.

Es kann Echtzeitdaten aus sozialen Medien und anderen Quellen sammeln.

Ihr leistungsstarker Web-Scraper ist für die komplexe Extraktion großer Datenmengen konzipiert.

Unsere Einschätzung

Entsperren Sie Daten mit einem führenden Proxy-Service. Mit über 175M Wohn-Proxies, 2M dedizierten Rechenzentrumsproxies und 20M mobilen Proxies gibt Oxylabs Ihnen die IP-Adressen, die Sie für jedes Projekt benötigen.

Wichtigste Vorteile

- OxyCopilot AI Assistant: Mit diesem Tool können Sie Schrottanfragen mit einfacher, natürlicher Sprache erstellen.

- Huge Proxy Network: Hat einen der größten Proxy-Pools der Welt mit IPs aus 195 Ländern.

- Garantierter Erfolg: Die AI-getriebene Fingerabdrückung und CAPTCHA Bypass sorgen für eine hohe Erfolgsquote auch an den härtesten Standorten.

- Enterprise-Grade Security: Die Plattform ist ISO/IEC 27001:2022 zertifiziert und sorgt für hohe Datensicherheit und Datenschutz.

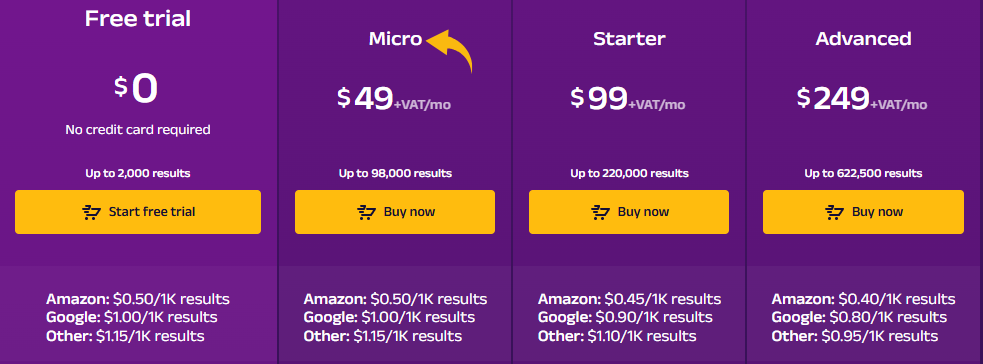

Preisgestaltung

- Kostenlose Testversion: $0.

- Mikro: 49 $/Monat + MwSt.

- Anlasser: $99/Monat + MwSt.

- Fortschrittlich: $249/Monat + MwSt.

Vorteile

Nachteile

4. Durchsuchen Sie KI (⭐3,8)

Browse AI ist ein No-Code-Webportal. Schabewerkzeug.

Es ermöglicht Ihnen, einen Roboter so zu trainieren, dass er Daten von beliebigen Websites erfasst. Die intuitive Benutzeroberfläche macht die Datenextraktion kinderleicht.

Es beinhaltet außerdem vorgefertigte Roboter für Social-Media-Daten und ist damit ein hervorragender Web-Scraper für Marketer.

Entfesseln Sie sein Potenzial mit unserem KI-Tutorial durchsuchen.

Unsere Einschätzung

Sie möchten Zeit sparen und die benötigten Daten erhalten? Browse AI kann Millionen von Websites verarbeiten. Entdecken Sie, wie einfach Web-Scraping sein kann.

Wichtigste Vorteile

- Kein Code Erforderlich: Die Punkt-und-Klick-Schnittstelle ermöglicht es jedem, einen Datenschaber in Minuten zu bauen.

- KI-Powered Adaptability: Das Tool passt sich automatisch an Änderungen im Layout einer Website an, sodass Ihre Daten stets konsistent sind.

- 7.000+ Integrationen: Verbinden Sie Ihre Daten einfach mit Apps wie Google Sheets, Airtable und Zapier.

- Vorgefertigte Roboter: Zugriff auf eine Bibliothek von vorgefertigten Robotern für gemeinsame Aufgaben auf beliebten Webseiten, so dass Sie noch mehr Zeit sparen.

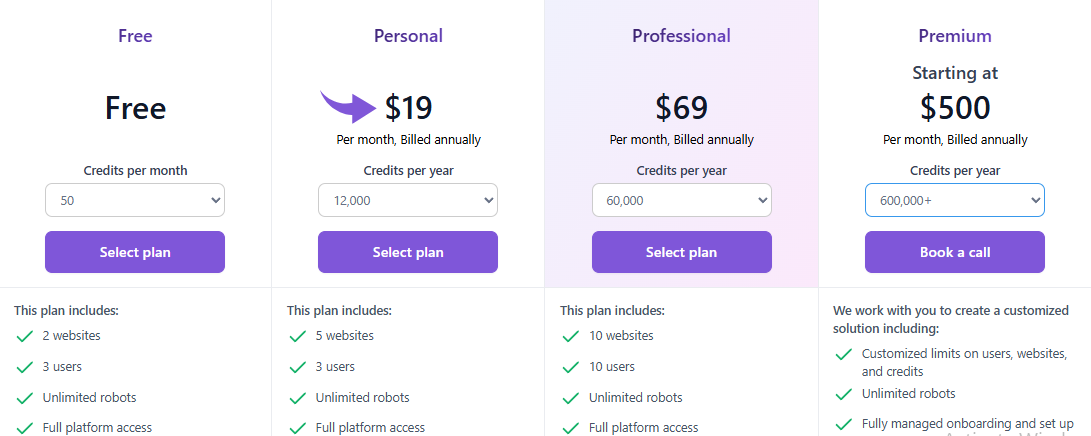

Preisgestaltung

Alle Pläne werden wird jährlich abgerechnet.

- Frei: $0.

- Persönlich: $19/monat .

- Professional: 69 US-Dollar pro Monat.

- Prämie: Ab $500/Monat.

Vorteile

Nachteile

5. Zyte (⭐)

Zyte ist eine Full-Stack-Plattform für Web-Scraping.

Es existiert schon lange und genießt das Vertrauen vieler.

Es unterstützt Entwickler beim Hosten und Verwalten ihrer Webcrawler in der Cloud. Zudem bietet es eine leistungsstarke API, die den Bot-Schutz übernimmt.

Die Plattform von Zyte ist für die großflächige Extraktion von Social-Media-Daten konzipiert.

Unsere Einschätzung

Erhalten Sie das zuverlässigste Web Daten mit Zyte API. Erzielen Sie mit dieser hochwertigen Web-Schrott-API 99,99% Datengenauigkeit für Ihre Projekte und optimieren Sie Ihren Datenextraktionsprozess heute.

Wichtigste Vorteile

- Automatische Entsperrung: Hör auf, die Proxis zu krümmen; Zyte API ist ein leistungsfähiges automatisiertes Werkzeug für die Handhabung von Verboten.

- Nahtlose Scrapy Integration: Wenn Sie ein Entwickler sind, der das Scrapy-Framework nutzt, passt Zyte richtig in.

- AI-Powered Data Extraction: Das Tool kann automatisch Daten identifizieren und parse, wodurch die Notwendigkeit manueller Parsing-Regeln reduziert werden.

- Integrierter Headless-Browser: Keine Notwendigkeit für Drittanbieter-Headless-Browser, wie Zyte bietet eine, die für Web-Schrott im Maßstab optimiert ist.

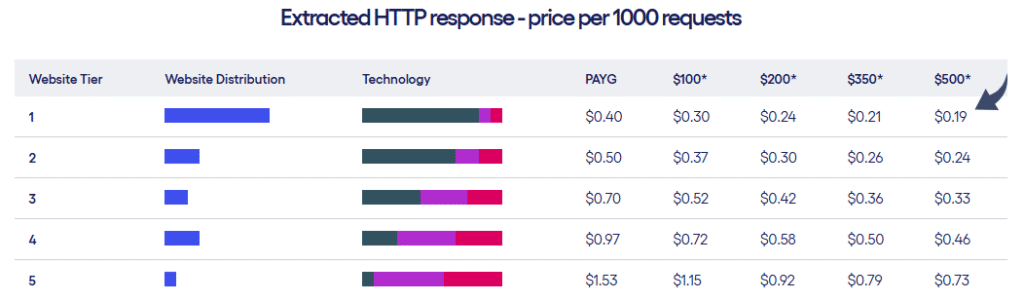

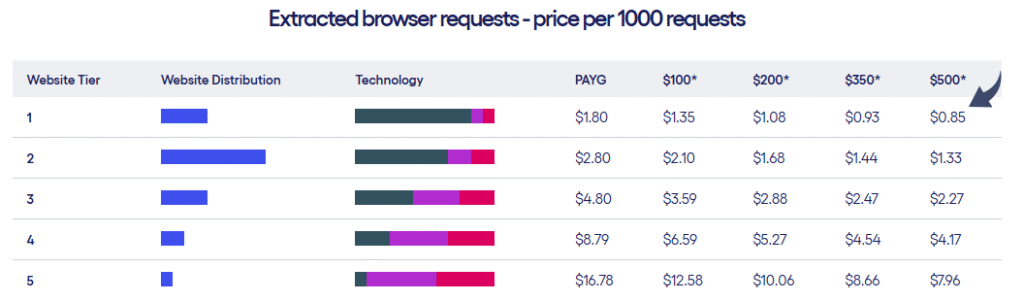

Preisgestaltung

- Zyte bietet zwei Arten von Preisplänen basierend auf den Websites Tier und die Anzahl der Anfragen, die Sie machen.

Vorteile

Nachteile

6. ScrapeGraph AI (⭐

ScrapeGraph AI ist eine einzigartige Python-Bibliothek, die KI zum Auslesen von Webseiten nutzt.

Sie geben einfach in einfacher Sprache an, welche Informationen Sie benötigen.

Anschließend werden die Daten mithilfe eines graphenbasierten Ansatzes für Sie abgerufen.

Es handelt sich um einen neuen Ansatz für Web-Scraping. Dieses KI-gestützte Tool vereinfacht die Extraktion komplexer Daten.

Unsere Einschätzung

Führende Profis (350+) vertrauen ScrapeGraphAI für seine robusten KI-getriebenen Web-Schrott-Funktionen. Sichern Sie sich eine Effizienzsteigerung von 20% für die nächsten 48 Stunden.

Wichtigste Vorteile

- Natural Language Scraping: Man kann ihm sagen, was man mit einfachen, humanähnlichen Aufforderungen extrahieren soll.

- Open-Source Bibliothek: Entwickler können die leistungsstarke Open-Source-Bibliothek für maximale Kontrolle nutzen.

- Kennzeichnung Feature: Es kann ganze Webseiten in saubere, lesbare Markdown-Dokumente umwandeln.

- Agentic Scraper: Die KI kann autonom navigieren und mit Webseiten interagieren, um komplexe, mehrstufige Aufgaben zu erledigen.

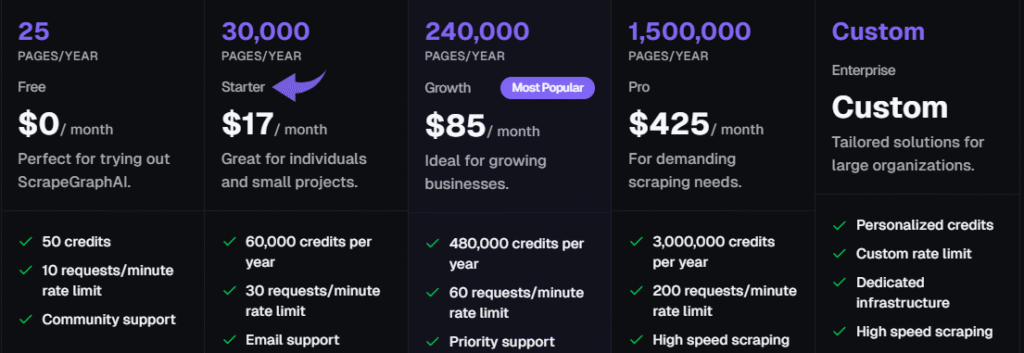

Preisgestaltung

Alle Pläne werden wird jährlich abgerechnet.

- Frei: 0 €/Monat.

- Anlasser: 17 Dollar pro Monat.

- Wachstum: 85 US-Dollar pro Monat.

- Pro: $425/monat.

- Unternehmen: Individuelle Preisgestaltung.

Vorteile

Nachteile

7. ThorData (⭐

ThorData ist eine Plattform, die sowohl Proxy-Infrastruktur als auch Web-Scraping-Tools anbietet.

Die Universal Scraping API ist so konzipiert, dass sie das Verhalten realer Menschen für fortgeschrittene Scraping-Aufgaben nachahmt.

Dieser Web-Scraper bietet sowohl eine Option ohne Programmierung als auch eine leistungsstarke API für Entwickler.

Es kann Echtzeitdaten von Social-Media-Plattformen erfassen.

Unsere Einschätzung

Erleben Sie unübertroffene Sicherheit mit ThorData. Es’ Daten der Verifikationsprozess gewährleistet eine Erfolgsquote von 99,7%. Mit 24/7 Live-Unterstützung und einer durchschnittlichen Reaktionszeit von weniger als 3 Minuten können Sie ihm vertrauen’s Verbindungsqualität. Erhalten Sie über 60 Millionen IP-Adressen und sichern Sie Ihre Daten.

Wichtigste Vorteile

- Riesiger IP-Pool: Bietet über 60 Millionen ethisch bezogene Wohn-IPs.

- Hohe Anonymität: Vergewissern Sie sich, dass Ihre Abstreifungsaktivität mit seinen hochwertigen Proxien unentdeckt bleibt.

- Pay-as-you-go: Die Abrechnung ist transparent; Sie zahlen nur für den von Ihnen genutzten Verkehr, nicht für fehlgeschlagene Anfragen.

- Eingebauter Scraper: Enthält einen No-Code Web Scraper und eine universelle API, so dass Sie kein separates Werkzeug für einfache Projekte benötigen.

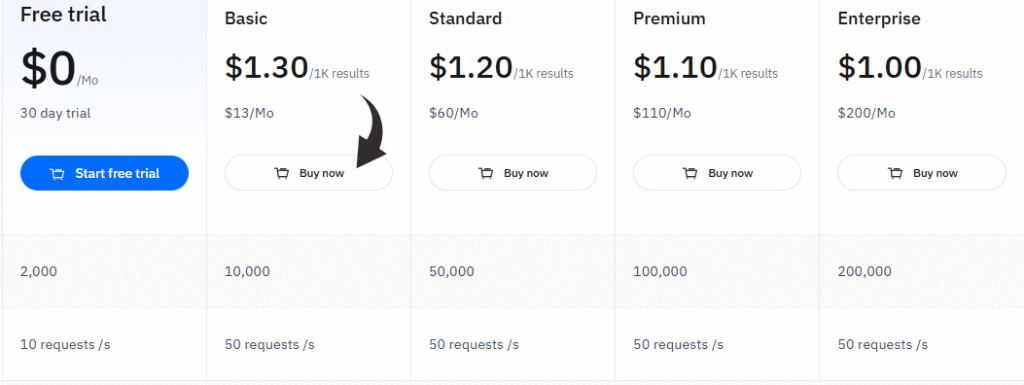

Preisgestaltung

- Kostenlose Testversion: $0/monat, 30 tage test.

- Basic: $13/monat.

- Standard: $60/monat.

- Prämie: $110/monat.

- Unternehmen: 200 US-Dollar pro Monat.

Vorteile

Nachteile

Käuferleitfaden

Wir haben jedes Produkt anhand mehrerer Schlüsselfaktoren bewertet, um sicherzustellen, dass unsere Empfehlungen die besten sind.

Wir haben uns angeschaut, was die einzelnen Web-Scraper auszeichnet und was ihnen möglicherweise fehlt.

Unser Rechercheprozess war einfach und darauf ausgerichtet, Ihnen die Informationen zu liefern, die Sie für eine gute Entscheidung benötigen.

Hier und #8217;s wie wir es getan haben:

- Preisgestaltung: Wir haben die Preise der einzelnen Tools geprüft und unter anderem untersucht, ob eine kostenlose Testversion oder ein kostenloser Tarif für den Einstieg angeboten wird. Wir haben verschiedene Preismodelle verglichen, um Optionen für unterschiedliche Budgets zu finden.

- Merkmale: Wir haben die Funktionen jedes Tools genau unter die Lupe genommen. Dabei haben wir unter anderem auf eine benutzerfreundliche Point-and-Click-Oberfläche, die Fähigkeit zur Echtzeitdatenverarbeitung und eine leistungsstarke API geachtet. Außerdem haben wir geprüft, ob eine Google Sheets-Integration zur einfacheren Datenerfassung vorhanden ist.

- Negatives: Wir suchten nach potenziellen Nachteilen. Gab es eine steile Lernkurve? Hatte das Tool Probleme mit Anti-Scraping-Maßnahmen? Fehlte etwas, das das Tool für Aufgaben wie diese weniger nützlich machen würde? TikTok oder andere spezifische Plattformen wie soziale Medien?

- Unterstützung & Community: Wir haben untersucht, welche Art von Unterstützung die einzelnen Anbieter bieten. Wir haben geprüft, ob sie ein Community-Forum, hilfreiche Anleitungen oder direkten Kundensupport anbieten. Außerdem haben wir ihre Rückerstattungsrichtlinien berücksichtigt.

- Leistung: Wir haben bewertet, wie gut die einzelnen Tools Daten extrahieren und als saubere, strukturierte Daten zurückgeben können. Außerdem haben wir untersucht, wie gut die Scraper gängige Herausforderungen bewältigen können, ohne blockiert zu werden.

- KI-Integration: Wir haben nach Tools gesucht, die KI-Agenten oder andere KI-Funktionen nutzen, um das Web-Scraping intelligenter und effizienter zu gestalten.

Zusammenfassung

Das richtige und beste Werkzeug für Ihre Bedürfnisse zu finden, kann eine Herausforderung sein.

Wir haben uns viele verschiedene Optionen angesehen, um Ihnen bei der Suche nach dem besten Web-Data-Scraper zu helfen.

Wir haben die wichtigsten Funktionen, die Preisgestaltung und die Bedienfreundlichkeit berücksichtigt.

Sie können sich jetzt das für Sie passende Werkzeug aussuchen.

Ob Sie eine einfache Point-and-Click-Oberfläche oder eine leistungsstarke API benötigen, die komplexe Anfragen verarbeitet.

Mit dem richtigen Tool können Sie Daten aus einer Vielzahl von Plattformen und Websites extrahieren, um das zu entwickeln, was Sie für die Skalierung benötigen.

Häufig gestellte Fragen

Is web scraping illegal?

Generally, no. It’s legal for public data. Courts, like in the hiQ vs. LinkedIn case, have protected the scraping of publicly available information. However, bypassing paywalls or harvesting personal data is a legal “no-go.” Always respect a site’s robots.txt file.

Is it possible to scrape data from a website?

Absolutely. Almost any public site can be scraped. While some sites use advanced anti-bot shields, modern tools like ScraperAPI are designed to bypass these blocks effortlessly. If the data is visible to a standard browser, a scraper can likely extract it.

Which is best for web scraping?

It depends on your skill. Developers typically swear by Scrapy or BeautifulSoup for total customization. If you prefer a visual approach, Octoparse is the winner. For massive enterprise projects requiring heavy anti-bot protection, Bright Data is the undisputed industry leader.

What is the best tool for web scraping?

Bright Data is widely considered the best for power and reliability. It handles proxy rotation and CAPTCHAs without breaking a sweat. For those on a budget, ParseHub or Octoparse offer excellent free tiers that work perfectly for smaller, straightforward projects.

Which scraping tool is best for beginners?

Octoparse is the gold standard for non-coders. It features a point-and-click interface, allowing you to select data directly on the screen. No coding required. ParseHub is another fantastic visual alternative that makes complex data extraction feel like a simple walkthrough.

Can ChatGPT create a web scraper?

Yes, and it’s fast. ChatGPT can generate Python scripts using BeautifulSoup or Selenium in seconds. While it provides the logic, you still need to execute the code yourself. It’s perfect for simple tasks, though complex sites might require some manual fine-tuning.

What is an example of web scraping?

Price monitoring is the classic use case. Retailers scrape sites like Amazon to adjust their own prices dynamically. Other examples include pulling Immobilie listings, gathering sports stats for analysis, or aggregating news for AI training. It turns the web into a structured database.

More Facts about Scrape creators Alternatives

- ScrapingBee, Apify, and Octoparse are great choices if you don’t want to use Scrape Creators. They work well for social media and online shops.

- In 2026, the best tools for getting data from websites are Bright Data, ScrapingBee, Apify, and Octoparse.

- ScrapingBee is a helpful tool that handles tricky website code and hides your identity while you work.

- ScrapingFish is built to be very fast and doesn’t waste any time.

- ScrapingAnt is an easy-to-use tool that gets the job done without any extra fuss.

- Scrapfly is a simple tool that can grow as your project gets bigger.

- ZenRows is great at getting past “robot blockers” on modern websites to get the info you need.

- Oxylabs has a special tool that helps it get into “stubborn” websites that try to block users.

- A web scraper is good for projects that need to pull large amounts of data regularly. It can even read websites that change or update while you are looking at them.

- Scraper API lets you take data from any public site without worrying about technical blocks like “I am not a robot” tests (CAPTCHA). You can even try it for free for 7 days.

- ParseHub is a program you download to your computer that helps you get data without writing any code.

- Scrapy is a famous tool for giant projects, but it’s like a “manual” car—you have to set up the tricky parts yourself.

- Most of these tools are easy to use, with simple buttons that make the work easier. Many “no-code” tools can do the work automatically, saving you time.

- No-code tools are smart enough to read websites that use complex computer code (JavaScript).

- You can save your data in common files like Excel, Google Sheets, or simple lists (JSON).

- Some tools have “starter kits” or templates that help you begin scraping popular websites right away.

- Bright Data has the world’s largest network, with over 150 million connections. It is a specialist at helping people scrape shopping websites.

- Web scraping APIs make it much easier to pull information off the web and turn a messy website into a neat, organized list.

- People use these tools for things like market research or seeing what prices their competitors are charging.

- Octoparse has a “visual Bauherr” that automatically highlights lists and tables on a website for you. It lets you turn any website into a list without knowing how to code.

- Feuerkriechgang is a newer tool made specifically for AI. It turns web pages into a format that AI programs like to read.

- Selenium and Playwright are tools that act like a real person clicking and scrolling on a website.

- Kadoa is a very smart tool that figures out what data is on its own, even if the website changes its layout.

- Oxylabs has an AI helper called OxyCopilot that lets you request the data you want using everyday words.