Haben Sie jemals das Gefühl, aus einem Feuerwehrschlauch trinken zu wollen, wenn Sie Daten aus dem Internet benötigen?

Das ist frustrierend. Was wäre, wenn es einen besseren Weg gäbe?

Künstliche Intelligenz verändert die Spielregeln und macht das Web-Scraping für viele zu einer frustrierenden Angelegenheit.

Kein Herumhantieren mehr mit komplexem Code oder dem Risiko, von Anti-Bot-Maßnahmen erwischt zu werden.

Deshalb haben wir in diesem Artikel diese Liste der 7 besten KI-Web-Scraping-Tools zur Datenextraktion im Jahr 2025 zusammengestellt.

Wenn Sie mit dem Lesen fertig sind, wissen Sie genau, welches Werkzeug Sie verwenden müssen, um die benötigten Daten zu erhalten.

Was sind die besten KI-Web-Scraping-Tools?

Bei so vielen verfügbaren Optionen kann es unmöglich erscheinen, das beste Werkzeug zu finden.

Die richtige Wahl hängt davon ab, wofür Sie es benötigen – ob für ein einfaches Projekt oder eine umfangreiche Datenerfassungsaufgabe.

Keine Sorge, wir haben die Arbeit für Sie erledigt. Hier ist unsere Liste der besten KI-Web-Scraping-Tools.

1. Genehmigung (⭐.4.8)

Apify ist eine Full-Stack-Plattform für Web-Scraping.

Man kann es sich als Komplettlösung für die Datenextraktion vorstellen. Es ist extrem flexibel – man kann vorgefertigte Scraper verwenden oder eigene, individuelle erstellen.

Es ist ein großartiges Werkzeug für Entwickler, die eine leistungsstarke, skalierbare Lösung wünschen.

Es verwandelt außerdem jede Website in eine nutzbare API und ermöglicht so eine einfache Integration in Ihre bestehenden Systeme.

Unsere Einschätzung

Möchten Sie die Macht der Authentifizierung für sich selbst sehen? Unsere Plattform wurde genutzt, um über 2,5 Millionen Webseiten abzukratzen und mehr als 500 TB Daten in einem Monat zu verarbeiten. Bereit zu beginnen?

Wichtigste Vorteile

- Massive Marketplace: Der Apify Store verfügt über über über 5.000 gebrauchsfertige Abstreifer und Automatisierungswerkzeuge namens Actors.

- Ultimative Skalierbarkeit: Für Aufgaben auf Unternehmensebene gebaut, kann es große Crawls von Millionen von Seiten verarbeiten.

- Entwickler-Freundly: Bietet einen Open-Source-SDK und unterstützt benutzerdefinierten Code in Python und JavaScript.

- Fortgeschrittene Regelung: Betätigen Sie Ihre Abstreifaufgaben in bestimmten Zeiten oder Intervallen ohne manuelle Arbeit.

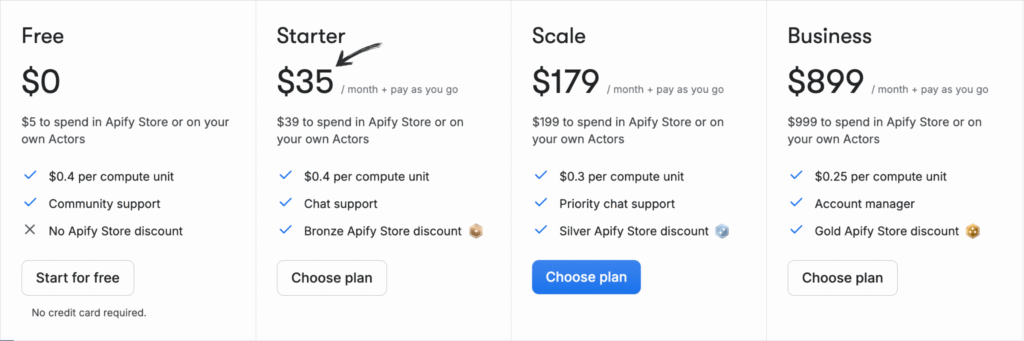

Preisgestaltung

Alle Pläne werden wird jährlich abgerechnet.

- Frei: $0/Monat + Pay as You Go.

- Anlasser: $35/Monat + Pay As You Go.

- Skala: $179/Monat + Pay As You Go.

- Geschäft: $899/Monat + Pay as You Go.

Vorteile

Nachteile

2. Oxylabs (⭐4,5)

Oxylabs ist bekannt für seine erstklassigen Proxy-Dienste, aber auch eine leistungsstarke Web-Scraping-Plattform.

Es ist eine hervorragende Wahl für Unternehmen, die Daten in großem Umfang extrahieren müssen, ohne blockiert zu werden.

Ihre KI-Funktionen machen Dynamische Websites lassen sich kinderleicht scrapen.

Es handelt sich um einen erstklassigen Service, dem große Unternehmen und Konzerne aufgrund seiner Zuverlässigkeit vertrauen. Sicherheit.

Unsere Einschätzung

Entsperren Sie Daten mit einem führenden Proxy-Service. Mit über 175M Wohn-Proxies, 2M dedizierten Rechenzentrumsproxies und 20M mobilen Proxies gibt Oxylabs Ihnen die IP-Adressen, die Sie für jedes Projekt benötigen.

Wichtigste Vorteile

- OxyCopilot AI Assistant: Mit diesem Tool können Sie Schrottanfragen mit einfacher, natürlicher Sprache erstellen.

- Huge Proxy Network: Hat einen der größten Proxy-Pools der Welt mit IPs aus 195 Ländern.

- Garantierter Erfolg: Die AI-getriebene Fingerabdrückung und CAPTCHA Bypass sorgen für eine hohe Erfolgsquote auch an den härtesten Standorten.

- Enterprise-Grade Security: Die Plattform ist ISO/IEC 27001:2022 zertifiziert und sorgt für hohe Datensicherheit und Datenschutz.

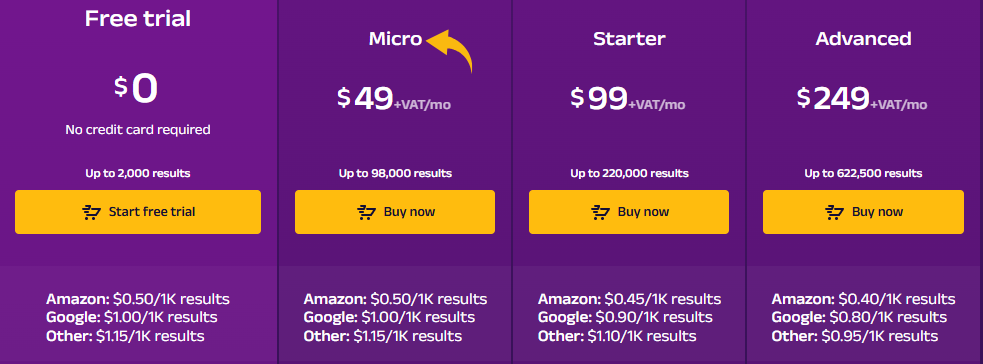

Preisgestaltung

- Kostenlose Testversion: $0.

- Mikro: 49 $/Monat + MwSt.

- Anlasser: $99/Monat + MwSt.

- Fortschrittlich: $249/Monat + MwSt.

Vorteile

Nachteile

3. ScrapingBee (⭐4.0)

Schabebiene ist eine Web-Scraping-API, die entwickelt wurde, um Entwicklern das Leben zu erleichtern.

Sie müssen sich keine Gedanken über Proxys, Headless-Browser oder IP-Sperren machen.

Senden Sie einfach eine Anfrage, und es kümmert sich um den Rest.

Es eignet sich perfekt zur Integration der Datenextraktion in Ihre Anwendungen.

Es kümmert sich um alle technischen Probleme, sodass Sie sich auf Ihren Code konzentrieren können.

Unsere Einschätzung

Holt euch Daten sie benötigen von über 98% der Webseiten. Schrott Die leistungsstarke Web-Schrotting-API von Bee bietet JavaScript-Rendering, Google Search API und die Fähigkeit, strukturierte Daten mit bis zu 99,5 % Genauigkeit auf dynamischen Websites zu extrahieren.

Wichtigste Vorteile

- Alles für Sie: Es verwaltet die Proxy-Drehung und JavaScript-Rendering automatisch.

- Einfache API: Sie erhalten saubere Daten zurück mit einem einzigen, unkomplizierten API-Anruf.

- 99,9% Uhrzeit: Die Plattform ist für ihre hohe Zuverlässigkeit und gleichbleibende Leistung bekannt.

- Umfangreiche Dokumentation: Bietet klare und umfassende Dokumentation mit Codebeispielen für mehrere Sprachen, so dass es einfach zu starten.

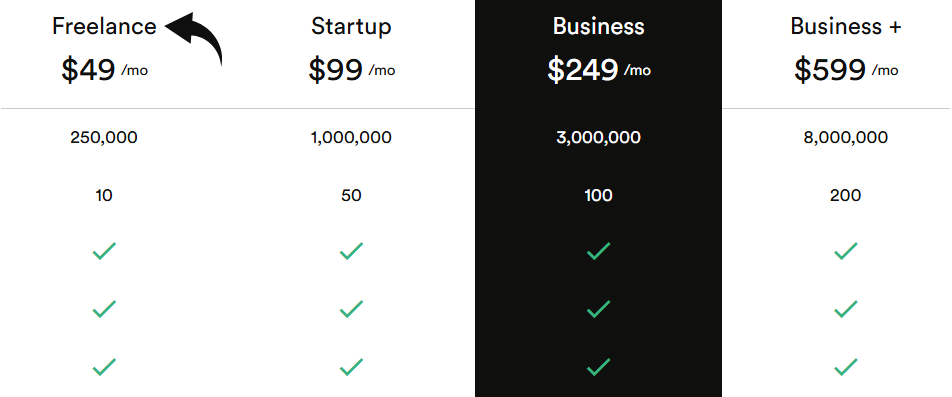

Preisgestaltung

Alle Pläne werden wird jährlich abgerechnet.

- Freelance: 49 US-Dollar pro Monat.

- Startup: 99 US-Dollar pro Monat.

- Geschäft: 249 US-Dollar pro Monat.

- Business+: $599/monat.

Vorteile

Nachteile

4. Durchsuchen Sie KI (⭐3,8)

Müssen Sie Daten extrahieren, wissen aber nicht, wie man programmiert? Durchsuchen Sie KI ist für dich.

Es handelt sich um ein Tool ohne Programmierung, mit dem Sie einen Roboter trainieren können, Daten zu extrahieren und zu überwachen, indem Sie einfach darauf zeigen und klicken.

Es ist unglaublich benutzerfreundlich und perfekt für Anwender ohne technische Vorkenntnisse.

Sie können sogar Überwachungsfunktionen einrichten, um Echtzeitwarnungen zu erhalten, wenn sich eine Website ändert.

Entfesseln Sie sein Potenzial mit unserem KI-Tutorial durchsuchen.

Unsere Einschätzung

Sie möchten Zeit sparen und die benötigten Daten erhalten? Browse AI kann Millionen von Websites verarbeiten. Entdecken Sie, wie einfach Web-Scraping sein kann.

Wichtigste Vorteile

- Kein Code Erforderlich: Die Punkt-und-Klick-Schnittstelle ermöglicht es jedem, einen Datenschaber in Minuten zu bauen.

- KI-Powered Adaptability: Das Tool passt sich automatisch an Änderungen im Layout einer Website an, sodass Ihre Daten stets konsistent sind.

- 7.000+ Integrationen: Verbinden Sie Ihre Daten einfach mit Apps wie Google Sheets, Airtable und Zapier.

- Vorgefertigte Roboter: Zugriff auf eine Bibliothek von vorgefertigten Robotern für gemeinsame Aufgaben auf beliebten Webseiten, so dass Sie noch mehr Zeit sparen.

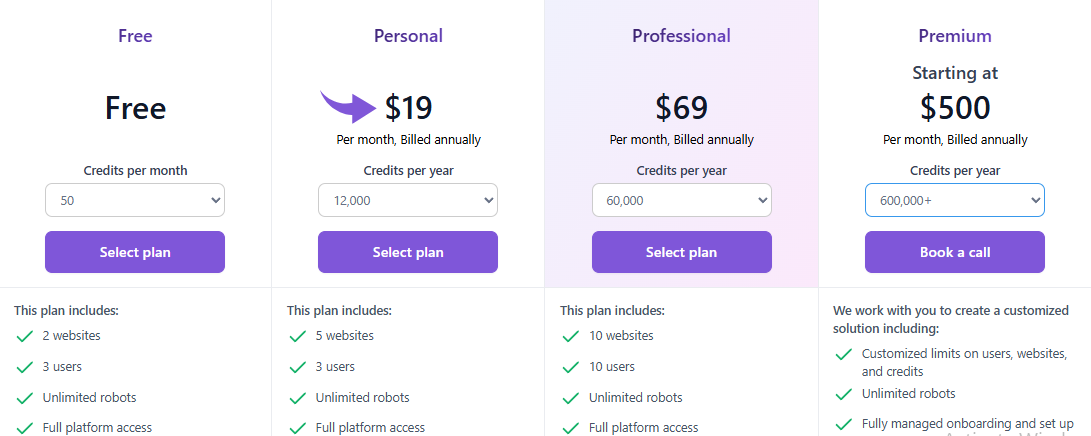

Preisgestaltung

Alle Pläne werden wird jährlich abgerechnet.

- Frei: $0.

- Persönlich: $19/monat .

- Professional: 69 US-Dollar pro Monat.

- Prämie: Ab $500/Monat.

Vorteile

Nachteile

5. Zyte (⭐)

Zyte ist ein etablierter Akteur in der Welt des Web-Scrapings.

Es handelt sich um eine umfassende Plattform, die eine leistungsstarke Scraping-API und eine Reihe von Tools für groß angelegte Datenprojekte bietet.

Es ist zuverlässig, skalierbar und genießt das Vertrauen vieler.

Die einzigartige KI-Technologie des Unternehmens kann selbst die anspruchsvollsten Websites bewältigen.

Unsere Einschätzung

Erhalten Sie das zuverlässigste Web Daten mit Zyte API. Erzielen Sie mit dieser hochwertigen Web-Schrott-API 99,99% Datengenauigkeit für Ihre Projekte und optimieren Sie Ihren Datenextraktionsprozess heute.

Wichtigste Vorteile

- Automatische Entsperrung: Hör auf, die Proxis zu krümmen; Zyte API ist ein leistungsfähiges automatisiertes Werkzeug für die Handhabung von Verboten.

- Nahtlose Scrapy Integration: Wenn Sie ein Entwickler sind, der das Scrapy-Framework nutzt, passt Zyte richtig in.

- AI-Powered Data Extraction: Das Tool kann automatisch Daten identifizieren und parse, wodurch die Notwendigkeit manueller Parsing-Regeln reduziert werden.

- Integrierter Headless-Browser: Keine Notwendigkeit für Drittanbieter-Headless-Browser, wie Zyte bietet eine, die für Web-Schrott im Maßstab optimiert ist.

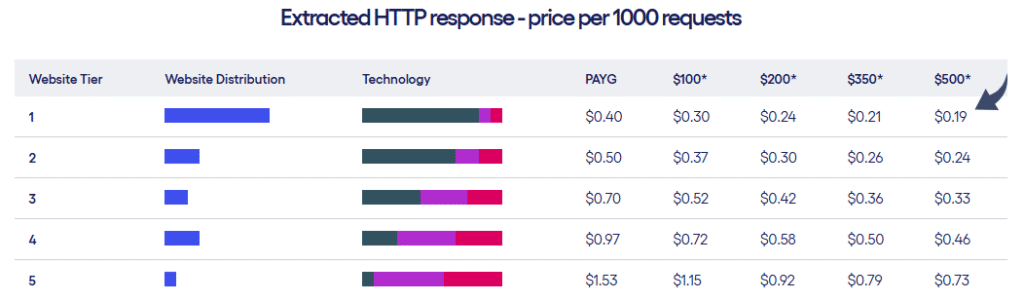

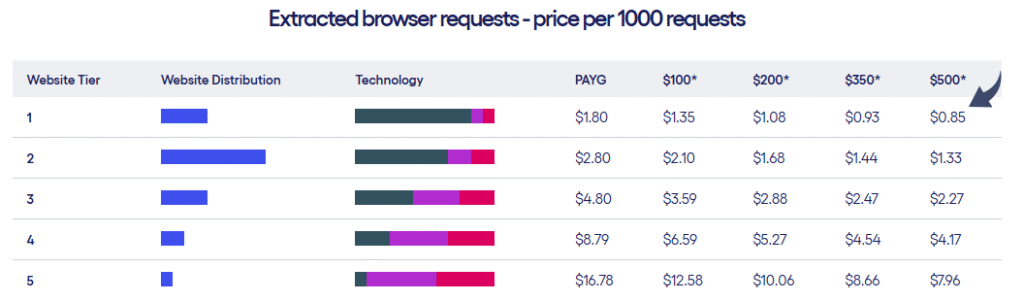

Preisgestaltung

- Zyte bietet zwei Arten von Preisplänen basierend auf den Websites Tier und die Anzahl der Anfragen, die Sie machen.

Vorteile

Nachteile

6. Scrape Creators (⭐3.2)

Scrape-Ersteller ist ein Spezialwerkzeug.

Es konzentriert sich darauf, das Extrahieren von Daten von beliebten Quellen zu vereinfachen. soziale Medien Plattformen.

Sie können Echtzeitinformationen von Websites wie diesen abrufen. TikTok, Twitch und Pinterest, ohne sich mit deren komplexen offiziellen APIs auseinandersetzen zu müssen.

Für Marketingfachleute und Forscher, die genau diese Art von Daten benötigen, ist dies ein Wendepunkt.

Unsere Einschätzung

Bemühen Sie sich nicht, soziale Mediendaten zu sammeln. Mit Scrape Creators, erhalten Echtzeit-Daten von Plattformen wie Twitch und Pinterest. Begleiten Sie Hunderte von Nutzern, die über 6 Millionen Anfragen abgekratzt haben und die von Ihnen benötigten Erkenntnisse gewinnen.

Wichtigste Vorteile

- Spezialisierte APIs: Bietet vorgefertigte Lösungen speziell für Social Media Plattformen.

- Keine API-Schlüssel erforderlich: Sie können die Notwendigkeit von offiziellen API-Tasten von Websites wie Twitch umgehen.

- Pay-as-you-go: Sie zahlen nur für das, was Sie verwenden, und Ihre Kredite verfallen nie.

- Reichen Sie JSON Daten: Die APIs bieten saubere, strukturierte JSON-Daten, so dass Sie keine zusätzlichen Parsing tun müssen.

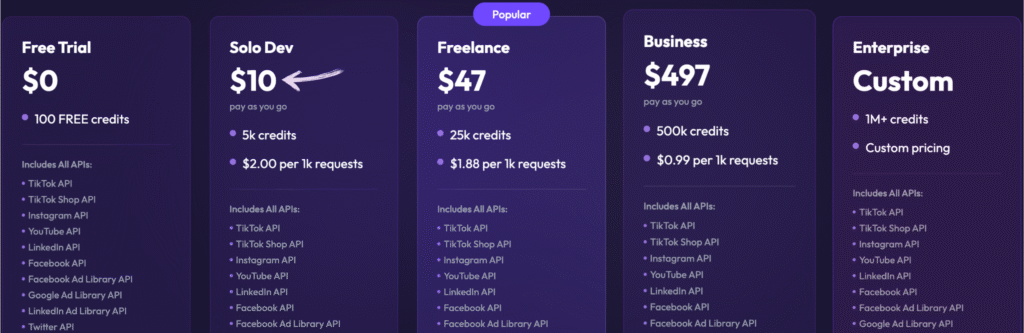

Preisgestaltung

- Kostenlose Testversion: 0 $, 100 Credits gratis.

- Solo Dev: $10 & #8211; Pay as You Go, 5k credits.

- Freelance: $47 & #8211; Pay as You Go, 25k credits.

- Geschäft: $497 & #8211; Pay as You Go, 500k credits.

- Unternehmen: Individuelle Preisgestaltung, über 1 Million Credits.

Vorteile

Nachteile

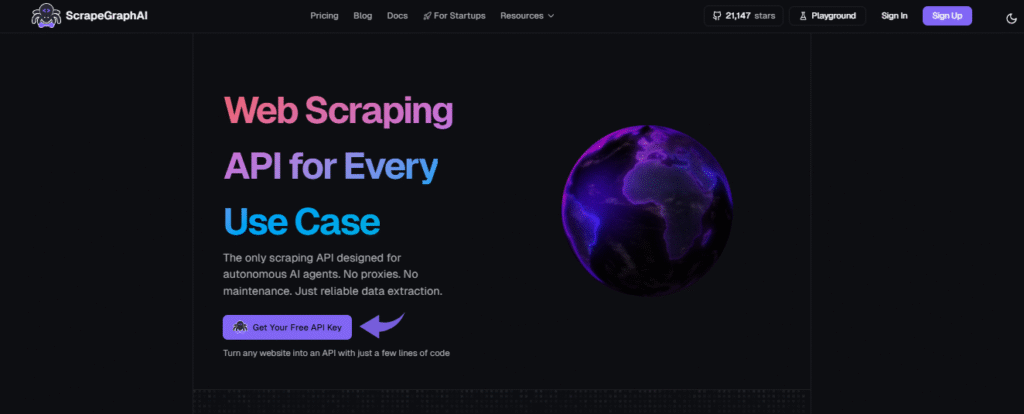

7. ScrapeGraph AI (⭐3.0)

SchrottGraph AI ist ein ganz besonderes Werkzeug.

Es verwendet große Sprachmodelle (LLMs), um zu verstehen, was Sie scrapen möchten.

Sie geben einfach eine URL an und beschreiben in einfacher Sprache, welche Daten abgerufen werden sollen.

Kein Hantieren mehr mit komplexem Code oder Selektoren.

Dieses Tool eignet sich hervorragend sowohl für Entwickler als auch für technisch nicht versierte Anwender, die KI zur Datenextraktion nutzen möchten.

Unsere Einschätzung

Führende Profis (350+) vertrauen ScrapeGraphAI für seine robusten KI-getriebenen Web-Schrott-Funktionen. Sichern Sie sich eine Effizienzsteigerung von 20% für die nächsten 48 Stunden.

Wichtigste Vorteile

- Natural Language Scraping: Man kann ihm sagen, was man mit einfachen, humanähnlichen Aufforderungen extrahieren soll.

- Open-Source Bibliothek: Entwickler können die leistungsstarke Open-Source-Bibliothek für maximale Kontrolle nutzen.

- Kennzeichnung Feature: Es kann ganze Webseiten in saubere, lesbare Markdown-Dokumente umwandeln.

- Agentic Scraper: Die KI kann autonom navigieren und mit Webseiten interagieren, um komplexe, mehrstufige Aufgaben zu erledigen.

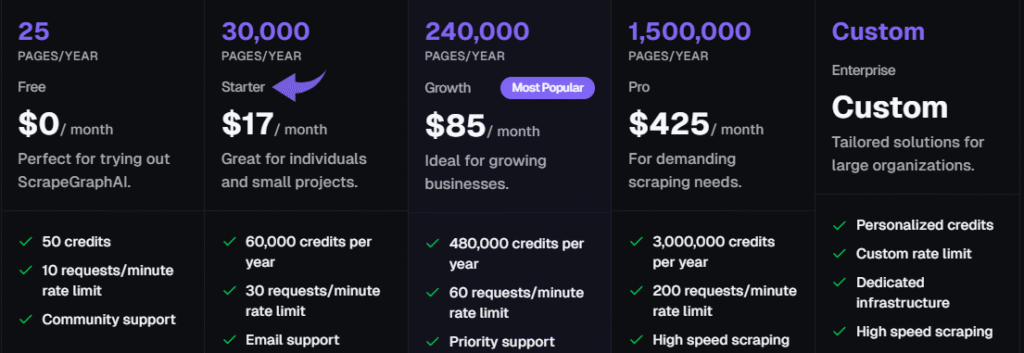

Preisgestaltung

Alle Pläne werden wird jährlich abgerechnet.

- Frei: 0 €/Monat.

- Anlasser: 17 Dollar pro Monat.

- Wachstum: 85 US-Dollar pro Monat.

- Pro: $425/monat.

- Unternehmen: Individuelle Preisgestaltung.

Vorteile

Nachteile

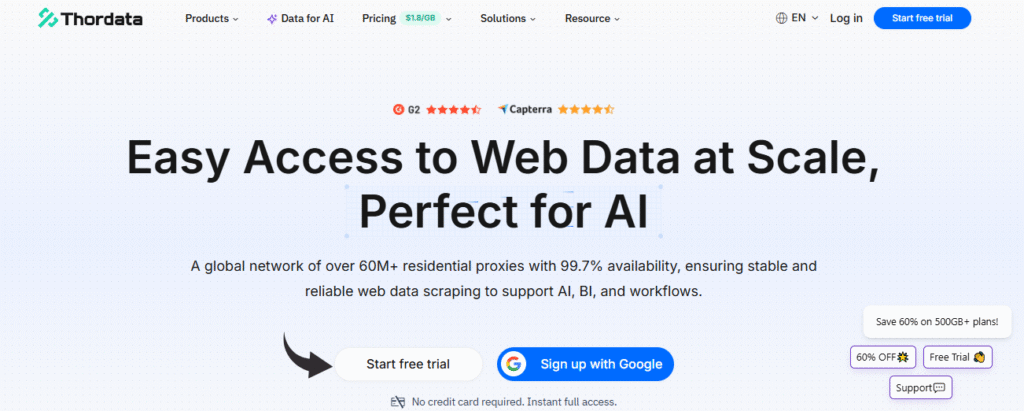

8. ThorData (⭐2,8)

ThorData ist ein hochwertiger Proxy-Dienst. Er wurde für anspruchsvolle Datenerfassungsaufgaben entwickelt.

Obwohl es sich in erster Linie um einen Proxy-Anbieter handelt, ist sein Dienst für jedes Web-Scraping-Projekt mit hohem Datenvolumen unerlässlich.

Es stellt sicher, dass Sie auf die benötigten Daten zugreifen können, ohne blockiert zu werden.

Sie verfügen außerdem über eigene Schabwerkzeuge, um den Vorgang noch einfacher zu gestalten.

Unsere Einschätzung

Erleben Sie unübertroffene Sicherheit mit ThorData. Es’ Daten der Verifikationsprozess gewährleistet eine Erfolgsquote von 99,7%. Mit 24/7 Live-Unterstützung und einer durchschnittlichen Reaktionszeit von weniger als 3 Minuten können Sie ihm vertrauen’s Verbindungsqualität. Erhalten Sie über 60 Millionen IP-Adressen und sichern Sie Ihre Daten.

Wichtigste Vorteile

- Riesiger IP-Pool: Bietet über 60 Millionen ethisch bezogene Wohn-IPs.

- Hohe Anonymität: Vergewissern Sie sich, dass Ihre Abstreifungsaktivität mit seinen hochwertigen Proxien unentdeckt bleibt.

- Pay-as-you-go: Die Abrechnung ist transparent; Sie zahlen nur für den von Ihnen genutzten Verkehr, nicht für fehlgeschlagene Anfragen.

- Eingebauter Scraper: Enthält einen No-Code Web Scraper und eine universelle API, so dass Sie kein separates Werkzeug für einfache Projekte benötigen.

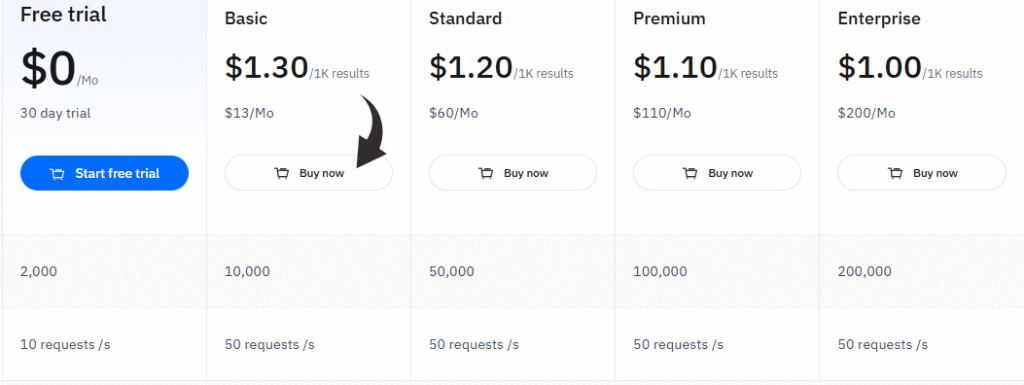

Preisgestaltung

- Kostenlose Testversion: $0/monat, 30 tage test.

- Basic: $13/monat.

- Standard: $60/monat.

- Prämie: $110/monat.

- Unternehmen: 200 US-Dollar pro Monat.

Vorteile

Nachteile

Worauf sollte man bei der Auswahl der besten Web-Scraping-Tools achten?

- Benutzerfreundlichkeit: Können Sie Daten mit wenigen Klicks extrahieren oder müssen Sie programmieren? Suchen Sie nach einem Tool, das Ihrem Kenntnisstand entspricht, egal ob es sich um eine visuelle Anwendung ohne Programmierung handelt. Bauherr oder eine auf Entwickler ausgerichtete API.

- Umgang mit komplexen Websites: Die besten Tools können dynamische Inhalte extrahieren, darunter Seiten mit JavaScript, unendlichem Scrollen oder Formularen. Dies ist entscheidend, um zuverlässige Daten von modernen, komplexen Websites zu erhalten.

- KI-Fähigkeiten: KI-Funktionen sind ein echter Wendepunkt. Sie ermöglichen die automatisierte Datenextraktion, passen sich automatisch an Website-Änderungen an und helfen sogar beim Scraping von Websites mithilfe von einfachen Sprachbefehlen.

- Skalierbarkeit: Wenn Sie eine umfangreiche Datenextraktion durchführen müssen, wählen Sie ein Tool, das für die Verarbeitung großer Datenmengen ohne Blockierungen ausgelegt ist.

- Anti-Blockung Eigenschaften: Ein gutes Tool sollte über eine integrierte IP-Rotation und ein intelligentes Proxy-Management verfügen, um eine Blockierung zu verhindern, insbesondere wenn Sie Stellenbeschreibungen oder Google-Suchergebnisse abrufen müssen.

- Datenexportoptionen: Stellen Sie sicher, dass das Tool die gesammelten Daten in den von Ihnen benötigten Formaten exportieren kann, z. B. CSV, JSON oder direkt in eine Datenbank, und dass es strukturierte Daten erzeugen kann.

- Cloud vs. Lokal: Überlegen Sie, ob Sie eine Web-Scraper-Cloud-Plattform benötigen, die Aufgaben rund um die Uhr ausführt, oder ob eine lokale Desktop-Anwendung für Ihre Bedürfnisse ausreicht.

- Spezifische Anwendungsfälle: Manche Werkzeuge eignen sich hervorragend für den allgemeinen Gebrauch, während andere auf Bereiche wie … spezialisiert sind. soziale Medien oder Google Maps-Daten, wählen Sie also eine, die zu Ihrem Projekt passt.

Wie können Ihnen die besten Web-Scraping-Tools nützen?

Web-Scraping-Tools sind eine enorme Zeitersparnis.

Sie können sich die mühsame manuelle Arbeit des Kopierens und Einfügens von Datenpunkten von mehreren Seiten sparen.

Eine gute Scraping-Lösung kann diesen Prozess hingegen für Sie automatisieren.

- Mühelose Datenerfassung: Mithilfe dieser Tools lassen sich Webseiten einfach nach Informationen wie Produktpreisen oder Marktforschungsdaten durchsuchen.

- Erweiterte Funktionen: Dank ihrer erweiterten Funktionen können diese Tools sogar komplexe Aufgaben bewältigen, wie das Auslesen von Google-Suchergebnissen oder das Abrufen des vollständigen HTML-Quellcodes.

- Sofort einsatzbereite Daten: Sie bieten hervorragende Datenexportoptionen und liefern Ihnen saubere und strukturierte Daten. Sie müssen die Informationen nicht selbst aufbereiten.

- Zeitsparende Abläufe: Diese Scraping-Operationen helfen Ihnen, stundenlange Arbeit zu sparen, sodass Sie sich auf die Analyse der Daten konzentrieren können, anstatt sie zu sammeln.

- Zuverlässig und schnell: Diese Tools sind auf Geschwindigkeit und Zuverlässigkeit ausgelegt und gewährleisten, dass Sie schnell die benötigten Informationen erhalten.

Käuferleitfaden

Wir wissen, wie wichtig es ist, das richtige Werkzeug für Ihre Bedürfnisse zu finden.

Um Ihnen die besten Empfehlungen geben zu können, haben wir jedes Produkt mit einem mehrstufigen Ansatz recherchiert und getestet.

Unser Prozess konzentrierte sich auf die Faktoren, die für die Nutzer am wichtigsten sind, vom Anfänger bis zum Profi.

Hier ist eine detaillierte Aufschlüsselung, wie wir unsere Top-Auswahl ermittelt haben:

- Benutzerfreundlichkeit: Wir haben geprüft, ob eine Lösung ohne Programmierung möglich ist oder ob Programmierkenntnisse zwingend erforderlich sind. Außerdem haben wir untersucht, wie einfach es ist, unformatierte Webseiten in nutzbare Informationen umzuwandeln, die sich problemlos in Google Sheets anzeigen lassen.

- Datengenauigkeit: Wir haben jedes Tool mit verschiedenen Datenebenen getestet. Außerdem haben wir seine Fähigkeit geprüft, Daten aus verschiedenen Bereichen einer Seite, einschließlich Meta-Tags, zu extrahieren, um die Qualität der Informationen sicherzustellen.

- Preisgestaltung: Wir haben verschiedene Preisstrategien geprüft, von kostenlosen Angeboten bis hin zu kostenpflichtigen Diensten. Dabei haben wir die anfänglichen Kosten, Abonnementmodelle, Premium-Proxys und etwaige versteckte Gebühren berücksichtigt. Außerdem haben wir nach Tools gesucht, die individuelle Lösungen für größere Unternehmen anbieten.

- Merkmale: Wir haben die Kernfunktionen jedes Tools eingehend untersucht und uns dabei insbesondere auf dessen Fähigkeit konzentriert, komplexe Websites mit unendlichem Scrollen zu verarbeiten. Wir haben die integrierte Proxy-Verwaltung und IP-Rotation geprüft und alle besonderen Funktionen im Bereich maschinelles Lernen oder KI notiert. Außerdem haben wir auf eine einfache Datenausgabe geachtet, beispielsweise den direkten Export in das CSV-Format.

- Negatives: Kein Tool ist perfekt. Wir haben die größten Schwächen jedes Produkts identifiziert. Dazu gehörten eine steile Lernkurve, der Bedarf an fortgeschrittenen technischen Kenntnissen oder fehlende Funktionen für großflächiges Web-Scraping. Wir haben auch fehlende Funktionen, wie beispielsweise eine zuverlässige Managed-Services-Option, notiert.

- Unterstützung & Community: Wir haben uns den angebotenen Kundenservice angesehen. Gab es Live-Chat, E-Mail-Support oder eine aktive Nutzer-Community? Wir haben auch die Rückerstattungsrichtlinien geprüft, damit Sie beruhigt sein können.

Unser Ziel war es, wertvolle Einblicke in die Gesamterfahrung bei der Verwendung jedes einzelnen Tools zu geben, um die benötigten Auftragsdetails zu erhalten.

Zusammenfassung

Die Wahl des richtigen KI-Web-Scraping-Tools ist der Schlüssel zum Erfolg.

Diese Tools eignen sich für komplexe Projekte und helfen Ihnen, Informationen von verschiedenen Websites ohne großen Lernaufwand zu extrahieren.

Vergessen Sie mühsame manuelle Eingriffe und gesperrte IPs; intelligente Funktionen wie rotierende Proxys und maschinelles Lernen helfen Ihnen dabei.

Mit diesen Tools erhalten Sie alles von Produktdaten über Suchergebnisse bis hin zu Stellenbezeichnungen.

Unsere auf einem mehrschichtigen Ansatz basierende Forschung gewährleistet Ihnen verlässliche Empfehlungen.

Von benutzerfreundlichen No-Code-Lösungen bis hin zu leistungsstarken Plattformen für Entwickler – wir ebnen Ihnen den Weg zum Erfolg.

Häufig gestellte Fragen

Können KI-gestützte Web-Scraping-Tools auch komplexe Websites bewältigen?

Ja, sie nutzen maschinelles Lernen, um sich an Änderungen der Website-Struktur anzupassen und dynamische Inhalte sowie Anti-Bot-Maßnahmen wie das Lösen von Captchas zu handhaben.

Kann ich mit diesen Tools Suchergebnisse extrahieren?

Absolut. Viele Tools verfügen über spezielle Funktionen, die entwickelt wurden, um Suchergebnisse von Plattformen wie Google und anderen Suchmaschinen zu extrahieren.

Was sind die größten technischen Hürden beim Web Scraping?

Zu den größten technischen Hürden zählen der Umgang mit dynamischen Inhalten, Änderungen am Website-Layout und ausgeklügelte Anti-Bot-Systeme wie IP-Sperren und rotierende Proxys.

Wie kann ich Webdaten aus diesen Tools exportieren?

Die meisten Tools bieten verschiedene Datenexportoptionen an, mit denen Sie Daten als CSV- oder JSON-Datei oder direkt in eine Datenbank exportieren können, um sie einfach weiterzuverwenden.

Worin unterscheiden sich KI-Werkzeuge von anderen Werkzeugen?

Im Gegensatz zu anderen Tools benötigen KI-Scraper weniger manuelle Eingriffe und können detailliertere Informationen mit einer wesentlich geringeren Lernkurve gewinnen.