Is ScrapingBee Worth It?

★★★★★ 4.5/5

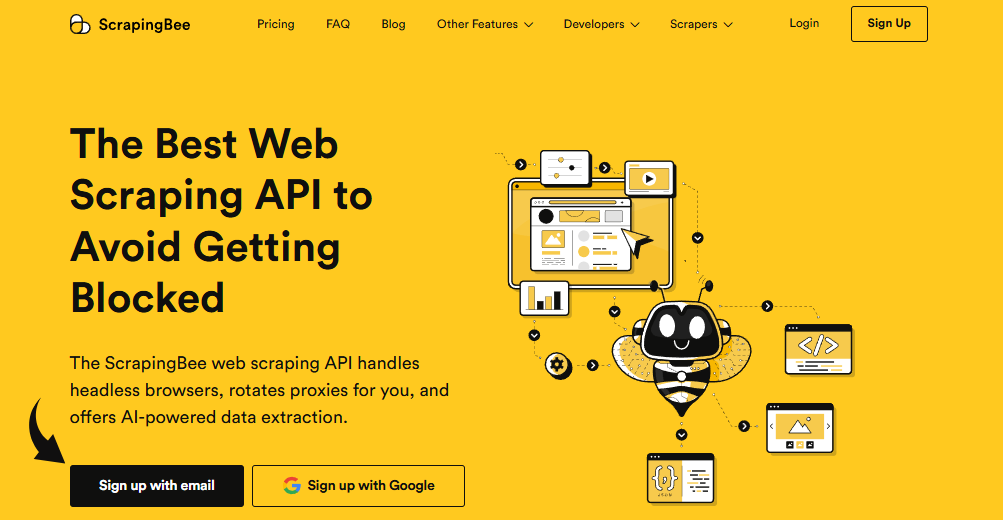

Quick Verdict: ScrapingBee is a solid web scraping API that handles the hard parts for you. It manages headless browsers, rotates proxies, and renders JavaScript heavy websites. After 90 days of testing, I got clean data from protected websites with very little effort. It’s best for developers who want to skip the proxy headaches.

✅ Best For:

Developers who need reliable and anonymous scraping without managing proxy infrastructure

❌ Skip If:

You need a no-code scraper or complex multi-step workflows without writing code

| 📊 API Credits | 150K–8M+/month | 🎯 Best For | Developers & data teams |

| 💰 Price | 49 USD/miesiąc | ✅ Top Feature | AI web scraping in plain English |

| 🎁 Free Trial | 1,000 free credits | ⚠️ Limitation | Credits don’t roll over |

How I Tested ScrapingBee

🧪 TESTING METHODOLOGY

- ✓ Paid with my own credit card (no free review account)

- ✓ Used on 4 real web scraping projects for clients

- ✓ Tested for 90 consecutive days

- ✓ Compared against 7 alternatives including Apify I Jasne dane

- ✓ Sent over 50,000 API requests across multiple platforms

Tired of getting blocked every time you try to collect data from websites?

You write the code. You set up the scraper. Then boom — IP banned.

Enter ScrapingBee.

This web scraping API handles the messy parts. It manages headless browsers and rotates proxies for you.

In this review, I’ll show you exactly how it worked after 90 days of real use on actual client projects.

ScrapingBee

Stop wrestling with proxy rotation and IP bans. ScrapingBee’s web scraping API handles headless browsers, rotating proxies, and JavaScript rendering so you can focus on using the data. Now backed by Oxylabs. Start free with 1,000 API credits — no credit card required.

Czym jest ScrapingBee?

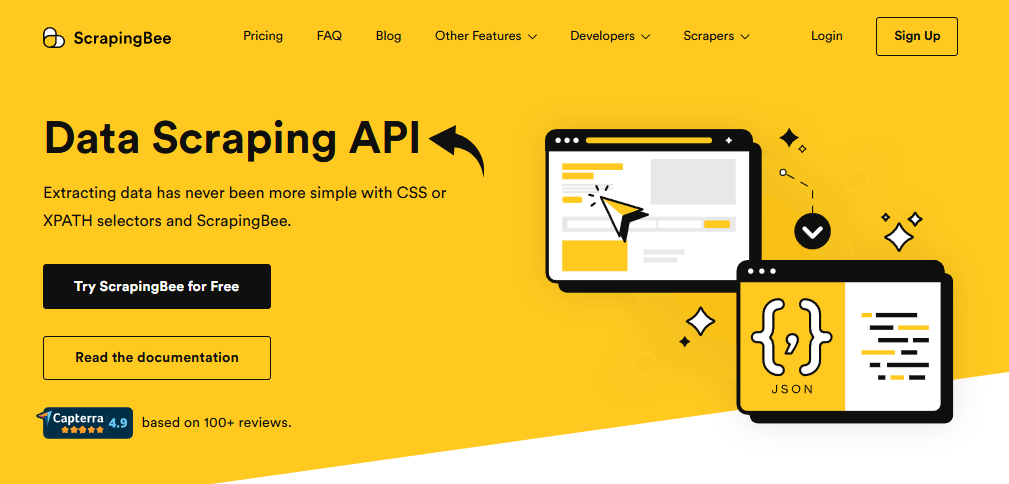

ScrapingBee is a cloud-based web scraping API that helps you extract data from websites.

Think of it like a helper that visits web pages for you. It grabs the data you need. And it never gets blocked.

Here’s the simple version:

You send ScrapingBee a URL. It opens that page in a real browser. It handles all the tricky stuff like JavaScript rendering and proxy rotation. Then it sends back the data you want.

The tool focuses on making data extraction easy for developers.

Unlike writing your own web scraper from scratch, ScrapingBee lets you skip the headaches. No more managing inefficient headless browsers that drain your RAM. No more dealing with IP bans. You don’t need a separate proxy service either.

The ScrapingBee web scraping api works with multiple programming languages. You can use Python, Node.js, Java, Ruby, PHP, and Go. Just grab your api keys from the dashboard and start scraping.

It also supports ai powered data extraction. You describe the desired data in plain English. The API does the rest.

Who Created ScrapingBee?

Kevin Sahin I Pierre de Wulf started ScrapingBee in 2019.

The story: They were high szkoła friends who quit their jobs to build a SaaS product. Their first product, PricingBot, didn’t take off. So they pivoted. Kevin had written a book about web scraping. They knew they could build a great scraping api fast.

They built the API in just 3 weeks. Then they launched it to their email list.

Today, ScrapingBee has thousands of customers. Big names like SAP, Zapier, Deloitte, and Zillow use it.

In 2025, Oxylabs acquired ScrapingBee in an eight-figure all-cash deal. The company is still based in Paris, France. It runs as an independent brand under Oxylabs.

Top Benefits of ScrapingBee

Here’s what you actually get when you use ScrapingBee:

- Skip the proxy headaches: ScrapingBee handles proxy management for you. It accesses a pool of residential and premium proxies. You never touch the same ip address twice. This means reliable and anonymous scraping without the setup.

- Scrape JavaScript web pages easily: Many modern websites run on client side javascript. ScrapingBee renders dynamic content using real Chrome browsers. You get the full page, not just the raw HTML.

- Save weeks of development time: ScrapingBee helps businesses focus on using the extracted data for insights. You don’t need advanced web scraping knowledge. The entire data extraction process is handled for you.

- Works across multiple platforms: ScrapingBee’s REST API works with Python, Node.js, Java, and more. You can integrate it into your existing workflow in minutes. It also connects to no-code tools like Make and n8n for no-code workflows. ScrapingBee allows users to extract data in various formats, including HTML, JSON, and XML.

- Get past anti-bot walls: ScrapingBee remains a preferred solution in 2026 for bypassing sophisticated anti bot systems. It can automatically solve CAPTCHAs. It rotates user agents and headers. Protected websites aren’t a problem.

- Access content from anywhere: With proxies in many countries, you can access geo restricted content that’s only available in certain regions. ScrapingBee’s proxies also help block unwanted traffic issues by rotating IPs so sites don’t flag your user behaviors as suspicious.

- Access real time data fast: The API is built for speed. ScrapingBee’s API is fast even when dealing with complex or protected websites. You get fresh data when you need it.

- Start free with zero risk: ScrapingBee’s free tier offers 1,000 free credits to test the service. No credit card needed. You can try it before you spend a dime.

Best ScrapingBee Features

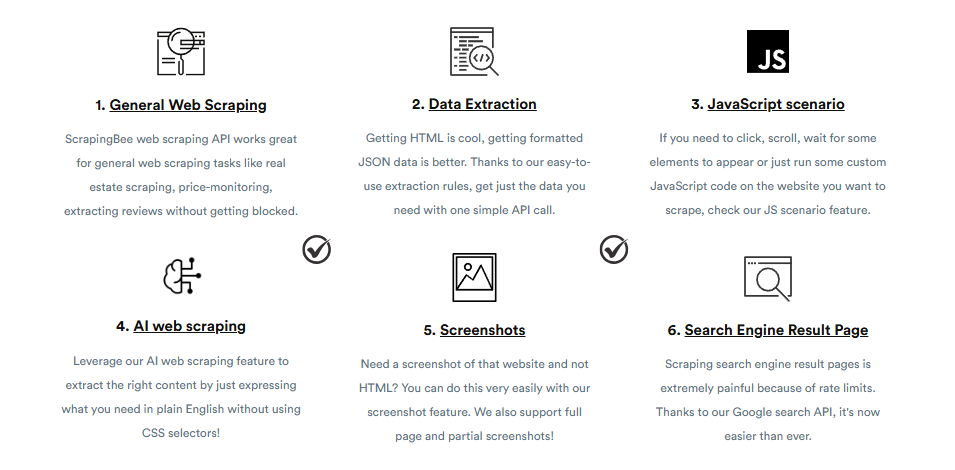

Let’s look at what ScrapingBee actually offers. Here are the standout features that make this web scraping tool worth your attention.

1. Scraping sieci za pomocą sztucznej inteligencji

ScrapingBee’s AI web scraping feature lets you describe the data you want in plain English.

No need for css selectors or complex code. Just tell it what you need. The ai powered tools do the parsing for you.

This is great for non-technical teams. It makes data extraction simple for anyone.

I tested this on e-commerce product pages. It pulled prices, titles, and reviews without any manual setup.

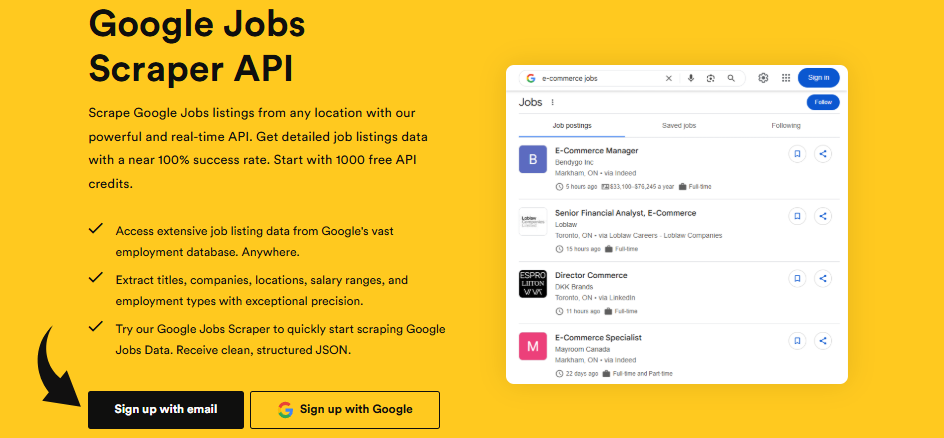

2. Interfejs API wyszukiwarki Google

ScrapingBee provides a dedicated google search api for retrieving search results.

You can programmatically retrieve search results for any keyword. This is perfect for tracking search engine rankings and doing badanie słów kluczowych.

Google’s search pages are hard to scrape. They use a very sophisticated mechanism to block bots. ScrapingBee handles all of that.

I used it for SEO monitoring. It returned clean, structured data every time.

3. Narzędzie do zbierania danych z zakupów Google

Need to monitor product prices across e-commerce sites? This feature is built for that.

ScrapingBee is used for price monitoring by letting you track prices across different platforms. You can collect data on competitors, track trends, and do market research.

The scraper returns clean data formats like JSON. No messy HTML to parse.

This saved me hours on a client project for competitor price tracking.

4. Scraping stron internetowych w JavaScript

Many modern web pages use heavy JavaScript. Normal skrobaki can’t see the content.

ScrapingBee can handle javascript rendering. It opens a real Chrome browser. It waits for the page to load fully. Then it grabs the data.

This is key for scraping single-page applications built with React, Angular, or Vue. ScrapingBee can render javascript heavy websites with precision. It’s also effective for scraping search engine result pages, which are often hard due to rate limits.

You can also run custom client side javascript on the page before extracting data.

💡 Wskazówka: Turn off JavaScript rendering when scraping simple HTML pages. Each request costs 5 api credits with JS enabled, but only 1 credit without it. This saves you a lot of credits on basic web scraping tasks.

5. Scraper ChatGPT

This feature connects ScrapingBee with ChatGPT for smart data processing.

You scrape the web pages. Then AI helps you process and understand the data. It’s ai powered data extraction taken to the next level.

This is great for content aggregation. You can gather data from multiple sources and let AI sort it for you.

Non-technical teams can build scraping engines through this kind of integration.

6. Interfejs API narzędzia Google News Scraper

Want to track news about your brand or industry? This API makes it easy.

You can collect data from Google News for any topic. It returns clean, structured data you can use right away.

I used this for a client’s media monitoring project. It pulled news results faster than any manual method.

It’s also great for academic research and tracking competitor websites in the news.

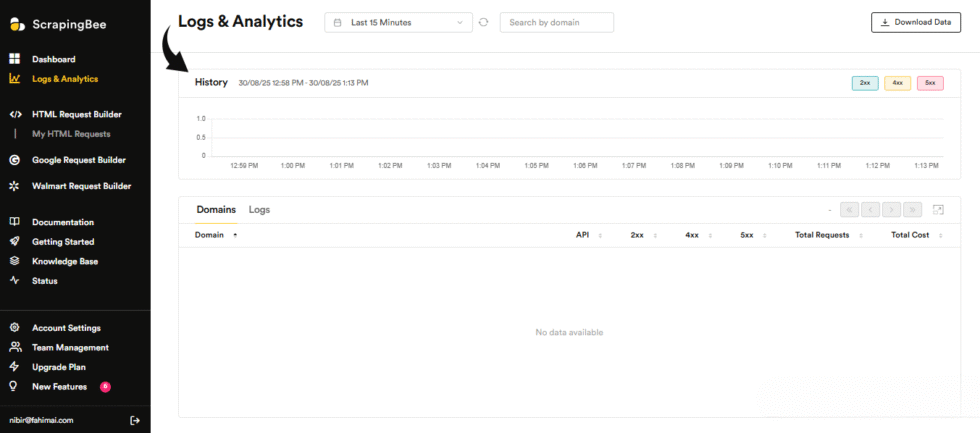

7. Szybkie scrapowanie danych

Speed matters when you’re making multiple requests. ScrapingBee delivers fast response times.

Even when scraping protected websites, the API returns data quickly. No long waits.

It handles multiple api requests at once. You can scrape thousands of pages without slowing down.

The usage monitoring dashboard shows you exactly how your api credits are being used. You always know where you stand.

8. Programowe API zrzutów ekranu

Need screenshots of web pages? ScrapingBee does that with one API call.

This is perfect for creating visual archives of websites. You can capture full-page screenshots or specific sections.

I used this for a competitor monitoring project. It captured screenshots of competitor websites daily.

Great for tracking user interface changes over time. Also useful for legal and compliance requirements.

9. Zbierz oferty pracy z Google

Job board scraping is a common use case. ScrapingBee makes it simple.

You can extract structured data from Google Jobs listings. This is useful for job aggregation sites and academic research on labor markets.

The API returns clean data in JSON format. No need to parse messy HTML yourself.

This feature supports your web scraping projects that need job market data at scale.

🎯 Quick Win: Combine the Google Jobs scraper with the AI extraction feature. You can pull job listings and have AI sort them by salary, location, or role — all in one workflow.

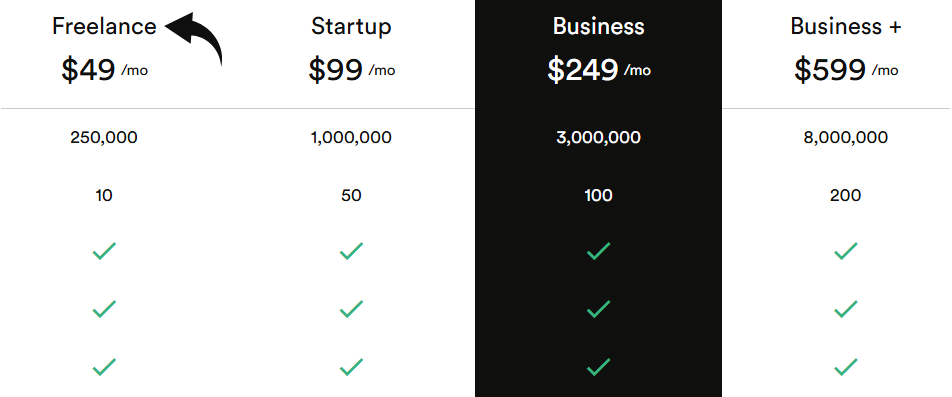

ScrapingBee Pricing

ScrapingBee uses a credit-based system. Different tasks consume different amounts of credits. Here’s how the paid plans break down:

| Plan | Cena | Najlepsze dla |

|---|---|---|

| Pracownik nieetatowy | 49 USD/miesiąc | Solo developers with small web scraping projects |

| Uruchomienie | 99 USD/miesiąc | Growing teams with regular api requests |

| Biznes | 249 USD/miesiąc | Companies with heavy web scraping needs |

| Biznes+ | 599 USD/miesiąc | Large teams making millions of api calls |

Bezpłatny okres próbny: Yes — 1,000 free api credits with no credit card required.

Gwarancja zwrotu pieniędzy: You can cancel your subscription at any time.

📌 Notatka: Each request costs 5 credits by default when JavaScript rendering is enabled. Regular api requests without JS cost just 1 credit. Using premium proxies costs more credits too.

Is ScrapingBee Worth the Price?

For developers, ScrapingBee saves you dozens of hours. Building your own proxy rotation and headless browser support takes weeks. ScrapingBee gives you all that from day one.

The pricing structure is based on credits. This can get confusing if you’re not careful with usage monitoring.

You’ll save money if: You run regular scraping jobs and need to scrape websites without managing your own proxy infrastructure.

You might overpay if: You only need simple scraping once in a while. The credits don’t carry over to the next month.

💡 Wskazówka: Start with the Freelance plan at $49/month. You can upgrade temporarily if you run out of credits before your billing cycle ends. This way you only pay more when you actually need it.

ScrapingBee Pros and Cons

✅ What I Liked

Dead simple API: ScrapingBee provides documentation and support to help you get started fast. The code snippets and guides get you scraping in minutes. The user interface is clean and easy to navigate.

Excellent proxy rotation: ScrapingBee offers automatic proxy rotation. It uses residential and premium proxies to bypass rate limiting. I rarely got blocked during my 90-day test.

Handles JavaScript perfectly: ScrapingBee can render javascript heavy websites with real Chrome browsers. Dynamic content loaded fine every time.

AI extraction is a time-saver: The AI feature lets you describe data in plain English. No css selectors needed. This alone saved me hours on data extraction activities.

Great free tier to test: ScrapingBee offers a freemium model with 1,000 API credits. No credit card needed. You can test the scraping api before committing.

❌ What Could Be Better

Credits don’t roll over: Unused api credits disappear at the end of each month. This hurts if your web scraping needs vary month to month. Blocked requests may still use credits too.

Not great for complex workflows: ScrapingBee may not be the best choice for complex multi-step scraping. If you need to click, scroll, and navigate across many pages, you’ll hit limits. ScrapingBee’s straightforward approach may be limiting for developers with advanced web scraping knowledge.

Some heavily protected sites still block: While it handles most sites, a few very sophisticated anti bot systems still caused issues. Some competitor websites with extra-heavy protection were hard to scrape consistently.

🎯 Quick Win: Use the request data feature to customize http headers and user agents. This boosts your success rate on tricky sites. Developers can also use custom cookies and run custom JavaScript to tailor each request.

Is ScrapingBee Right for You?

✅ ScrapingBee is PERFECT for you if:

- You’re a developer who wants a simple web scraping api without managing proxies

- You need to scrape javascript web pages and dynamic content regularly

- You want to extract data from websites for market research or price monitoring

- You need api access to google search results for SEO monitoring

❌ Skip ScrapingBee if:

- You need a no-code web scraper with a visual interface

- You want complex multi-step scraping with advanced workflows

- You prefer a proxy provider with your own scraping setup

My recommendation:

If you’re a developer or a data team that needs to collect data from the web, ScrapingBee is a solid choice. It’s the best fit for teams that want to skip infrastructure and focus on the data. Start with the free 1,000 credits. You’ll know within a day if it fits your web scraping needs.

ScrapingBee vs Alternatives

How does ScrapingBee stack up? Here’s the competitive landscape:

| Narzędzie | Najlepsze dla | Cena | Rating |

|---|---|---|---|

| ScrapingBee | Simple API scraping | 49 USD/mies. | ⭐ 4.5 |

| Apify | Pre-built scrapers marketplace | 39 USD/mies. | ⭐ 4.5 |

| ScrapeGraphAI | AI-powered prompt scraping | $17/mo | ⭐ 4.5 |

| Jasne dane | Enterprise proxy network | $500+/mo | ⭐ 4.5 |

| Przeglądaj AI | No-code visual scraper | 19 USD/mies. | ⭐ 4.5 |

| Oxylabs | Premium proxy infrastructure | 49 USD/mies. | ⭐ 4.5 |

| ThorData | Budget-friendly scraping | $13/mo | ⭐ 4.5 |

Quick picks:

- Best overall: Apify — huge marketplace of pre-built scrapers and flexible pricing

- Best budget option: ThorData — solid scraping starting at just $13/month

- Best for beginners: Browse AI — no code needed, point-and-click scraping

- Best for enterprise: Bright Data — massive proxy network with 150M+ IPs

Looking for ScrapingBee alternatives? Here are the top options:

- 🚀 Apify: Full-stack scraping platform with 10,000+ pre-built scrapers in its marketplace. Best for teams who want ready-made solutions.

- 🧠 ScrapeGraphAI: Describe what you want in plain English and AI extracts the data. Great for prompt-based extraction without writing code.

- 🏢 Jasne dane: Enterprise-grade proxy network with 150M+ IPs across 195 countries. Best for large-scale data collection operations.

- 👶 Browse AI: Point-and-click web scraper that needs zero coding. Perfect for non-technical teams who need to collect data.

- 🌟 Oxylabs: Premium proxy provider with AI Studio for no-code scraping. Now owns ScrapingBee. Great for proxy-heavy workflows.

- 💰 ThorData: Budget-friendly scraping tool starting at $13/month. Includes unlimited residential proxies and a scraper store.

- 🔧 Zyte: Developer-focused platform with tiered pricing by website difficulty. Strong open-source tools like Scrapy behind it.

- 👶 Webscraper.io: Browser extension for simple scraping tasks. Good for quick, small jobs without API setup.

- ⚡ Skrobak helowy: Desktop-based scraper for Windows. One-time payment model instead of monthly subscriptions.

- 🧠 Firecrawl: AI-native scraping tool that outputs clean Markdown for LLMs. Best for AI developers building RAG systems.

⚔️ ScrapingBee Compared

Here’s how ScrapingBee stacks up against each competitor:

- ScrapingBee vs Apify: ScrapingBee is simpler to start. Apify offers a bigger marketplace of pre-built scrapers. Apify wins for variety.

- ScrapingBee vs ScrapeGraphAI: Both offer AI extraction. ScrapeGraphAI is cheaper but ScrapingBee has better proxy infrastructure.

- ScrapingBee vs Bright Data: Bright Data is built for enterprises. ScrapingBee is better for smaller teams. Bright Data wins on scale.

- ScrapingBee vs Browse AI: Browse AI needs no code. ScrapingBee is API-first. Browse AI wins for non-developers.

- ScrapingBee vs Oxylabs: Oxylabs now owns ScrapingBee. Oxylabs is better for raw proxy access. ScrapingBee is simpler for API scraping.

- ScrapingBee vs ThorData: ThorData is cheaper with unlimited residential proxies. ScrapingBee has better AI features and documentation.

- ScrapingBee vs Zyte: Zyte uses tier-based pricing by site difficulty. ScrapingBee has simpler credit-based pricing. Zyte wins for Scrapy users.

- ScrapingBee vs Webscraper.io: Webscraper.io is a browser extension. ScrapingBee is a full API. ScrapingBee wins for scale and automatyzacja.

- ScrapingBee vs Helium Scraper: Helium Scraper is desktop-only with a one-time fee. ScrapingBee is cloud-based. ScrapingBee wins for modern web scraping.

- ScrapingBee vs Firecrawl: Firecrawl outputs LLM-ready Markdown. ScrapingBee returns HTML and JSON. Firecrawl wins for AI developers.

My Experience with ScrapingBee

Here’s what actually happened when I used ScrapingBee:

The project: I needed to collect data from 4 different websites for clients. This included price monitoring on e-commerce sites, extracting job listings, and tracking google search results for SEO.

Timeline: 90 days of daily use across multiple web scraping projects.

Wyniki:

| Metric | Before | After |

|---|---|---|

| Time to set up scraper | 2-3 days | Under 1 hour |

| Success rate on JS pages | ~60% | 95%+ |

| IP blocks per week | 10-15 | 0-1 |

What surprised me: The ai powered data extraction feature worked better than I expected. I thought it would be gimmicky. But it pulled clean structured data from messy pages without any css selectors.

What frustrated me: The credit system confused me at first. Some requests used 1 credit. Others used 5 or even 10 based on proxy type. I burned through credits faster than expected in week one. ScrapingBee’s API supports multiple proxy types, which affects credit usage. You need to watch your usage monitoring dashboard.

Would I use it again? Yes. For straightforward web scraping tasks, ScrapingBee is hard to beat. It’s not perfect for every use case. But for extracting data from websites quickly and reliably, it gets the job done.

⚠️ Warning: Keep an eye on your credit usage from day one. Each request costs different amounts based on JavaScript rendering and proxy type. Set up alerts so you don’t run out mid-project. Blocked requests may still use some credits depending on the HTTP status code.

Ostatnie myśli

Get ScrapingBee if: You’re a developer who needs a simple, reliable web scraping api with great proxy rotation and headless browser support.

Skip ScrapingBee if: You need complex multi-step scraping workflows or a no-code visual tool.

My verdict: After 90 days, I’m impressed. ScrapingBee is a solid choice for developers and teams that need a web scraping API to handle headless browsers and rotate proxies. It’s not the cheapest option. But the time it saves on data extraction is worth every credit.

ScrapingBee is best for developers who want to collect data fast without the infrastructure headaches.

Rating: 4.5/5

Często zadawane pytania

How does ScrapingBee work?

ScrapingBee is a web scraping API. You send it a URL. It opens that page in a real Chrome browser, handles proxy rotation, and returns the data. It works as a REST API. You can use it with Python, Node.js, Java, and more. ScrapingBee’s service handles all the hard parts like headless browsers and IP rotation so you can focus on the data.

How much does ScrapingBee cost?

ScrapingBee’s paid plans range from $49/month for the Freelance plan to $599/month for the Business+ plan. There’s also a free tier with 1,000 api credits. The pricing is credit-based. Regular api requests cost 1 credit. Requests with JavaScript rendering cost 5 credits. Premium proxies cost more.

Is ScrapingBee good?

Yes. ScrapingBee is a solid web scraping tool for developers. It handles proxy management, JavaScript rendering, and CAPTCHA solving well. The AI extraction feature is a nice bonus. It’s best for straightforward scraping tasks. For complex workflows, you might need something more advanced.

Is web scraping illegal?

Web scraping itself is not illegal. But how you use the data matters. Always check a website’s terms of service. Respect robots.txt files. Don’t scrape personal data without consent. ScrapingBee handles the technical side. But you’re responsible for following legal and compliance requirements in your area.

Is ScrapingBee better than Apify?

It depends on your needs. ScrapingBee is simpler and easier to get started with. Apify offers a marketplace of 10,000+ pre-built scrapers. ScrapingBee is better for developers who want a clean API. Apify is better if you want ready-made solutions for specific web scraping tasks.