Praca z ogromnymi ilościami danych na Reddicie jest trudna.

Kopiowanie i wklejanie zajmuje wieczność.

Przegapiasz ważne posty i najważniejsze trendy.

Potrzebujesz szybszego i łatwiejszego sposobu zdobycia tych informacji.

Muszą to być czyste dane, z których faktycznie można skorzystać.

Znalazłyśmy 7 najlepszych scraperów Reddita na rok 2025.

Zacznij już dziś inteligentnie pozyskiwać dane.

Jakie są najlepsze scrapery Reddita?

Potrzebujesz szybkich i czystych danych z Reddita. Ale które narzędzie będzie dla Ciebie odpowiednie?

Potrzebujesz skrobak to działa, bez bólu głowy.

Przyjrzeliśmy się wszystkim najlepszym opcjom.

Poniżej znajduje się nasza ostateczna, uporządkowana lista 7 najlepszych scraperów Reddit, z których możesz korzystać w 2025 roku.

1. Apify (⭐4.8)

Apify to platforma oparta na chmurze.

Zawiera wiele gotowych narzędzi zwanych „Aktorami”.

Możesz pozyskiwać wpisy, komentarze i dane użytkowników bez konieczności logowania.

Dzięki temu zbieranie danych na dużą skalę będzie dla Ciebie o wiele łatwiejsze.

Nasze podejście

Chcesz przekonać się na własne oczy o możliwościach Apify? Nasza platforma została wykorzystana do zeskanowania ponad 2,5 miliona stron internetowych i przetworzenia ponad 500 TB danych w ciągu jednego miesiąca. Gotowy do działania?

Kluczowe korzyści

- Ogromny rynek: W sklepie Apify Store dostępnych jest ponad 5000 gotowych do użycia programów do scrapowania i automatyzacji, zwanych aktorami.

- Maksymalna skalowalność: Zaprojektowane do zadań na poziomie korporacyjnym, umożliwia przetwarzanie na dużą skalę milionów stron.

- Przyjazne dla programistów: Udostępnia pakiet SDK typu open source i obsługuje niestandardowy kod w językach Python i JavaScript.

- Zaawansowane planowanie: Zautomatyzuj zadania scrapowania, aby były wykonywane w określonych godzinach lub odstępach czasu, bez konieczności wykonywania czynności ręcznych.

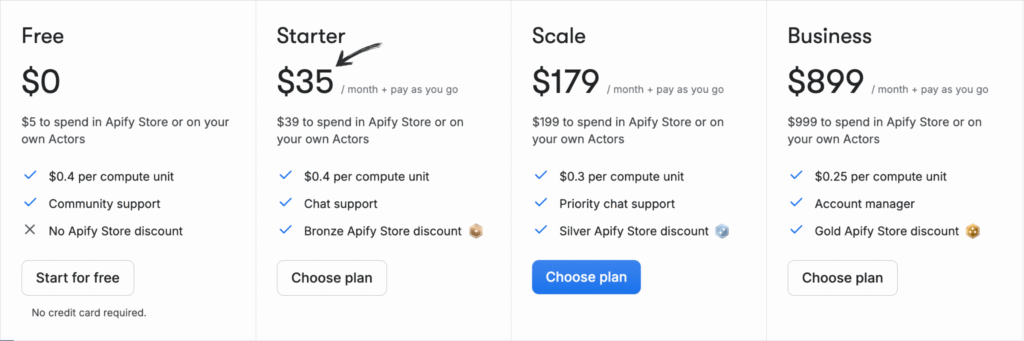

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: 0 zł/miesiąc + Płać zgodnie z zużyciem.

- Rozrusznik: 35 USD/miesiąc + płatność w miarę zużycia.

- Skala: 179 USD/miesiąc + Płać za zużycie.

- Biznes: 899 USD/miesiąc + płatność w miarę zużycia.

Zalety

Wady

2. Przeglądaj AI (⭐4.5)

To narzędzie nie wymaga kodu. Trenujesz robota, po prostu klikając na to, co chcesz wyodrębnić.

Jest bardzo prosty w obsłudze.

Świetnie sprawdza się u osób niebędących programistami, które chcą monitorować subreddity pod kątem trendów.

Nasze podejście

Chcesz zaoszczędzić czas i uzyskać potrzebne dane? Browse AI poradzi sobie z milionami stron internetowych. Zobacz, jak łatwe może być scrapowanie stron internetowych.

Kluczowe korzyści

- Kod nie jest wymagany: Dzięki interfejsowi typu „wskaż i kliknij” każdy może w ciągu kilku minut stworzyć narzędzie do pozyskiwania danych.

- Adaptacja wspomagana przez sztuczną inteligencję: Narzędzie automatycznie dostosowuje się do zmian w układzie witryny, zapewniając zawsze spójność danych.

- Ponad 7000 integracji: Łatwo połącz zebrane dane z aplikacjami takimi jak Arkusze Google, Airtable i Zapier.

- Gotowe roboty: Uzyskaj dostęp do biblioteki gotowych robotów przeznaczonych do wykonywania typowych zadań na popularnych stronach internetowych, oszczędzając jeszcze więcej czasu.

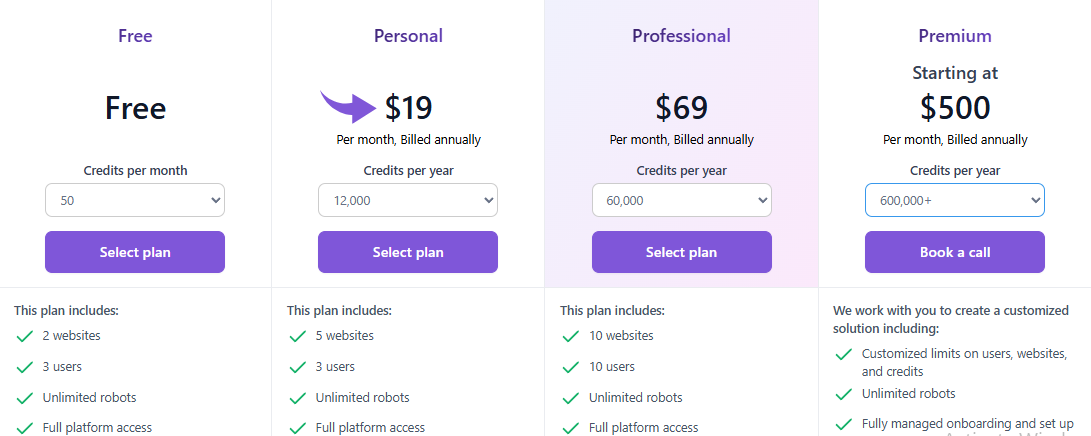

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: $0.

- Osobisty: 19 USD/miesiąc.

- Profesjonalny: 69 USD/miesiąc.

- Premia: Od 500 USD/miesiąc.

Zalety

Wady

3. Oxylabs (⭐4.0)

Oxylabs to potężne rozwiązanie bazujące na API.

Koncentrują się na odblokowywaniu trudnych do zeskrobania stron.

Otrzymujesz inteligentną rotację serwerów proxy i wspomaganą sztuczną inteligencją ochronę przed botami.

Jest to rozwiązanie idealne w przypadku bardzo dużych projektów o dużej objętości.

Nasze podejście

Odblokuj dane dzięki wiodącej usłudze proxy. Z ponad 175 milionami serwerów proxy domowych, 2 milionami dedykowanych serwerów proxy w centrach danych i 20 milionami serwerów proxy mobilnych, Oxylabs zapewnia adresy IP potrzebne do każdego projektu.

Kluczowe korzyści

- Asystent AI OxyCopilot: To narzędzie umożliwia generowanie żądań scrapowania przy użyciu prostego, naturalnego języka.

- Ogromna sieć proxy: Posiada jedną z największych pul serwerów proxy na świecie, obejmującą adresy IP ze 195 krajów.

- Gwarancja sukcesu: Oparte na sztucznej inteligencji odciski palców platformy i omijanie testu CAPTCHA gwarantują wysoki wskaźnik powodzenia nawet w przypadku najtrudniejszych witryn.

- Bezpieczeństwo klasy korporacyjnej: Platforma posiada certyfikat ISO/IEC 27001:2022, co gwarantuje wysoki poziom bezpieczeństwa i prywatności danych.

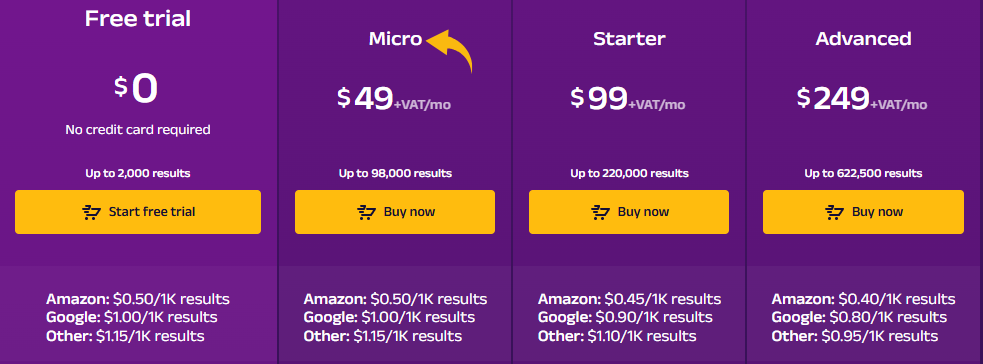

Wycena

- Bezpłatny okres próbny: $0.

- Mikro: 49 USD/miesiąc + VAT.

- Rozrusznik: 99 USD/miesiąc + VAT.

- Zaawansowany: 249 USD/miesiąc + VAT.

Zalety

Wady

4. ScrapeGraphAI (⭐3.8)

To narzędzie wykorzystuje sztuczną inteligencję do uproszczenia scrapowania.

Podajesz mu proste informacje, jakich danych potrzebujesz.

Sztuczna inteligencja zajmuje się skomplikowanym kodowaniem.

To przełomowe rozwiązanie pozwalające szybko uzyskać ustrukturyzowane dane.

Nasze podejście

Wiodący specjaliści (ponad 350 osób) zaufali ScrapeGraphAI ze względu na jego solidne, oparte na sztucznej inteligencji możliwości scrapowania stron internetowych. Zapewnij sobie 20% wzrost wydajności na kolejne 48 godzin.

Kluczowe korzyści

- Scraping języka naturalnego: Możesz wskazać mu, co ma wyodrębnić, używając prostych, zrozumiałych dla człowieka monitów.

- Biblioteka Open Source: Deweloperzy mogą wykorzystać jego wszechstronną bibliotekę typu open-source, aby uzyskać maksymalną kontrolę.

- Funkcja Markdownify: Potrafi konwertować całe strony internetowe na przejrzyste, czytelne dokumenty Markdown.

- Agentic Scraper: Sztuczna inteligencja potrafi autonomicznie poruszać się po stronach internetowych i wchodzić z nimi w interakcje, wykonując złożone, wieloetapowe zadania.

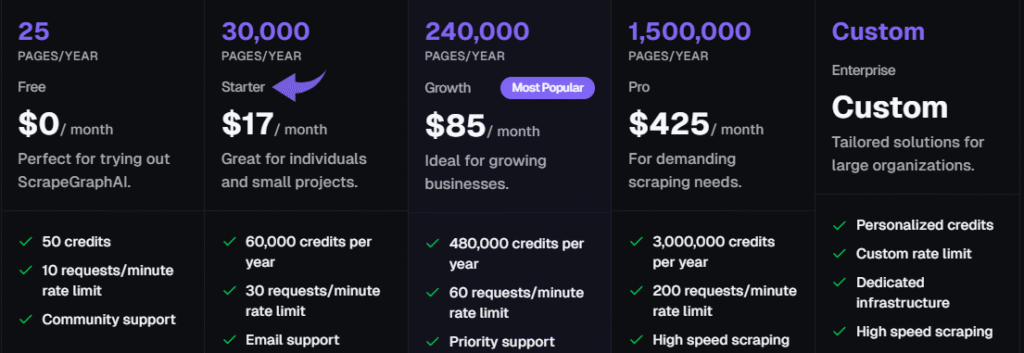

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: 0 zł/miesiąc.

- Rozrusznik: 17 USD/miesiąc.

- Wzrost: 85 USD/miesiąc.

- Zawodowiec: 425 USD/miesiąc.

- Przedsiębiorstwo: Indywidualne ceny.

Zalety

Wady

5. Zyte (⭐3,5)

Zyte oferuje pełne API do scrapowania stron internetowych.

Świetnie nadaje się do stron dynamicznych, wykorzystujących dużo JavaScript.

Platforma zajmuje się zarządzaniem serwerami proxy i środkami anty-botowymi.

To niezawodny wybór w przypadku skalowalnych zadań korporacyjnych.

Nasze podejście

Uzyskaj najbardziej niezawodną sieć dane z API Zyte. Osiągnij 99,99% dokładności danych w swoich projektach dzięki temu wysokiej jakości API do scrapowania stron internetowych i usprawnij proces ekstrakcji danych już dziś.

Kluczowe korzyści

- Automatyczne odblokowywanie: Przestań żonglować serwerami proxy; Zyte API to potężne, zautomatyzowane narzędzie do obsługi banów.

- Bezproblemowa integracja ze Scrapy: Jeśli jesteś programistą korzystającym z frameworka Scrapy, Zyte będzie dla Ciebie idealnym rozwiązaniem.

- Ekstrakcja danych wspomagana sztuczną inteligencją: Narzędzie może automatycznie identyfikować i analizować dane, zmniejszając potrzebę ręcznego stosowania reguł analizy.

- Zintegrowana przeglądarka bez interfejsu: Nie ma potrzeby korzystania z przeglądarek bezgłowych innych firm, ponieważ Zyte udostępnia przeglądarkę zoptymalizowaną pod kątem scrapowania stron internetowych na dużą skalę.

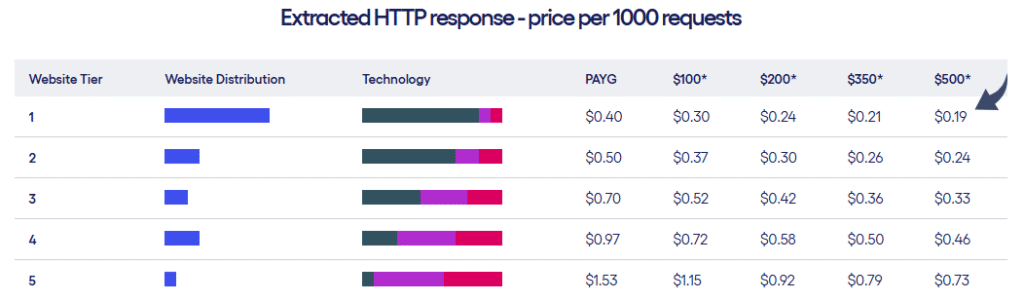

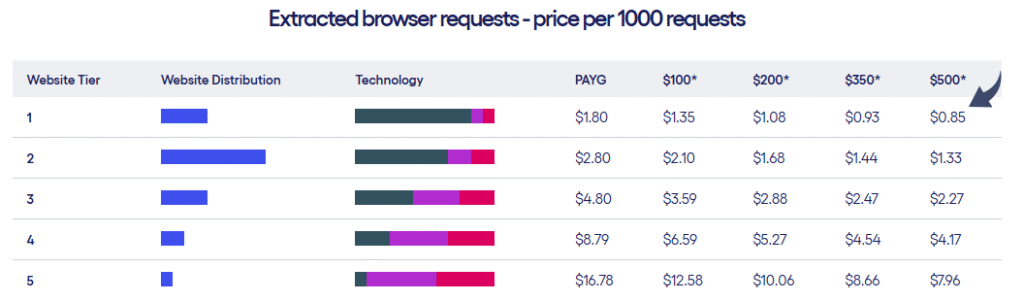

Wycena

- Zyte oferuje dwa rodzaje planów cenowych w zależności od poziomu witryn i liczby żądań.

Zalety

Wady

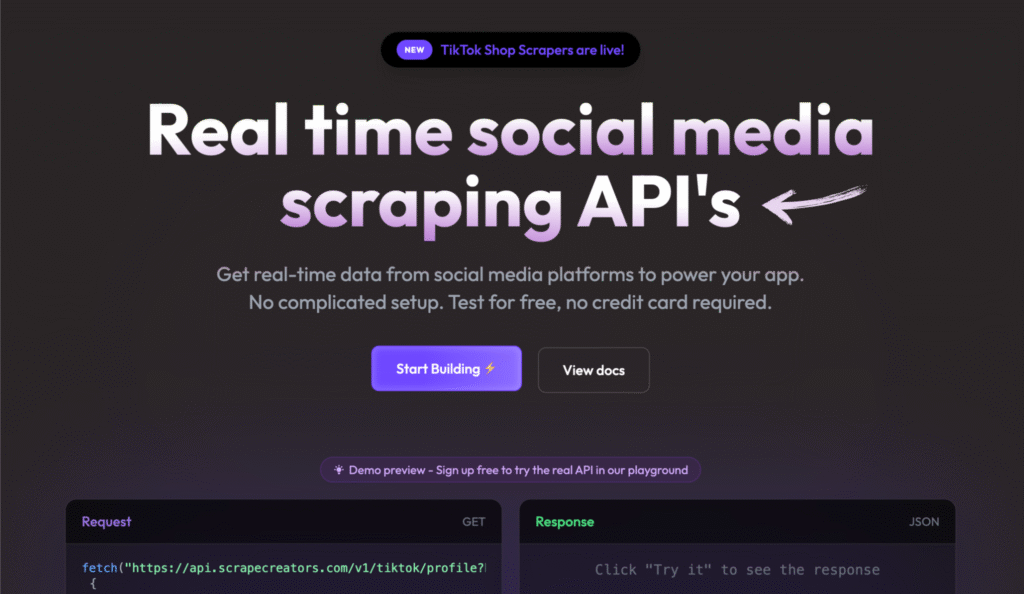

6. Twórcy scrapowania (⭐3.2)

Scrape Creators zapewnia w czasie rzeczywistym media społecznościowe API scrapowania.

To narzędzie udostępnia dane na żądanie. Obsługuje elastyczny model płatności za rzeczywiste wykorzystanie.

To idealne rozwiązanie, jeśli potrzebujesz danych tylko od czasu do czasu.

Nasze podejście

Nie musisz już męczyć się ze zbieraniem danych z mediów społecznościowych. Dzięki Scrape Creators uzyskasz dane w czasie rzeczywistym z platform takich jak Twitch i Pinterest. Dołącz do setek użytkowników, którzy zebrali ponad 6 milionów zapytań i uzyskaj potrzebne Ci informacje.

Kluczowe korzyści

- Specjalistyczne interfejsy API: Oferuje gotowe rozwiązania przeznaczone specjalnie dla platform mediów społecznościowych.

- Nie potrzeba kluczy API: Możesz ominąć konieczność posiadania oficjalnych kluczy API w przypadku witryn takich jak Twitch.

- Płać za zużycie: Płacisz tylko za to, z czego korzystasz, a Twoje środki nigdy nie wygasają.

- Bogate dane JSON: Interfejsy API udostępniają czyste i ustrukturyzowane dane JSON, dzięki czemu nie musisz wykonywać dodatkowego przetwarzania.

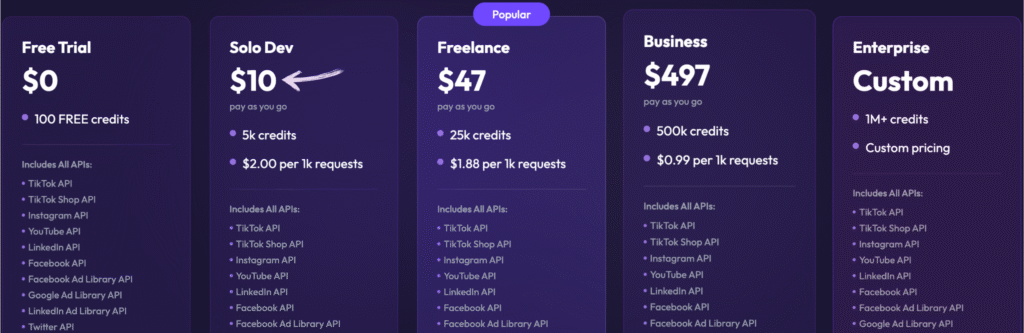

Wycena

- Bezpłatny okres próbny: 0, 100 darmowych kredytów.

- Solo Dev: 10 USD – Płać w miarę użytkowania, 5 tys. kredytów.

- Pracownik nieetatowy: 47 USD – Płać w miarę użytkowania, 25 tys. kredytów.

- Biznes: 497 USD – Płać w miarę użytkowania, 500 tys. kredytów.

- Przedsiębiorstwo: Cena niestandardowa, ponad 1 mln kredytów.

Zalety

Wady

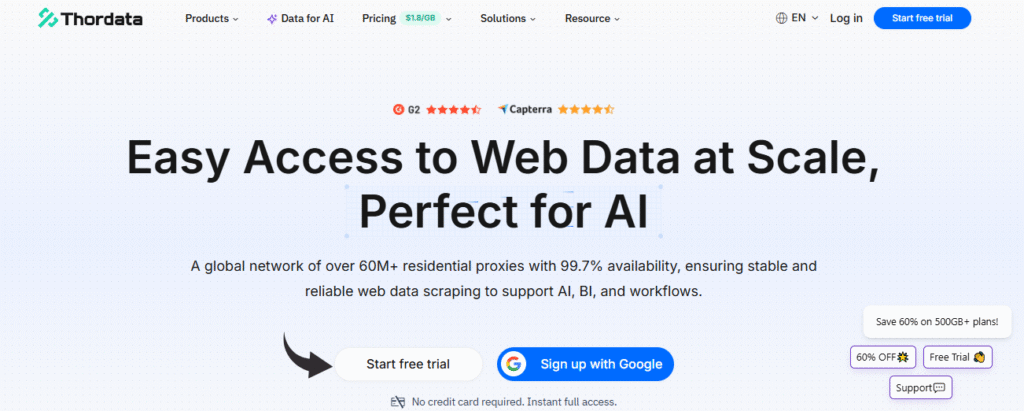

7. ThorData (⭐3.0)

ThorData to prosty interfejs API do scrapowania danych, niewymagający pisania kodu.

Na początek możesz skorzystać z 1000 bezpłatnych wywołań API.

Koncentruje się na dostarczaniu ustrukturyzowanych danych w formatach takich jak Excel i JSON.

To prosty sposób na automatyzację zbierania danych.

Nasze podejście

Ciesz się niezrównanym bezpieczeństwem dzięki ThorData. To dane Proces weryfikacji gwarantuje 99,7% skuteczności. Dzięki całodobowemu wsparciu na żywo i średniemu czasowi reakcji poniżej 3 minut możesz być pewien jakości połączenia. Uzyskaj ponad 60 milionów adresów IP i zabezpiecz swoje dane.

Kluczowe korzyści

- Ogromna pula adresów IP: Oferuje ponad 60 milionów etycznie pozyskanych adresów IP.

- Wysoka anonimowość: Zapewnia, że Twoja aktywność scrapowania pozostanie niewykryta dzięki wysokiej jakości serwerom proxy.

- Płać za zużycie: Rozliczenia są przejrzyste: płacisz tylko za wykorzystany ruch, a nie za nieudane żądania.

- Wbudowany skrobak: Zawiera narzędzie do scrapowania stron internetowych bez kodu i uniwersalny interfejs API, dzięki czemu nie potrzebujesz osobnego narzędzia do prostych projektów.

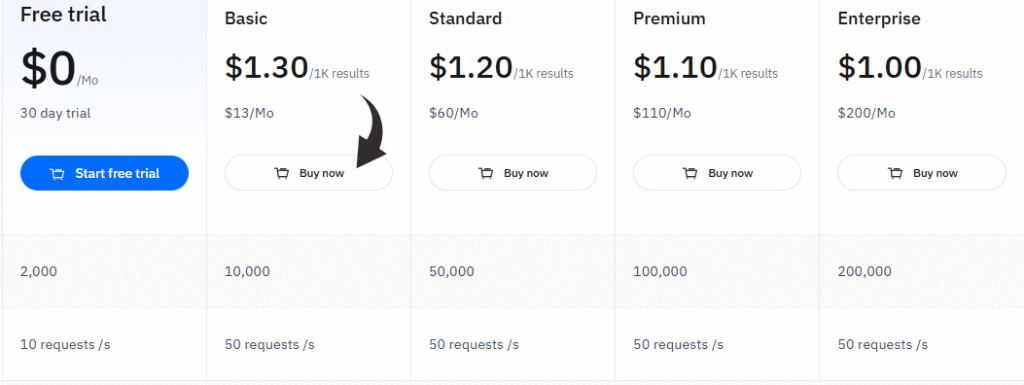

Wycena

- Bezpłatny okres próbny: 0 USD/miesiąc, 30-dniowy okres próbny.

- Podstawowy: 13 USD/miesiąc.

- Standard: 60 USD/miesiąc.

- Premia: 110 USD/miesiąc.

- Przedsiębiorstwo: 200 dolarów miesięcznie.

Zalety

Wady

Na co zwrócić uwagę wybierając narzędzie do scrapowania danych z Reddita?

Wybór właściwego narzędzia jest kluczowy dla uzyskania potrzebnych danych.

Nie wybieraj narzędzia, które łatwo się psuje lub które nieczytelnie przekazuje dane.

Zawsze bierz pod uwagę swój poziom umiejętności i ilość danych, których potrzebujesz.

Oto, na co należy zwrócić uwagę przy wyborze scrapera Reddita:

- Łatwość użytkowania: Czy jest bezkodowe i ma prosty interfejs typu „wskaż i kliknij”? A może wymaga znajomości Pythona? Dopasuj narzędzie do swojego poziomu technicznego.

- Struktura danych: Scraper musi dostarczać czyste, ustrukturyzowane dane. Oznacza to przejrzyste pliki JSON lub CSV, gotowe do analizy, a nie surowe. tekst.

- Funkcje zapobiegające blokowaniu: Reddit aktywnie stara się blokować boty. Dobry scraper musi obsługiwać rotację adresów IP i CAPTCHA, aby zapewnić dokończenie zadania.

- API/Integracja: Czy możesz połączyć go z innymi narzędziami, takimi jak Arkusze Google lub magazyn danych? Poszukaj interfejsów API, które ułatwią Ci przepływ pracy.

- Punkty danych: Powinien zbierać więcej niż tylko tytuł wpisu. Potrzebne są komentarze, głosy „za”, znaczniki czasu i pełne dane użytkownika.

- Skalowalność: Czy poradzi sobie z szybkim pobieraniem tysięcy postów z wielu subredditów? To kluczowe dla badań rynku na dużą skalę.

- Harmonogram: Najlepsze narzędzia pozwalają skonfigurować zadania, które będą uruchamiane automatycznie każdego dnia lub tygodnia. Dzięki temu możesz śledzić trendy w czasie bez konieczności ręcznego wykonywania czynności.

W jaki sposób narzędzie Reddit Scraper może pomóc Twojemu biznesowi?

Możesz zyskać ogromną przewagę nad konkurencją.

Narzędzie do scrapowania stron internetowych Reddit szybko gromadzi dla Ciebie nowe informacje rynkowe.

Oznacza to, że możesz śledzić, co ludzie mówią o Twojej marce lub o Twoich konkurentach.

Zamieniasz surowe wątki konwersacji w cenne dane zebrane z Reddita.

Możesz śledzić trendy zanim staną się viralowe.

Sprawdzanie tematów poruszanych na subredditach pozwala na znalezienie nowych pomysłów na produkty lub szybkie rozwiązanie problemów.

Analizując każdy post i komentarz na Reddicie, możesz również odkryć ukryte potrzeby klientów.

To tak, jakby grupa fokusowa działała w czasie rzeczywistym 24 godziny na dobę, 7 dni w tygodniu.

Proces scrapowania danych z Reddita dostarcza czyste listy danych z Reddita.

Możesz wprowadzić te dane do własnych narzędzi, korzystając z interfejsu API Reddita, aby zautomatyzować generowanie raportów.

Dzięki temu możesz przeszukiwać Reddit w celu lepszego zrozumienia nastrojów społecznych.

Przewodnik kupującego

Podczas poszukiwania najlepszego produktu kierowaliśmy się następującymi czynnikami.

Nasza metoda skupiała się na rzeczywistej użyteczności ekstrakcji publicznie dostępnych danych.

- Cennik i dostęp:Przyjrzeliśmy się kosztom usługi i sposobom dostępu do niej. Sprawdziliśmy, czy potrzebujesz konta na Reddicie, czy tokenu deweloperskiego.

- Punkty danychCzy narzędzie może zbierać pełne dane? Obejmuje to adres URL wpisu, adresy URL Reddita i kluczowe szczegóły wpisu. Musi umożliwiać skanowanie subredditów i wyszukiwanie najpopularniejszych wpisów.

- Antyblokowanie:Przetestowaliśmy narzędzia zapobiegające blokowaniu przez sieć bezpieczeństwo. Częsty błąd – zgłoszenie nie może się zdarzyć. Sprawdziliśmy, jak radzić sobie z blokadą spowodowaną przez pomyłkę i zgłoszeniem do pomocy technicznej. Sprawdziliśmy dziennik pod kątem błędów połączenia.

- Funkcje i kod:Sprawdzaliśmy, czy można stworzyć scraper za pomocą kodu Pythona. Szukaliśmy przykładowego samouczka, zazwyczaj w formie filmu lub YouTube Link, aby pokazać proces. Omówiliśmy również, jak importować dane i uzyskiwać odpowiedzi.

- Łatwość użytkowania:Szukaliśmy prostoty. Czy można łatwo przewijać wyniki? Czy osoba niebędąca programistą mogłaby korzystać ze strony i kontynuować pracę bez dogłębnej wiedzy technicznej?

- Analiza i wynikiSprawdziliśmy, czy scraper jest przydatny do analizy sentymentu. Wynik musiał być czysty, a nie chaotyczny HTML.

- Zgodność i szacunekZadbaliśmy o to, aby każde narzędzie było zgodne z regulaminem Reddita. Położyliśmy nacisk na narzędzia, które szanują prywatność danych.

- Komunikacja i wsparcieCzy oferują dobre opinie? Czy możesz wysłać wiadomość lub uzyskać podsumowanie swoich problemów? Sprawdziliśmy ich wsparcie dla każdego artykułu lub samouczka.

- Podstawowa funkcjonalnośćMożliwość określenia konkretnej nazwy użytkownika i znalezienia odpowiedniego posta na subreddicie była kluczowa. Przetestowaliśmy, jak funkcja główna obsługuje różne słowa kluczowe i żądania.

- Przyszłe wykorzystanie:Rozważaliśmy takie funkcje, jak dodawanie zakładek i wyszukiwanie obrazów powiązanych z danymi. Narzędzie musi dostarczać końcowy adres URL za pomocą protokołu HTTPS.

- Ostatnia nadzieja:Ostatecznym celem jest zawsze uzyskanie niezawodnych danych, których potrzebujesz.

Podsumowanie

Przedstawiliśmy 7 najlepszych scraperów Reddit, których będziesz potrzebować w 2025 roku.

Teraz już wiesz, że uzyskanie czystych danych ze stron Reddita nie musi być trudne.

Pokazaliśmy Ci narzędzia dla każdego poziomu umiejętności. Niektóre nie wymagają kodu.

Inne pozwalają na wykorzystanie tokena deweloperskiego w celu uzyskania pogłębionego, niestandardowego dostępu.

Nasza lista zawiera najlepsze narzędzia, dzięki którym już dziś możesz zacząć śledzić trendy rynkowe.

Nie marnuj czasu na ręczne kopiowanie i wklejanie.

Wybierz inteligentny scraper, skonfiguruj go i uzyskaj informacje, które pomogą Ci biznes.

Wysłuchaliście nas i teraz macie odpowiednie narzędzia, aby wygrać w grze o dane.

Często zadawane pytania

Czy pozyskiwanie danych z Reddita jest legalne?

Tak, scrapowanie publicznie dostępnych danych jest generalnie legalne, ale należy przestrzegać Warunków korzystania z usługi Reddit oraz pliku robots.txt. Nadmierne, agresywne scrapowanie jest niedozwolone.

Czy potrzebuję konta na Reddicie, aby scrapować?

Nie, większość narzędzi do scrapowania danych umożliwia dostęp do publicznych subredditów bez zalogowanego konta Reddit. Jednak przekroczenie wyższych limitów żądań może wymagać użycia tokena.

Jaki jest najlepszy format wyjściowy dla zebranych danych z Reddita?

Najlepszymi formatami są pliki strukturalne, takie jak JSON i CSV. robić dane można łatwo importować do arkuszy kalkulacyjnych lub baz danych w celu natychmiastowej analizy.

Czy narzędzie do scrapowania danych z Reddita może uzyskać komentarze i dane użytkowników?

Tak, najlepsze narzędzia potrafią wyodrębnić pełną treść komentarzy, szczegóły wpisów, a nawet nazwę użytkownika powiązaną z daną treścią.

Czy zostanę zablokowany, jeśli zbiorę za dużo danych?

Tak, jeśli wysyłasz zbyt wiele żądań zbyt szybko, ryzykujesz zablokowanie przez zabezpieczenia sieci. Użyj scrapera z rotacją proxy, aby temu zapobiec.