Czy masz dość skomplikowanych narzędzi do web scrapingu, które sprawiają wrażenie pracy na pełen etat?

Rozumiemy, że ich używanie może być skomplikowane.

Próba pobrania danych ze stron może okazać się uciążliwa, zwłaszcza gdy natrafisz na przeszkodę.

Marnujesz cenny czas i szybko nie osiągasz żadnych celów.

Dlatego stworzyliśmy listę najlepszych Twórcy scrapowania alternatywy. Ten przewodnik pomoże Ci znaleźć potężne i proste narzędzie do pozyskiwania potrzebnych danych.

Do dzieła!

Jakie są najlepsze alternatywy dla narzędzi do tworzenia scrapbooków?

Jeśli szukasz lepszego sposobu na pozyskiwanie danych, trafiłeś we właściwe miejsce.

Dołożyliśmy wszelkich starań, aby znaleźć najlepsze, łatwiejsze w użyciu i bardziej wydajne narzędzia. Nasza lista zawiera proste opcje bez kodu oraz zaawansowane narzędzia dla programistów.

Znajdziesz idealne narzędzie odpowiadające Twoim potrzebom.

1. ScrapingBee (⭐4.8)

ScrapingBee to interfejs API do scrapowania stron internetowych przeznaczony dla programistów.

Wykonuje za Ciebie trudniejsze części, takie jak zarządzanie przeglądarkami bez interfejsu użytkownika i rotacja serwerów proxy.

To API do scrapowania jest idealne dla programistów, którzy chcą uniknąć technicznych problemów związanych ze scrapowaniem stron internetowych.

Szczególnie przydatne do gromadzenia media społecznościowe dane do badań rynku.

Nasze podejście

Zdobądź dane Potrzebujesz ich z ponad 98% stron internetowych. Potężne API do scrapowania stron internetowych ScrapingBee oferuje renderowanie JavaScript, API wyszukiwarki Google oraz możliwość ekstrakcji danych strukturalnych z dokładnością do 99,5% na stronach dynamicznych.

Kluczowe korzyści

- Zajmie się wszystkim za Ciebie: Zarządza automatycznie rotacją serwerów proxy i renderowaniem JavaScript.

- Proste API: Za pomocą jednego, prostego wywołania API otrzymasz czyste dane.

- 99,9% czasu sprawności: Platforma charakteryzuje się wysoką niezawodnością i stabilną wydajnością.

- Obszerna dokumentacja: Zawiera przejrzystą i wyczerpującą dokumentację z przykładami kodu dla wielu języków, co ułatwia rozpoczęcie pracy.

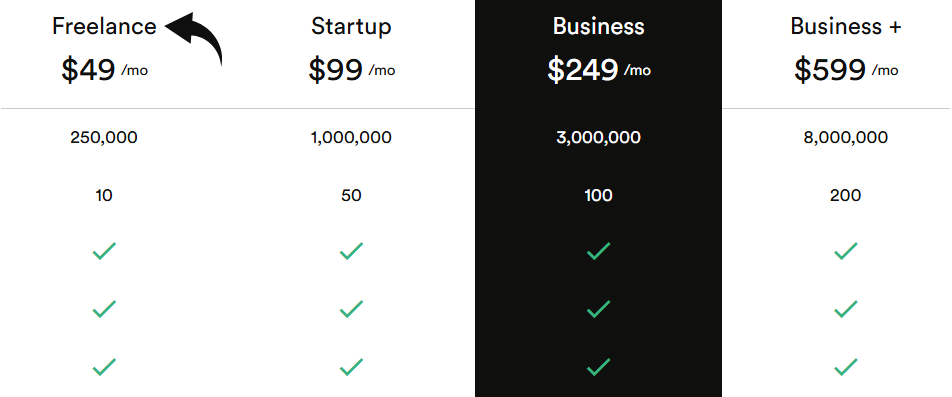

Wycena

Wszystkie plany będą rozliczane rocznie.

- Pracownik nieetatowy: 49 USD/miesiąc.

- Uruchomienie: 99 USD/miesiąc.

- Biznes: 249 USD/miesiąc.

- Biznes+: 599 USD/miesiąc.

Zalety

Wady

2. Apify (⭐4.5)

Apify to oparta na chmurze platforma do scrapowania stron internetowych i automatyzacja.

Został stworzony zarówno dla programistów, jak i osób niebędących programistami.

Możesz wykorzystać jego ogromną bibliotekę gotowych aktorów do scrapowania stron internetowych bez konieczności pisania kodu.

This tool offers solutions for media społecznościowe ekstrakcja danych.

Elastyczna platforma i duży zbiór narzędzi robić łatwo zacząć skrobać.

Nasze podejście

Chcesz przekonać się na własne oczy o możliwościach Apify? Nasza platforma została wykorzystana do zeskanowania ponad 2,5 miliona stron internetowych i przetworzenia ponad 500 TB danych w ciągu jednego miesiąca. Gotowy do działania?

Kluczowe korzyści

- Ogromny rynek: W sklepie Apify Store dostępnych jest ponad 5000 gotowych do użycia programów do scrapowania i automatyzacji, zwanych aktorami.

- Maksymalna skalowalność: Zaprojektowane do zadań na poziomie korporacyjnym, umożliwia przetwarzanie na dużą skalę milionów stron.

- Przyjazne dla programistów: Udostępnia pakiet SDK typu open source i obsługuje niestandardowy kod w językach Python i JavaScript.

- Zaawansowane planowanie: Zautomatyzuj zadania scrapowania, aby były wykonywane w określonych godzinach lub odstępach czasu, bez konieczności wykonywania czynności ręcznych.

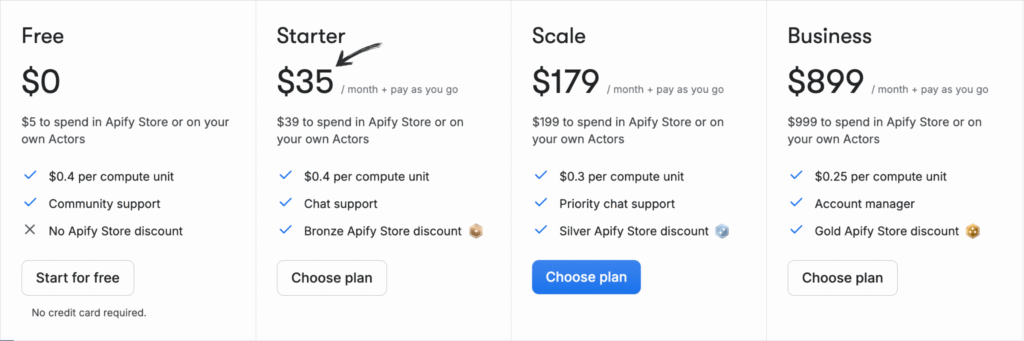

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: 0 zł/miesiąc + Płać zgodnie z zużyciem.

- Rozrusznik: 35 USD/miesiąc + płatność w miarę zużycia.

- Skala: 179 USD/miesiąc + Płać za zużycie.

- Biznes: 899 USD/miesiąc + płatność w miarę zużycia.

Zalety

Wady

3. Oxylabs (⭐4.0)

Oxylabs to zaufana firma zajmująca się analizą sieci, oferująca wydajne usługi proxy i narzędzia do scrapowania stron internetowych.

Jest znana ze swojej dużej sieci adresów IP i zaawansowanych funkcji.

Może zbierać dane w czasie rzeczywistym z mediów społecznościowych i innych źródeł.

Ich potężne narzędzie do scrapowania stron internetowych jest stworzone do obsługi skomplikowanego procesu ekstrakcji danych na dużą skalę.

Nasze podejście

Odblokuj dane dzięki wiodącej usłudze proxy. Z ponad 175 milionami serwerów proxy domowych, 2 milionami dedykowanych serwerów proxy w centrach danych i 20 milionami serwerów proxy mobilnych, Oxylabs zapewnia adresy IP potrzebne do każdego projektu.

Kluczowe korzyści

- Asystent AI OxyCopilot: To narzędzie umożliwia generowanie żądań scrapowania przy użyciu prostego, naturalnego języka.

- Ogromna sieć proxy: Posiada jedną z największych pul serwerów proxy na świecie, obejmującą adresy IP ze 195 krajów.

- Gwarancja sukcesu: Oparte na sztucznej inteligencji odciski palców platformy i omijanie testu CAPTCHA gwarantują wysoki wskaźnik powodzenia nawet w przypadku najtrudniejszych witryn.

- Bezpieczeństwo klasy korporacyjnej: Platforma posiada certyfikat ISO/IEC 27001:2022, co gwarantuje wysoki poziom bezpieczeństwa i prywatności danych.

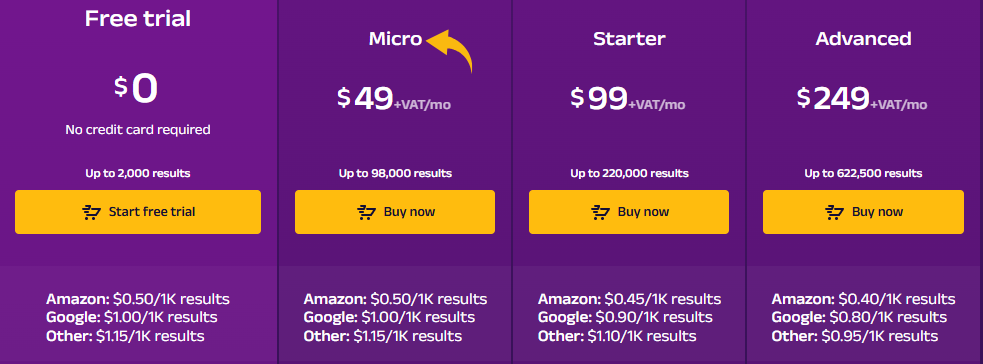

Wycena

- Bezpłatny okres próbny: $0.

- Mikro: 49 USD/miesiąc + VAT.

- Rozrusznik: 99 USD/miesiąc + VAT.

- Zaawansowany: 249 USD/miesiąc + VAT.

Zalety

Wady

4. Przeglądaj AI (⭐3.8)

Browse AI to sieć bez kodu narzędzie do skrobania.

Pozwala wyszkolić robota do pobierania danych z dowolnej strony internetowej. Interfejs „wskaż i kliknij” ułatwia ekstrakcję danych.

Zawiera również wstępnie zbudowane roboty do pozyskiwania danych z mediów społecznościowych, co czyni je doskonałym narzędziem do scrapowania danych ze stron internetowych dla marketerów.

Odkryj jego potencjał dzięki naszemu Przeglądaj samouczek dotyczący sztucznej inteligencji.

Nasze podejście

Chcesz zaoszczędzić czas i uzyskać potrzebne dane? Browse AI poradzi sobie z milionami stron internetowych. Zobacz, jak łatwe może być scrapowanie stron internetowych.

Kluczowe korzyści

- Kod nie jest wymagany: Dzięki interfejsowi typu „wskaż i kliknij” każdy może w ciągu kilku minut stworzyć narzędzie do pozyskiwania danych.

- Adaptacja wspomagana przez sztuczną inteligencję: Narzędzie automatycznie dostosowuje się do zmian w układzie witryny, zapewniając zawsze spójność danych.

- Ponad 7000 integracji: Łatwo połącz zebrane dane z aplikacjami takimi jak Arkusze Google, Airtable i Zapier.

- Gotowe roboty: Uzyskaj dostęp do biblioteki gotowych robotów przeznaczonych do wykonywania typowych zadań na popularnych stronach internetowych, oszczędzając jeszcze więcej czasu.

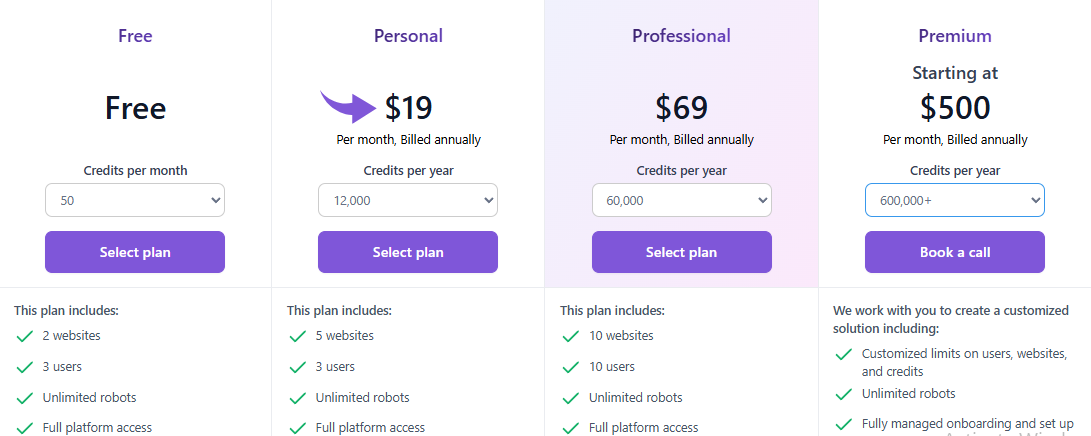

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: $0.

- Osobisty: 19 USD/miesiąc.

- Profesjonalny: 69 USD/miesiąc.

- Premia: Od 500 USD/miesiąc.

Zalety

Wady

5. Zyte (⭐3,5)

Zyte to kompleksowa platforma do scrapowania stron internetowych.

Istnieje już od dawna i wielu ludzi mu ufa.

Pomaga programistom hostować i zarządzać swoimi robotami indeksującymi w chmurze. Oferuje również zaawansowane API, które obsługuje obronę przed botami.

Platforma Zyte jest przeznaczona do ekstrakcji danych z mediów społecznościowych na dużą skalę.

Nasze podejście

Uzyskaj najbardziej niezawodną sieć dane z API Zyte. Osiągnij 99,99% dokładności danych w swoich projektach dzięki temu wysokiej jakości API do scrapowania stron internetowych i usprawnij proces ekstrakcji danych już dziś.

Kluczowe korzyści

- Automatyczne odblokowywanie: Przestań żonglować serwerami proxy; Zyte API to potężne, zautomatyzowane narzędzie do obsługi banów.

- Bezproblemowa integracja ze Scrapy: Jeśli jesteś programistą korzystającym z frameworka Scrapy, Zyte będzie dla Ciebie idealnym rozwiązaniem.

- Ekstrakcja danych wspomagana sztuczną inteligencją: Narzędzie może automatycznie identyfikować i analizować dane, zmniejszając potrzebę ręcznego stosowania reguł analizy.

- Zintegrowana przeglądarka bez interfejsu: Nie ma potrzeby korzystania z przeglądarek bezgłowych innych firm, ponieważ Zyte udostępnia przeglądarkę zoptymalizowaną pod kątem scrapowania stron internetowych na dużą skalę.

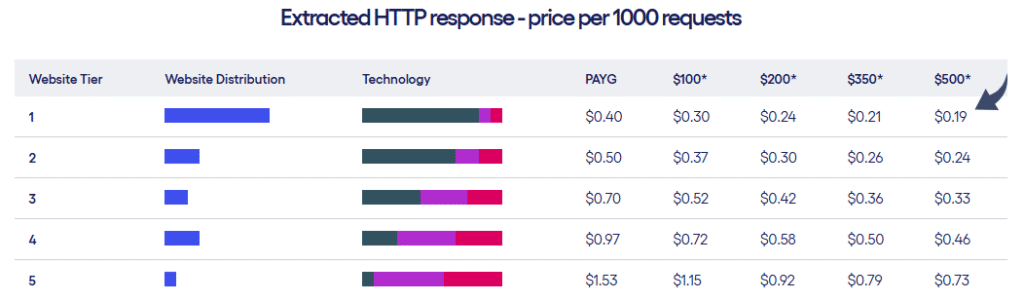

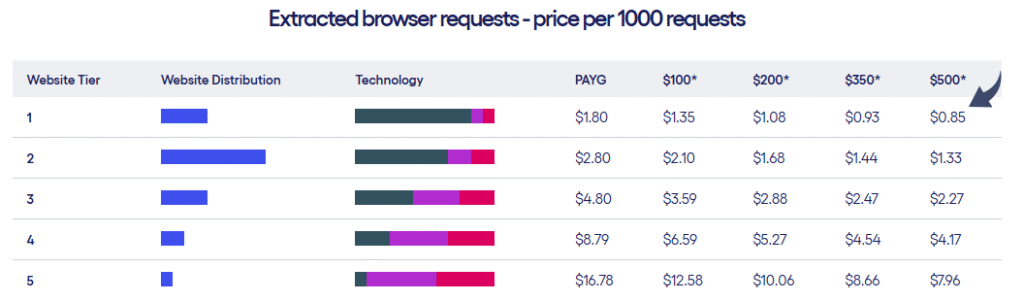

Wycena

- Zyte oferuje dwa rodzaje planów cenowych w zależności od poziomu witryn i liczby żądań.

Zalety

Wady

6. Sztuczna inteligencja ScrapeGraph (⭐3.2)

ScrapeGraph AI to wyjątkowa biblioteka języka Python wykorzystująca sztuczną inteligencję do scrapowania stron internetowych.

Wystarczy, że powiesz mu prostym językiem, jakich informacji chcesz się dowiedzieć.

Następnie wykorzystuje podejście oparte na grafie, aby pobrać dane za Ciebie.

To nowatorskie podejście do scrapowania stron internetowych. To narzędzie oparte na sztucznej inteligencji upraszcza skomplikowaną ekstrakcję danych.

Nasze podejście

Wiodący specjaliści (ponad 350 osób) zaufali ScrapeGraphAI ze względu na jego solidne, oparte na sztucznej inteligencji możliwości scrapowania stron internetowych. Zapewnij sobie 20% wzrost wydajności na kolejne 48 godzin.

Kluczowe korzyści

- Scraping języka naturalnego: Możesz wskazać mu, co ma wyodrębnić, używając prostych, zrozumiałych dla człowieka monitów.

- Biblioteka Open Source: Deweloperzy mogą wykorzystać jego wszechstronną bibliotekę typu open-source, aby uzyskać maksymalną kontrolę.

- Funkcja Markdownify: Potrafi konwertować całe strony internetowe na przejrzyste, czytelne dokumenty Markdown.

- Agentic Scraper: Sztuczna inteligencja potrafi autonomicznie poruszać się po stronach internetowych i wchodzić z nimi w interakcje, wykonując złożone, wieloetapowe zadania.

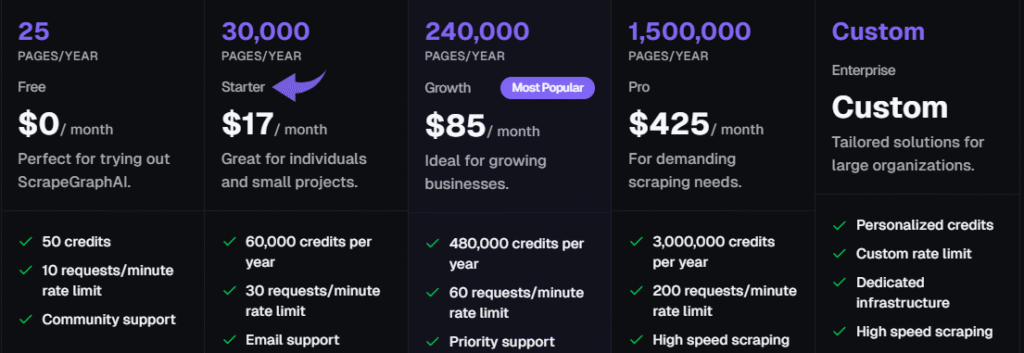

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: 0 zł/miesiąc.

- Rozrusznik: 17 USD/miesiąc.

- Wzrost: 85 USD/miesiąc.

- Zawodowiec: 425 USD/miesiąc.

- Przedsiębiorstwo: Indywidualne ceny.

Zalety

Wady

7. ThorData (⭐3.0)

ThorData to platforma oferująca zarówno infrastrukturę proxy, jak i narzędzia do scrapowania stron internetowych.

Uniwersalny interfejs API do scrapowania został zaprojektowany tak, aby naśladować rzeczywiste zachowania człowieka w przypadku zaawansowanych zadań scrapowania.

Ten skrobak stron internetowych oferuje zarówno opcję bez kodu, jak i potężne API dla programistów.

Może zbierać dane w czasie rzeczywistym z platform mediów społecznościowych.

Nasze podejście

Ciesz się niezrównanym bezpieczeństwem dzięki ThorData. To dane Proces weryfikacji gwarantuje 99,7% skuteczności. Dzięki całodobowemu wsparciu na żywo i średniemu czasowi reakcji poniżej 3 minut możesz być pewien jakości połączenia. Uzyskaj ponad 60 milionów adresów IP i zabezpiecz swoje dane.

Kluczowe korzyści

- Ogromna pula adresów IP: Oferuje ponad 60 milionów etycznie pozyskanych adresów IP.

- Wysoka anonimowość: Zapewnia, że Twoja aktywność scrapowania pozostanie niewykryta dzięki wysokiej jakości serwerom proxy.

- Płać za zużycie: Rozliczenia są przejrzyste: płacisz tylko za wykorzystany ruch, a nie za nieudane żądania.

- Wbudowany skrobak: Zawiera narzędzie do scrapowania stron internetowych bez kodu i uniwersalny interfejs API, dzięki czemu nie potrzebujesz osobnego narzędzia do prostych projektów.

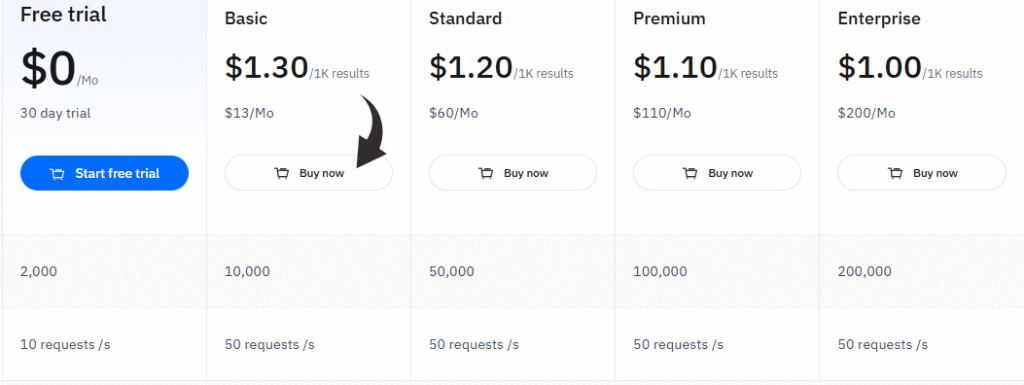

Wycena

- Bezpłatny okres próbny: 0 USD/miesiąc, 30-dniowy okres próbny.

- Podstawowy: 13 USD/miesiąc.

- Standard: 60 USD/miesiąc.

- Premia: 110 USD/miesiąc.

- Przedsiębiorstwo: 200 dolarów miesięcznie.

Zalety

Wady

Przewodnik kupującego

Oceniliśmy każdy produkt na podstawie kilku kluczowych czynników, aby mieć pewność, że nasze rekomendacje są najlepsze.

Przyjrzeliśmy się temu, co wyróżnia poszczególne narzędzia do scrapowania stron internetowych, a czego może w nich brakować.

Nasz proces badawczy był prosty i skoncentrowany na dostarczeniu Ci informacji, których potrzebujesz, aby dokonać dobrego wyboru.

Oto jak to zrobiliśmy:

- Wycena: Sprawdziliśmy ceny każdego narzędzia, w tym czy oferują darmowy okres próbny lub darmowy plan na start. Przyjrzeliśmy się różnym modelom cenowym, aby znaleźć opcje dla różnych budżetów.

- Cechy: Przyjrzeliśmy się bliżej funkcjom każdego narzędzia. Szukaliśmy takich rzeczy, jak przyjazny dla użytkownika interfejs typu „wskaż i kliknij”, możliwość obsługi danych w czasie rzeczywistym oraz czy oferują wydajne API. Sprawdziliśmy również, czy zawierają integrację z Arkuszami Google, aby ułatwić zbieranie danych.

- Negatywy: Szukaliśmy potencjalnych wad. Czy krzywa uczenia się była stroma? Czy narzędzie miało problemy z zabezpieczeniami antyscrapingowymi? Czy brakowało czegoś, co czyniłoby je mniej użytecznym w takich zadaniach jak TikTok lub innych konkretnych platformach, takich jak media społecznościowe?

- Wsparcie i społeczność: Zbadaliśmy, jaki rodzaj wsparcia oferuje każda usługa. Sprawdziliśmy, czy mają forum społecznościowe, pomocne samouczki lub bezpośrednią obsługę klienta. Rozważyliśmy również ich politykę zwrotów.

- Wydajność: Oceniliśmy, jak dobrze każde narzędzie potrafi wyodrębnić dane i zwrócić je w postaci czystych, ustrukturyzowanych danych. Rozważyliśmy również, jak dobrze scrapery radzą sobie z typowymi wyzwaniami, nie blokując się.

- Integracja AI: Szukaliśmy narzędzi wykorzystujących agentów AI lub inne funkcje AI, aby uczynić scrapowanie inteligentniejszym i bardziej efektywnym.

Podsumowanie

Znalezienie właściwego i najlepszego narzędzia odpowiadającego Twoim potrzebom może stanowić wyzwanie.

Przyjrzeliśmy się wielu różnym opcjom, aby pomóc Ci wybrać najlepsze narzędzie do zbierania danych z Internetu.

Pod uwagę braliśmy kluczowe cechy, cenę i łatwość obsługi dla użytkowników.

Teraz możesz wybrać narzędzie, które jest dla Ciebie odpowiednie.

Niezależnie od tego, czy potrzebujesz prostego interfejsu typu „wskaż i kliknij”, czy też zaawansowanego interfejsu API obsługującego złożone żądania.

Wybierając odpowiednie narzędzie, możesz wyodrębnić dane z różnych platform i stron internetowych, co pomoże Ci stworzyć rozwiązanie skalowalne.

Często zadawane pytania

Is web scraping illegal?

Generally, no. It’s legal for public data. Courts, like in the hiQ vs. LinkedIn case, have protected the scraping of publicly available information. However, bypassing paywalls or harvesting personal data is a legal “no-go.” Always respect a site’s robots.txt file.

Is it possible to scrape data from a website?

Absolutely. Almost any public site can be scraped. While some sites use advanced anti-bot shields, modern tools like ScraperAPI are designed to bypass these blocks effortlessly. If the data is visible to a standard browser, a scraper can likely extract it.

Which is best for web scraping?

It depends on your skill. Developers typically swear by Scrapy or BeautifulSoup for total customization. If you prefer a visual approach, Octoparse is the winner. For massive enterprise projects requiring heavy anti-bot protection, Jasne dane is the undisputed industry leader.

What is the best tool for web scraping?

Bright Data is widely considered the best for power and reliability. It handles proxy rotation and CAPTCHAs without breaking a sweat. For those on a budget, ParseHub or Octoparse offer excellent free tiers that work perfectly for smaller, straightforward projects.

Which scraping tool is best for beginners?

Octoparse is the gold standard for non-coders. It features a point-and-click interface, allowing you to select data directly on the screen. No coding required. ParseHub is another fantastic visual alternative that makes complex data extraction feel like a simple walkthrough.

Can ChatGPT create a web scraper?

Yes, and it’s fast. ChatGPT can generate Python scripts using BeautifulSoup or Selenium in seconds. While it provides the logic, you still need to execute the code yourself. It’s perfect for simple tasks, though complex sites might require some manual fine-tuning.

What is an example of web scraping?

Price monitoring is the classic use case. Retailers scrape sites like Amazon to adjust their own prices dynamically. Other examples include pulling nieruchomość listings, gathering sports stats for analysis, or aggregating news for AI training. It turns the web into a structured database.

More Facts about Scrape creators Alternatives

- ScrapingBee, Apify, and Octoparse are great choices if you don’t want to use Scrape Creators. They work well for social media and online shops.

- In 2026, the best tools for getting data from websites are Bright Data, ScrapingBee, Apify, and Octoparse.

- ScrapingBee is a helpful tool that handles tricky website code and hides your identity while you work.

- ScrapingFish is built to be very fast and doesn’t waste any time.

- ScrapingAnt is an easy-to-use tool that gets the job done without any extra fuss.

- Scrapfly is a simple tool that can grow as your project gets bigger.

- ZenRows is great at getting past “robot blockers” on modern websites to get the info you need.

- Oxylabs has a special tool that helps it get into “stubborn” websites that try to block users.

- A web scraper is good for projects that need to pull large amounts of data regularly. It can even read websites that change or update while you are looking at them.

- Scraper API lets you take data from any public site without worrying about technical blocks like “I am not a robot” tests (CAPTCHA). You can even try it for free for 7 days.

- ParseHub is a program you download to your computer that helps you get data without writing any code.

- Scrapy is a famous tool for giant projects, but it’s like a “manual” car—you have to set up the tricky parts yourself.

- Most of these tools are easy to use, with simple buttons that make the work easier. Many “no-code” tools can do the work automatically, saving you time.

- No-code tools are smart enough to read websites that use complex computer code (JavaScript).

- You can save your data in common files like Excel, Google Sheets, or simple lists (JSON).

- Some tools have “starter kits” or templates that help you begin scraping popular websites right away.

- Bright Data has the world’s largest network, with over 150 million connections. It is a specialist at helping people scrape shopping websites.

- Web scraping APIs make it much easier to pull information off the web and turn a messy website into a neat, organized list.

- People use these tools for things like market research or seeing what prices their competitors are charging.

- Octoparse has a “visual budowniczy” that automatically highlights lists and tables on a website for you. It lets you turn any website into a list without knowing how to code.

- Firecrawl is a newer tool made specifically for AI. It turns web pages into a format that AI programs like to read.

- Selenium and Playwright are tools that act like a real person clicking and scrolling on a website.

- Kadoa is a very smart tool that figures out what data is on its own, even if the website changes its layout.

- Oxylabs has an AI helper called OxyCopilot that lets you request the data you want using everyday words.