Czy kiedykolwiek czułeś się tak, jakbyś próbował pić z węża strażackiego, gdy potrzebowałeś danych z sieci?

To frustrujące. A co, gdyby istniał lepszy sposób?

Sztuczna inteligencja zmienia zasady gry, a frustrujący świat scrapowania stron internetowych staje się prosty.

Nie musisz już zajmować się skomplikowanym kodem ani dać się złapać zabezpieczeniom anty-bot.

Właśnie dlatego w tym artykule stworzyliśmy listę 7 najlepszych narzędzi AI do scrapowania stron internetowych w celu ekstrakcji danych w 2025 roku.

Po przeczytaniu tego tekstu będziesz dokładnie wiedzieć, z którego narzędzia skorzystać, aby uzyskać potrzebne Ci dane.

Jakie są najlepsze narzędzia AI do scrapowania stron internetowych?

Znalezienie najlepszego narzędzia przy tak wielu dostępnych opcjach może wydawać się niemożliwe.

Właściwy wybór zależy od tego, do czego potrzebujesz danego narzędzia — czy jest to prosty projekt, czy też zadanie polegające na zbieraniu ogromnych ilości danych.

Nie martw się, wykonaliśmy za Ciebie najtrudniejszą pracę. Oto nasza lista najlepszych narzędzi AI do scrapowania stron internetowych.

1. Apify (⭐4.8)

Apify jest kompleksową platformą do scrapowania stron internetowych.

Pomyśl o nim jak o kompleksowym rozwiązaniu do ekstrakcji danych. Jest niezwykle elastyczny – możesz korzystać z gotowych scraperów lub tworzyć własne.

To świetne narzędzie dla deweloperów poszukujących wydajnego i skalowalnego rozwiązania.

Zamienia także dowolną stronę internetową w użyteczny interfejs API, ułatwiając integrację z istniejącymi systemami.

Nasze podejście

Chcesz przekonać się na własne oczy o możliwościach Apify? Nasza platforma została wykorzystana do zeskanowania ponad 2,5 miliona stron internetowych i przetworzenia ponad 500 TB danych w ciągu jednego miesiąca. Gotowy do działania?

Kluczowe korzyści

- Ogromny rynek: W sklepie Apify Store dostępnych jest ponad 5000 gotowych do użycia programów do scrapowania i automatyzacji, zwanych aktorami.

- Maksymalna skalowalność: Zaprojektowane do zadań na poziomie korporacyjnym, umożliwia przetwarzanie na dużą skalę milionów stron.

- Przyjazne dla programistów: Udostępnia pakiet SDK typu open source i obsługuje niestandardowy kod w językach Python i JavaScript.

- Zaawansowane planowanie: Zautomatyzuj zadania scrapowania, aby były wykonywane w określonych godzinach lub odstępach czasu, bez konieczności wykonywania czynności ręcznych.

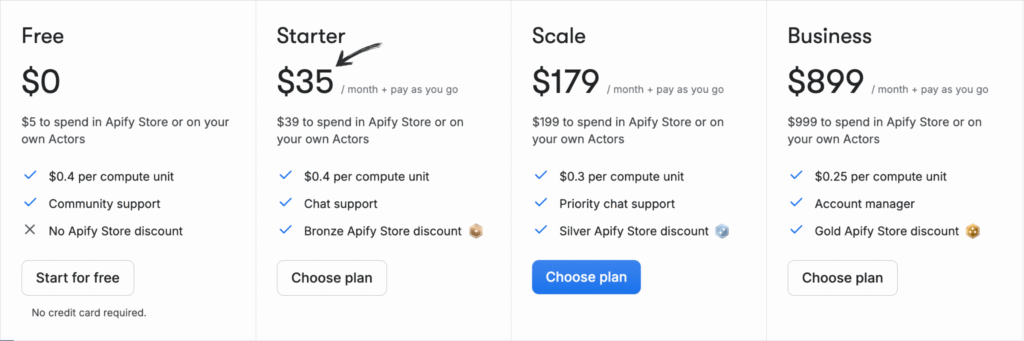

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: 0 zł/miesiąc + Płać zgodnie z zużyciem.

- Rozrusznik: 35 USD/miesiąc + płatność w miarę zużycia.

- Skala: 179 USD/miesiąc + Płać za zużycie.

- Biznes: 899 USD/miesiąc + płatność w miarę zużycia.

Zalety

Wady

2. Oxylabs (⭐4,5)

Oxylabs jest znana ze swoich wysokiej klasy usług proxy, ale jest także wydajną platformą do scrapowania stron internetowych.

To doskonały wybór dla firm, które muszą pozyskiwać dane na dużą skalę, nie narażając się na blokady.

Ich funkcje sztucznej inteligencji robić scrapowanie dynamicznych stron internetowych staje się proste.

To usługa najwyższej klasy, której zaufały duże firmy i przedsiębiorstwa ze względu na jej niezawodność i bezpieczeństwo.

Nasze podejście

Odblokuj dane dzięki wiodącej usłudze proxy. Z ponad 175 milionami serwerów proxy domowych, 2 milionami dedykowanych serwerów proxy w centrach danych i 20 milionami serwerów proxy mobilnych, Oxylabs zapewnia adresy IP potrzebne do każdego projektu.

Kluczowe korzyści

- Asystent AI OxyCopilot: To narzędzie umożliwia generowanie żądań scrapowania przy użyciu prostego, naturalnego języka.

- Ogromna sieć proxy: Posiada jedną z największych pul serwerów proxy na świecie, obejmującą adresy IP ze 195 krajów.

- Gwarancja sukcesu: Oparte na sztucznej inteligencji odciski palców platformy i omijanie testu CAPTCHA gwarantują wysoki wskaźnik powodzenia nawet w przypadku najtrudniejszych witryn.

- Bezpieczeństwo klasy korporacyjnej: Platforma posiada certyfikat ISO/IEC 27001:2022, co gwarantuje wysoki poziom bezpieczeństwa i prywatności danych.

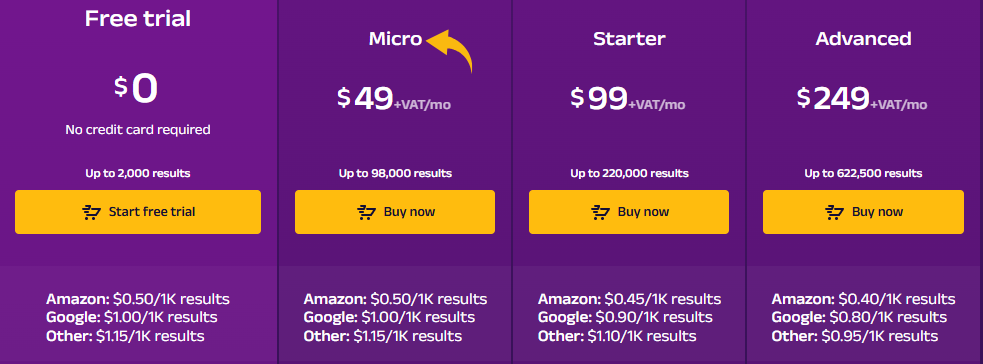

Wycena

- Bezpłatny okres próbny: $0.

- Mikro: 49 USD/miesiąc + VAT.

- Rozrusznik: 99 USD/miesiąc + VAT.

- Zaawansowany: 249 USD/miesiąc + VAT.

Zalety

Wady

3. ScrapingBee (⭐4.0)

ScrapingBee jest interfejsem API do scrapowania stron internetowych, zaprojektowanym, aby ułatwić życie programistom.

Nie musisz martwić się o serwery proxy, przeglądarki bez interfejsu graficznego ani blokady adresów IP.

Wystarczy wysłać prośbę, a system zajmie się resztą.

Doskonale nadaje się do integracji ekstrakcji danych z aplikacjami.

Rozwiązuje wszystkie problemy natury technicznej, dzięki czemu Ty możesz skupić się na kodzie.

Nasze podejście

Zdobądź dane Potrzebujesz ich z ponad 98% stron internetowych. Potężne API do scrapowania stron internetowych ScrapingBee oferuje renderowanie JavaScript, API wyszukiwarki Google oraz możliwość ekstrakcji danych strukturalnych z dokładnością do 99,5% na stronach dynamicznych.

Kluczowe korzyści

- Zajmie się wszystkim za Ciebie: Zarządza automatycznie rotacją serwerów proxy i renderowaniem JavaScript.

- Proste API: Za pomocą jednego, prostego wywołania API otrzymasz czyste dane.

- 99,9% czasu sprawności: Platforma charakteryzuje się wysoką niezawodnością i stabilną wydajnością.

- Obszerna dokumentacja: Zawiera przejrzystą i wyczerpującą dokumentację z przykładami kodu dla wielu języków, co ułatwia rozpoczęcie pracy.

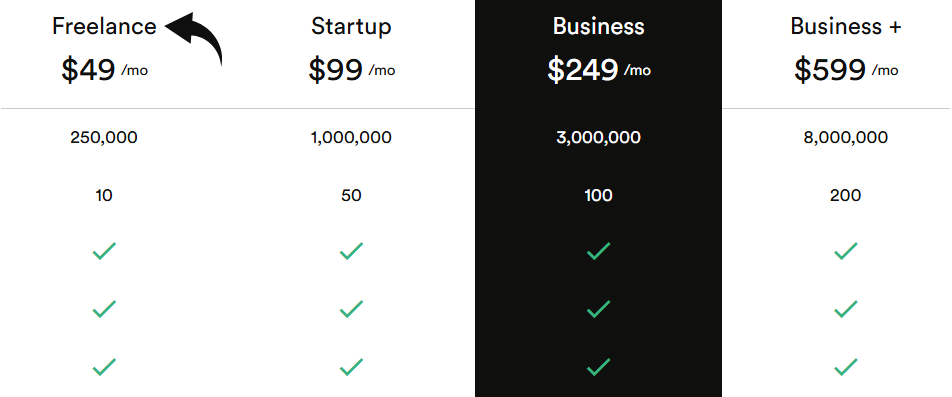

Wycena

Wszystkie plany będą rozliczane rocznie.

- Pracownik nieetatowy: 49 USD/miesiąc.

- Uruchomienie: 99 USD/miesiąc.

- Biznes: 249 USD/miesiąc.

- Biznes+: 599 USD/miesiąc.

Zalety

Wady

4. Przeglądaj AI (⭐3.8)

Czy musisz pozyskać dane, ale nie umiesz kodować? Przeglądaj AI jest dla Ciebie.

To narzędzie niewymagające kodu, które pozwala nauczyć robota wyodrębniania i monitorowania danych za pomocą zwykłego wskazywania i klikania.

Jest niezwykle przyjazny dla użytkownika i idealny dla osób niemających wiedzy technicznej.

Można nawet skonfigurować monitory, które będą wysyłać powiadomienia w czasie rzeczywistym za każdym razem, gdy na stronie zajdą jakieś zmiany.

Odkryj jego potencjał dzięki naszemu Przeglądaj samouczek dotyczący sztucznej inteligencji.

Nasze podejście

Chcesz zaoszczędzić czas i uzyskać potrzebne dane? Browse AI poradzi sobie z milionami stron internetowych. Zobacz, jak łatwe może być scrapowanie stron internetowych.

Kluczowe korzyści

- Kod nie jest wymagany: Dzięki interfejsowi typu „wskaż i kliknij” każdy może w ciągu kilku minut stworzyć narzędzie do pozyskiwania danych.

- Adaptacja wspomagana przez sztuczną inteligencję: Narzędzie automatycznie dostosowuje się do zmian w układzie witryny, zapewniając zawsze spójność danych.

- Ponad 7000 integracji: Łatwo połącz zebrane dane z aplikacjami takimi jak Arkusze Google, Airtable i Zapier.

- Gotowe roboty: Uzyskaj dostęp do biblioteki gotowych robotów przeznaczonych do wykonywania typowych zadań na popularnych stronach internetowych, oszczędzając jeszcze więcej czasu.

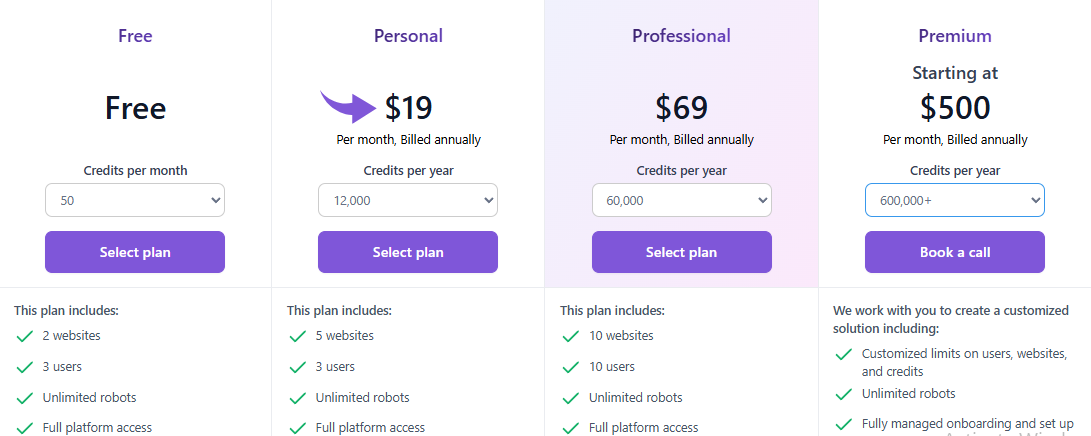

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: $0.

- Osobisty: 19 USD/miesiąc.

- Profesjonalny: 69 USD/miesiąc.

- Premia: Od 500 USD/miesiąc.

Zalety

Wady

5. Zyte (⭐3,5)

Zyte jest uznanym graczem na rynku scrapowania stron internetowych.

Jest to kompleksowa platforma oferująca zaawansowane API do scrapowania i zestaw narzędzi dla projektów związanych z danymi na dużą skalę.

Jest niezawodny, skalowalny i cieszy się zaufaniem wielu osób.

Unikalna technologia sztucznej inteligencji firmy poradzi sobie nawet z najbardziej wymagającymi stronami internetowymi.

Nasze podejście

Uzyskaj najbardziej niezawodną sieć dane z API Zyte. Osiągnij 99,99% dokładności danych w swoich projektach dzięki temu wysokiej jakości API do scrapowania stron internetowych i usprawnij proces ekstrakcji danych już dziś.

Kluczowe korzyści

- Automatyczne odblokowywanie: Przestań żonglować serwerami proxy; Zyte API to potężne, zautomatyzowane narzędzie do obsługi banów.

- Bezproblemowa integracja ze Scrapy: Jeśli jesteś programistą korzystającym z frameworka Scrapy, Zyte będzie dla Ciebie idealnym rozwiązaniem.

- Ekstrakcja danych wspomagana sztuczną inteligencją: Narzędzie może automatycznie identyfikować i analizować dane, zmniejszając potrzebę ręcznego stosowania reguł analizy.

- Zintegrowana przeglądarka bez interfejsu: Nie ma potrzeby korzystania z przeglądarek bezgłowych innych firm, ponieważ Zyte udostępnia przeglądarkę zoptymalizowaną pod kątem scrapowania stron internetowych na dużą skalę.

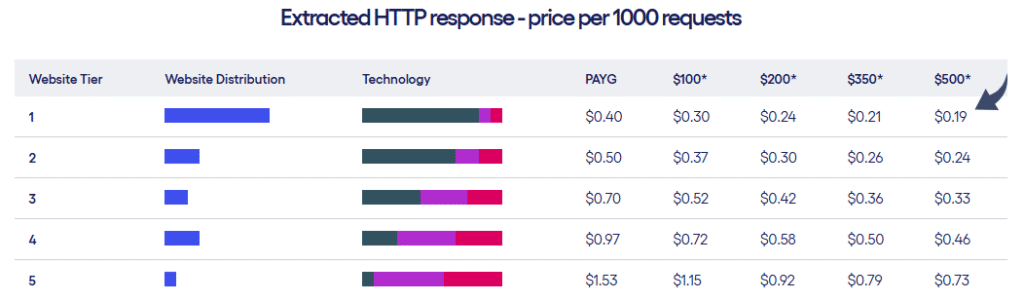

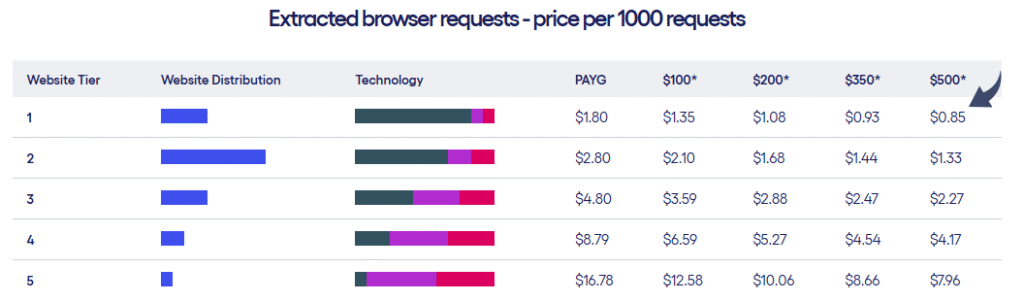

Wycena

- Zyte oferuje dwa rodzaje planów cenowych w zależności od poziomu witryn i liczby żądań.

Zalety

Wady

6. Twórcy scrapowania (⭐3.2)

Twórcy scrapowania jest narzędziem specjalistycznym.

Koncentruje się na ułatwieniu pozyskiwania danych z popularnych media społecznościowe platformy.

Możesz uzyskać informacje w czasie rzeczywistym z takich witryn jak TikTok, Twitch i Pinterest bez konieczności korzystania ze skomplikowanych oficjalnych interfejsów API.

To prawdziwa rewolucja dla marketerów i badaczy, którzy potrzebują tego konkretnego rodzaju danych.

Nasze podejście

Nie musisz już męczyć się ze zbieraniem danych z mediów społecznościowych. Dzięki Scrape Creators uzyskasz dane w czasie rzeczywistym z platform takich jak Twitch i Pinterest. Dołącz do setek użytkowników, którzy zebrali ponad 6 milionów zapytań i uzyskaj potrzebne Ci informacje.

Kluczowe korzyści

- Specjalistyczne interfejsy API: Oferuje gotowe rozwiązania przeznaczone specjalnie dla platform mediów społecznościowych.

- Nie potrzeba kluczy API: Możesz ominąć konieczność posiadania oficjalnych kluczy API w przypadku witryn takich jak Twitch.

- Płać za zużycie: Płacisz tylko za to, z czego korzystasz, a Twoje środki nigdy nie wygasają.

- Bogate dane JSON: Interfejsy API udostępniają czyste i ustrukturyzowane dane JSON, dzięki czemu nie musisz wykonywać dodatkowego przetwarzania.

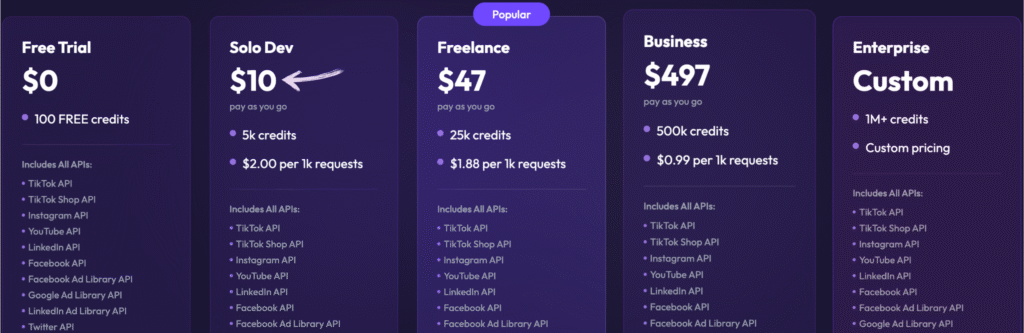

Wycena

- Bezpłatny okres próbny: 0, 100 darmowych kredytów.

- Solo Dev: 10 USD – Płać w miarę użytkowania, 5 tys. kredytów.

- Pracownik nieetatowy: 47 USD – Płać w miarę użytkowania, 25 tys. kredytów.

- Biznes: 497 USD – Płać w miarę użytkowania, 500 tys. kredytów.

- Przedsiębiorstwo: Cena niestandardowa, ponad 1 mln kredytów.

Zalety

Wady

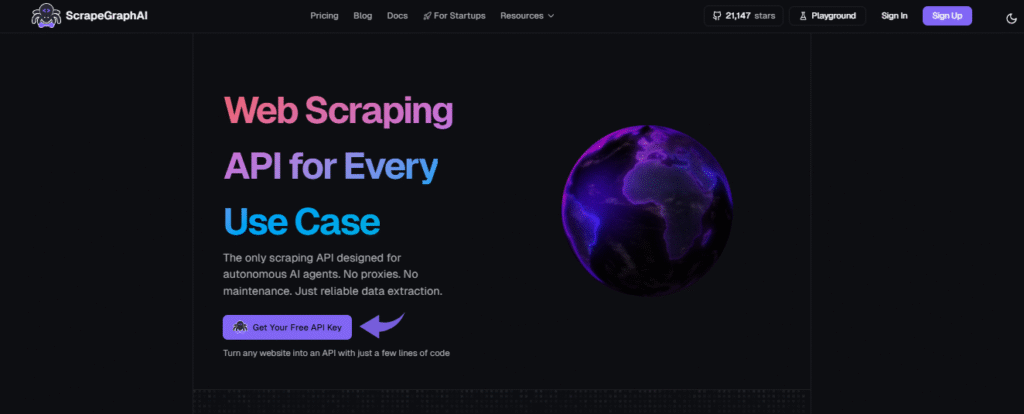

7. Sztuczna inteligencja ScrapeGraph (⭐3.0)

ScrapeGraph AI jest bardzo unikalnym narzędziem.

Wykorzystuje modele dużego języka (LLM), aby zrozumieć, co chcesz zeskrobać.

Wystarczy podać adres URL i w prosty sposób wyjaśnić, jakie dane ma pobrać.

Nie musisz już zajmować się skomplikowanym kodem ani selektorami.

To narzędzie świetnie sprawdzi się zarówno dla programistów, jak i użytkowników nietechnicznych, którzy chcą wykorzystać sztuczną inteligencję do ekstrakcji danych.

Nasze podejście

Wiodący specjaliści (ponad 350 osób) zaufali ScrapeGraphAI ze względu na jego solidne, oparte na sztucznej inteligencji możliwości scrapowania stron internetowych. Zapewnij sobie 20% wzrost wydajności na kolejne 48 godzin.

Kluczowe korzyści

- Scraping języka naturalnego: Możesz wskazać mu, co ma wyodrębnić, używając prostych, zrozumiałych dla człowieka monitów.

- Biblioteka Open Source: Deweloperzy mogą wykorzystać jego wszechstronną bibliotekę typu open-source, aby uzyskać maksymalną kontrolę.

- Funkcja Markdownify: Potrafi konwertować całe strony internetowe na przejrzyste, czytelne dokumenty Markdown.

- Agentic Scraper: Sztuczna inteligencja potrafi autonomicznie poruszać się po stronach internetowych i wchodzić z nimi w interakcje, wykonując złożone, wieloetapowe zadania.

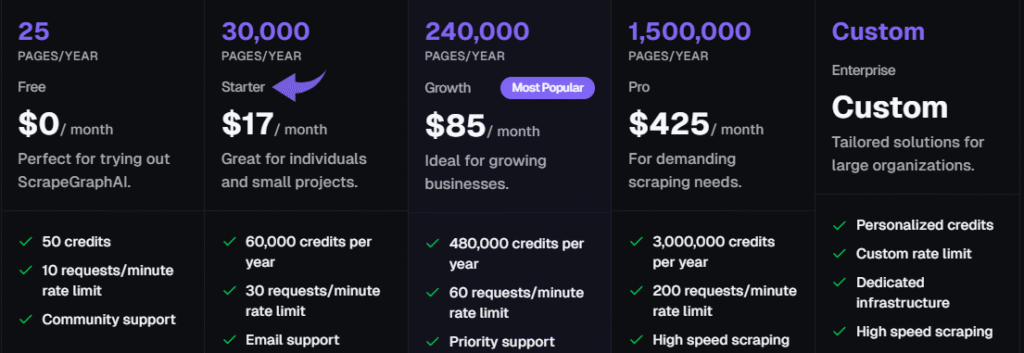

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: 0 zł/miesiąc.

- Rozrusznik: 17 USD/miesiąc.

- Wzrost: 85 USD/miesiąc.

- Zawodowiec: 425 USD/miesiąc.

- Przedsiębiorstwo: Indywidualne ceny.

Zalety

Wady

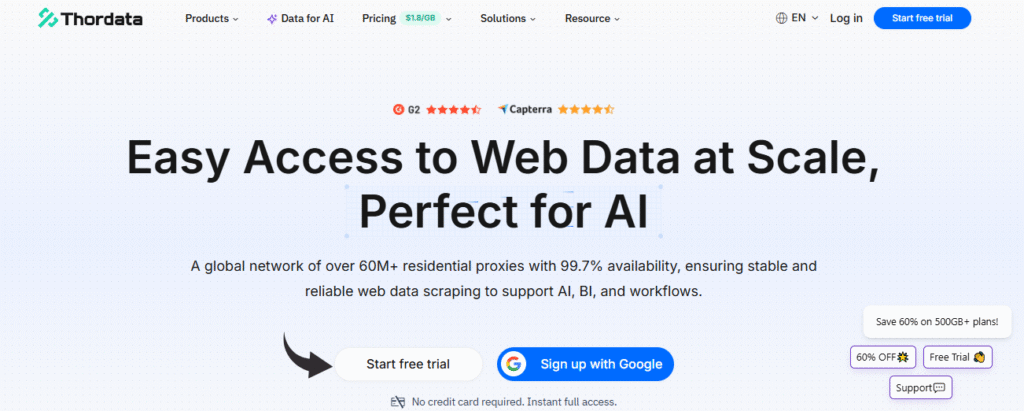

8. ThorData (⭐2.8)

ThorData to wysokiej jakości usługa proxy. Została stworzona z myślą o poważnych zadaniach związanych ze zbieraniem danych.

Mimo że jest to przede wszystkim dostawca serwerów proxy, jego usługi są niezbędne w przypadku każdego projektu scrapowania dużej ilości danych.

Dzięki temu możesz uzyskać dostęp do potrzebnych danych, nie narażając się na blokady.

Posiadają również własne narzędzia do skrobania, co jeszcze bardziej ułatwia cały proces.

Nasze podejście

Ciesz się niezrównanym bezpieczeństwem dzięki ThorData. To dane Proces weryfikacji gwarantuje 99,7% skuteczności. Dzięki całodobowemu wsparciu na żywo i średniemu czasowi reakcji poniżej 3 minut możesz być pewien jakości połączenia. Uzyskaj ponad 60 milionów adresów IP i zabezpiecz swoje dane.

Kluczowe korzyści

- Ogromna pula adresów IP: Oferuje ponad 60 milionów etycznie pozyskanych adresów IP.

- Wysoka anonimowość: Zapewnia, że Twoja aktywność scrapowania pozostanie niewykryta dzięki wysokiej jakości serwerom proxy.

- Płać za zużycie: Rozliczenia są przejrzyste: płacisz tylko za wykorzystany ruch, a nie za nieudane żądania.

- Wbudowany skrobak: Zawiera narzędzie do scrapowania stron internetowych bez kodu i uniwersalny interfejs API, dzięki czemu nie potrzebujesz osobnego narzędzia do prostych projektów.

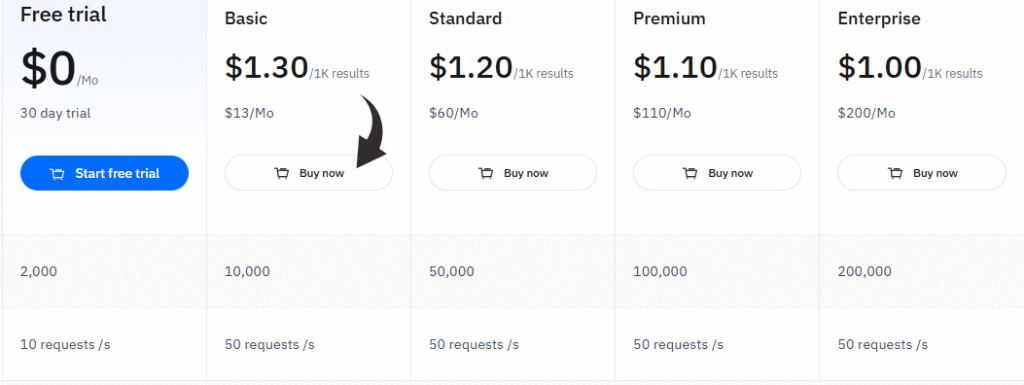

Wycena

- Bezpłatny okres próbny: 0 USD/miesiąc, 30-dniowy okres próbny.

- Podstawowy: 13 USD/miesiąc.

- Standard: 60 USD/miesiąc.

- Premia: 110 USD/miesiąc.

- Przedsiębiorstwo: 200 dolarów miesięcznie.

Zalety

Wady

Na co zwrócić uwagę przy wyborze najlepszego narzędzia do scrapowania stron internetowych?

- Łatwość użytkowania: Czy potrafisz wyodrębnić dane za pomocą kilku kliknięć, czy musisz napisać kod? Poszukaj narzędzia, które odpowiada Twojemu poziomowi umiejętności, niezależnie od tego, czy jest to wizualizacja bez kodu. budowniczy lub API przeznaczone dla programistów.

- Obsługa złożonych witryn internetowych: Najlepsze narzędzia potrafią skanować dynamiczną zawartość, w tym strony z JavaScriptem, nieskończonym przewijaniem czy formularzami. Jest to kluczowe dla uzyskania wiarygodnych danych z nowoczesnych, złożonych witryn internetowych.

- Możliwości sztucznej inteligencji: Funkcje AI to prawdziwy przełom. Potrafią obsługiwać automatyczną ekstrakcję danych, automatycznie dostosowywać się do zmian na stronie, a nawet pomagać w scrapowaniu stron internetowych za pomocą prostych komunikatów.

- Skalowalność: Jeśli musisz przeprowadzić ekstrakcję danych na dużą skalę, wybierz narzędzie stworzone do obsługi dużych wolumenów danych bez blokowania się.

- Funkcje zapobiegające blokowaniu: Dobre narzędzie powinno mieć wbudowaną rotację adresów IP i inteligentne zarządzanie serwerami proxy, aby zapobiec zablokowaniu konta, zwłaszcza gdy trzeba wyodrębnić szczegóły dotyczące oferty pracy lub wyniki wyszukiwania Google.

- Opcje eksportu danych: Upewnij się, że narzędzie może eksportować zebrane dane do potrzebnych Ci formatów, takich jak CSV, JSON, lub bezpośrednio do bazy danych, a także może generować ustrukturyzowane dane.

- Chmura kontra lokalnie: Zastanów się, czy potrzebujesz platformy w chmurze do scrapowania stron internetowych, która będzie w stanie wykonywać zadania 24 godziny na dobę, 7 dni w tygodniu, czy też wystarczy Ci lokalna aplikacja komputerowa.

- Konkretne przypadki użycia: Niektóre narzędzia świetnie nadają się do ogólnego użytku, inne zaś specjalizują się w takich obszarach jak media społecznościowe lub danych z map Google, wybierz zatem te, które pasują do Twojego projektu.

Jakie korzyści mogą Ci przynieść najlepsze narzędzia do web scrapingu?

Narzędzia do scrapowania stron internetowych pozwalają zaoszczędzić mnóstwo czasu.

Możesz pominąć żmudną, ręczną pracę polegającą na kopiowaniu i wklejaniu danych z wielu stron.

Zamiast tego dobre rozwiązanie do scrapowania może zautomatyzować ten proces za Ciebie.

- Bezproblemowe zbieranie danych: Dzięki tym narzędziom można łatwo wyszukiwać na stronach internetowych takie informacje, jak ceny produktów czy dane z badań rynkowych.

- Zaawansowane funkcje: Dzięki zaawansowanym funkcjom narzędzia te mogą wykonywać nawet skomplikowane zadania, takie jak skanowanie wyników wyszukiwania Google lub pobieranie pełnego kodu źródłowego HTML.

- Dane gotowe do użycia: Oferują doskonałe opcje eksportu danych, zapewniając czyste i uporządkowane dane. Nie musisz samodzielnie oczyszczać informacji.

- Operacje oszczędzające czas: Tego typu operacje scrapowania pozwalają zaoszczędzić wiele godzin pracy, dzięki czemu możesz skupić się na analizowaniu danych, a nie na ich gromadzeniu.

- Niezawodny i szybki: Narzędzia te zostały stworzone z myślą o szybkości i niezawodności, dzięki czemu szybko uzyskasz potrzebne informacje.

Przewodnik kupującego

Wiemy, jak ważne jest znalezienie właściwego narzędzia odpowiadającego Twoim potrzebom.

Aby przedstawić Ci najlepsze rekomendacje, każdy produkt poddaliśmy badaniom i testom, stosując wielowarstwowe podejście.

Nasz proces koncentrował się na czynnikach, które mają największe znaczenie dla użytkowników – od początkujących po profesjonalistów.

Poniżej przedstawiamy krok po kroku, w jaki sposób dokonaliśmy wyboru najlepszych propozycji:

- Łatwość użytkowania: Sprawdziliśmy, czy rozwiązanie bez kodu jest możliwe, czy też konieczne jest kodowanie. Rozważyliśmy również, jak łatwo jest przekształcić surowe strony internetowe w użyteczne informacje, które można łatwo przeglądać w Arkuszach Google.

- Dokładność danych: Przeprowadziliśmy testy każdego narzędzia z wieloma warstwami danych. Sprawdziliśmy również możliwość wyodrębniania danych z różnych części strony, w tym meta tagów, aby zapewnić jakość informacji.

- Wycena: Rozważaliśmy różne strategie cenowe, od planu darmowego po usługi płatne. Braliśmy pod uwagę koszty początkowe, modele subskrypcji, proxy premium i wszelkie ukryte opłaty. Szukaliśmy również narzędzi oferujących rozwiązania dedykowane dla większych firm.

- Cechy: Przyjrzeliśmy się bliżej podstawowym funkcjom każdego narzędzia, skupiając się szczególnie na jego możliwościach obsługi złożonych witryn z nieskończonym przewijaniem. Sprawdziliśmy wbudowane zarządzanie proxy i rotację adresów IP oraz odnotowaliśmy wszelkie unikalne możliwości uczenia maszynowego lub sztucznej inteligencji. Szukaliśmy również łatwego wyjścia danych, takiego jak bezpośredni eksport do formatu csv.

- Negatywy: Żadne narzędzie nie jest idealne. Zidentyfikowaliśmy największe ograniczenia każdego produktu. Należały do nich: stroma krzywa uczenia się, konieczność posiadania zaawansowanych umiejętności technicznych czy brak funkcji do scrapowania na dużą skalę. Zwróciliśmy również uwagę na wszelkie braki, takie jak rozbudowana opcja usług zarządzanych.

- Wsparcie i społeczność: Przyjrzeliśmy się poziomowi oferowanej obsługi klienta. Czy oferowali czat na żywo, wsparcie e-mailowe, czy aktywną społeczność użytkowników? Przeanalizowaliśmy również ich politykę zwrotów, aby zapewnić Ci spokój ducha.

Naszym celem było dostarczenie cennych informacji na temat ogólnych wrażeń związanych z korzystaniem z każdego narzędzia, aby umożliwić Ci uzyskanie potrzebnych szczegółów dotyczących pracy.

Podsumowanie

Kluczem do sukcesu jest wybór odpowiedniego narzędzia AI do scrapowania stron internetowych.

Narzędzia te mogą poradzić sobie ze skomplikowanymi projektami i pomóc Ci wyodrębnić informacje z różnych stron internetowych bez konieczności długiego uczenia się.

Zapomnij o żmudnych ręcznych interwencjach i zablokowanych adresach IP; inteligentne funkcje, takie jak rotacyjne serwery proxy i uczenie maszynowe, są tutaj, aby Ci pomóc.

Narzędzia te umożliwiają uzyskanie wszelkich informacji, od danych o produktach po wyniki wyszukiwania i stanowiska pracy.

Nasze badania, oparte na wielowarstwowym podejściu, gwarantują, że otrzymasz wiarygodne rekomendacje.

Od przyjaznych dla użytkownika rozwiązań no-code po zaawansowane platformy dla deweloperów, które pokażą Ci jasną ścieżkę do sukcesu.

Często zadawane pytania

Czy narzędzia AI do scrapowania stron internetowych radzą sobie ze skomplikowanymi witrynami?

Tak, wykorzystują uczenie maszynowe, aby dostosowywać się do zmian w strukturze witryny, obsługiwać dynamiczną treść i środki anty-botowe, takie jak rozwiązywanie captcha.

Czy za pomocą tych narzędzi mogę pozyskiwać wyniki wyszukiwania?

Zdecydowanie. Wiele narzędzi ma funkcje przeznaczone do pozyskiwania wyników wyszukiwania z platform takich jak Google i innych wyszukiwarek.

Jakie są główne bariery techniczne utrudniające scrapowanie stron internetowych?

Największe bariery techniczne obejmują obsługę dynamicznej zawartości, zmiany układu witryny i zaawansowane systemy anty-botowe, takie jak blokady adresów IP i rotacyjne serwery proxy.

Jak mogę eksportować dane internetowe z tych narzędzi?

Większość narzędzi oferuje różne opcje eksportu danych, umożliwiając eksportowanie danych w formacie CSV, pliku JSON lub bezpośrednio do bazy danych, co ułatwia ich wykorzystanie.

Czym narzędzia AI różnią się od innych narzędzi?

W przeciwieństwie do innych narzędzi, scrapery oparte na sztucznej inteligencji wymagają mniejszej ingerencji użytkownika i mogą pozyskiwać bardziej szczegółowe informacje przy znacznie krótszej krzywej uczenia się.