Wybór właściwej sieci narzędzie do skrobania może być trudne.

Musisz zeskrobać dane z sieci i słyszałeś o tym Zyte.

To potężne narzędzie, ale nie jedyne.

Istnieje mnóstwo świetnych narzędzi zaprojektowanych specjalnie po to, aby rozwiązać te konkretne problemy.

W tym przewodniku przyjrzymy się najlepszym alternatywom dla Zyte dostępnym obecnie na rynku. Pokażemy Ci opcje, które są bardziej przystępne cenowo i oferują konkretne funkcje, których potrzebujesz.

Nasze najlepsze propozycje oferują świetne funkcje i lepsze ceny.

Jakie są najlepsze alternatywy dla Zyte?

Znalezienie odpowiedniego i idealnego narzędzia może robić decydująca różnica dla Twojego projektu web scrapingu.

Jeśli Zyte nie jest dla Ciebie idealnym rozwiązaniem, nie martw się.

Istnieje wiele innych potężnych platform.

Przeprowadziliśmy dla Ciebie badania i stworzyliśmy listę najlepszych alternatyw, które są obecnie dostępne.

Znajdźmy Twój nowy, najlepszy skrobak.

1. Oxylabs (⭐4,8)

Więc o co chodzi z Oxylabs? Pomyśl o nim jak o poważnym narzędziu do poważnego scrapowania.

Znana jest z ogromnej sieci serwerów proxy. Posiada miliony serwerów proxy w domach i centrach danych.

Dzięki temu jest to niezwykle niezawodne rozwiązanie, pozwalające na pobieranie danych bez blokowania.

To doskonały wybór nie bez powodu. Jego zaawansowane funkcje czynią go niezawodnym rozwiązaniem dla przedsiębiorstw.

Można na niego liczyć przy zbieraniu dużych ilości danych.

Nasze podejście

Odblokuj dane dzięki wiodącej usłudze proxy. Z ponad 175 milionami serwerów proxy domowych, 2 milionami dedykowanych serwerów proxy w centrach danych i 20 milionami serwerów proxy mobilnych, Oxylabs zapewnia adresy IP potrzebne do każdego projektu.

Kluczowe korzyści

- Asystent AI OxyCopilot: To narzędzie umożliwia generowanie żądań scrapowania przy użyciu prostego, naturalnego języka.

- Ogromna sieć proxy: Posiada jedną z największych pul serwerów proxy na świecie, obejmującą adresy IP ze 195 krajów.

- Gwarancja sukcesu: Oparte na sztucznej inteligencji odciski palców platformy i omijanie testu CAPTCHA gwarantują wysoki wskaźnik powodzenia nawet w przypadku najtrudniejszych witryn.

- Bezpieczeństwo klasy korporacyjnej: Platforma posiada certyfikat ISO/IEC 27001:2022, co gwarantuje wysoki poziom bezpieczeństwa i prywatności danych.

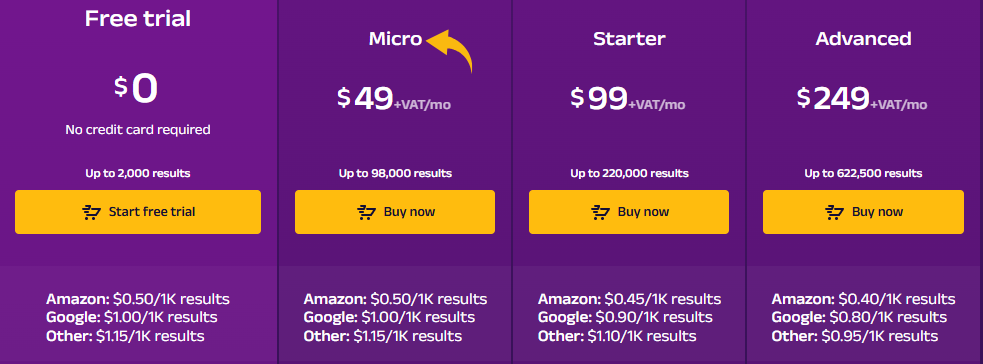

Wycena

- Bezpłatny okres próbny: $0.

- Mikro: 49 USD/miesiąc + VAT.

- Rozrusznik: 99 USD/miesiąc + VAT.

- Zaawansowany: 249 USD/miesiąc + VAT.

Zalety

Wady

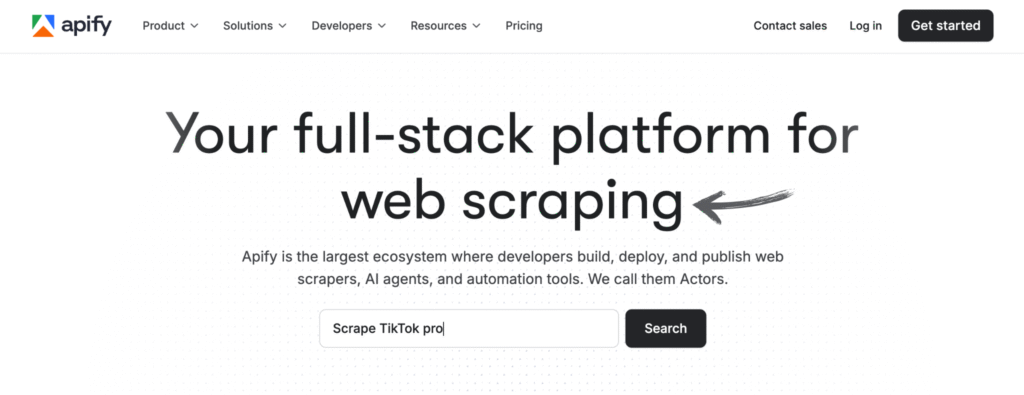

2. Apify (⭐4.5)

Apify is a tool for web scraping & automatyzacja.

Jest naprawdę elastyczny, niemal jak cały ekosystem. Możesz korzystać z gotowych aktorów z ich sklepu.

Alternatywnie, jeśli posiadasz niezbędne umiejętności kodowania, możesz stworzyć własne narzędzia.

Nie musisz martwić się o infrastrukturę.

Świetnie sprawdzi się zarówno początkującym, jak i ekspertom.

Nasze podejście

Chcesz przekonać się na własne oczy o możliwościach Apify? Nasza platforma została wykorzystana do zeskanowania ponad 2,5 miliona stron internetowych i przetworzenia ponad 500 TB danych w ciągu jednego miesiąca. Gotowy do działania?

Kluczowe korzyści

- Ogromny rynek: W sklepie Apify Store dostępnych jest ponad 5000 gotowych do użycia programów do scrapowania i automatyzacji, zwanych aktorami.

- Maksymalna skalowalność: Zaprojektowane do zadań na poziomie korporacyjnym, umożliwia przetwarzanie na dużą skalę milionów stron.

- Przyjazne dla programistów: Udostępnia pakiet SDK typu open source i obsługuje niestandardowy kod w językach Python i JavaScript.

- Zaawansowane planowanie: Zautomatyzuj zadania scrapowania, aby były wykonywane w określonych godzinach lub odstępach czasu, bez konieczności wykonywania czynności ręcznych.

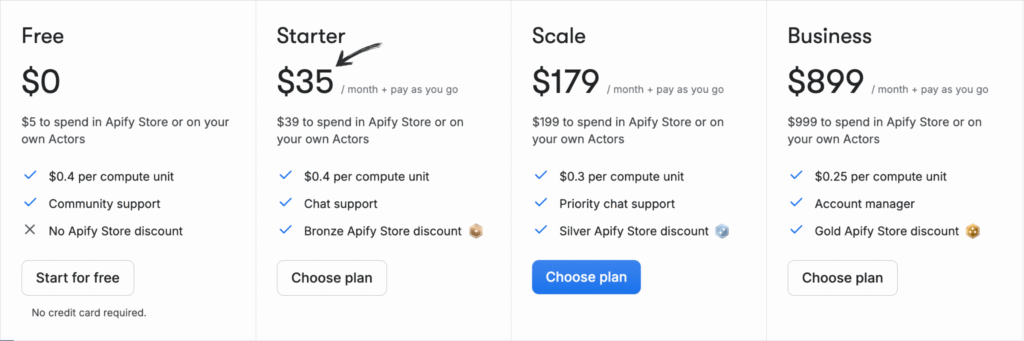

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: 0 zł/miesiąc + Płać zgodnie z zużyciem.

- Rozrusznik: 35 USD/miesiąc + płatność w miarę zużycia.

- Skala: 179 USD/miesiąc + Płać za zużycie.

- Biznes: 899 USD/miesiąc + płatność w miarę zużycia.

Zalety

Wady

3. ScrapingBee (⭐4.0)

ScrapingBee to dobry wybór, jeśli szukasz prostego API.

Jest stworzony do obsługi skomplikowanych witryn wykorzystujących dużo języka JavaScript.

Wysyłasz żądanie, a ono zajmuje się takimi zadaniami, jak rotacja serwerów proxy i obsługa przeglądarek.

Jest to idealne rozwiązanie dla programistów, którzy chcą skupić się na danych, a nie na naprawianiu scraperów.

To proste rozwiązanie dla wymagających zadań scrapowania. Otrzymujesz czysty kod HTML bez żadnych problemów.

Nasze podejście

Zdobądź dane Potrzebujesz ich z ponad 98% stron internetowych. Potężne API do scrapowania stron internetowych ScrapingBee oferuje renderowanie JavaScript, API wyszukiwarki Google oraz możliwość ekstrakcji danych strukturalnych z dokładnością do 99,5% na stronach dynamicznych.

Kluczowe korzyści

- Zajmie się wszystkim za Ciebie: Zarządza automatycznie rotacją serwerów proxy i renderowaniem JavaScript.

- Proste API: Za pomocą jednego, prostego wywołania API otrzymasz czyste dane.

- 99,9% czasu sprawności: Platforma charakteryzuje się wysoką niezawodnością i stabilną wydajnością.

- Obszerna dokumentacja: Zawiera przejrzystą i wyczerpującą dokumentację z przykładami kodu dla wielu języków, co ułatwia rozpoczęcie pracy.

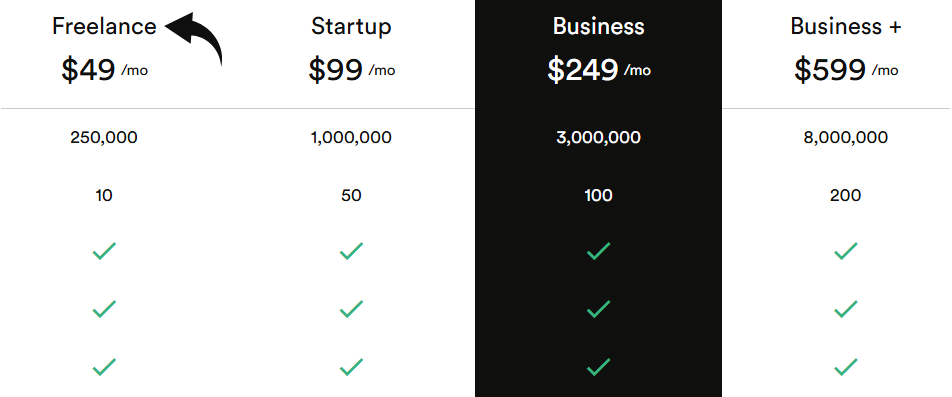

Wycena

Wszystkie plany będą rozliczane rocznie.

- Pracownik nieetatowy: 49 USD/miesiąc.

- Uruchomienie: 99 USD/miesiąc.

- Biznes: 249 USD/miesiąc.

- Biznes+: 599 USD/miesiąc.

Zalety

Wady

4. Przeglądaj AI (⭐3.8)

Szukasz rozwiązania bez kodu? Browse AI może być tym, czego potrzebujesz.

Umożliwia tworzenie robotów poprzez proste kliknięcie danych, które chcesz wyodrębnić ze strony internetowej.

Jest on niezwykle przyjazny dla użytkownika i idealny dla osób bez umiejętności technicznych.

Realizuje również takie zadania, jak logowanie się do witryn i włączanie nieskończonego przewijania.

Dzięki temu można szybko i łatwo rozpocząć pracę. Można skonfigurować monitorowanie witryny pod kątem zmian.

Odkryj jego potencjał dzięki naszemu Przeglądaj samouczek dotyczący sztucznej inteligencji.

Nasze podejście

Chcesz zaoszczędzić czas i uzyskać potrzebne dane? Browse AI poradzi sobie z milionami stron internetowych. Zobacz, jak łatwe może być scrapowanie stron internetowych.

Kluczowe korzyści

- Kod nie jest wymagany: Dzięki interfejsowi typu „wskaż i kliknij” każdy może w ciągu kilku minut stworzyć narzędzie do pozyskiwania danych.

- Adaptacja wspomagana przez sztuczną inteligencję: Narzędzie automatycznie dostosowuje się do zmian w układzie witryny, zapewniając zawsze spójność danych.

- Ponad 7000 integracji: Łatwo połącz zebrane dane z aplikacjami takimi jak Arkusze Google, Airtable i Zapier.

- Gotowe roboty: Uzyskaj dostęp do biblioteki gotowych robotów przeznaczonych do wykonywania typowych zadań na popularnych stronach internetowych, oszczędzając jeszcze więcej czasu.

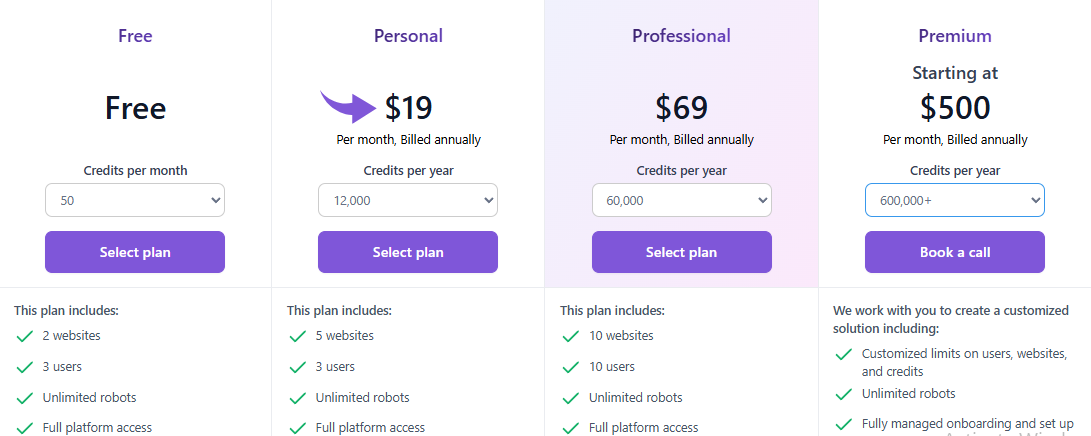

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: $0.

- Osobisty: 19 USD/miesiąc.

- Profesjonalny: 69 USD/miesiąc.

- Premia: Od 500 USD/miesiąc.

Zalety

Wady

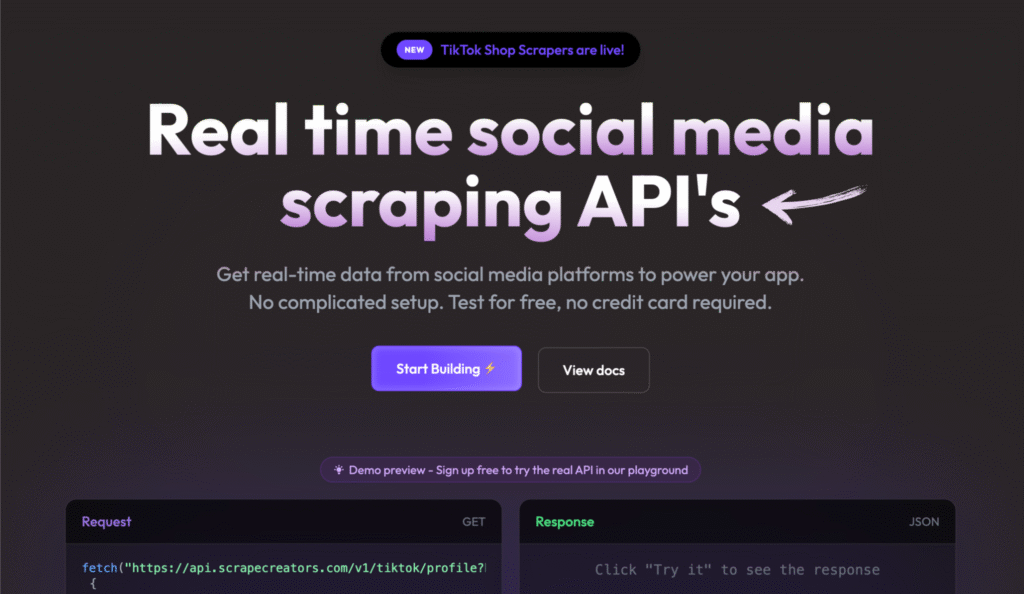

5. Twórcy scrapowania (⭐3.5)

Scrape Creators skupia się na jednej rzeczy: media społecznościowe danych. To usługa typu „płać za zużycie”.

Płacisz tylko za to, z czego korzystasz. Nie jest wymagana żadna miesięczna subskrypcja.

Został stworzony specjalnie do pobierania danych z platform takich jak TikTok, YouTubei Instagrama.

To doskonały wybór dla twórców i marketerów. Usługa jest szybka i niezawodna.

To świetny sposób na zdobycie potrzebnych danych społecznościowych.

Nasze podejście

Nie musisz już męczyć się ze zbieraniem danych z mediów społecznościowych. Dzięki Scrape Creators uzyskasz dane w czasie rzeczywistym z platform takich jak Twitch i Pinterest. Dołącz do setek użytkowników, którzy zebrali ponad 6 milionów zapytań i uzyskaj potrzebne Ci informacje.

Kluczowe korzyści

- Specjalistyczne interfejsy API: Oferuje gotowe rozwiązania przeznaczone specjalnie dla platform mediów społecznościowych.

- Nie potrzeba kluczy API: Możesz ominąć konieczność posiadania oficjalnych kluczy API w przypadku witryn takich jak Twitch.

- Płać za zużycie: Płacisz tylko za to, z czego korzystasz, a Twoje środki nigdy nie wygasają.

- Bogate dane JSON: Interfejsy API udostępniają czyste i ustrukturyzowane dane JSON, dzięki czemu nie musisz wykonywać dodatkowego przetwarzania.

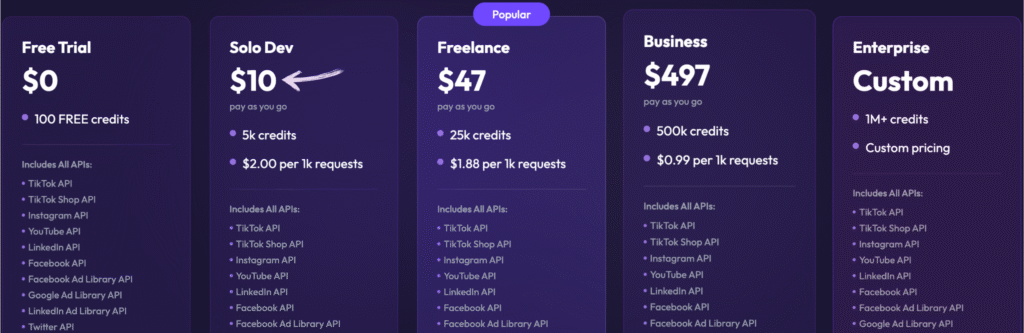

Wycena

- Bezpłatny okres próbny: 0, 100 darmowych kredytów.

- Solo Dev: 10 USD – Płać w miarę użytkowania, 5 tys. kredytów.

- Pracownik nieetatowy: 47 USD – Płać w miarę użytkowania, 25 tys. kredytów.

- Biznes: 497 USD – Płać w miarę użytkowania, 500 tys. kredytów.

- Przedsiębiorstwo: Cena niestandardowa, ponad 1 mln kredytów.

Zalety

Wady

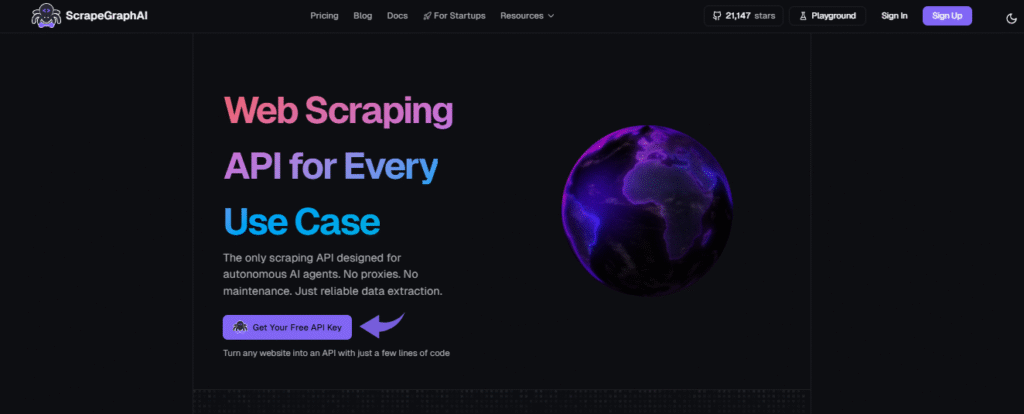

6. Sztuczna inteligencja ScrapeGraph (⭐3.2)

ScrapeGraph AI to nowe narzędzie wykorzystujące sztuczną inteligencję. Mówisz mu, jakich danych potrzebujesz, używając prostego języka.

Ciężką robotę, polegającą na ustaleniu sposobu jego zdobycia, wykonuje sztuczna inteligencja.

To biblioteka Pythona, która upraszcza złożone zadania scrapowania. Możesz stworzyć prototyp nowego scrapera w kilka minut.

Dzięki temu scrapowanie stron internetowych staje się bardziej dostępne dla szerszego grona odbiorców.

Możesz szybko przejść od pomysłu do działającego narzędzia do zbierania danych.

Nasze podejście

Wiodący specjaliści (ponad 350 osób) zaufali ScrapeGraphAI ze względu na jego solidne, oparte na sztucznej inteligencji możliwości scrapowania stron internetowych. Zapewnij sobie 20% wzrost wydajności na kolejne 48 godzin.

Kluczowe korzyści

- Scraping języka naturalnego: Możesz wskazać mu, co ma wyodrębnić, używając prostych, zrozumiałych dla człowieka monitów.

- Biblioteka Open Source: Deweloperzy mogą wykorzystać jego wszechstronną bibliotekę typu open-source, aby uzyskać maksymalną kontrolę.

- Funkcja Markdownify: Potrafi konwertować całe strony internetowe na przejrzyste, czytelne dokumenty Markdown.

- Agentic Scraper: Sztuczna inteligencja potrafi autonomicznie poruszać się po stronach internetowych i wchodzić z nimi w interakcje, wykonując złożone, wieloetapowe zadania.

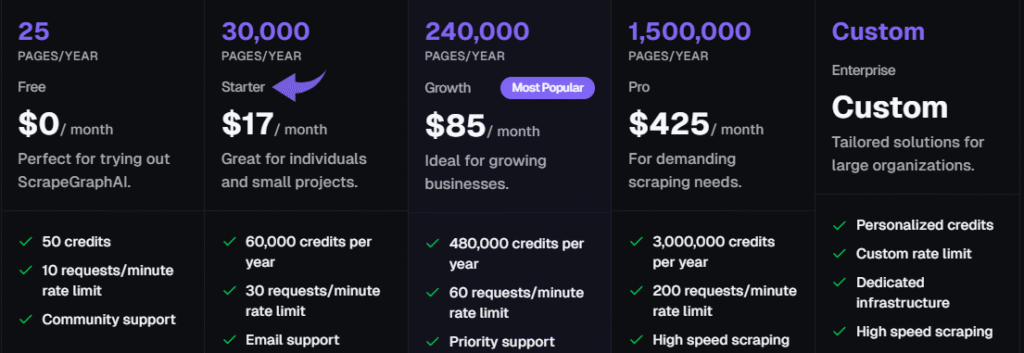

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: 0 zł/miesiąc.

- Rozrusznik: 17 USD/miesiąc.

- Wzrost: 85 USD/miesiąc.

- Zawodowiec: 425 USD/miesiąc.

- Przedsiębiorstwo: Indywidualne ceny.

Zalety

Wady

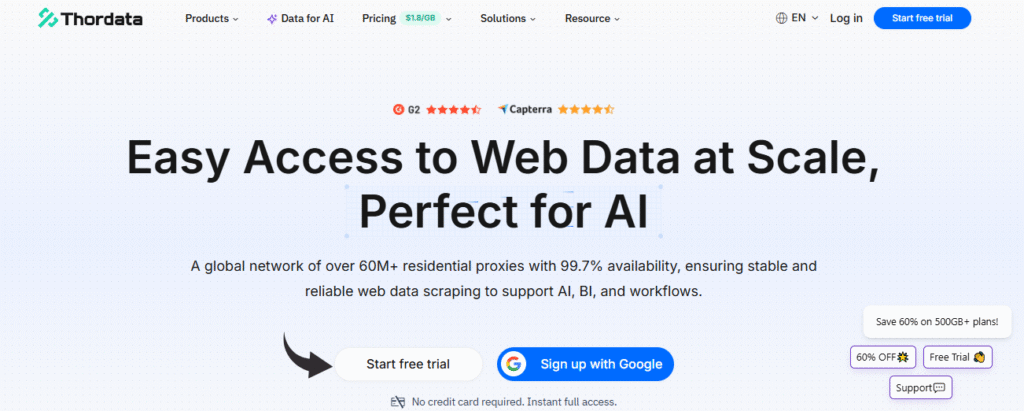

7. ThorData (⭐3.0)

ThorData to oparta na chmurze platforma służąca do zbierania dużych ilości danych.

Posiada ogromną sieć serwerów proxy domowych i mobilnych.

To doskonały wybór dla zespołów, które potrzebują dużych ilości danych. Usługa wykonuje znaczną część zadań technicznych w tle.

Zapewnia wysokiej jakości dane na dużą skalę.

Dzięki temu rozwiązanie to doskonale sprawdza się w przedsiębiorstwach, które potrzebują dużych zbiorów danych.

Nasze podejście

Ciesz się niezrównanym bezpieczeństwem dzięki ThorData. To dane Proces weryfikacji gwarantuje 99,7% skuteczności. Dzięki całodobowemu wsparciu na żywo i średniemu czasowi reakcji poniżej 3 minut możesz być pewien jakości połączenia. Uzyskaj ponad 60 milionów adresów IP i zabezpiecz swoje dane.

Kluczowe korzyści

- Ogromna pula adresów IP: Oferuje ponad 60 milionów etycznie pozyskanych adresów IP.

- Wysoka anonimowość: Zapewnia, że Twoja aktywność scrapowania pozostanie niewykryta dzięki wysokiej jakości serwerom proxy.

- Płać za zużycie: Rozliczenia są przejrzyste: płacisz tylko za wykorzystany ruch, a nie za nieudane żądania.

- Wbudowany skrobak: Zawiera narzędzie do scrapowania stron internetowych bez kodu i uniwersalny interfejs API, dzięki czemu nie potrzebujesz osobnego narzędzia do prostych projektów.

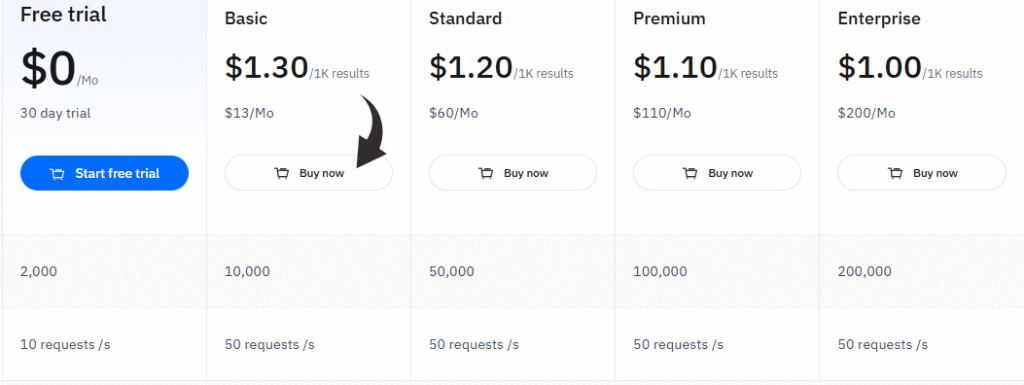

Wycena

- Bezpłatny okres próbny: 0 USD/miesiąc, 30-dniowy okres próbny.

- Podstawowy: 13 USD/miesiąc.

- Standard: 60 USD/miesiąc.

- Premia: 110 USD/miesiąc.

- Przedsiębiorstwo: 200 dolarów miesięcznie.

Zalety

Wady

Przewodnik kupującego

Ustaliliśmy najlepszą alternatywę dla Zyte, oceniając kilka kluczowych czynników.

Przeprowadziliśmy dogłębny proces badawczy, aby znaleźć narzędzia odpowiadające różnym potrzebom użytkowników.

We took these factors and applied them to tools designed for various tasks, from lead generation and price monitoring to market research and analiza konkurencji.

Chcieliśmy znaleźć najlepszą alternatywę dla różnych przypadków użycia.

Sprawdziliśmy także opinie użytkowników, aby zobaczyć, jak narzędzia sprawdzają się w rzeczywistych sytuacjach.

Porównaliśmy, w jaki sposób te narzędzia do scrapowania stron internetowych radzą sobie z pobieraniem ustrukturyzowanych danych i ich eksportowaniem, zapewniając możliwość wyodrębniania danych z różnych źródeł.

Nasz proces badawczy obejmował następujące kluczowe kroki:

- Wycena: Najpierw przyjrzeliśmy się strukturze cenowej każdego narzędzia, w tym wszelkim pakietom darmowym i systemom kredytowym. Zastanawialiśmy się również, czy ceny są przejrzyste, czy złożone, jak w przypadku cennika Zyte, co często może być decydującym czynnikiem dla użytkowników.

- Cechy: We dived deep into the key features of each platform. We specifically looked for automatic proxy rotation, JavaScript rendering, anti bot protection, and captcha solving. We also checked for capabilities like browser automatyzacja and handling dynamic content.

- Negatywy: Żadne narzędzie nie jest idealne, dlatego szukaliśmy wad. Braliśmy pod uwagę krzywą uczenia się, potencjalne blokady adresów IP oraz ograniczenia związane z konkretnymi typami witryn docelowych lub złożonymi witrynami. Zwróciliśmy również uwagę na wszelkie braki w zaawansowanych funkcjach, których użytkownik mógłby oczekiwać.

- Wsparcie i społeczność: Oceniliśmy poziom obsługi klienta i dostępność zespołu wsparcia. Szukaliśmy takich elementów, jak dedykowani opiekunowie klienta, kompleksowa dokumentacja oraz responsywna społeczność lub forum. Dobry zespół wsparcia jest kluczowy dla użytkowników borykających się z problemami.

Naszym celem było stworzenie kompleksowego przewodnika dla każdego, kto chce zbierać dane z sieci.

Przeanalizowaliśmy, jak każde narzędzie radzi sobie z działaniami zapobiegającymi scrapowaniu i projektami na dużą skalę, pomagając Ci znaleźć narzędzie do lepszego scrapowania.

Narzędzia te są przydatne przy pracach związanych ze skrobaniem, a także umożliwiają skrobanie chmur i pająków.

Rozważaliśmy zarówno opcje bezpłatne, jak i płatne, przyglądając się produktom, które są obecne w branży od ponad dekady, a także nowym graczom, którzy zmieniają zasady gry.

Podsumowanie

Znalezienie właściwego narzędzia jest najważniejszym krokiem w każdym projekcie pozyskiwania danych.

Przyjrzeliśmy się najlepszym alternatywom dla API Zyte.

Każdy z nich oferuje coś trochę innego.

Niezależnie od tego, czy potrzebujesz prostego sposobu na pozyskiwanie surowego kodu HTML ze stron internetowych, czy narzędzia do scrapowania danych na dużą skalę, na pewno znajdziesz rozwiązanie dla siebie.

Niektóre świetnie nadają się do tworzenia przepływów danych dla zespołów sprzedaży, inne zaś świetnie sprawdzają się w przypadku złożonych projektów.

Omówiliśmy narzędzia z wydajnymi serwerami proxy, jak i te, które są prostsze w obsłudze.

Przyjrzyj się więc bliżej i wybierz opcję, która najlepiej odpowiada Twoim potrzebom.

Teraz możesz wyszukać i znaleźć idealne narzędzie, dzięki któremu rozpoczniesz eksportowanie danych i wykonywanie swojej pracy.

Często zadawane pytania

Dlaczego potrzebuję alternatywy dla Zyte do web scrapingu?

Możesz potrzebować więcej opcji personalizacji lub innego modelu cenowego. Niektóre alternatywy oferują również lepszą obsługę blokad i mniej blokad adresów IP na trudnych stronach.

Czy te alternatywy działają na wszystkich popularnych stronach internetowych?

Wiele z tych narzędzi zostało zaprojektowanych do działania na wszystkich platformach e-commerce i innych popularnych stronach internetowych. Często wykorzystują przeglądarki bezgłowe i zaawansowane techniki, aby zapewnić wysoką skuteczność.

W jaki sposób te narzędzia zapewniają ochronę anty-botową?

Wykorzystują zaawansowane metody, takie jak rotacja serwerów proxy i obsługa banów. To klucz do uzyskania wiarygodnych danych internetowych ze strony docelowej bez ryzyka zablokowania.

Czy mogę korzystać z tych usług w celu ekstrakcji danych na dużą skalę?

Tak. Usługi takie jak Jasne dane są budowane z myślą o skalowalności, oferując ogromne zbiory danych i infrastrukturę potrzebną do bezproblemowego wydobywania danych na dużą skalę.

Czy łatwo jest uzyskać dostęp do tych usług?

Większość z tych narzędzi oferuje proste interfejsy API i przejrzystą dokumentację. Można uzyskać do nich dostęp i szybko rozpocząć projekt. Jeden z recenzentów zauważył, że konfiguracja była łatwa.

More Facts about Zyte Alternatives

- Zyte’s Main Job: Zyte is a tool that turns websites into useful lists of information. It uses smart tech to automatically copy data, so people don’t have to do it by hand.

- Scale and Speed: It can visit millions of pages at once without getting tired. This helps big businesses collect huge amounts of info very quickly.

- Smart Systems: Zyte uses Artificial Intelligence (AI) to read web pages, such as shopping sites or news sites, and organize the details into neat categories.

- Avoiding Blocks: Many websites try to stop bots from visiting. Zyte has a “Smart Proxy Manager” that acts like a disguise, helping the tool stay hidden so it doesn’t get banned.

- Success Rates: In 2026, Zyte remains very reliable, usually succeeding more than 95% of the time, even on websites with strong bezpieczeństwo.

- For Experts Only: Zyte is made for people who know a lot about computers. It can be hard for beginners to use because it has many complex settings.

- The Cost of Power: Zyte’s prices can rise quickly. It charges based on how much “brain power” it uses. Hard-to-read websites cost more than simple ones.

- Cloud Power: You don’t need your own powerful computer to use it. Zyte lets you run your scraping programs on their internet servers instead.

- Legal and Safe: Zyte follows major privacy laws like GDPR and CCPA to ensure the data it collects is handled appropriately.

- Old Name: Before 2021, the company was known as Scrapinghub.

- The Competition in 2026:

- Jasne dane: This tool is a leader right now, with a massive network of 150 million “disguises” (IPs) and a 98.44% success rate.

- Scrape do: This is currently the speed king, taking only about 4.7 seconds to finish a task.

- Ośmiornica: Perfect for people who don’t want to write code. You just point and click at what you want to copy.

- ScrapingBee & ScraperAPI: These are “plug-and-play” tools that prioritize simplicity and ease of use for developers to start right away.

- Apify: Think of this like an app store for web scraping. It has over 1,500 pre-made tools for popular websites.

- Firecrawl: This is a special tool made just for AI. It turns websites into text that “computer brains” (like ChatGPT) can understand easily.