هل سئمت من أدوات استخراج البيانات المعقدة من مواقع الويب التي تبدو وكأنها وظيفة بدوام كامل؟

نحن نتفهم ذلك، قد يكون استخدامها معقداً.

قد يكون استخراج البيانات من المواقع الإلكترونية أمراً صعباً، خاصة عندما تواجه عقبة ما.

أنت تضيع وقتاً ثميناً ولا تصل إلى أي مكان بسرعة.

لهذا السبب قمنا بتجميع قائمة بأفضل منشئو الكشط البدائل. سيساعدك هذا الدليل في العثور على أداة قوية وبسيطة للحصول على البيانات التي تحتاجها.

هيا بنا نبدأ بالكشط!

ما هي أفضل بدائل لبرامج إنشاء الكشط؟

إذا كنت تبحث عن طريقة أفضل لجمع البيانات، فقد وصلت إلى المكان الصحيح.

لقد بذلنا جهدًا كبيرًا للعثور على أفضل الأدوات التي تتميز بسهولة الاستخدام وقوة الأداء. تتضمن قائمتنا خيارات بسيطة لا تتطلب كتابة أكواد، بالإضافة إلى أدوات فعّالة للمطورين.

ستجد الأداة المثالية التي تلبي احتياجاتك.

1. ScrapingBee (⭐4.8)

ScrapingBee عبارة عن واجهة برمجة تطبيقات (API) لاستخراج البيانات من مواقع الويب، مصممة للمطورين.

يتولى البرنامج الأجزاء الصعبة نيابةً عنك، مثل إدارة المتصفحات بدون واجهة رسومية وتدوير الخوادم الوكيلة.

تُعد واجهة برمجة التطبيقات هذه مثالية للمطورين الذين يرغبون في تجنب المشاكل التقنية المتعلقة باستخراج البيانات من مواقع الويب.

إنه مفيد بشكل خاص للتجمع وسائل التواصل الاجتماعي بيانات لأبحاث السوق.

رأينا

احصل على بيانات تحتاج إلى استخراج البيانات من أكثر من 98% من صفحات الويب. توفر واجهة برمجة تطبيقات ScrapingBee القوية لاستخراج البيانات من الويب إمكانية عرض البيانات باستخدام JavaScript، وواجهة برمجة تطبيقات بحث جوجل، والقدرة على استخراج البيانات المنظمة بدقة تصل إلى 99.5% على المواقع الديناميكية.

الفوائد الرئيسية

- يتولى كل شيء نيابةً عنك: يدير البرنامج تدوير البروكسي وعرض جافا سكريبت تلقائيًا.

- واجهة برمجة تطبيقات بسيطة: ستحصل على بيانات نظيفة من خلال استدعاء واجهة برمجة التطبيقات (API) واحد ومباشر.

- نسبة التشغيل 99.9%: تشتهر المنصة بموثوقيتها العالية وأدائها المتسق.

- وثائق شاملة: يوفر وثائق واضحة وشاملة مع أمثلة برمجية للغات متعددة، مما يسهل البدء.

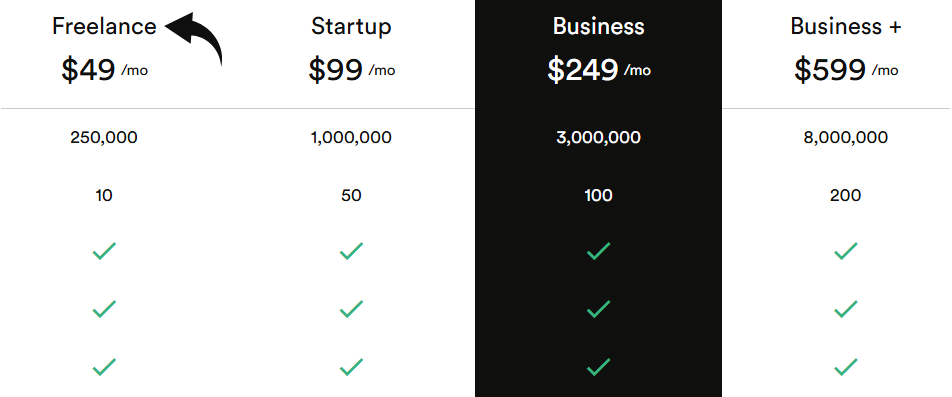

التسعير

ستكون جميع الخطط يتم إصدار الفاتورة سنوياً.

- العمل الحر: 49 دولارًا شهريًا.

- بدء: 99 دولارًا شهريًا.

- عمل: 249 دولارًا شهريًا.

- بزنس بلس: 599 دولارًا شهريًا.

الإيجابيات

السلبيات

2. Apify (⭐4.5)

Apify هي منصة سحابية لاستخراج البيانات من مواقع الويب و الأتمتة.

تم تصميمه لكل من المبرمجين وغير المبرمجين.

يمكنك استخدام مكتبتها الضخمة من الممثلين الجاهزين مسبقًا لاستخراج البيانات من مواقع الويب دون كتابة أي كود.

This tool offers solutions for وسائل التواصل الاجتماعي استخراج البيانات.

منصتها المرنة ومجموعة أدواتها الكبيرة يصنع من السهل البدء في عملية الكشط.

رأينا

هل ترغب في تجربة قوة Apify بنفسك؟ لقد استُخدمت منصتنا لاستخراج بيانات أكثر من 2.5 مليون صفحة ويب ومعالجة أكثر من 500 تيرابايت من البيانات في شهر واحد فقط. هل أنت مستعد للبدء؟

الفوائد الرئيسية

- سوق ضخم: يحتوي متجر Apify على أكثر من 5000 أداة جاهزة للاستخدام لاستخراج البيانات وأدوات التشغيل الآلي تسمى Actors.

- قابلية التوسع القصوى: تم تصميمه لمهام على مستوى المؤسسات، ويمكنه التعامل مع عمليات زحف واسعة النطاق لملايين الصفحات.

- مناسب للمطورين: يوفر حزمة تطوير برمجية مفتوحة المصدر ويدعم التعليمات البرمجية المخصصة بلغة بايثون وجافا سكريبت.

- الجدولة المتقدمة: قم بأتمتة مهام استخراج البيانات لتشغيلها في أوقات أو فترات زمنية محددة دون أي عمل يدوي.

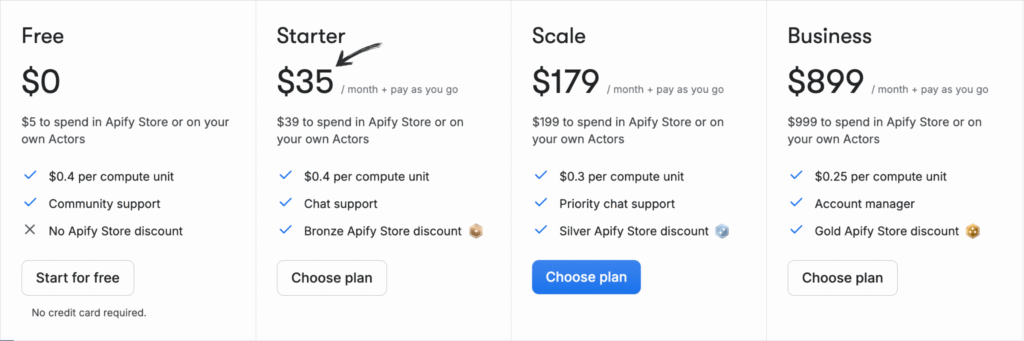

التسعير

ستكون جميع الخطط يتم إصدار الفاتورة سنوياً.

- حر: 0 دولار شهرياً + الدفع حسب الاستخدام.

- بداية: 35 دولارًا شهريًا + الدفع حسب الاستخدام.

- حجم: 179 دولارًا شهريًا + الدفع حسب الاستخدام.

- عمل: 899 دولارًا شهريًا + الدفع حسب الاستخدام.

الإيجابيات

السلبيات

3. أوكسي لابس (⭐4.0)

أوكسي لابس هي شركة موثوقة في مجال ذكاء الويب تقدم خدمات بروكسي قوية وأدوات استخراج البيانات من مواقع الويب.

تشتهر بشبكتها الواسعة من عناوين IP وميزاتها المتقدمة.

يمكنه جمع البيانات في الوقت الفعلي من وسائل التواصل الاجتماعي ومصادر أخرى.

تم تصميم برنامج استخراج البيانات القوي الخاص بهم للتعامل مع استخراج البيانات المعقدة واسعة النطاق.

رأينا

استغل بياناتك مع خدمة بروكسي رائدة. مع أكثر من 175 مليون بروكسي سكني، ومليوني بروكسي مخصص لمراكز البيانات، و20 مليون بروكسي للهواتف المحمولة، توفر لك أوكسي لابس عناوين IP التي تحتاجها لأي مشروع.

الفوائد الرئيسية

- مساعد أوكسيكوبايلوت الذكي: تتيح لك هذه الأداة إنشاء طلبات استخراج البيانات باستخدام لغة بسيطة وطبيعية.

- شبكة بروكسي ضخمة: تمتلك واحدة من أكبر مجموعات البروكسي في العالم مع عناوين IP من 195 دولة.

- النجاح مضمون: تضمن تقنية بصمة الإصبع المدعومة بالذكاء الاصطناعي وتجاوز اختبار CAPTCHA في المنصة معدل نجاح عالٍ حتى في أصعب المواقع.

- أمان على مستوى المؤسسات: المنصة حاصلة على شهادة ISO/IEC 27001:2022، مما يضمن مستوى عالٍ من أمن البيانات والخصوصية.

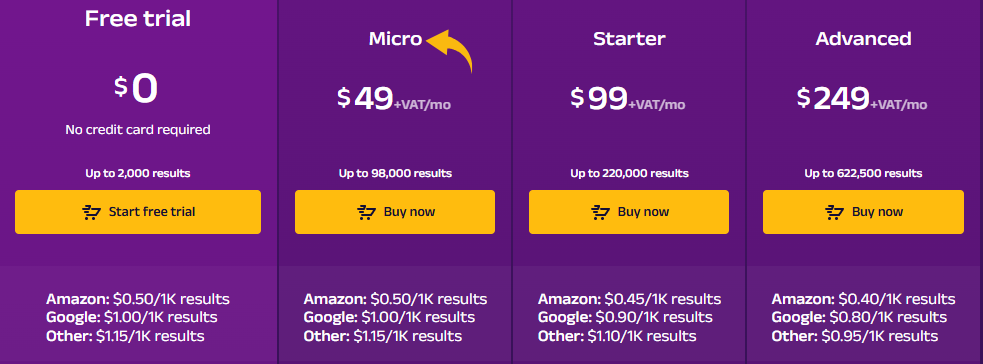

التسعير

- تجربة مجانية: $0.

- مايكرو: 49 دولارًا شهريًا + ضريبة القيمة المضافة.

- بداية: 99 دولارًا شهريًا + ضريبة القيمة المضافة.

- متقدم: 249 دولارًا شهريًا + ضريبة القيمة المضافة.

الإيجابيات

السلبيات

4. تصفح الذكاء الاصطناعي (⭐3.8)

Browse AI هو موقع ويب بدون كتابة أكواد أداة الكشط.

يتيح لك هذا البرنامج تدريب روبوت على استخراج البيانات من أي موقع ويب. كما أن واجهة النقر والتحديد تجعل عملية استخراج البيانات بسيطة.

كما يتضمن روبوتات جاهزة لبيانات وسائل التواصل الاجتماعي، مما يجعله أداة رائعة لاستخراج البيانات من مواقع الويب للمسوقين.

أطلق العنان لإمكانياته مع برنامجنا تصفح دروس الذكاء الاصطناعي.

رأينا

هل أنت مستعد لتوفير الوقت والحصول على البيانات التي تحتاجها؟ بإمكان Browse AI التعامل مع ملايين المواقع الإلكترونية. اكتشف مدى سهولة استخراج البيانات من المواقع.

الفوائد الرئيسية

- لا حاجة لكتابة أي كود: تتيح واجهته سهلة الاستخدام، والتي تعتمد على النقر والتحديد، لأي شخص إنشاء برنامج استخراج بيانات في دقائق.

- القدرة على التكيف المدعومة بالذكاء الاصطناعي: تتكيف الأداة تلقائيًا مع التغييرات في تصميم موقع الويب، مما يضمن اتساق بياناتك دائمًا.

- أكثر من 7000 عملية تكامل: يمكنك بسهولة ربط البيانات التي تم جمعها بتطبيقات مثل جداول بيانات جوجل، وAirtable، وZapier.

- روبوتات جاهزة الصنع: يمكنك الوصول إلى مكتبة من الروبوتات الجاهزة للمهام الشائعة على مواقع الويب الشهيرة، مما يوفر لك المزيد من الوقت.

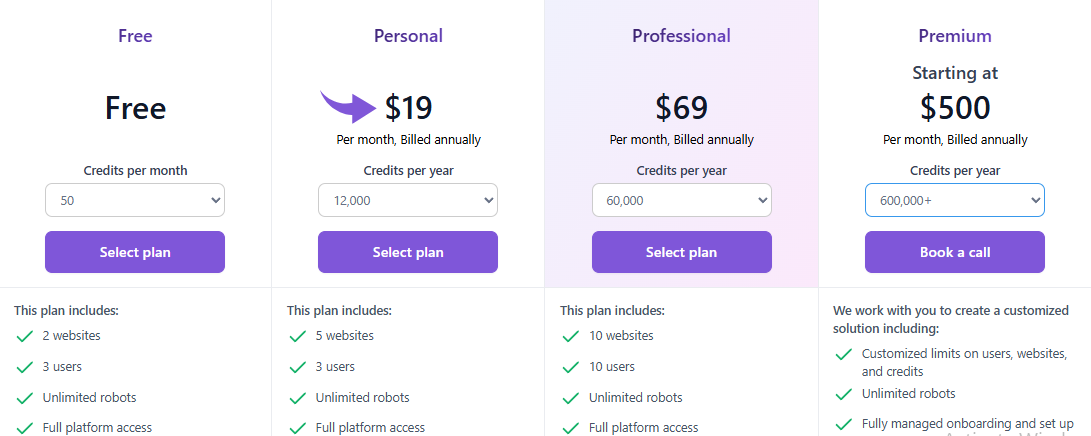

التسعير

ستكون جميع الخطط يتم إصدار الفاتورة سنوياً.

- حر: $0.

- شخصي: 19 دولارًا شهريًا.

- احترافي: 69 دولارًا شهريًا.

- غالي: ابتداءً من 500 دولار شهرياً.

الإيجابيات

السلبيات

5. زيت (⭐3.5)

Zyte عبارة عن منصة متكاملة لاستخراج البيانات من مواقع الويب.

لقد كان موجوداً منذ فترة طويلة ويحظى بثقة الكثيرين.

تساعد هذه الخدمة المطورين على استضافة وإدارة برامج زحف الويب الخاصة بهم في السحابة. كما توفر واجهة برمجة تطبيقات قوية تتولى حماية برامج الروبوت نيابةً عنك.

تم تصميم منصة Zyte لاستخراج بيانات وسائل التواصل الاجتماعي على نطاق واسع.

رأينا

احصل على أكثر المواقع الإلكترونية موثوقية بيانات مع واجهة برمجة تطبيقات Zyte. حقق دقة بيانات بنسبة 99.99% لمشاريعك باستخدام واجهة برمجة تطبيقات استخراج البيانات عالية الجودة هذه، وقم بتبسيط عملية استخراج البيانات اليوم.

الفوائد الرئيسية

- إلغاء الحظر التلقائي: توقف عن استخدام الخوادم الوكيلة؛ Zyte API هي أداة آلية قوية للتعامل مع عمليات الحظر.

- تكامل سلس مع سكرايبي: إذا كنت مطورًا تستخدم إطار عمل Scrapy، فإن Zyte يناسبك تمامًا.

- استخراج البيانات المدعوم بالذكاء الاصطناعي: يمكن للأداة تحديد البيانات وتحليلها تلقائيًا، مما يقلل الحاجة إلى قواعد التحليل اليدوية.

- متصفح مدمج بدون واجهة رسومية: لا حاجة لمتصفحات الطرف الثالث التي تعمل بدون واجهة رسومية، حيث يوفر Zyte متصفحًا مُحسَّنًا لاستخراج البيانات من الويب على نطاق واسع.

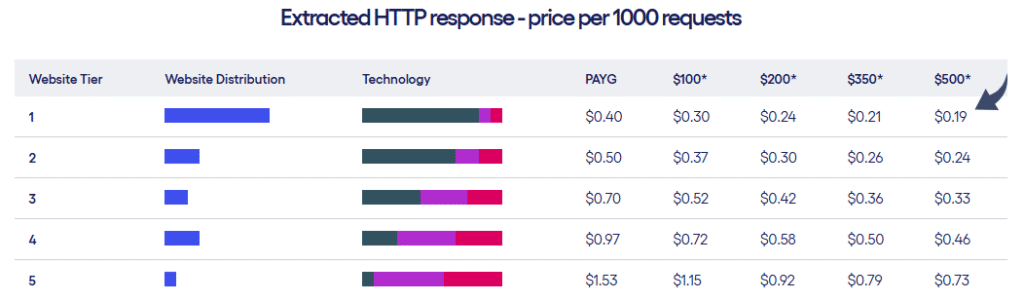

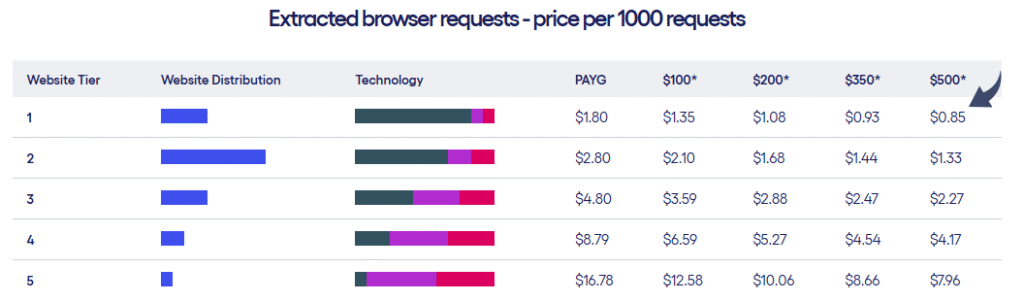

التسعير

- تقدم شركة Zyte نوعين من خطط التسعير بناءً على مستوى مواقع الويب وعدد الطلبات التي تقوم بها.

الإيجابيات

السلبيات

6. برنامج ScrapeGraph AI (⭐3.2)

ScrapeGraph AI هي مكتبة بايثون فريدة من نوعها تستخدم الذكاء الاصطناعي لاستخراج البيانات من مواقع الويب.

ما عليك سوى إخباره بالمعلومات التي تريدها بلغة إنجليزية بسيطة.

ثم يستخدم أسلوبًا قائمًا على الرسوم البيانية لاستخراج البيانات نيابةً عنك.

إنها طريقة جديدة للتعامل مع استخراج البيانات من مواقع الويب. تعمل هذه الأداة المدعومة بالذكاء الاصطناعي على تبسيط استخراج البيانات المعقدة.

رأينا

يثق أكثر من 350 خبيرًا رائدًا في مجال استخراج البيانات من مواقع الويب باستخدام ScrapeGraphAI لما تتمتع به من قدرات قوية مدعومة بالذكاء الاصطناعي. احصل على ترقية بنسبة 20% في الكفاءة خلال الـ 48 ساعة القادمة.

الفوائد الرئيسية

- استخراج البيانات من اللغة الطبيعية: يمكنك إخباره بما يجب استخراجه باستخدام مطالبات بسيطة تشبه مطالبات البشر.

- مكتبة مفتوحة المصدر: يمكن للمطورين استخدام مكتبتها القوية مفتوحة المصدر لتحقيق أقصى قدر من التحكم.

- ميزة Markdownify: بإمكانه تحويل صفحات الويب بأكملها إلى مستندات Markdown نظيفة وقابلة للقراءة.

- أداة الكشط الآلية: يمكن للذكاء الاصطناعي التنقل والتفاعل مع مواقع الويب بشكل مستقل لإكمال مهام معقدة ومتعددة الخطوات.

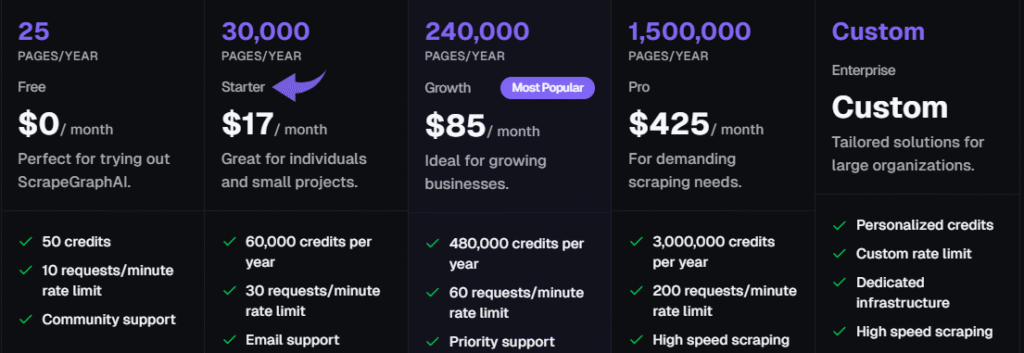

التسعير

ستكون جميع الخطط يتم إصدار الفاتورة سنوياً.

- حر: 0 دولار شهرياً.

- بداية: 17 دولارًا شهريًا.

- نمو: 85 دولارًا شهريًا.

- إيجابي: 425 دولارًا شهريًا.

- مَشرُوع: تسعير مخصص.

الإيجابيات

السلبيات

7. ثور داتا (⭐3.0)

ThorData هي منصة توفر كلاً من البنية التحتية للوكيل وأدوات استخراج البيانات من الويب.

تم تصميم واجهة برمجة التطبيقات الخاصة بها للمسح الشامل لمحاكاة السلوك البشري الحقيقي لمهام المسح المتقدمة.

يوفر هذا البرنامج لاستخراج البيانات من مواقع الويب خيارًا بدون كتابة أكواد وواجهة برمجة تطبيقات قوية للمطورين.

يمكنه جمع البيانات في الوقت الفعلي من منصات التواصل الاجتماعي.

رأينا

استمتع بأمان لا مثيل له مع ثور داتا. بيانات تضمن عملية التحقق نسبة نجاح تصل إلى 99.7%. مع دعم مباشر على مدار الساعة وطوال أيام الأسبوع، ومتوسط وقت استجابة أقل من 3 دقائق، يمكنك الوثوق بجودة الاتصال. احصل على أكثر من 60 مليون عنوان IP وقم بتأمين بياناتك.

الفوائد الرئيسية

- مجموعة عناوين IP ضخمة: يوفر أكثر من 60 مليون عنوان IP سكني من مصادر أخلاقية.

- مستوى عالٍ من إخفاء الهوية: يضمن لك هذا النظام عدم اكتشاف نشاطك في استخراج البيانات بفضل خوادمه الوكيلة عالية الجودة.

- الدفع حسب الاستخدام: نظام الفوترة شفاف؛ فأنت تدفع فقط مقابل حركة البيانات التي تستخدمها، وليس مقابل الطلبات الفاشلة.

- مكشطة مدمجة: يتضمن أداة استخراج بيانات الويب بدون كتابة أكواد وواجهة برمجة تطبيقات عالمية، لذلك لن تحتاج إلى أداة منفصلة للمشاريع البسيطة.

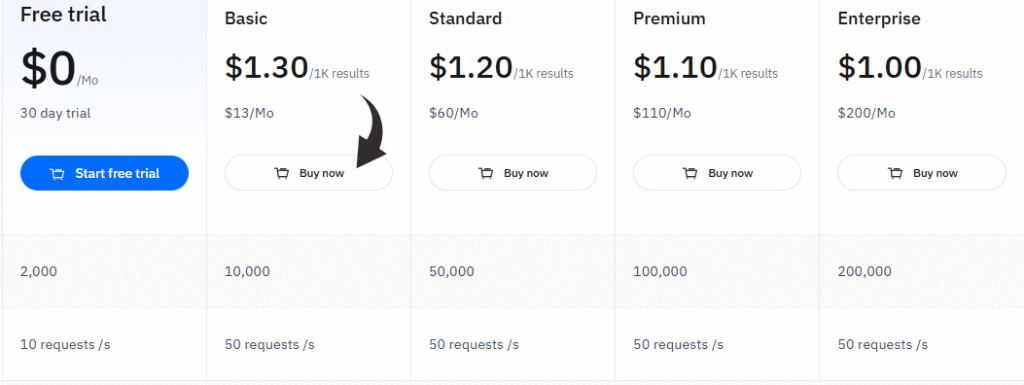

التسعير

- تجربة مجانية: 0 دولار شهرياً، تجربة لمدة 30 يوماً.

- أساسي: 13 دولارًا شهريًا.

- معيار: 60 دولارًا شهريًا.

- غالي: 110 دولارًا شهريًا.

- مَشرُوع: 200 دولار شهرياً.

الإيجابيات

السلبيات

دليل المشتري

لقد قمنا بتقييم كل منتج بناءً على عدة عوامل رئيسية للتأكد من أن توصياتنا هي الأفضل.

لقد بحثنا في ما يميز كل برنامج من برامج استخراج البيانات من مواقع الويب وما قد يكون مفقودًا.

كانت عملية البحث لدينا بسيطة وتركز على تزويدك بالمعلومات التي تحتاجها لاتخاذ خيار جيد.

إليكم كيف فعلنا ذلك:

- الأسعار: تحققنا من أسعار كل أداة، بما في ذلك ما إذا كانت توفر فترة تجريبية مجانية أو خطة مجانية لمساعدتك على البدء. وقد اطلعنا على نماذج تسعير متنوعة لإيجاد خيارات تناسب مختلف الميزانيات.

- سمات: تعمّقنا في خصائص كل أداة. بحثنا عن ميزات مثل واجهة سهلة الاستخدام تعتمد على النقر والتحديد، والقدرة على معالجة البيانات في الوقت الفعلي، وما إذا كانت توفر واجهة برمجة تطبيقات قوية. كما تحققنا من وجود تكامل مع جداول بيانات جوجل لتسهيل جمع البيانات.

- السلبيات: بحثنا عن أي عيوب محتملة. هل كان تعلم استخدام الأداة صعبًا؟ هل واجهت الأداة صعوبة في التعامل مع أنظمة الحماية من الاختراق؟ هل كان هناك شيء مفقود يجعلها أقل فائدة لمهام مثل تيك توك أو منصات محددة أخرى مثل وسائل التواصل الاجتماعي؟

- الدعم والمجتمع: بحثنا في نوع الدعم الذي تقدمه كل خدمة. تحققنا مما إذا كان لديهم منتدى مجتمعي، أو دروس تعليمية مفيدة، أو دعم عملاء مباشر. كما نظرنا في سياسات الاسترداد الخاصة بهم.

- أداء: قمنا بتقييم مدى كفاءة كل أداة في استخراج البيانات وإعادتها كبيانات نظيفة ومنظمة. كما نظرنا في مدى قدرة أدوات استخراج البيانات على التعامل مع التحديات الشائعة دون أن تتعطل.

- دمج الذكاء الاصطناعي: لقد بحثنا عن أدوات تستخدم وكلاء الذكاء الاصطناعي أو ميزات الذكاء الاصطناعي الأخرى لجعل عملية استخراج البيانات أكثر ذكاءً وكفاءة.

يختتم

قد يكون العثور على الأداة المناسبة والأفضل لاحتياجاتك أمراً صعباً.

لقد بحثنا في العديد من الخيارات المختلفة لمساعدتك في العثور على أفضل برنامج لاستخراج بيانات الويب.

لقد أخذنا في الاعتبار الميزات الرئيسية والتسعير ومدى سهولة استخدامها من قبل المستخدمين.

يمكنك الآن اختيار الأداة المناسبة لك.

سواء كنت بحاجة إلى واجهة بسيطة تعتمد على النقر أو واجهة برمجة تطبيقات قوية تتعامل مع الطلبات المعقدة.

باختيار الأداة المناسبة، يمكنك استخراج البيانات من مجموعة متنوعة من المنصات والمواقع الإلكترونية لمساعدتك في بناء ما تحتاجه للتوسع.

الأسئلة الشائعة

Is web scraping illegal?

Generally, no. It’s legal for public data. Courts, like in the hiQ vs. لينكد إن case, have protected the scraping of publicly available information. However, bypassing paywalls or harvesting personal data is a legal “no-go.” Always respect a site’s robots.txt file.

Is it possible to scrape data from a website?

Absolutely. Almost any public site can be scraped. While some sites use advanced anti-bot shields, modern tools like ScraperAPI are designed to bypass these blocks effortlessly. If the data is visible to a standard browser, a scraper can likely extract it.

Which is best for web scraping?

It depends on your skill. Developers typically swear by Scrapy or BeautifulSoup for total customization. If you prefer a visual approach, Octoparse is the winner. For massive enterprise projects requiring heavy anti-bot protection, بيانات برايت is the undisputed industry leader.

What is the best tool for web scraping?

Bright Data is widely considered the best for power and reliability. It handles proxy rotation and CAPTCHAs without breaking a sweat. For those on a budget, ParseHub or Octoparse offer excellent free tiers that work perfectly for smaller, straightforward projects.

Which scraping tool is best for beginners?

Octoparse is the gold standard for non-coders. It features a point-and-click interface, allowing you to select data directly on the screen. No coding required. ParseHub is another fantastic visual alternative that makes complex data extraction feel like a simple walkthrough.

Can ChatGPT create a web scraper?

Yes, and it’s fast. ChatGPT can generate Python scripts using BeautifulSoup or Selenium in seconds. While it provides the logic, you still need to execute the code yourself. It’s perfect for simple tasks, though complex sites might require some manual fine-tuning.

What is an example of web scraping?

Price monitoring is the classic use case. Retailers scrape sites like Amazon to adjust their own prices dynamically. Other examples include pulling العقارات listings, gathering sports stats for analysis, or aggregating news for AI training. It turns the web into a structured database.

More Facts about Scrape creators Alternatives

- ScrapingBee, Apify, and Octoparse are great choices if you don’t want to use Scrape Creators. They work well for social media and online shops.

- In 2026, the best tools for getting data from websites are Bright Data, ScrapingBee, Apify, and Octoparse.

- ScrapingBee is a helpful tool that handles tricky website code and hides your identity while you work.

- ScrapingFish is built to be very fast and doesn’t waste any time.

- ScrapingAnt is an easy-to-use tool that gets the job done without any extra fuss.

- Scrapfly is a simple tool that can grow as your project gets bigger.

- ZenRows is great at getting past “robot blockers” on modern websites to get the info you need.

- Oxylabs has a special tool that helps it get into “stubborn” websites that try to block users.

- A web scraper is good for projects that need to pull large amounts of data regularly. It can even read websites that change or update while you are looking at them.

- Scraper API lets you take data from any public site without worrying about technical blocks like “I am not a robot” tests (CAPTCHA). You can even try it for free for 7 days.

- ParseHub is a program you download to your computer that helps you get data without writing any code.

- Scrapy is a famous tool for giant projects, but it’s like a “manual” car—you have to set up the tricky parts yourself.

- Most of these tools are easy to use, with simple buttons that make the work easier. Many “no-code” tools can do the work automatically, saving you time.

- No-code tools are smart enough to read websites that use complex computer code (JavaScript).

- You can save your data in common files like Excel, Google Sheets, or simple lists (JSON).

- Some tools have “starter kits” or templates that help you begin scraping popular websites right away.

- Bright Data has the world’s largest network, with over 150 million connections. It is a specialist at helping people scrape shopping websites.

- Web scraping APIs make it much easier to pull information off the web and turn a messy website into a neat, organized list.

- People use these tools for things like market research or seeing what prices their competitors are charging.

- Octoparse has a “visual مقاول بناء” that automatically highlights lists and tables on a website for you. It lets you turn any website into a list without knowing how to code.

- فايركراول is a newer tool made specifically for AI. It turns web pages into a format that AI programs like to read.

- Selenium and Playwright are tools that act like a real person clicking and scrolling on a website.

- Kadoa is a very smart tool that figures out what data is on its own, even if the website changes its layout.

- Oxylabs has an AI helper called OxyCopilot that lets you request the data you want using everyday words.