Gérer des tonnes de données sur Reddit est difficile.

Copier-coller prend une éternité.

Vous ratez des publications importantes et des tendances clés.

Il vous faut un moyen plus rapide et plus simple d'obtenir ces informations.

Il doit s'agir de données propres et utilisables.

Nous avons trouvé les 7 meilleurs outils d'extraction de données Reddit pour 2025.

Commencez dès maintenant à collecter des données intelligemment.

Quels sont les meilleurs scrapers Reddit ?

Vous souhaitez obtenir des données rapides et fiables de Reddit. Mais quel outil choisir ?

Vous avez besoin d'un grattoir Ça fonctionne, sans aucun problème.

Nous avons examiné toutes les meilleures options.

Vous trouverez ci-dessous notre liste finale et classée des 7 meilleurs outils d'extraction de données Reddit que vous pourrez utiliser en 2025.

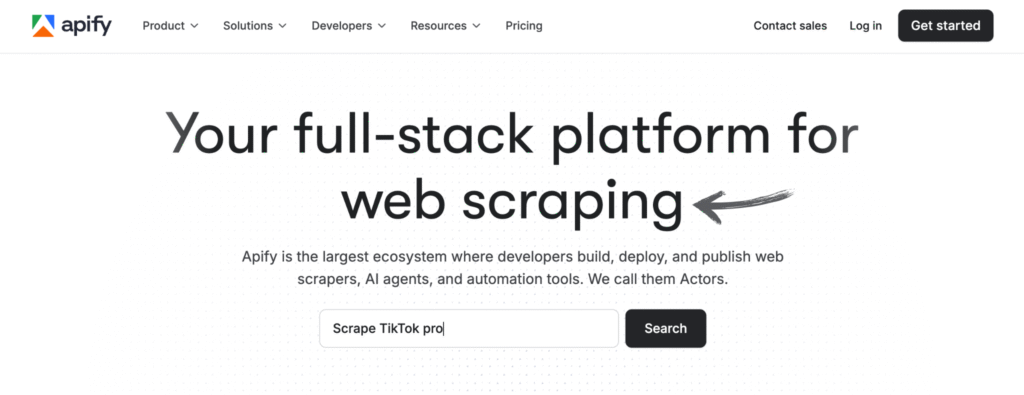

1. Apify (⭐4,8)

Apify est une plateforme basée sur le cloud.

Il dispose de nombreux outils prêts à l'emploi appelés « Acteurs ».

Vous pouvez extraire les publications, les commentaires et les informations des utilisateurs sans vous connecter.

Cela vous facilite grandement la collecte de données à grande échelle.

Notre avis

Envie de constater par vous-même la puissance d'Apify ? Notre plateforme a permis d'extraire des données de plus de 2,5 millions de pages web et de traiter plus de 500 To de données en un seul mois. Prêt à vous lancer ?

Principaux avantages

- Marché massif : L'Apify Store propose plus de 5 000 outils d'extraction et d'automatisation prêts à l'emploi, appelés Actors.

- Évolutivité ultime : Conçu pour les tâches de niveau entreprise, il peut gérer des analyses à grande échelle de millions de pages.

- Adapté aux développeurs : Fournit un SDK open source et prend en charge le code personnalisé en Python et JavaScript.

- Planification avancée : Automatisez vos tâches de web scraping pour qu'elles s'exécutent à des heures ou à des intervalles spécifiques, sans aucune intervention manuelle.

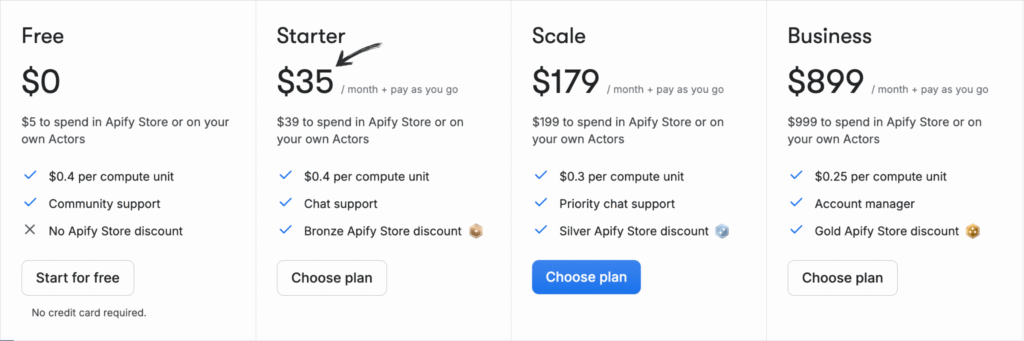

Tarification

Tous les plans seront facturé annuellement.

- Gratuit: 0 $/mois + Paiement à l'utilisation.

- Démarreur: 35 $/mois + Paiement à l'utilisation.

- Échelle: 179 $/mois + Paiement à l'utilisation.

- Entreprise: 899 $/mois + Paiement à l'utilisation.

Avantages

Cons

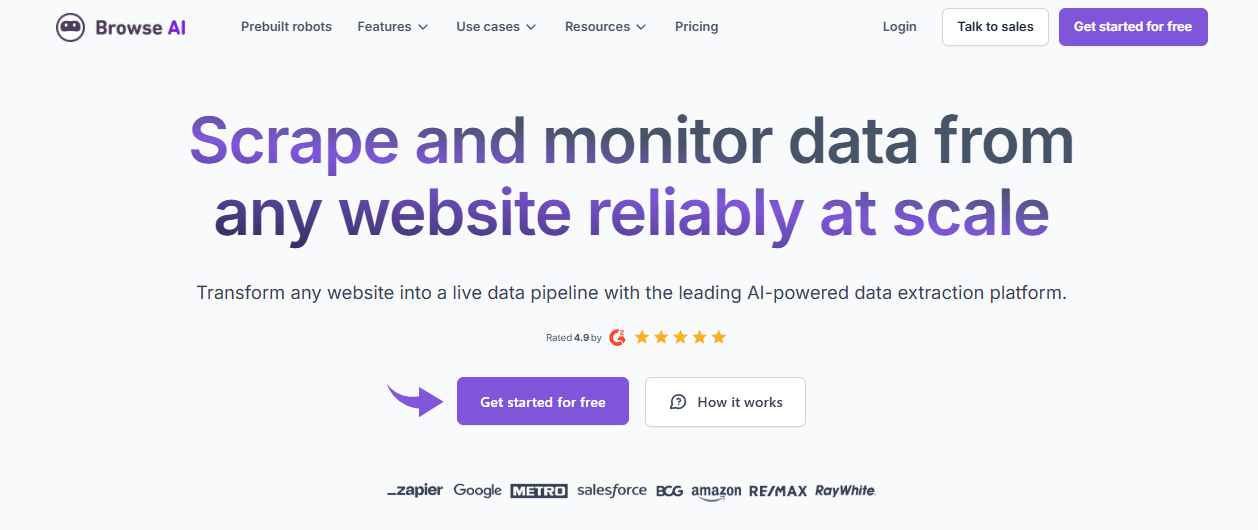

2. IA de navigation (⭐4,5)

Cet outil ne nécessite aucune programmation. Il suffit de cliquer sur l'élément à extraire pour entraîner le robot.

Son utilisation est extrêmement simple.

C'est idéal pour les non-développeurs qui souhaitent surveiller les tendances sur les subreddits.

Notre avis

Prêt à gagner du temps et à obtenir les données dont vous avez besoin ? Browse AI peut traiter des millions de sites web. Découvrez la simplicité du web scraping.

Principaux avantages

- Aucun code requis : Son interface intuitive permet à n'importe qui de créer un outil d'extraction de données en quelques minutes.

- Adaptabilité basée sur l'IA : L’outil s’adapte automatiquement aux changements de mise en page d’un site web, garantissant ainsi la cohérence de vos données.

- Plus de 7 000 intégrations : Connectez facilement vos données collectées à des applications comme Google Sheets, Airtable et Zapier.

- Robots pré-assemblés : Accédez à une bibliothèque de robots préconfigurés pour les tâches courantes sur les sites web populaires, et gagnez ainsi encore plus de temps.

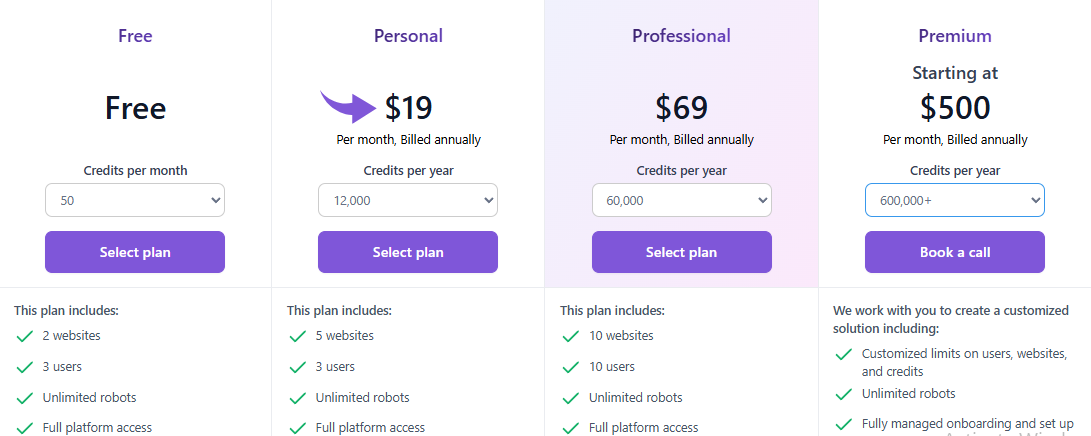

Tarification

Tous les plans seront facturé annuellement.

- Gratuit: $0.

- Personnel: 19 $/mois.

- Professionnel: 69 $/mois.

- Prime: À partir de 500 $/mois.

Avantages

Cons

3. Oxylabs (⭐4.0)

Oxylabs est une solution puissante, axée sur les API.

Ils se concentrent sur le déblocage des sites difficiles à indexer.

Vous bénéficiez d'une rotation intelligente des proxys et d'une protection anti-bots pilotée par l'IA.

C'est idéal pour les projets de très grande envergure et à volume élevé.

Notre avis

Accédez à vos données grâce à un service proxy de premier plan. Avec plus de 175 millions de proxys résidentiels, 2 millions de proxys dédiés aux centres de données et 20 millions de proxys mobiles, Oxylabs vous fournit les adresses IP nécessaires à tous vos projets.

Principaux avantages

- Assistant IA OxyCopilot : Cet outil vous permet de générer des requêtes de web scraping en utilisant un langage simple et naturel.

- Vaste réseau de proxys : Possède l'un des plus grands réseaux de serveurs proxy au monde, avec des adresses IP provenant de 195 pays.

- Succès garanti : La technologie d'empreinte digitale pilotée par l'IA et le contournement du CAPTCHA de la plateforme garantissent un taux de réussite élevé, même sur les sites les plus difficiles.

- Sécurité de niveau entreprise : La plateforme est certifiée ISO/IEC 27001:2022, garantissant un haut niveau de sécurité et de confidentialité des données.

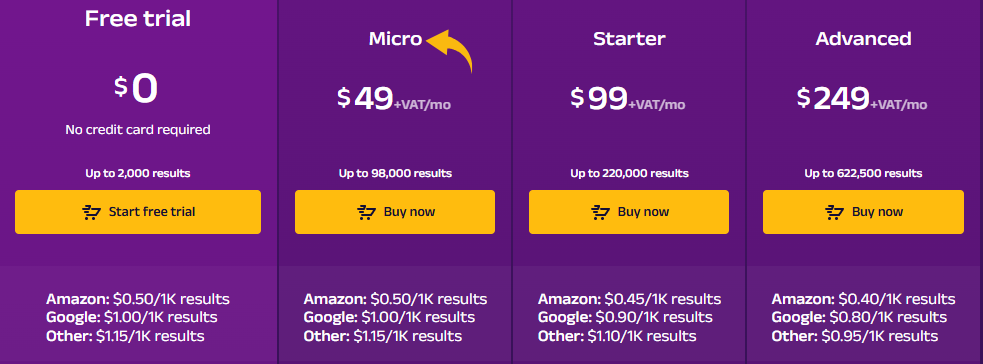

Tarification

- Essai gratuit : $0.

- Micro : 49 $/mois + TVA.

- Démarreur: 99 $/mois + TVA.

- Avancé: 249 $/mois + TVA.

Avantages

Cons

4. ScrapeGraphAI (⭐3,8)

Cet outil utilise l'IA pour simplifier le web scraping.

Vous lui indiquez les données dont vous avez besoin en anglais simple.

L'IA gère le codage complexe.

C'est une révolution pour obtenir rapidement des données structurées.

Notre avis

Plus de 350 professionnels de renom font confiance à ScrapeGraphAI pour ses puissantes capacités d'extraction de données web basées sur l'IA. Bénéficiez d'une amélioration de votre efficacité de 20 % pendant les prochaines 48 heures.

Principaux avantages

- Extraction de données en langage naturel : Vous pouvez lui indiquer les données à extraire à l'aide d'instructions simples et intuitives.

- Bibliothèque open source : Les développeurs peuvent utiliser sa puissante bibliothèque open source pour un contrôle maximal.

- Fonctionnalité Markdownify : Il peut convertir des pages web entières en documents Markdown propres et lisibles.

- Scraper agentique : L'IA peut naviguer et interagir de manière autonome avec les sites web pour accomplir des tâches complexes en plusieurs étapes.

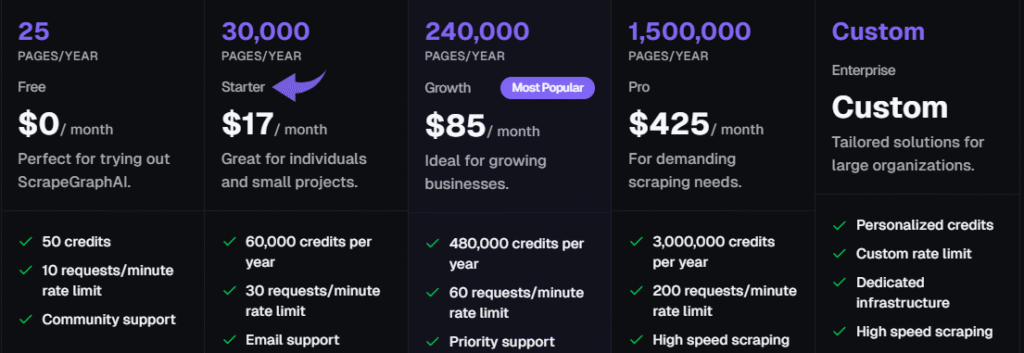

Tarification

Tous les plans seront facturé annuellement.

- Gratuit: 0 $/mois.

- Démarreur: 17 $/mois.

- Croissance: 85 $/mois.

- Pro: 425 $/mois.

- Entreprise: Tarification personnalisée.

Avantages

Cons

5. Zyte (⭐3,5)

Zyte propose une API complète de web scraping.

Il est idéal pour les pages dynamiques riches en JavaScript.

La plateforme gère pour vous la gestion des proxys et les mesures anti-bots.

C'est un choix fiable pour les tâches d'entreprise évolutives.

Notre avis

Obtenez le site web le plus fiable données Avec l'API Zyte, atteignez une précision de données de 99,99 % pour vos projets grâce à cette API de web scraping de haute qualité et optimisez votre processus d'extraction de données dès aujourd'hui.

Principaux avantages

- Déblocage automatique : Arrêtez de jongler avec les proxys ; l'API Zyte est un outil automatisé puissant pour gérer les bannissements.

- Intégration transparente de Scrapy : Si vous êtes un développeur qui utilise le framework Scrapy, Zyte s'intègre parfaitement.

- Extraction de données basée sur l'IA : Cet outil peut identifier et analyser automatiquement les données, réduisant ainsi le besoin de règles d'analyse manuelles.

- Navigateur sans interface graphique intégré : Pas besoin de navigateurs headless tiers, car Zyte en fournit un optimisé pour le web scraping à grande échelle.

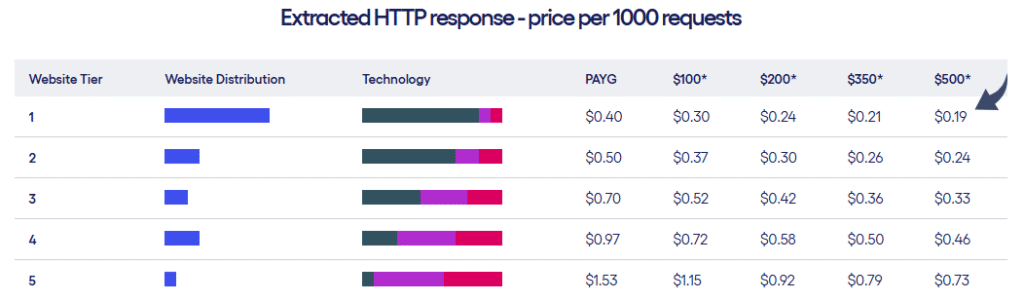

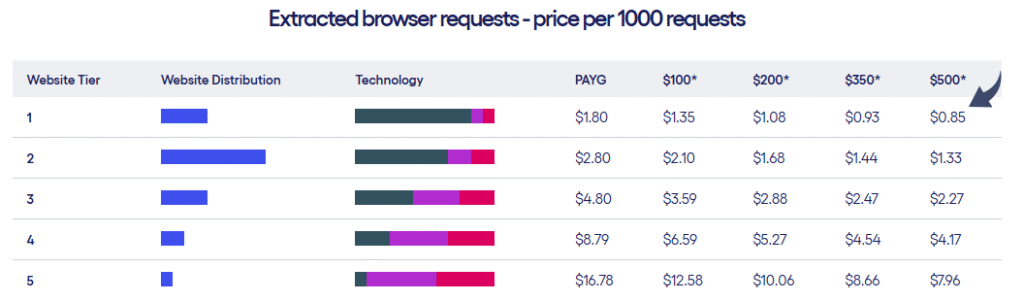

Tarification

- Zyte propose deux types de formules tarifaires en fonction du niveau de sites web et du nombre de requêtes effectuées.

Avantages

Cons

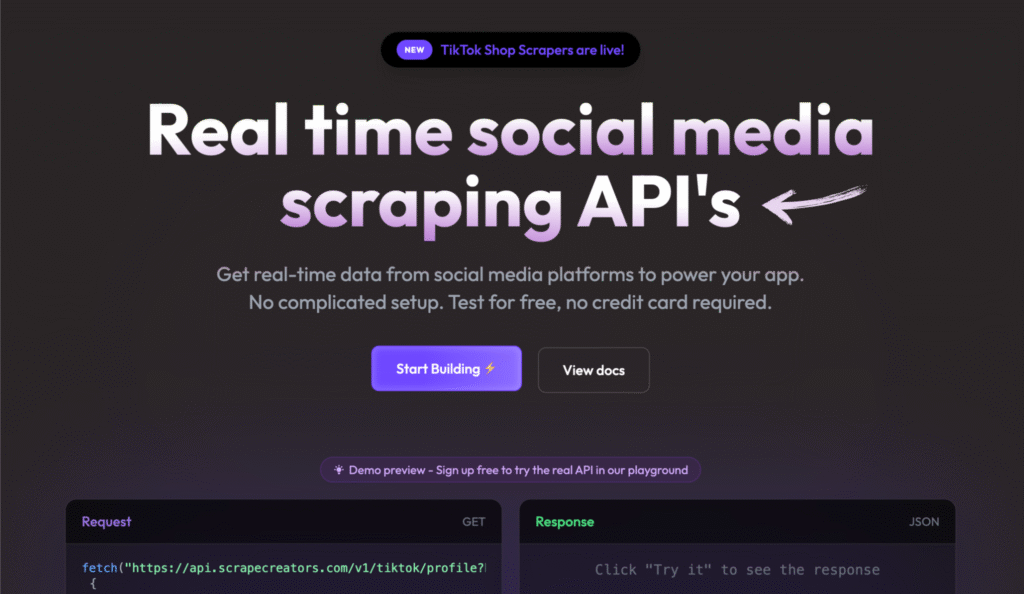

6. Scrape Creators (⭐3.2)

Scrape Creators fournit une solution en temps réel réseaux sociaux API de scraping.

Cet outil vous fournit des données à la demande. Il prend en charge un modèle flexible de paiement à l'utilisation.

C'est parfait si vous n'avez besoin de données que ponctuellement.

Notre avis

Ne perdez plus de temps à collecter des données sur les réseaux sociaux. Avec Scrape Creators, obtenez des données en temps réel depuis des plateformes comme Twitch et Pinterest. Rejoignez les centaines d'utilisateurs qui ont déjà analysé plus de 6 millions de requêtes et exploitez les informations dont vous avez besoin.

Principaux avantages

- API spécialisées : Propose des solutions préconfigurées spécifiquement pour les plateformes de médias sociaux.

- Aucune clé API requise : Vous pouvez ainsi vous passer des clés API officielles fournies par des sites comme Twitch.

- Paiement à l'utilisation : Vous ne payez que ce que vous utilisez, et vos crédits n'expirent jamais.

- Données JSON riches : Les API fournissent des données JSON propres et structurées, vous évitant ainsi tout traitement supplémentaire.

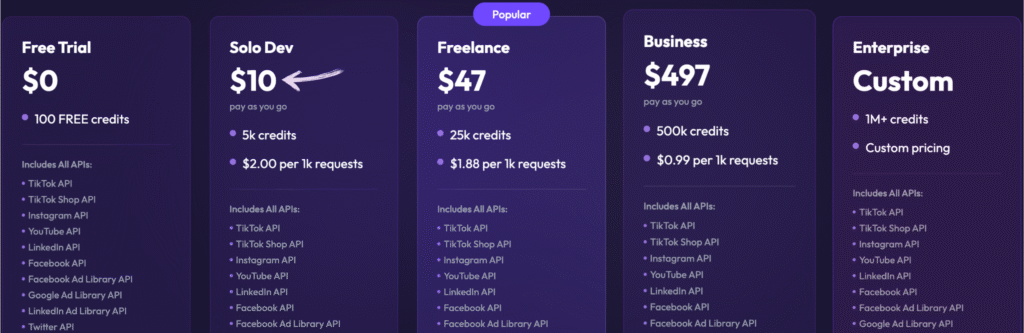

Tarification

- Essai gratuit : 0 $, 100 crédits gratuits.

- Développeur solo : 10 $ – Paiement à l'utilisation, 5k crédits.

- Free-lance: 47 $ – Paiement à l'utilisation, 25 000 crédits.

- Entreprise: 497 $ × Paiement à l'utilisation, 500 000 crédits.

- Entreprise: Tarification personnalisée, plus d'un million de crédits.

Avantages

Cons

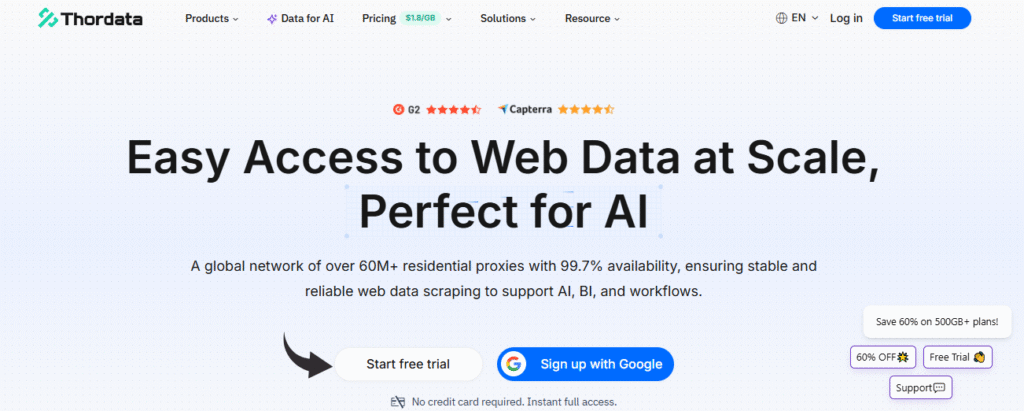

7. ThorData (⭐3.0)

ThorData est une API de scraping simple et sans code.

Vous pouvez commencer avec 1 000 appels API gratuits.

Elle se concentre sur la fourniture de données structurées dans des formats tels qu'Excel et JSON.

C'est un moyen simple d'automatiser la collecte de données.

Notre avis

Bénéficiez d'une sécurité inégalée avec ThorData. données Le processus de vérification garantit un taux de réussite de 99,7 %. Avec une assistance en direct 24 h/24 et 7 j/7 et un temps de réponse moyen inférieur à 3 minutes, vous pouvez avoir confiance en la qualité de votre connexion. Bénéficiez de plus de 60 millions d'adresses IP et sécurisez vos données.

Principaux avantages

- Vaste pool d'adresses IP : Offre plus de 60 millions d'adresses IP résidentielles issues de sources éthiques.

- Anonymat élevé : Grâce à ses proxys de haute qualité, votre activité de scraping reste indétectable.

- Paiement à l'utilisation : La facturation est transparente ; vous ne payez que pour le trafic que vous utilisez, et non pour les requêtes ayant échoué.

- Scraper intégré : Inclut un outil d'extraction de données Web sans code et une API universelle, vous n'avez donc pas besoin d'un outil séparé pour les projets simples.

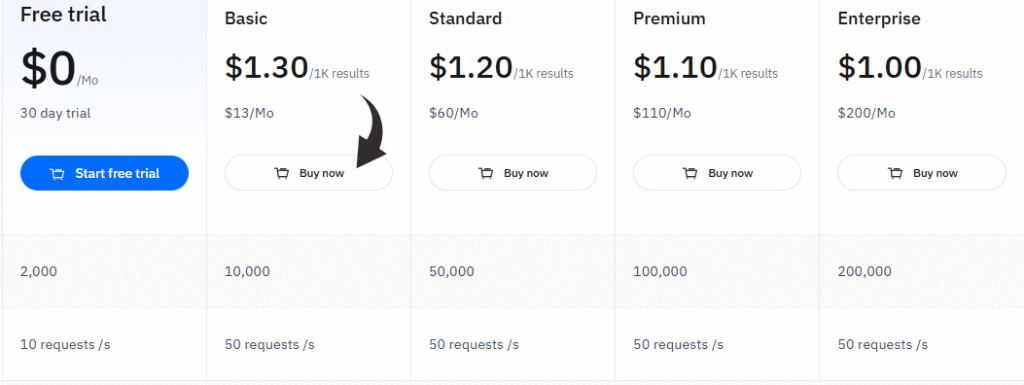

Tarification

- Essai gratuit : 0 $/mois, essai gratuit de 30 jours.

- Basique: 13 $/mois.

- Standard: 60 $/mois.

- Prime: 110 $/mois.

- Entreprise: 200 $/mois.

Avantages

Cons

Quels sont les critères de choix d'un scraper Reddit ?

Choisir le bon outil est essentiel pour obtenir les données dont vous avez besoin.

N’optez pas pour un outil qui tombe facilement en panne ou qui vous fournit des données désordonnées.

Pensez toujours à votre niveau de compétence et à la quantité de données dont vous avez besoin.

Voici ce que vous devez rechercher lorsque vous choisissez un outil d'extraction de données Reddit :

- Facilité d'utilisation : Est-ce un outil sans code, avec une interface simple de type pointer-cliquer ? Ou nécessite-t-il des compétences en Python ? Choisissez un outil adapté à votre niveau technique.

- Structure des données : Le scraper doit fournir des données propres et structurées. Cela signifie des fichiers JSON ou CSV clairs et prêts à être analysés, et non des données brutes. texte.

- Fonctionnalités anti-blocage : Reddit s'efforce de bloquer les bots. Un bon scraper doit gérer la rotation des adresses IP et les CAPTCHA pour garantir le bon déroulement de votre tâche.

- API/Intégration : Pouvez-vous le connecter à vos autres outils, comme Google Sheets ou un entrepôt de données ? Recherchez des API pour faciliter votre flux de travail.

- Points de données : Il devrait pouvoir recueillir plus que le simple titre de la publication. Il faut les commentaires, les votes positifs, les horodatages et les informations complètes de l'utilisateur.

- Évolutivité : Ce système peut-il extraire rapidement des milliers de publications provenant de plusieurs subreddits ? C'est essentiel pour les études de marché à grande échelle.

- Planification : Les meilleurs outils permettent de programmer des tâches qui s'exécutent automatiquement chaque jour ou chaque semaine. Cela vous permet de suivre les tendances au fil du temps sans intervention manuelle.

Comment un outil d'extraction de données Reddit peut-il booster votre entreprise ?

Vous pouvez obtenir un avantage considérable sur vos concurrents.

Un outil d'extraction de données web basé sur Reddit collecte rapidement pour vous des informations récentes sur le marché.

Cela signifie que vous pouvez suivre ce que les gens disent de votre marque ou de vos concurrents.

Vous transformez des fils de conversation bruts en précieuses données Reddit extraites.

Vous pouvez repérer les tendances avant qu'elles ne deviennent virales.

Consulter les discussions sur les subreddits permet de trouver de nouvelles idées de produits ou de résoudre rapidement des problèmes.

Vous pouvez également identifier les besoins cachés des clients en analysant chaque publication et commentaire sur Reddit.

C'est comme avoir un groupe de discussion en temps réel fonctionnant 24h/24 et 7j/7.

Le processus d'extraction de données de Reddit fournit des listes propres de données Reddit.

Vous pouvez intégrer ces données à vos propres outils via l'API Reddit pour automatiser la génération de rapports.

Cela vous permet d'analyser les données de Reddit pour mieux comprendre l'opinion publique.

Guide d'achat

Lors de notre recherche du meilleur produit, nous avons utilisé les facteurs suivants.

Notre méthode était axée sur l'utilité concrète de l'extraction de données publiques.

- Tarification et accèsNous avons examiné le coût du service et les modalités d'accès. Nous avons vérifié si un compte Reddit ou un jeton développeur était nécessaire.

- Points de donnéesL'outil peut-il capturer toutes les informations nécessaires ? Cela inclut l'URL de la publication, les URL Reddit et les détails clés de la publication. Il doit permettre d'explorer les subreddits et de trouver les publications les plus populaires.

- Anti-blocageNous avons testé des outils pour éviter d'être bloqués par le réseau. sécuritéIl est impératif d'éviter l'erreur fréquente de création d'un ticket d'assistance. Nous avons examiné la procédure à suivre en cas de blocage suite à la création d'un ticket d'assistance par erreur. Nous avons vérifié les journaux pour détecter d'éventuelles erreurs de connexion.

- Fonctionnalités et codeNous avons vérifié s'il était possible de créer un scraper en utilisant du code Python. Nous avons recherché un exemple de tutoriel, souvent une vidéo ou YouTube Nous avons inclus un lien pour illustrer la procédure. Nous avons également passé en revue la méthode d'importation des données et l'obtention de la réponse.

- Facilité d'utilisationNous avons recherché la simplicité. La navigation dans les résultats devait être aisée. Une personne sans connaissances en programmation pouvait-elle utiliser le site web et poursuivre sa tâche sans connaissances techniques approfondies ?

- Analyse et résultatsNous avons vérifié si l'outil d'extraction de données était utile pour l'analyse des sentiments. Le résultat devait être un code HTML propre, et non un code HTML désordonné.

- Conformité et respectNous avons veillé à ce que chaque outil respecte les conditions d'utilisation de Reddit. Nous avons privilégié les outils respectueux de la vie privée des données.

- Communication et soutienOffrent-ils un bon système de retour d'information ? Peut-on envoyer un message ou obtenir un résumé des problèmes rencontrés ? Nous avons évalué leur assistance pour chaque article ou tutoriel.

- Fonctionnalités de baseLa possibilité de cibler un nom d'utilisateur précis et de trouver le bon subreddit était essentielle. Nous avons testé la façon dont la fonction principale gérait différents mots-clés et requêtes.

- Utilisation futureNous avons envisagé des fonctionnalités telles que la mise en favoris et la recherche d'une image associée aux données. L'outil doit fournir l'URL finale via HTTPS.

- Dernier espoirL’objectif final est toujours d’obtenir de manière fiable les données dont vous avez besoin.

Conclusion

Nous avons passé en revue les 7 meilleurs outils d'extraction de données Reddit dont vous aurez besoin en 2025.

Vous savez maintenant qu'obtenir des données propres à partir des pages Reddit n'est pas forcément difficile.

Nous vous avons présenté des outils adaptés à tous les niveaux de compétence. Certains ne nécessitent aucune programmation.

D'autres vous permettent d'utiliser votre jeton de développeur pour un accès personnalisé et approfondi.

Notre liste vous offre les meilleurs outils pour commencer dès aujourd'hui à suivre les tendances du marché.

Arrêtez de perdre du temps avec le copier-coller manuel.

Choisissez un outil d'extraction de données intelligent, configurez-le et obtenez les informations qui vous permettront de piloter votre stratégie. entreprise.

Vous nous avez écoutés, et vous disposez maintenant des outils adéquats pour gagner la bataille des données.

Foire aux questions

Est-il légal de récupérer des données sur Reddit ?

Oui, la récupération de données publiques est généralement légale, mais vous devez respecter les conditions d'utilisation de Reddit et le fichier robots.txt. Toute récupération excessive ou agressive est interdite.

Ai-je besoin d'un compte Reddit pour extraire des données ?

Non, la plupart des outils d'extraction de données peuvent accéder aux subreddits publics sans compte Reddit. Cependant, un jeton peut être nécessaire pour dépasser les limites de requêtes plus élevées.

Quel est le meilleur format de sortie pour les données extraites de Reddit ?

Les meilleurs formats sont les fichiers structurés comme JSON et CSV. faire Il est facile d'importer les données dans des tableurs ou des bases de données pour une analyse immédiate.

Un outil d'extraction de données Reddit peut-il récupérer les commentaires et les informations des utilisateurs ?

Oui, les meilleurs outils peuvent extraire le texte intégral des commentaires, les détails des publications et même le nom d'utilisateur associé au contenu.

Vais-je être bloqué si je collecte trop de données ?

Oui, si vous envoyez trop de requêtes trop rapidement, vous risquez d'être bloqué par la sécurité du réseau. Utilisez un scraper avec rotation de proxy pour éviter cela.