Czy jesteś zmęczony swoim Webscraper Zadania IO są blokowane?

Czy uważasz, że konfiguracja mapy witryny jest zbyt trudna?

Być może potrzebujesz większych prędkości i lepszych narzędzi do realizacji dużych projektów.

Te problemy spowalniają Cię i marnują Twój czas.

Nie możesz uzyskać czystych, dużych danych, które są potrzebne do rozwoju.

Właściwe narzędzie jest niezbędne do osiągnięcia sukcesu w roku 2025.

Mamy odpowiedź. Odkryj 7 najlepszych alternatyw dla Webscraper IO.

Narzędzia te oferują łatwiejszą konfigurację, większą niezawodność i większą szybkość.

Jakie są najlepsze alternatywy dla Webscraper IO?

Może nie możesz sobie poradzić z Webscraper IO. Nic się nie stało.

Coraz trudniej jest pozyskiwać dane ze stron internetowych i czasami potrzebna jest lepsza automatyzacja sieciowa.

Powolne lub zablokowane działanie skrobaka oznacza utratę kluczowych danych.

To duży problem! Znaleźliśmy najlepsze alternatywy, które robić Twoje życie łatwiejsze.

Te narzędzia pomogą Ci szybciej uzyskać czyste dane, których potrzebujesz.

Znajdźmy coś odpowiedniego dla Ciebie.

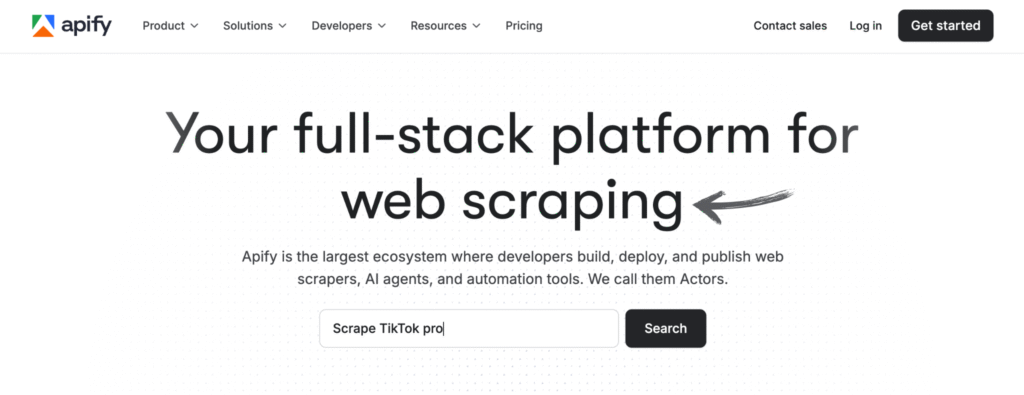

1. Apify (⭐4.8)

Apify to platforma chmurowa do scrapowania stron internetowych. Jej narzędzia nazywają się „Actors”.

Oferuje duży sklep z gotowymi rozwiązaniami skrobaki.

Możesz również tworzyć własne, niestandardowe narzędzia.

Świetnie sprawdzi się zarówno dla programistów, jak i osób niebędących programistami.

Nasze podejście

Chcesz przekonać się na własne oczy o możliwościach Apify? Nasza platforma została wykorzystana do zeskanowania ponad 2,5 miliona stron internetowych i przetworzenia ponad 500 TB danych w ciągu jednego miesiąca. Gotowy do działania?

Kluczowe korzyści

- Ogromny rynek: W sklepie Apify Store dostępnych jest ponad 5000 gotowych do użycia programów do scrapowania i automatyzacji, zwanych aktorami.

- Maksymalna skalowalność: Zaprojektowane do zadań na poziomie korporacyjnym, umożliwia przetwarzanie na dużą skalę milionów stron.

- Przyjazne dla programistów: Udostępnia pakiet SDK typu open source i obsługuje niestandardowy kod w językach Python i JavaScript.

- Zaawansowane planowanie: Zautomatyzuj zadania scrapowania, aby były wykonywane w określonych godzinach lub odstępach czasu, bez konieczności wykonywania czynności ręcznych.

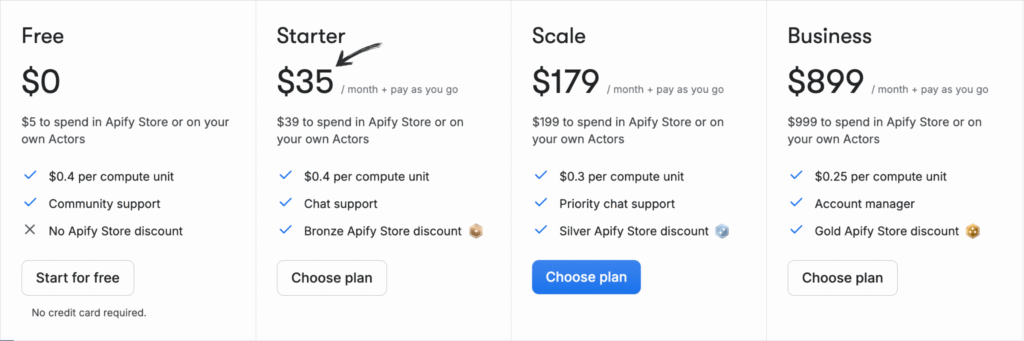

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: 0 zł/miesiąc + Płać zgodnie z zużyciem.

- Rozrusznik: 35 USD/miesiąc + płatność w miarę zużycia.

- Skala: 179 USD/miesiąc + Płać za zużycie.

- Biznes: 899 USD/miesiąc + płatność w miarę zużycia.

Zalety

Wady

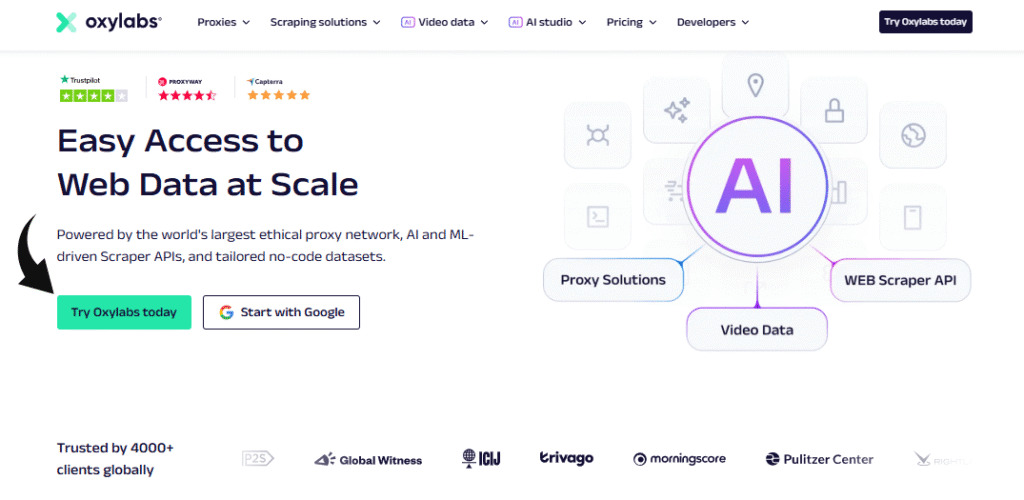

2. Oxylabs (⭐4,5)

Czy martwisz się, że zostaniesz zablokowany?

Oxylabs słynie ze swoich silnych środków zapobiegających blokowaniu.

Oferują ogromną sieć serwerów proxy.

Ułatwia to gromadzenie wiarygodnych danych na dużą skalę.

Mają nawet funkcję AI Copilot.

Nasze podejście

Odblokuj dane dzięki wiodącej usłudze proxy. Z ponad 175 milionami serwerów proxy domowych, 2 milionami dedykowanych serwerów proxy w centrach danych i 20 milionami serwerów proxy mobilnych, Oxylabs zapewnia adresy IP potrzebne do każdego projektu.

Kluczowe korzyści

- Asystent AI OxyCopilot: To narzędzie umożliwia generowanie żądań scrapowania przy użyciu prostego, naturalnego języka.

- Ogromna sieć proxy: Posiada jedną z największych pul serwerów proxy na świecie, obejmującą adresy IP ze 195 krajów.

- Gwarancja sukcesu: Oparte na sztucznej inteligencji odciski palców platformy i omijanie testu CAPTCHA gwarantują wysoki wskaźnik powodzenia nawet w przypadku najtrudniejszych witryn.

- Bezpieczeństwo klasy korporacyjnej: Platforma posiada certyfikat ISO/IEC 27001:2022, co gwarantuje wysoki poziom bezpieczeństwa i prywatności danych.

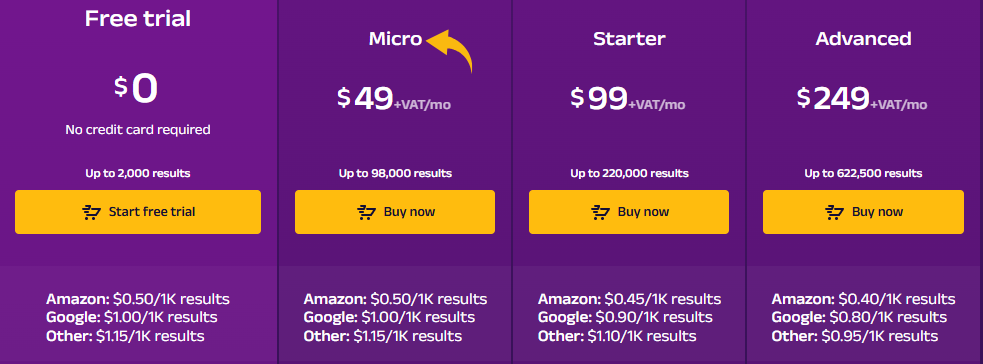

Wycena

- Bezpłatny okres próbny: $0.

- Mikro: 49 USD/miesiąc + VAT.

- Rozrusznik: 99 USD/miesiąc + VAT.

- Zaawansowany: 249 USD/miesiąc + VAT.

Zalety

Wady

3. Przeglądaj AI (⭐4.0)

To ulubiona gra bez kodu. Wskazujesz i klikasz, aby wyszkolić „robota”.

W ciągu kilku sekund zamienia dowolną stronę internetową w proste API.

Doskonale nadaje się do automatycznego monitorowania stron internetowych pod kątem zmian.

Nasze podejście

Chcesz zaoszczędzić czas i uzyskać potrzebne dane? Browse AI poradzi sobie z milionami stron internetowych. Zobacz, jak łatwe może być scrapowanie stron internetowych.

Kluczowe korzyści

- Kod nie jest wymagany: Dzięki interfejsowi typu „wskaż i kliknij” każdy może w ciągu kilku minut stworzyć narzędzie do pozyskiwania danych.

- Adaptacja wspomagana przez sztuczną inteligencję: Narzędzie automatycznie dostosowuje się do zmian w układzie witryny, zapewniając zawsze spójność danych.

- Ponad 7000 integracji: Łatwo połącz zebrane dane z aplikacjami takimi jak Arkusze Google, Airtable i Zapier.

- Gotowe roboty: Uzyskaj dostęp do biblioteki gotowych robotów przeznaczonych do wykonywania typowych zadań na popularnych stronach internetowych, oszczędzając jeszcze więcej czasu.

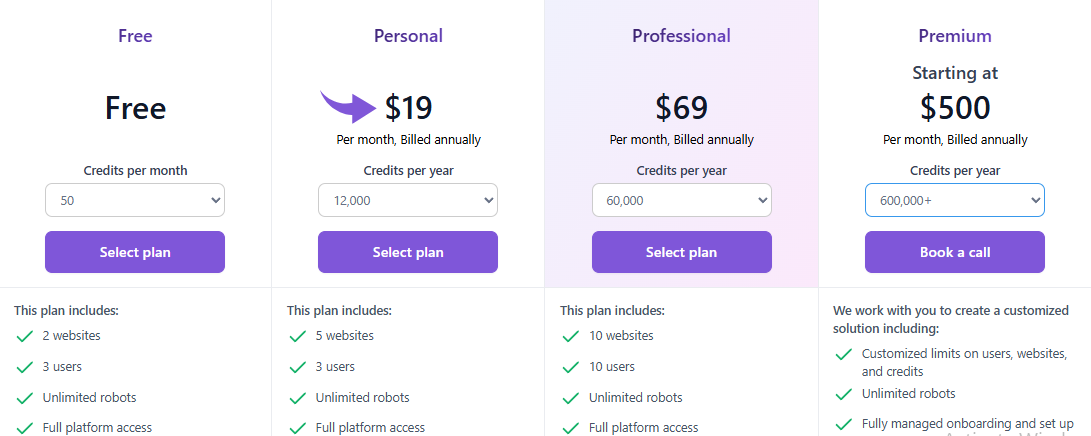

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: $0.

- Osobisty: 19 USD/miesiąc.

- Profesjonalny: 69 USD/miesiąc.

- Premia: Od 500 USD/miesiąc.

Zalety

Wady

4. Zyte (⭐3,8)

Zyte oferuje potężne, kompleksowe API, zaprojektowane z myślą o łatwym odblokowywaniu stron internetowych.

Przywiązują dużą wagę do jakości i zgodności z przepisami prawa.

Doskonale nadaje się do obsługi trudnych, dynamicznych witryn.

Nasze podejście

Uzyskaj najbardziej niezawodną sieć dane z API Zyte. Osiągnij 99,99% dokładności danych w swoich projektach dzięki temu wysokiej jakości API do scrapowania stron internetowych i usprawnij proces ekstrakcji danych już dziś.

Kluczowe korzyści

- Automatyczne odblokowywanie: Przestań żonglować serwerami proxy; Zyte API to potężne, zautomatyzowane narzędzie do obsługi banów.

- Bezproblemowa integracja ze Scrapy: Jeśli jesteś programistą korzystającym z frameworka Scrapy, Zyte będzie dla Ciebie idealnym rozwiązaniem.

- Ekstrakcja danych wspomagana sztuczną inteligencją: Narzędzie może automatycznie identyfikować i analizować dane, zmniejszając potrzebę ręcznego stosowania reguł analizy.

- Zintegrowana przeglądarka bez interfejsu: Nie ma potrzeby korzystania z przeglądarek bezgłowych innych firm, ponieważ Zyte udostępnia przeglądarkę zoptymalizowaną pod kątem scrapowania stron internetowych na dużą skalę.

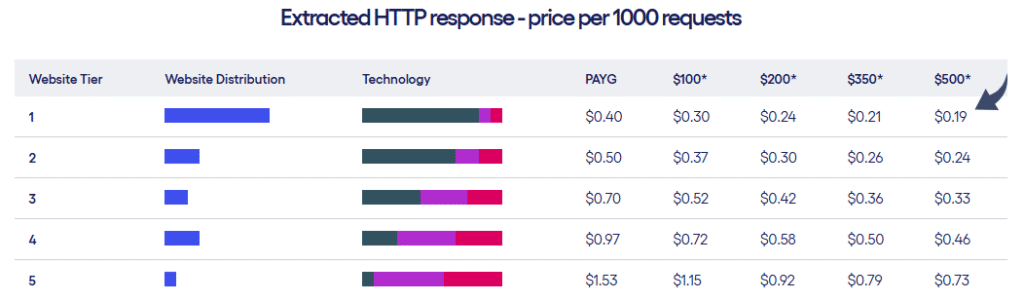

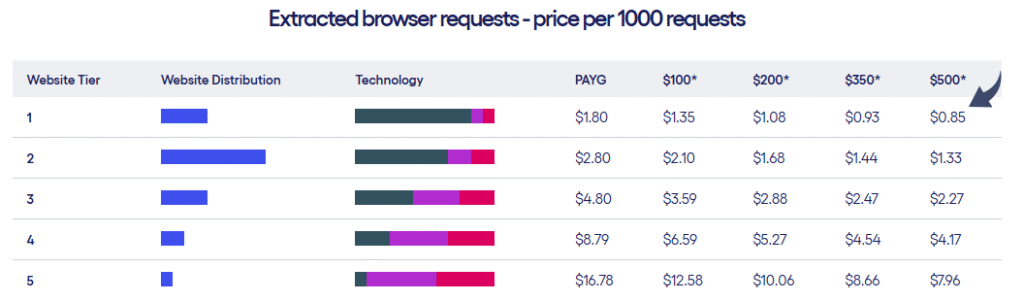

Wycena

- Zyte oferuje dwa rodzaje planów cenowych w zależności od poziomu witryn i liczby żądań.

Zalety

Wady

5. Twórcy scrapowania (⭐3.5)

Czy skrobiesz? media społecznościowe dane?

To narzędzie będzie do tego celu świetne.

Oferuje niezawodne, gotowe scrapery dla platform takich jak TikTok i Instagrama.

Oszczędza programistom mnóstwo czasu.

Nasze podejście

Nie musisz już męczyć się ze zbieraniem danych z mediów społecznościowych. Dzięki Scrape Creators uzyskasz dane w czasie rzeczywistym z platform takich jak Twitch i Pinterest. Dołącz do setek użytkowników, którzy zebrali ponad 6 milionów zapytań i uzyskaj potrzebne Ci informacje.

Kluczowe korzyści

- Specjalistyczne interfejsy API: Oferuje gotowe rozwiązania przeznaczone specjalnie dla platform mediów społecznościowych.

- Nie potrzeba kluczy API: Możesz ominąć konieczność posiadania oficjalnych kluczy API w przypadku witryn takich jak Twitch.

- Płać za zużycie: Płacisz tylko za to, z czego korzystasz, a Twoje środki nigdy nie wygasają.

- Bogate dane JSON: Interfejsy API udostępniają czyste i ustrukturyzowane dane JSON, dzięki czemu nie musisz wykonywać dodatkowego przetwarzania.

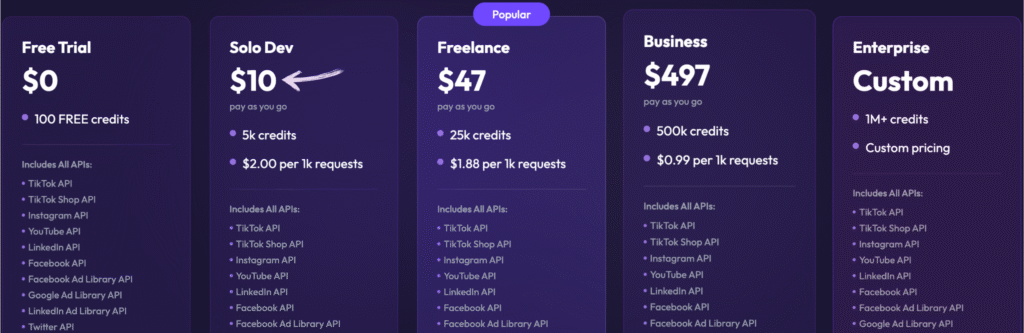

Wycena

- Bezpłatny okres próbny: 0, 100 darmowych kredytów.

- Solo Dev: 10 USD – Płać w miarę użytkowania, 5 tys. kredytów.

- Pracownik nieetatowy: 47 USD – Płać w miarę użytkowania, 25 tys. kredytów.

- Biznes: 497 USD – Płać w miarę użytkowania, 500 tys. kredytów.

- Przedsiębiorstwo: Cena niestandardowa, ponad 1 mln kredytów.

Zalety

Wady

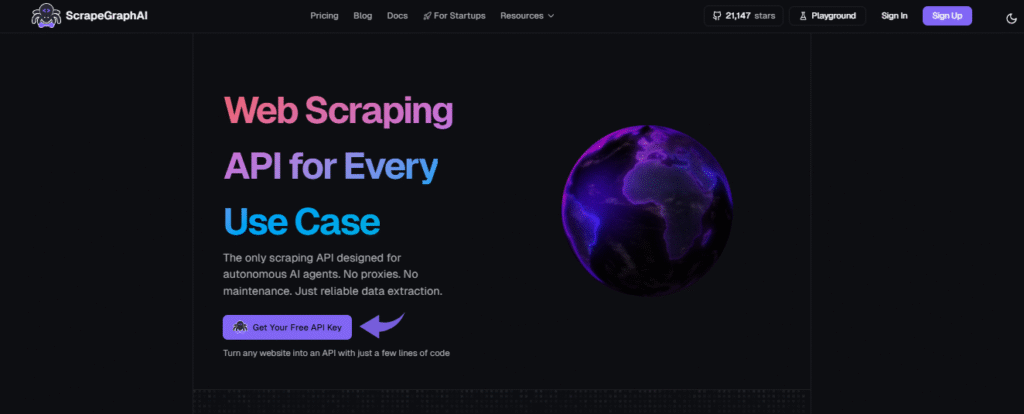

6. Sztuczna inteligencja ScrapeGraph (⭐3.2)

Jest to biblioteka Pythona o otwartym kodzie źródłowym.

Wykorzystuje sztuczną inteligencję (AI – Large Language Models) do ekstrakcji danych.

Powiedz mu wprost, czego chcesz tekst. I

Pomaga zautomatyzować złożone projekty scrapowania, wykorzystując mniej kodu.

Nasze podejście

Wiodący specjaliści (ponad 350 osób) zaufali ScrapeGraphAI ze względu na jego solidne, oparte na sztucznej inteligencji możliwości scrapowania stron internetowych. Zapewnij sobie 20% wzrost wydajności na kolejne 48 godzin.

Kluczowe korzyści

- Scraping języka naturalnego: Możesz wskazać mu, co ma wyodrębnić, używając prostych, zrozumiałych dla człowieka monitów.

- Biblioteka Open Source: Deweloperzy mogą wykorzystać jego wszechstronną bibliotekę typu open-source, aby uzyskać maksymalną kontrolę.

- Funkcja Markdownify: Potrafi konwertować całe strony internetowe na przejrzyste, czytelne dokumenty Markdown.

- Agentic Scraper: Sztuczna inteligencja potrafi autonomicznie poruszać się po stronach internetowych i wchodzić z nimi w interakcje, wykonując złożone, wieloetapowe zadania.

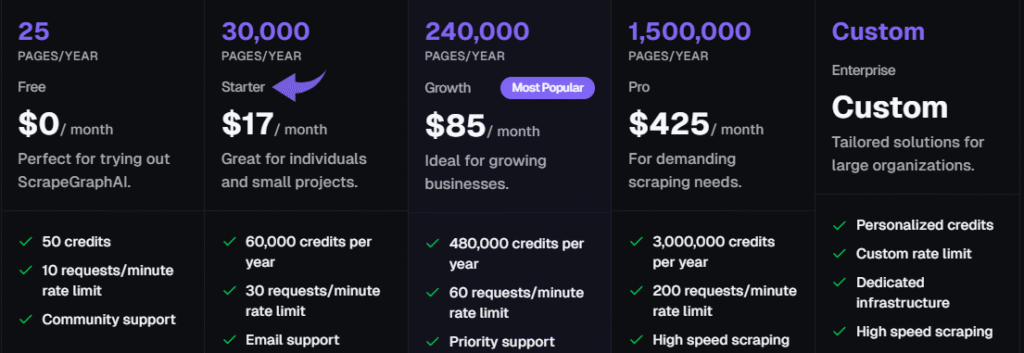

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: 0 zł/miesiąc.

- Rozrusznik: 17 USD/miesiąc.

- Wzrost: 85 USD/miesiąc.

- Zawodowiec: 425 USD/miesiąc.

- Przedsiębiorstwo: Indywidualne ceny.

Zalety

Wady

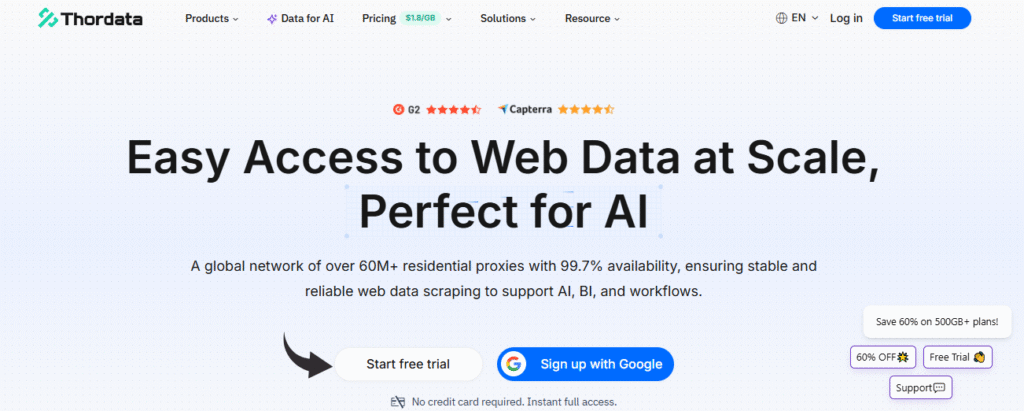

7. ThorData (⭐3.0)

ThorData udostępnia ogromne pule serwerów proxy.

Koncentrują się na dostarczaniu rzetelnych danych w czasie rzeczywistym.

Ich uniwersalne API do scrapowania wykona za Ciebie całą trudną pracę związaną z ochroną przed botami.

To solidny wybór w przypadku dużych, globalnych zadań.

Nasze podejście

Ciesz się niezrównanym bezpieczeństwem dzięki ThorData. To dane Proces weryfikacji gwarantuje 99,7% skuteczności. Dzięki całodobowemu wsparciu na żywo i średniemu czasowi reakcji poniżej 3 minut możesz być pewien jakości połączenia. Uzyskaj ponad 60 milionów adresów IP i zabezpiecz swoje dane.

Kluczowe korzyści

- Ogromna pula adresów IP: Oferuje ponad 60 milionów etycznie pozyskanych adresów IP.

- Wysoka anonimowość: Zapewnia, że Twoja aktywność scrapowania pozostanie niewykryta dzięki wysokiej jakości serwerom proxy.

- Płać za zużycie: Rozliczenia są przejrzyste: płacisz tylko za wykorzystany ruch, a nie za nieudane żądania.

- Wbudowany skrobak: Zawiera narzędzie do scrapowania stron internetowych bez kodu i uniwersalny interfejs API, dzięki czemu nie potrzebujesz osobnego narzędzia do prostych projektów.

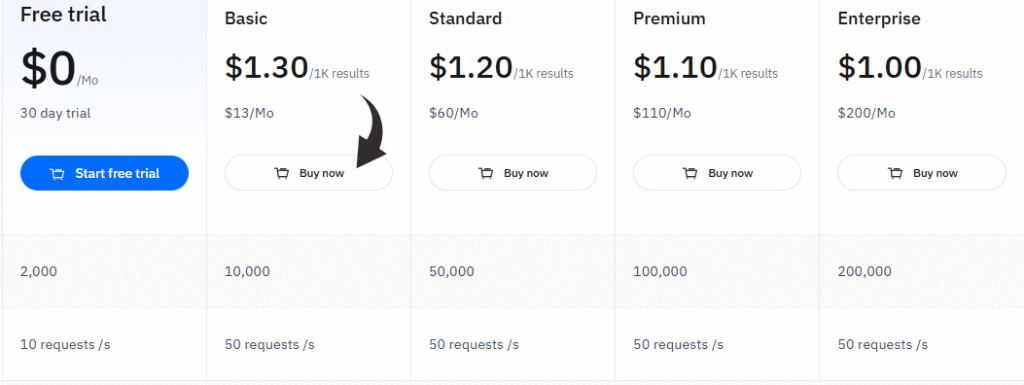

Wycena

- Bezpłatny okres próbny: 0 USD/miesiąc, 30-dniowy okres próbny.

- Podstawowy: 13 USD/miesiąc.

- Standard: 60 USD/miesiąc.

- Premia: 110 USD/miesiąc.

- Przedsiębiorstwo: 200 dolarów miesięcznie.

Zalety

Wady

Przewodnik kupującego

Podczas naszych badań mających na celu znalezienie najlepszych narzędzi do scrapowania stron internetowych, stanowiących prawdziwą alternatywę dla Webscraper IO, nie ograniczyliśmy się do prostej listy.

- Łatwość użytkowania i interfejs: Przyjrzeliśmy się interfejsowi użytkownika i krzywej uczenia się. Czy oferuje interfejs typu „wskaż i kliknij” dla użytkowników bez wiedzy technicznej? Czy oferuje rozszerzenie do Chrome lub aplikację na komputer? Czy można łatwo scrapować strony internetowe? To klucz do efektywnego procesu ekstrakcji danych i tworzenia scraperów internetowych.

- Cechy: Jakie były kluczowe funkcje każdego oprogramowania do scrapowania stron internetowych? Skupiliśmy się na zaawansowanych funkcjach, takich jak renderowanie JavaScript i obsługa JavaScript dla dynamicznych stron internetowych, rotacja adresów IP w celu zapobiegania blokadom oraz uczenie maszynowe w celu dokładniejszego wyodrębniania danych. Sprawdziliśmy również pod kątem… automatyzacja i zdolność do wykonywania wielu zadań scrapowania.

- Skalowalność i wydajność: Oceniliśmy, czy narzędzie do scrapowania stron internetowych poradzi sobie z zadaniami scrapowania na dużą skalę i złożonymi witrynami. Czy potrafi ono tworzyć skalowalne roboty indeksujące i zapewniać ekstrakcję danych na dużą skalę za pośrednictwem solidnych, skalowalnych robotów indeksujących i usług w chmurze? Wysoka wydajność jest niezbędna do gromadzenia dużych ilości danych o stronach internetowych na potrzeby badań rynkowych.

- Wycena: Sprawdziliśmy, czy narzędzie do scrapowania stron internetowych jest opłacalną opcją. Czy oferuje darmowy plan, czy hojny bezpłatny okres próbny? Porównaliśmy koszty ekstrakcji danych na dużą skalę, aby upewnić się, że jest to opłacalne.

- Dane wyjściowe i jakość: Czy narzędzie niezawodnie pobiera dane i dostarcza je w ustrukturyzowanym formacie? Czy można łatwo eksportować zebrane dane do popularnych formatów, takich jak Arkusze Google? Przetestowaliśmy jego zdolność do obsługi dokumentów HTML i XML oraz różnych struktur internetowych w celu dostarczenia pożądanych danych.

- Wsparcie: Sprawdziliśmy, czy narzędzie do scrapowania stron internetowych, zaprojektowane z myślą o wysokiej niezawodności, oferuje solidne wsparcie klienta. Jest to kluczowe, gdy proces scrapowania napotyka problemy, takie jak scrapowanie trudnych do scrapowania stron internetowych lub dostęp do danych z witryn takich jak Mapy Google.

- Negatywy: Czego brakowało lub czego obsługa była trudna? Skupiliśmy się na typowych problemach użytkowników, aby porównać, jak te najlepsze narzędzia do scrapowania stron internetowych rozwiązują je w porównaniu z innymi.

Podsumowanie

Znalezienie odpowiedniego narzędzia do scrapowania stron internetowych może wydawać się trudnym zadaniem. Rozumiemy to.

Właśnie przedstawiliśmy Ci najlepsze alternatywy dla Webscraper IO.

Te narzędzia do pozyskiwania danych znacznie ułatwiają tworzenie robotów indeksujących sieć.

Jeśli potrzebujesz szybko czystych danych internetowych, nasza lista będzie dobrym początkiem.

Pamiętaj, że najlepsze narzędzia do scrapowania danych z sieci radzą sobie z trudnymi zadaniami, takimi jak scrapowanie dynamicznych stron internetowych.

Oferują również dobry, intuicyjny interfejs użytkownika.

Dotyczy to zarówno początkujących, jak i doświadczonych naukowców zajmujących się danymi.

Nie zadowalaj się błędnymi danymi. Aby wygrać, potrzebujesz wiarygodnych danych ze stron internetowych.

Skorzystaj z tego przewodnika, aby wybrać kolejne potężne narzędzie i wrócić do pracy!

Często zadawane pytania

Jakie funkcje będą kluczowe w narzędziach do scrapowania w 2025 roku?

Poszukaj przyjaznego dla użytkownika interfejsu, zaawansowanych funkcji antyblokujących i możliwości obsługi złożonych struktur stron internetowych. Są one kluczowe dla Twoich potrzeb w zakresie scrapowania stron internetowych.

Czy mogę uzyskać cenne dane bez umiejętności kodowania?

Tak! Wiele narzędzi do scrapowania danych oferuje intuicyjne interfejsy użytkownika, które pozwalają na ekstrakcję danych produktowych za pomocą zaledwie kilku kliknięć. Nie są dziś potrzebne żadne zaawansowane umiejętności kodowania.

Jak zarządzać wyodrębnionymi danymi i jak je czyścić?

Najlepsze narzędzia oferują ustrukturyzowane punkty końcowe danych i ułatwiają eksport danych. Często zawierają funkcje wstępnego czyszczenia i przetwarzania danych przed eksportem.

A co ze złożonymi potrzebami ekstrakcji danych z dynamicznych witryn?

Wybierz platformę z doskonałym renderowaniem JavaScript. Dzięki temu spełnisz swoje potrzeby w zakresie ekstrakcji danych, w pełni ładując docelową stronę internetową i przechwytując wszystkie cenne dane.

Czy korzystanie z narzędzi do web scrapingu w celu pozyskiwania danych jest legalne?

Scraping danych publicznych z internetu jest generalnie legalny. Zawsze przestrzegaj pliku robots.txt witryny i Warunków korzystania z usługi, aby mieć pewność, że gromadzisz cenne dane w sposób etyczny.