Czy jesteś programistą, analitykiem danych lub marketerem i masz dość problemów ze scrapowaniem stron internetowych?

To jest frustrujące i może poważnie spowolnić Twoje projekty.

ScrapingBee jest świetnym narzędziem.

A może po prostu jesteś ciekaw, co jeszcze jest dostępne.

Co by było, gdyby istniało narzędzie, które mogłoby... robić Czy zbieranie danych jest bardziej wiarygodne?

Przygotowaliśmy listę najlepszych alternatyw dla ScrapingBee, dzięki czemu możesz znaleźć rozwiązanie, które lepiej Ci odpowiada.

Po przeczytaniu tego tekstu będziesz dokładnie wiedział, która platforma może Ci pomóc.

Jakie są najlepsze alternatywy dla ScrapingBee?

Jeśli szukasz wydajnego interfejsu API do scrapowania stron internetowych wykraczającego poza ScrapingBee, trafiłeś we właściwe miejsce.

Być może potrzebujesz lepszego renderowania JavaScript lub niezawodnego interfejsu API wyszukiwarki Google.

Nasza lista najlepszych narzędzi do analizy danych internetowych pomoże Ci znaleźć najlepsze rozwiązanie dla procesów ekstrakcji danych.

Przyjrzyjmy się najlepszym wyborom.

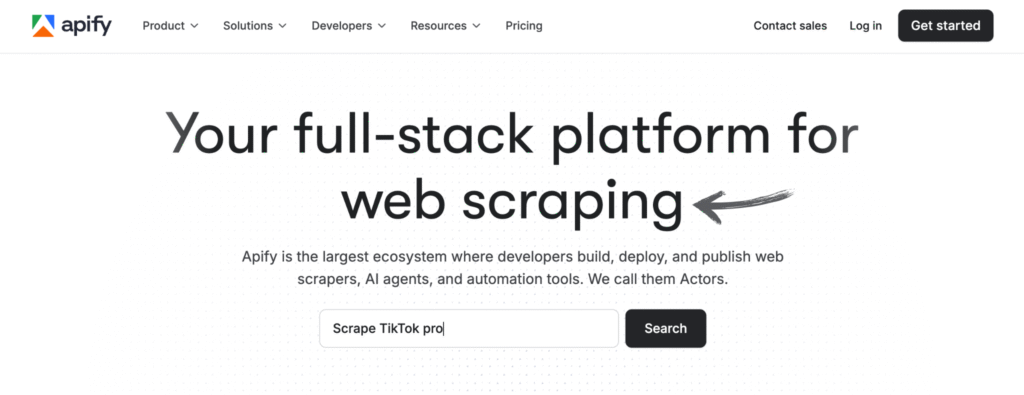

1. Apify (⭐4.8)

Apify to nie tylko narzędzie. To kompleksowa platforma do scrapowania i automatyzacji stron internetowych.

Można to postrzegać jako system operacyjny w chmurze służący do zarządzania danymi.

Posiada ogromną bibliotekę predefiniowanych aktorów, które są w zasadzie gotowymi do użycia narzędziami do zbierania danych.

Możesz wziąć jeden i zacząć skrobać w kilka minut. Radzi sobie z twardymi materiałami, więc Ty nie musisz.

To doskonały wybór dla każdego, komu zależy na kompleksowym gromadzeniu danych z sieci.

Nasze podejście

Chcesz przekonać się na własne oczy o możliwościach Apify? Nasza platforma została wykorzystana do zeskanowania ponad 2,5 miliona stron internetowych i przetworzenia ponad 500 TB danych w ciągu jednego miesiąca. Gotowy do działania?

Kluczowe korzyści

- Ogromny rynek: W sklepie Apify Store dostępnych jest ponad 5000 gotowych do użycia programów do scrapowania i automatyzacji, zwanych aktorami.

- Maksymalna skalowalność: Zaprojektowane do zadań na poziomie korporacyjnym, umożliwia przetwarzanie na dużą skalę milionów stron.

- Przyjazne dla programistów: Udostępnia pakiet SDK typu open source i obsługuje niestandardowy kod w językach Python i JavaScript.

- Zaawansowane planowanie: Zautomatyzuj zadania scrapowania, aby były wykonywane w określonych godzinach lub odstępach czasu, bez konieczności wykonywania czynności ręcznych.

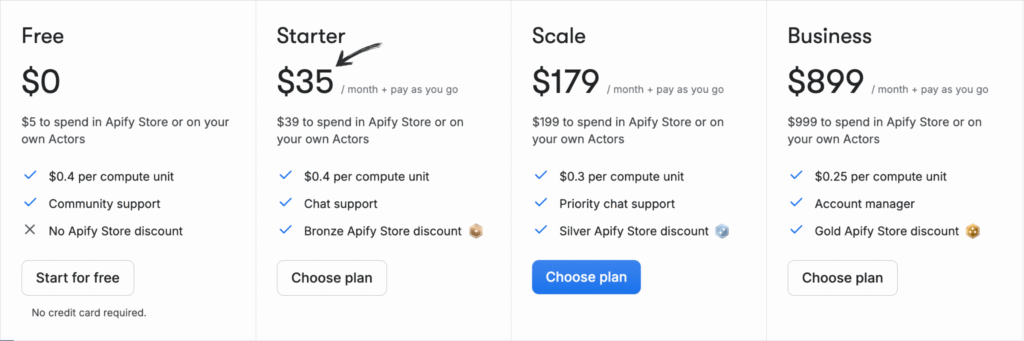

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: 0 zł/miesiąc + Płać zgodnie z zużyciem.

- Rozrusznik: 35 USD/miesiąc + płatność w miarę zużycia.

- Skala: 179 USD/miesiąc + Płać za zużycie.

- Biznes: 899 USD/miesiąc + płatność w miarę zużycia.

Zalety

Wady

2. Oxylabs (⭐4,5)

Oxylabs znany jest ze swojej ogromnej, wysokiej jakości sieci proxy.

To doskonały wybór do poważnej ekstrakcji danych. Ich interfejs API Web Scraper został zaprojektowany tak, aby omijać skuteczne zabezpieczenia anty-botowe.

Mają nawet asystenta opartego na sztucznej inteligencji, zwanego OxyCopilot, który pomaga w generowaniu kodu.

Świetnie sprawdza się w przypadku dużych, złożonych projektów i ułatwia wyodrębnianie danych z trudnych witryn internetowych.

Nasze podejście

Odblokuj dane dzięki wiodącej usłudze proxy. Z ponad 175 milionami serwerów proxy domowych, 2 milionami dedykowanych serwerów proxy w centrach danych i 20 milionami serwerów proxy mobilnych, Oxylabs zapewnia adresy IP potrzebne do każdego projektu.

Kluczowe korzyści

- Asystent AI OxyCopilot: To narzędzie umożliwia generowanie żądań scrapowania przy użyciu prostego, naturalnego języka.

- Ogromna sieć proxy: Posiada jedną z największych pul serwerów proxy na świecie, obejmującą adresy IP ze 195 krajów.

- Gwarancja sukcesu: Oparte na sztucznej inteligencji odciski palców platformy i omijanie testu CAPTCHA gwarantują wysoki wskaźnik powodzenia nawet w przypadku najtrudniejszych witryn.

- Bezpieczeństwo klasy korporacyjnej: Platforma posiada certyfikat ISO/IEC 27001:2022, co gwarantuje wysoki poziom bezpieczeństwa i prywatności danych.

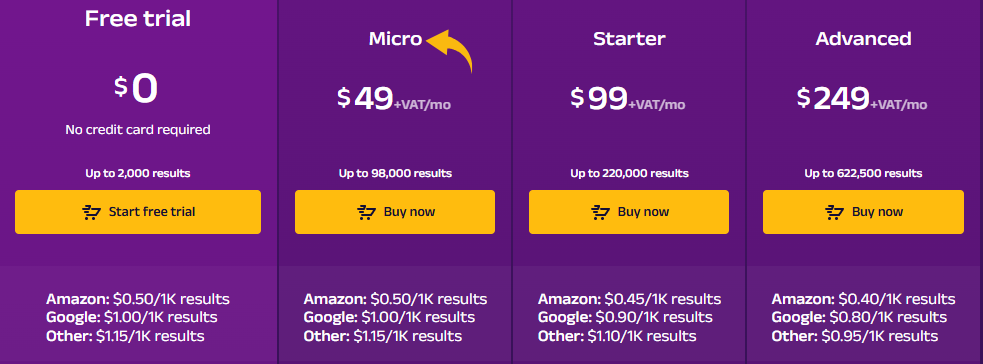

Wycena

- Bezpłatny okres próbny: $0.

- Mikro: 49 USD/miesiąc + VAT.

- Rozrusznik: 99 USD/miesiąc + VAT.

- Zaawansowany: 249 USD/miesiąc + VAT.

Zalety

Wady

3. Przeglądaj AI (⭐4.0)

Szukasz rozwiązania bez kodu?

Odpowiedzią jest Browse AI. Jest przeznaczone dla osób, które nie chcą pisać kodu.

Wystarczy wskazać i kliknąć interesujące Cię dane.

Narzędzie uczy się, co należy pobrać i może monitorować strony internetowe pod kątem zmian.

Jest niezwykle łatwy w użyciu i idealny dla osób niebędących programistami.

Odkryj jego potencjał dzięki naszemu Przeglądaj samouczek dotyczący sztucznej inteligencji.

Nasze podejście

Chcesz zaoszczędzić czas i uzyskać potrzebne dane? Browse AI poradzi sobie z milionami stron internetowych. Zobacz, jak łatwe może być scrapowanie stron internetowych.

Kluczowe korzyści

- Kod nie jest wymagany: Dzięki interfejsowi typu „wskaż i kliknij” każdy może w ciągu kilku minut stworzyć narzędzie do pozyskiwania danych.

- Adaptacja wspomagana przez sztuczną inteligencję: Narzędzie automatycznie dostosowuje się do zmian w układzie witryny, zapewniając zawsze spójność danych.

- Ponad 7000 integracji: Łatwo połącz zebrane dane z aplikacjami takimi jak Arkusze Google, Airtable i Zapier.

- Gotowe roboty: Uzyskaj dostęp do biblioteki gotowych robotów przeznaczonych do wykonywania typowych zadań na popularnych stronach internetowych, oszczędzając jeszcze więcej czasu.

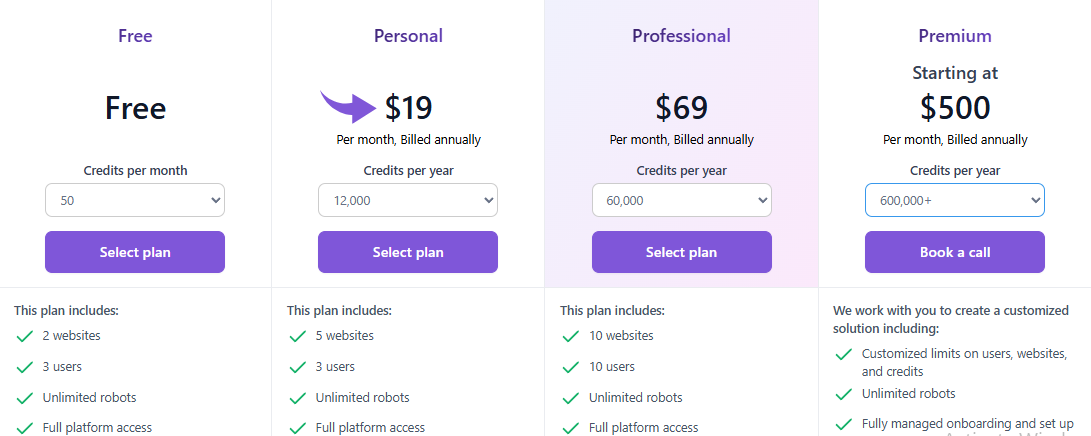

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: $0.

- Osobisty: 19 USD/miesiąc.

- Profesjonalny: 69 USD/miesiąc.

- Premia: Od 500 USD/miesiąc.

Zalety

Wady

4. Zyte (⭐3,8)

Zyte (dawniej Scrapinghub) jest znaną marką w branży.

Ich API Zyte to potężne, kompleksowe rozwiązanie. Doskonale radzi sobie z obsługą dynamicznych stron internetowych i renderowaniem JavaScript.

Zarządzają całą infrastrukturą, dzięki czemu możesz skupić się wyłącznie na danych.

To solidna i niezawodna sieć narzędzie do skrobania dla każdego projektu.

Nasze podejście

Uzyskaj najbardziej niezawodną sieć dane z API Zyte. Osiągnij 99,99% dokładności danych w swoich projektach dzięki temu wysokiej jakości API do scrapowania stron internetowych i usprawnij proces ekstrakcji danych już dziś.

Kluczowe korzyści

- Automatyczne odblokowywanie: Przestań żonglować serwerami proxy; Zyte API to potężne, zautomatyzowane narzędzie do obsługi banów.

- Bezproblemowa integracja ze Scrapy: Jeśli jesteś programistą korzystającym z frameworka Scrapy, Zyte będzie dla Ciebie idealnym rozwiązaniem.

- Ekstrakcja danych wspomagana sztuczną inteligencją: Narzędzie może automatycznie identyfikować i analizować dane, zmniejszając potrzebę ręcznego stosowania reguł analizy.

- Zintegrowana przeglądarka bez interfejsu: Nie ma potrzeby korzystania z przeglądarek bezgłowych innych firm, ponieważ Zyte udostępnia przeglądarkę zoptymalizowaną pod kątem scrapowania stron internetowych na dużą skalę.

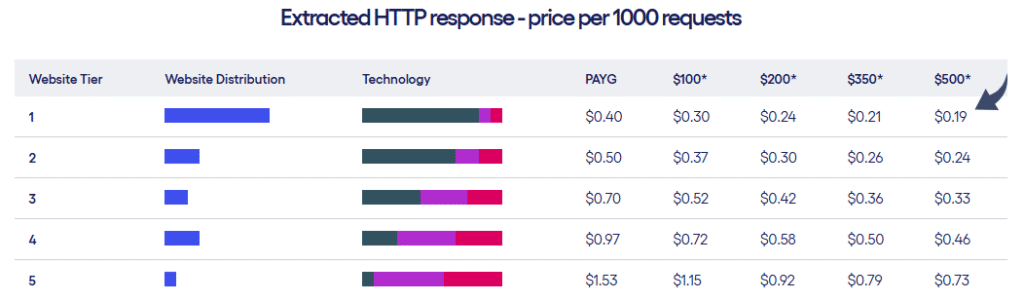

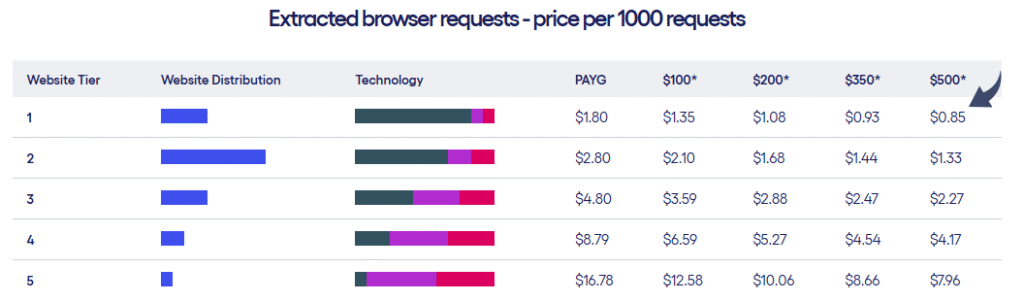

Wycena

- Zyte oferuje dwa rodzaje planów cenowych w zależności od poziomu witryn i liczby żądań.

Zalety

Wady

5. Twórcy scrapowania (⭐3.5)

Scrape Creators to specjalistyczne narzędzie.

Koncentruje się na zbieraniu danych z media społecznościowe platformy.

Potrzebuję uzyskać informacje od YouTube, Facebook czy TikTok?

To jest narzędzie dla Ciebie.

Dane dostarczane są w postaci uporządkowanych i gotowych do użycia danych w formacie JSON.

Nasze podejście

Nie musisz już męczyć się ze zbieraniem danych z mediów społecznościowych. Dzięki Scrape Creators uzyskasz dane w czasie rzeczywistym z platform takich jak Twitch i Pinterest. Dołącz do setek użytkowników, którzy zebrali ponad 6 milionów zapytań i uzyskaj potrzebne Ci informacje.

Kluczowe korzyści

- Specjalistyczne interfejsy API: Oferuje gotowe rozwiązania przeznaczone specjalnie dla platform mediów społecznościowych.

- Nie potrzeba kluczy API: Możesz ominąć konieczność posiadania oficjalnych kluczy API w przypadku witryn takich jak Twitch.

- Płać za zużycie: Płacisz tylko za to, z czego korzystasz, a Twoje środki nigdy nie wygasają.

- Bogate dane JSON: Interfejsy API udostępniają czyste i ustrukturyzowane dane JSON, dzięki czemu nie musisz wykonywać dodatkowego przetwarzania.

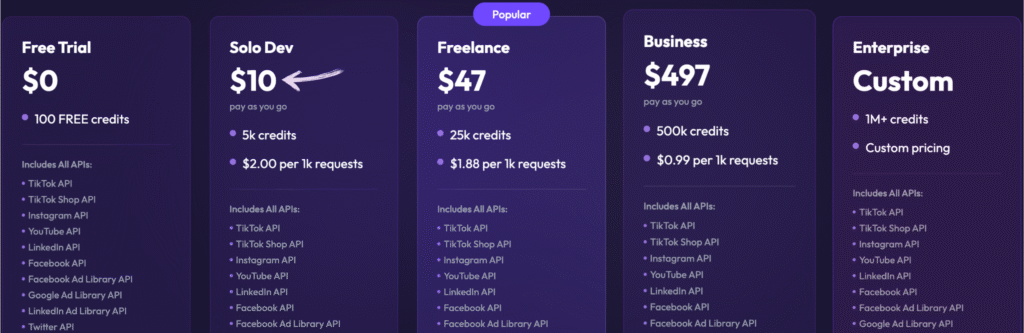

Wycena

- Bezpłatny okres próbny: 0, 100 darmowych kredytów.

- Solo Dev: 10 USD – Płać w miarę użytkowania, 5 tys. kredytów.

- Pracownik nieetatowy: 47 USD – Płać w miarę użytkowania, 25 tys. kredytów.

- Biznes: 497 USD – Płać w miarę użytkowania, 500 tys. kredytów.

- Przedsiębiorstwo: Cena niestandardowa, ponad 1 mln kredytów.

Zalety

Wady

6. Sztuczna inteligencja ScrapeGraph (⭐3.2)

To narzędzie jest przeznaczone dla programistów kochających sztuczną inteligencję. ScrapeGraph AI to biblioteka Pythona o otwartym kodzie źródłowym.

Wykorzystuje duże modele językowe (LLM) do tworzenia procesów scrapowania.

Powiedz mu, czego chcesz, a on zbuduje dla ciebie narzędzie do skrobania.

To narzędzie jest wyjątkowe ze względu na sposób, w jaki radzi sobie z wyodrębnianiem danych za pomocą prostego polecenia.

Nasze podejście

Wiodący specjaliści (ponad 350 osób) zaufali ScrapeGraphAI ze względu na jego solidne, oparte na sztucznej inteligencji możliwości scrapowania stron internetowych. Zapewnij sobie 20% wzrost wydajności na kolejne 48 godzin.

Kluczowe korzyści

- Scraping języka naturalnego: Możesz wskazać mu, co ma wyodrębnić, używając prostych, zrozumiałych dla człowieka monitów.

- Biblioteka Open Source: Deweloperzy mogą wykorzystać jego wszechstronną bibliotekę typu open-source, aby uzyskać maksymalną kontrolę.

- Funkcja Markdownify: Potrafi konwertować całe strony internetowe na przejrzyste, czytelne dokumenty Markdown.

- Agentic Scraper: Sztuczna inteligencja potrafi autonomicznie poruszać się po stronach internetowych i wchodzić z nimi w interakcje, wykonując złożone, wieloetapowe zadania.

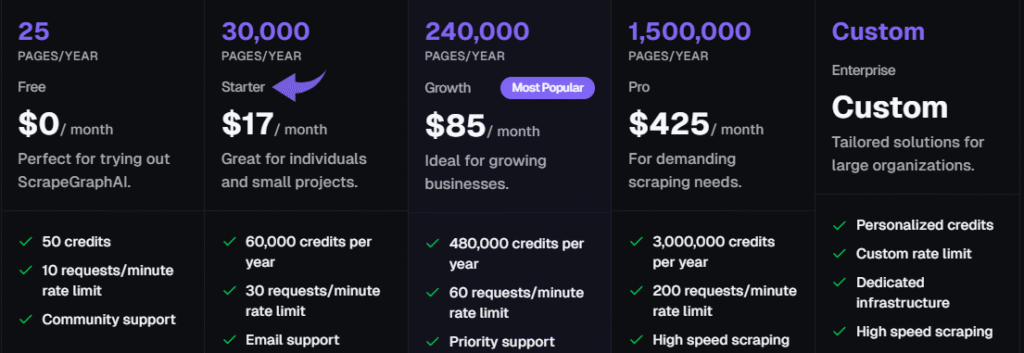

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: 0 zł/miesiąc.

- Rozrusznik: 17 USD/miesiąc.

- Wzrost: 85 USD/miesiąc.

- Zawodowiec: 425 USD/miesiąc.

- Przedsiębiorstwo: Indywidualne ceny.

Zalety

Wady

7. ThorData (⭐3.0)

ThorData to kompleksowa platforma proxy i scrapingu.

Rozwiązanie to jest przeznaczone dla zespołów, które potrzebują czystych i niezawodnych danych na dużą skalę.

Dysponują ogromną siecią serwerów proxy i uniwersalnym interfejsem API do scrapowania.

Jest to jeden z najsolidniejszych interfejsów API do scrapowania stron internetowych na rynku.

Nasze podejście

Ciesz się niezrównanym bezpieczeństwem dzięki ThorData. To dane Proces weryfikacji gwarantuje 99,7% skuteczności. Dzięki całodobowemu wsparciu na żywo i średniemu czasowi reakcji poniżej 3 minut możesz być pewien jakości połączenia. Uzyskaj ponad 60 milionów adresów IP i zabezpiecz swoje dane.

Kluczowe korzyści

- Ogromna pula adresów IP: Oferuje ponad 60 milionów etycznie pozyskanych adresów IP.

- Wysoka anonimowość: Zapewnia, że Twoja aktywność scrapowania pozostanie niewykryta dzięki wysokiej jakości serwerom proxy.

- Płać za zużycie: Rozliczenia są przejrzyste: płacisz tylko za wykorzystany ruch, a nie za nieudane żądania.

- Wbudowany skrobak: Zawiera narzędzie do scrapowania stron internetowych bez kodu i uniwersalny interfejs API, dzięki czemu nie potrzebujesz osobnego narzędzia do prostych projektów.

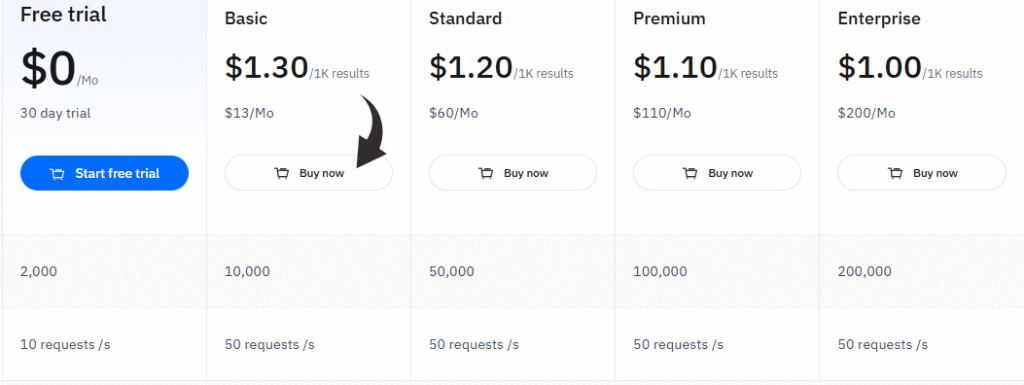

Wycena

- Bezpłatny okres próbny: 0 USD/miesiąc, 30-dniowy okres próbny.

- Podstawowy: 13 USD/miesiąc.

- Standard: 60 USD/miesiąc.

- Premia: 110 USD/miesiąc.

- Przedsiębiorstwo: 200 dolarów miesięcznie.

Zalety

Wady

Przewodnik kupującego

Przeprowadziliśmy szczegółowy przegląd każdego narzędzia do scrapowania stron internetowych, zwracając uwagę na kilka kluczowych czynników.

Naszym celem było pomóc Ci znaleźć rozwiązanie, które najlepiej odpowiada Twoim potrzebom, niezależnie od tego, czy jesteś programistą, analitykiem danych, czy specjalistą ds. marketingu.

Oto szczegółowy opis naszego procesu badawczego:

- Wycena: Przeanalizowaliśmy koszt podstawowego planu każdego produktu i jego funkcji premium. Obejmowało to sprawdzenie liczby wywołań API, kredytów API i żądań, które otrzymujesz za swoje pieniądze. Sprawdziliśmy również opcje nieograniczonej przepustowości.

- Cechy: Przyjrzeliśmy się podstawowym funkcjom każdej usługi. Skupiliśmy się na kluczowych funkcjach, takich jak renderowanie JavaScript, obsługa przeglądarki headless, automatyczna rotacja adresów IP i solidne zabezpieczenia anty-botowe. Oceniliśmy również ich zdolność do wyodrębniania danych strukturalnych, obsługi dynamicznej zawartości i wykonywania specjalistycznych zadań, takich jak scrapowanie SERP.

- Wydajność: Oceniliśmy, jak dobrze każde narzędzie do scrapowania stron internetowych sprawdza się w praktyce. Obejmowało to sprawdzenie wskaźników sukcesu w przypadku prób scrapowania stron internetowych, które korzystają z omijania zabezpieczeń anty-bot. Przyjrzeliśmy się również temu, jak radzą sobie z typowymi problemami, takimi jak problemy z JavaScriptem i wolne serwery proxy. Sprawdziliśmy dostępność serwerów proxy premium i mobilnych.

- Negatywy: Żadne narzędzie nie jest idealne. Zidentyfikowaliśmy główne wady każdej usługi, takie jak potencjalne blokady IP, bany IP czy skomplikowany interfejs użytkownika. Zwróciliśmy również uwagę na to, czy usługa ma problemy z zarządzaniem serwerami proxy, obsługą żądań API lub obsługą powolnych serwerów proxy.

- Wsparcie i społeczność: Zbadaliśmy poziom oferowanego wsparcia. Szukaliśmy dedykowanego wsparcia, przejrzystej dokumentacji oraz możliwości zwrotu pieniędzy. Dobra społeczność i system wsparcia są kluczowe dla rozwiązywania problemów z zadaniami scrapowania i optymalnego wykorzystania kluczy API.

- Przydatność przypadku użycia: Na koniec zastanowiliśmy się, dla jakiego typu użytkownika lub projektu dane narzędzie jest najlepsze. Oceniliśmy ich mocne strony w kontekście konkretnych zadań, takich jak scrapowanie stron konkurencji czy obsługa stron z dużą ilością kodu JavaScript, a także w kontekście konkretnych zastosowań, takich jak gromadzenie danych z sieci. Pomogło nam to określić, która usługa najlepiej odpowiada różnym potrzebom.

- Zaawansowane zarządzanie serwerami proxy: Skoncentrowaliśmy się na narzędziach oferujących zaawansowane funkcje zarządzania proxy. Obejmuje to usługi dedykowanego dostawcy proxy, który oferuje automatyczną rotację proxy. Jest to kluczowe dla zapewnienia niezawodnego pobierania danych z różnych stron docelowych bez blokowania lub oznaczania ich flagą.

- Różnorodne możliwości scrapowania: Przyjrzeliśmy się, jak każde narzędzie radzi sobie z różnymi potrzebami scrapowania. Obejmowało to ocenę wykorzystania przez nie różnorodnych serwerów proxy do różnych typów scrapowania. Możliwość przełączania się między metodami rotacji serwerów proxy i szerokiej gamy serwerów proxy jest niezbędna w przypadku złożonych witryn docelowych.

Podsumowanie

Wybór odpowiedniego narzędzia do scrapowania stron internetowych może być trudny, ale teraz znasz już fakty.

Od rotacyjnych serwerów proxy po rozwiązywanie captcha, każda usługa ma swoje mocne strony.

Niektóre oferują bezpłatną wersję na początek, podczas gdy inne mają solidne płatne plany dla dużych projektów.

Wybór odpowiedniego narzędzia zależy od Twoich celów, niezależnie od tego, czy jesteś programistą, czy członkiem zespołu marketingowego zajmującego się analizą konkurencji.

Dzięki zrozumieniu różnych modeli cenowych i tego, jak używać konkretnego języka programowania z narzędziem, możesz dokonać właściwego wyboru dla swojego kolejnego projektu.

Wszystko sprowadza się do znalezienia najlepszego dopasowania do Twoich konkretnych potrzeb i docelowego adresu URL, z którym pracujesz.

Często zadawane pytania

Czy narzędzia do scrapowania stron internetowych sprawdzają się w przypadku witryn e-commerce?

Tak, wiele narzędzi doskonale sprawdza się w e-commerce, umożliwiając firmom gromadzenie informacji o konkurencji. Z łatwością radzą sobie z dynamicznymi cenami i danymi o produktach na popularnych stronach internetowych.

Czy mogę otrzymać dane w różnych formatach?

Tak, większość nowoczesnych narzędzi pozwala na pobieranie zebranych danych w różnych formatach, takich jak JSON, CSV i Excel, co ułatwia ich integrację z istniejącymi przepływami pracy.

Czy te narzędzia mają wbudowany harmonogram?

Wiele usług scrapowania zawiera wbudowaną funkcję harmonogramDzięki temu możesz zautomatyzować swoje potrzeby związane ze scrapowaniem i uruchamiać zadania o określonych porach bez konieczności ręcznego wprowadzania danych, oszczędzając w ten sposób swój czas.

Czy da się pozyskać numery telefonów?

Tak, przy odpowiednim, solidnym wyborze narzędzia, możesz zacząć zbierać konkretne dane, takie jak numery telefonów. Narzędzia te wykorzystują różne metody wyszukiwania i ekstrakcji tych informacji.

Czym jest przeglądarka Chrome bez interfejsu graficznego?

Przeglądarka Chrome w trybie headless działa bez interfejsu wizualnego. To solidny wybór do scrapowania stron internetowych, ponieważ potrafi renderować JavaScript i wchodzić w interakcję z dynamiczną treścią, tak jak zwykły użytkownik.