Es ist 2025, und Sie brauchen Daten.

Das Kopieren und Einfügen von Informationen von Hunderten von Webseiten ist mühsam.

Es ist Zeitverschwendung und führt immer zu Fehlern. Kommt Ihnen das bekannt vor?

Das ist das Problem, mit dem viele konfrontiert sind, wenn sie schnell und sauber etwas brauchen. Daten.

Sie wünschen sich ein Tool, das einfach und schnell ist und für das Sie kein Programmiergenie sein müssen.

In diesem Webscraper IO-Testbericht schauen wir uns diese Chrome-Erweiterung und den Cloud-Dienst genauer an, um herauszufinden, ob sie die Lösung sind.

Lesen Sie weiter, um herauszufinden, ob dieses Tool Sie dieses Jahr wirklich zum Data-Scraping-Profi machen kann.

Möchten Sie monatlich über 50 Stunden bei der manuellen Dateneingabe sparen? Klicken Sie hier, um mit Webscraper durchzustarten und sich noch heute über 800.000 anderen Nutzern anzuschließen!

Was ist ein Webscraper?

Einfach ausgedrückt: Webscraper ist ein Werkzeug zum Auslesen von Webseiten.

Es hilft Ihnen dabei, Daten automatisch von Webseiten zu extrahieren.

Man kann es sich wie einen intelligenten Roboter vorstellen, der eine Webseite liest und die benötigten Informationen herausfiltert.

Es existiert hauptsächlich als kostenlose Chrome-Browsererweiterung.

Dadurch ist es kinderleicht zu bedienen. Das Tool verfügt über eine Point-and-Click-Oberfläche.

Das bedeutet, dass Sie keinen Code schreiben müssen, um einen Scraper zu erstellen.

Sie klicken auf die Teile der Seite, die Sie erfassen möchten.

Für größere, schnellere Aufträge bieten sie außerdem einen kostenpflichtigen Service namens Web Scraper Cloud an.

Dies ermöglicht es Ihnen, mehrere Scraping-Aufgaben gleichzeitig auszuführen.

Nachdem Sie die Daten extrahiert haben, können Sie sie schnell herunterladen.

Eine beliebte Option ist es, die Informationen direkt in Google Sheets oder eine Excel-Datei zu senden.

Wer hat Webscraper entwickelt?

Das Web-Scraping-Tool wurde 2013 als kostenlose Chrome-Erweiterung entwickelt.

Es wurde von einem Unternehmen namens Web Graph SIA in Lettland hergestellt.

Kein einzelner Gründer wird öffentlich als Schöpfer genannt.

Ihr Hauptziel ist es, die genaue Datenextraktion für alle zugänglich zu machen.

Sie wollen die fortschrittlichste und einfachste Möglichkeit zur individuellen Anpassung der Datenextraktion bieten.

Dies hilft Ihnen, schnell die benötigten Daten zu erfassen und zu exportieren.

Sie bieten auch maßgeschneiderte Web-Scraping-Dienste für größere Projekte an.

So kann jeder zum Datenexperten werden!

Die wichtigsten Vorteile von Webscraper

Warum nutzen so viele Menschen dieses Tool zur Datenerfassung?

Webscraper bietet eine umfassende Liste von Funktionen, die das Data Scraping einfach und effektiv machen.

Diese Vorteile machen es für viele Nutzer zu einer enormen Zeitersparnis:

- Zum Starten sind keine Programmierkenntnisse erforderlich.Das Hauptmerkmal ist die benutzerfreundliche Oberfläche. Dank der einfachen Point-and-Click-Funktionalität können Sie sofort mit dem Web-Scraping beginnen. Das ist besonders vorteilhaft, da keine komplexen Programmierkenntnisse erforderlich sind. So sparen Sie Zeit und umgehen die oft steile Lernkurve anderer Tools.

- Kompatibel mit modernen WebsitesEs wurde speziell für JavaScript-basierte und dynamische Websites entwickelt. Dies ist ein entscheidender Vorteil, da viele Websites heutzutage JavaScript und AJAX-Anfragen zum Laden von Inhalten verwenden. Die JavaScript-Verarbeitung des Tools stellt sicher, dass Sie alle Website-Inhalte erhalten, selbst auf dynamischen Seiten mit unendlichem Scrollen.

- Extrahiert Daten aus komplexen StrukturenSie können Sitemaps ganz einfach einrichten, um mehrere Ebenen einer Website zu durchsuchen und so eine umfassende Datenextraktion zu ermöglichen. Dadurch können Sie Daten von komplexen Websites extrahieren und unterschiedliche Website-Strukturen problemlos verarbeiten, selbst bei großen Websites.

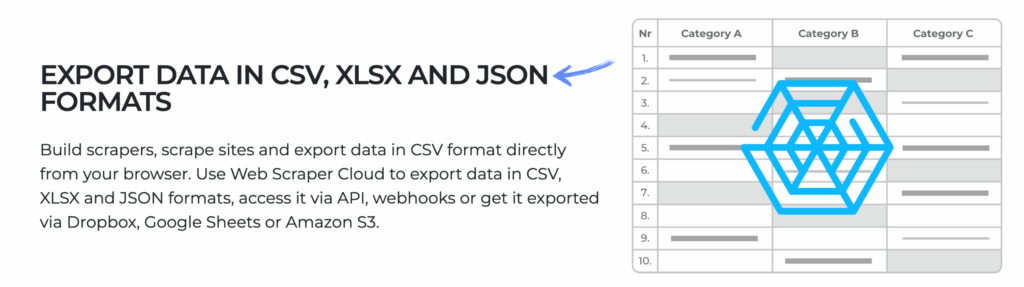

- Flexible DatenausgabeNachdem Sie die Daten extrahiert haben, müssen Sie sie nutzen. Webscraper ermöglicht es Nutzern, Daten einfach zu exportieren. Sie können die Informationen in Formaten wie CSV, XLSX und JSON herunterladen, die sich problemlos in anderen Systemen für Marketing oder Analysen verwenden lassen.

- Ideal für spezielle AnwendungsfälleDas Tool eignet sich perfekt für Aufgaben wie Marktforschung zur Verfolgung von Trends, Preisüberwachung bei Wettbewerbern und Leadgenerierung zum Sammeln von Details wie Telefonnummern oder anderen Produktdetails aus Immobilienanzeigen oder anderen Websites.

- Erweiterte Funktionen für Skalierung (Cloud)Die kostenpflichtige Cloud-Version bietet erweiterte Funktionen, darunter eine Proxy-Integration für umfangreiche Web-Scraping-Aufträge. Dadurch wird verhindert, dass Ihr Browser beim Abrufen großer Datenmengen von dynamischen Websites blockiert wird.

- Einfache Einrichtung und VerwendungAls Browsererweiterung ermöglicht sie das Web-Scraping mit wenigen Klicks. Per Mausklick wählen Sie Elemente aus und definieren Selektorpfade mithilfe von CSS-Selektoren. So kann jeder, ob Entwickler oder Laie, problemlos Daten erfassen. Text, Links und Bilder.

Beste Eigenschaften

Webscraper verfügt über einige großartige und einzigartige Tools, die es von anderen Scrapern abheben.

Es arbeitet hart, damit Sie es nicht müssen.

Diese Hauptmerkmale sind der Grund, warum Menschen es nutzen, um Informationen aus dem Internet abzurufen.

Werfen wir einen Blick auf die fünf wichtigsten Stärken dieses Produkts.

1. Point-and-Click-Oberfläche

Das ist eine der besten Eigenschaften. Es bedeutet, dass Sie keine Programmierkenntnisse benötigen.

Sie verwenden einfach Ihre Maus, um auf die gewünschten Teile der Webseite zu zeigen und zu klicken.

Wenn Sie beispielsweise die Produktnamen sehen möchten, klicken Sie einfach auf die Produktnamen.

Das Tool findet heraus, wie es sie für Sie abrufen kann.

Dank dieser benutzerfreundlichen Oberfläche können Sie sofort mit Ihrem ersten Job beginnen.

2. Daten extrahieren

Das Hauptziel dieses Tools ist die Datenextraktion.

Es nimmt die Informationen, auf die Sie geklickt haben, und ruft sie von der Webseite ab.

Es kann Texte, Links, Bilder und mehr erfassen.

Dadurch sparen Sie jede Menge Zeit, die Sie sonst mit Kopieren und Einfügen verbringen würden.

Es ermöglicht eine schnelle und einfache Datenerfassung.

3. Umgang mit JavaScript-Websites

Viele moderne Websites verwenden etwas namens JavaScript, um Inhalte zu laden.

Das kann einfache Web-Scraper blockieren. Glücklicherweise kann Webscraper problemlos mit JavaScript-Websites umgehen.

Das bedeutet, dass es auch von dynamischen Webseiten, die endlos scrollen, noch Informationen erfassen kann, wie zum Beispiel soziale Medien Futter.

Dies ermöglicht Ihnen den Zugriff auf Daten, die mit vielen anderen Tools nicht erreichbar sind.

4. Daten anpassen

Möglicherweise benötigen Sie nicht alles auf einer Seite.

Mit Webscraper können Sie Daten vor dem Herunterladen anpassen.

Sie können dem Tool genau sagen, welche Teile beibehalten und welche ignoriert werden sollen.

Dies hilft Ihnen auch dabei, spezielle „Regeln“ für das Crawling der Website durch das Tool festzulegen.

Sie können sicherstellen, dass Sie nur die spezifischen und genauen Daten erhalten, die Sie benötigen.

5. Daten exportieren

Sobald das Tool das Scraping abgeschlossen hat, müssen Sie die Daten verwenden!

Mit Webscraper können Sie Daten schnell exportieren.

Sie können Ihre gesammelten Informationen in gängigen Dateiformaten herunterladen.

Dazu gehören CSV- und XLSX-Dateien, die sich hervorragend für Tabellenkalkulationen eignen.

Sie können es auch im JSON-Format zur Verwendung in anderen Systemen erhalten.

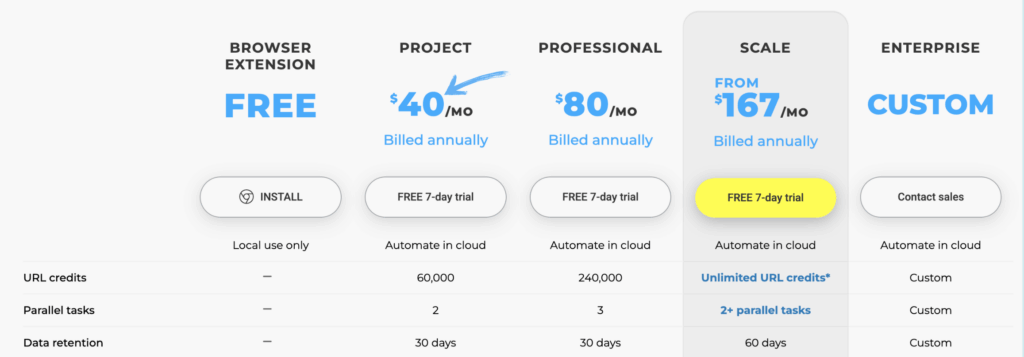

Preisgestaltung

| Planen | Preis |

| Frei | Frei |

| Projekt | 40 $/Monat |

| Professional | $80/month |

| Skala | 167 $/Monat |

| Unternehmen | Brauch |

Für und Wider

Vorteile

Nachteile

Webscraper-Alternativen

Falls Webscraper nicht das Richtige für Ihr Projekt zu sein scheint, stehen Ihnen andere hervorragende Tools zur Verfügung.

Einige eignen sich besser für große Projekte, andere sind benutzerfreundlicher für Anfänger.

Here are a few popular alternatives to consider:

- Octoparse: Dies ist eine leistungsstarke Desktop-Anwendung mit visuellem Editor. Sie eignet sich ideal für Anwender, die Web-Scraping ohne Programmierung nutzen möchten, aber für umfangreiche Projekte Cloud-Extraktionsdienste benötigen. Zudem bietet sie vorgefertigte Vorlagen für gängige Websites.

- ParseHub: Wie Webscraper bietet auch dieses Tool eine intuitive Benutzeroberfläche. Es eignet sich hervorragend für die Bearbeitung komplexer, dynamischer Websites und ist als Download-Anwendung verfügbar. Zudem bietet es einen umfangreichen kostenlosen Tarif.

- Scrapy: Dies ist ein Python-Framework für Entwickler. Es ist Open Source und äußerst flexibel, was es zur ersten Wahl für komplexe, umfangreiche Projekte macht, insbesondere für diejenigen mit Programmierkenntnissen.

- Apify: Dies ist eine Cloud-Plattform mit einer Bibliothek von über tausend vorgefertigten Scraping-Tools (sogenannten „Actors“). Sie ist ideal für Entwickler, die skalierbare, cloudbasierte Lösungen suchen. Automatisierung.

Persönliche Erfahrung

Unser Team hatte eine große Aufgabe.

Wir mussten die aktuellen Preise für Tausende von Produkten auf mehreren Seiten von drei Konkurrenzseiten zusammentragen.

Das von Hand zu machen, hätte uns eine ganze Woche gekostet.

Deshalb haben wir Webscraper verwendet.

Die Einrichtung des ersten Scrapers hat etwas Zeit in Anspruch genommen, aber die Dokumentation war hilfreich.

Wir haben gelernt, wie man den Sammelprozess automatisiert.

Wir haben für jeden Mitbewerber eine Sitemap erstellt, die unseren spezifischen Bedürfnissen entspricht.

Das Tool lief dann unauffällig im Hintergrund und ermittelte alle notwendigen Zahlen.

Wir haben über 40 Stunden manuelle Arbeit eingespart!

So hat Webscraper unserem Team geholfen:

- Zeitersparnis: Wir haben eine einwöchige Aufgabe in nur einen Nachmittag Aufbauzeit verwandelt.

- Einfache Einrichtung: Das Point-and-Click-Tool machte es einfach, den Scraping-Plan zu erstellen.

- Eingesammelte Preise: Wir haben präzise Preisdaten von mehreren Seiten direkt in eine Tabellenkalkulation extrahiert.

- Verwendete Dokumentation: Die Hilfehandbücher lieferten uns genaue Anweisungen, wie wir den gesamten Vorgang automatisieren konnten.

- Erfüllte Bedürfnisse: Wir haben die Sitemaps so angepasst, dass wir genau die Daten erhalten, die für unsere spezifischen Bedürfnisse erforderlich sind.

Schlussbetrachtung

Das Webscraper-Tool ist eine leistungsstarke Option zum Extrahieren von Daten.

Es eignet sich hervorragend für Leute, die nicht programmieren können.

Die Point-and-Click-Oberfläche macht die Bedienung einfach.

Es bewältigt anspruchsvolle JavaScript-Websites, an denen andere Tools scheitern.

Die kostenlose Erweiterung ist zwar sehr gut, aber man sollte sich darüber im Klaren sein, dass man einige grundlegende Kenntnisse über Webstrukturen benötigt.

Wenn Sie die Datenerfassung automatisieren müssen, ohne Code schreiben zu müssen, ist dies im Jahr 2025 eine Top-Wahl.

Sind Sie bereit, das manuelle Kopieren einzustellen?

Beginnen Sie noch heute mit dem Scrapen wertvoller Daten!

Häufig gestellte Fragen

Ist Webscraper sicher für meinen Computer?

Ja, die Browsererweiterung gilt als sicher. Sie sammelt weder Daten von Webseiten noch Ihre persönlichen Daten für eigene Zwecke.

Ist die Nutzung von Webscrapern zur Datenerhebung legal?

Die Rechtmäßigkeit von Web-Scraping hängt von den Nutzungsbedingungen bzw. Regeln der jeweiligen Website ab. Lesen Sie die Nutzungsbedingungen der Website stets sorgfältig durch und verzichten Sie darauf, private oder sensible Daten zu sammeln.

Worin unterscheidet sich die kostenlose Chrome-Erweiterung von den kostenpflichtigen Cloud-Plänen?

Die kostenlose Erweiterung läuft in Ihrem Browser und eignet sich gut für kleinere Aufgaben. Die kostenpflichtigen Cloud-Tarife bieten höhere Geschwindigkeit, geplante Aufträge und mehr Kapazität für die Extraktion großer Datenmengen.

Was passiert, wenn die Website ihr Layout ändert?

Ändert sich die Struktur der Website, kann die von Ihnen erstellte Sitemap oder der Scraping-Plan fehlerhaft werden. Sie müssen die Selektoren über die Benutzeroberfläche aktualisieren.

Kann Webscraper auch Webseiten verarbeiten, die eine Anmeldung erfordern?

Ja, das ist möglich. Oft müssen Sie sich zuerst manuell auf der Website anmelden. Anschließend können Sie den Scraping-Prozess auf der Seite starten, die nach der Anmeldung erscheint.