Sind Sie Entwickler, Datenanalyst oder Vermarkter und haben genug von Web-Scraping-Problemen?

Das ist frustrierend und kann Ihre Projekte erheblich verlangsamen.

ScrapingBee ist ein großartiges Werkzeug.

Aber vielleicht sind Sie einfach nur neugierig, was es sonst noch gibt.

Was wäre, wenn es ein Werkzeug gäbe, das machen Ihre Datenerfassung zuverlässiger?

Wir haben eine Liste der besten ScrapingBee-Alternativen zusammengestellt, damit Sie eine Lösung finden, die für Sie besser funktioniert.

Wenn Sie mit der Lektüre fertig sind, wissen Sie genau, welche Plattform Ihnen helfen kann.

Was sind die besten ScrapingBee-Alternativen?

Wenn Sie nach einer leistungsstarken Web-Scraping-API jenseits von ScrapingBee suchen, sind Sie hier richtig.

Vielleicht benötigen Sie eine bessere JavaScript-Wiedergabe oder eine zuverlässige Google-Such-API.

Unsere Liste der besten Webdatentools hilft Ihnen, die beste Lösung für Ihre Datenextraktionsprozesse zu finden.

Lassen Sie uns die Top-Auswahl erkunden.

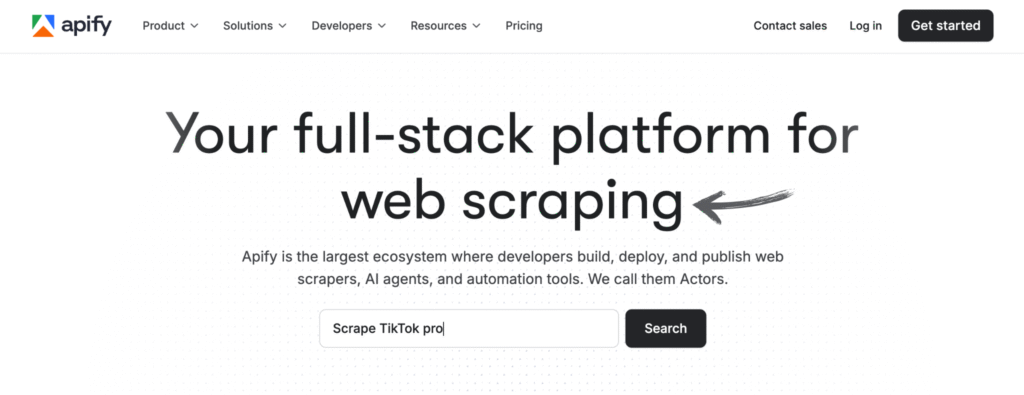

1. Apify (⭐4,8)

Apify ist nicht nur ein Tool. Es ist eine komplette Plattform für Web Scraping und Automatisierung.

Stellen Sie es sich als ein Cloud-basiertes Betriebssystem für Daten vor.

Es verfügt über eine riesige Bibliothek vorgefertigter Akteure, bei denen es sich im Grunde um gebrauchsfertige Scraper handelt.

Sie können sich eins schnappen und in wenigen Minuten mit dem Schaben beginnen. Es erledigt die harten Sachen, sodass Sie das nicht tun müssen.

Es ist eine ausgezeichnete Wahl für alle, die sich auf die umfassende Erfassung von Webdaten konzentrieren.

Unsere Meinung

Möchten Sie sich selbst von der Leistungsfähigkeit von Apify überzeugen? Unsere Plattform wurde genutzt, um in einem einzigen Monat über 2,5 Millionen Webseiten zu scrapen und mehr als 500 TB Daten zu verarbeiten. Bereit, loszulegen?

Hauptvorteile

- Riesiger Marktplatz: Der Apify Store verfügt über mehr als 5.000 gebrauchsfertige Scraper und Automatisierungstools, sogenannte Actors.

- Ultimative Skalierbarkeit: Es wurde für Aufgaben auf Unternehmensebene entwickelt und kann umfangreiche Crawls von Millionen von Seiten bewältigen.

- Entwicklerfreundlich: Bietet ein Open-Source-SDK und unterstützt benutzerdefinierten Code in Python und JavaScript.

- Erweiterte Planung: Automatisieren Sie Ihre Scraping-Aufgaben, sodass sie zu bestimmten Zeiten oder in bestimmten Intervallen ohne manuelle Arbeit ausgeführt werden.

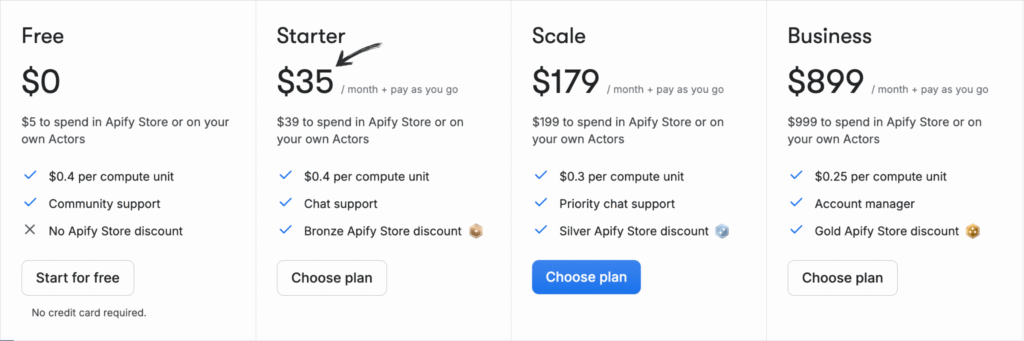

Preise

Alle Pläne werden jährliche Abrechnung.

- Frei: 0 $/Monat + Pay-As-You-Go.

- Anlasser: 35 $/Monat + Pay-As-You-Go.

- Skala: 179 $/Monat + Pay-As-You-Go.

- Geschäft: 899 $/Monat + Pay-As-You-Go.

Pros

Nachteile

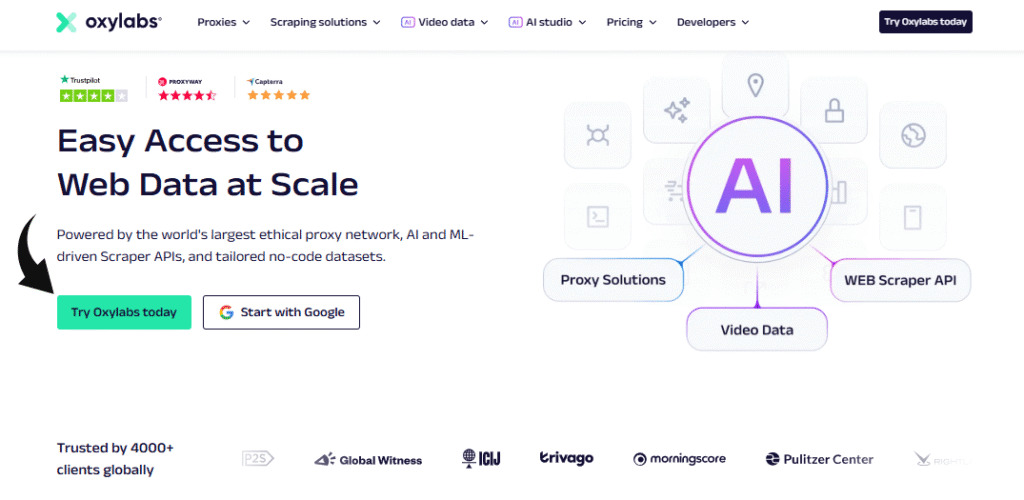

2. Oxylabs (⭐4,5)

Oxylabs ist für sein riesiges, hochwertiges Proxy-Netzwerk bekannt.

Es ist eine erstklassige Wahl für die ernsthafte Datenextraktion. Ihre Web Scraper API ist darauf ausgelegt, strenge Anti-Bot-Maßnahmen zu umgehen.

Sie haben sogar einen KI-gestützten Assistenten namens OxyCopilot, der Ihnen beim Generieren von Code hilft.

Es eignet sich hervorragend für große, komplexe Projekte und erleichtert das Extrahieren von Daten aus anspruchsvollen Websites.

Unsere Meinung

Entsperren Sie Daten mit einem führenden Proxy-Dienst. Mit über 175 Millionen Residential-Proxys, 2 Millionen dedizierten Datacenter-Proxys und 20 Millionen mobilen Proxys bietet Oxylabs Ihnen die IP-Adressen, die Sie für jedes Projekt benötigen.

Hauptvorteile

- OxyCopilot KI-Assistent: Mit diesem Tool können Sie Scraping-Anfragen in einfacher, natürlicher Sprache generieren.

- Riesiges Proxy-Netzwerk: Verfügt über einen der größten Proxy-Pools der Welt mit IPs aus 195 Ländern.

- Garantierter Erfolg: Das KI-gesteuerte Fingerprinting und die CAPTCHA-Umgehung der Plattform gewährleisten selbst auf den schwierigsten Websites eine hohe Erfolgsquote.

- Sicherheit auf Unternehmensniveau: Die Plattform ist nach ISO/IEC 27001:2022 zertifiziert und gewährleistet ein hohes Maß an Datensicherheit und Datenschutz.

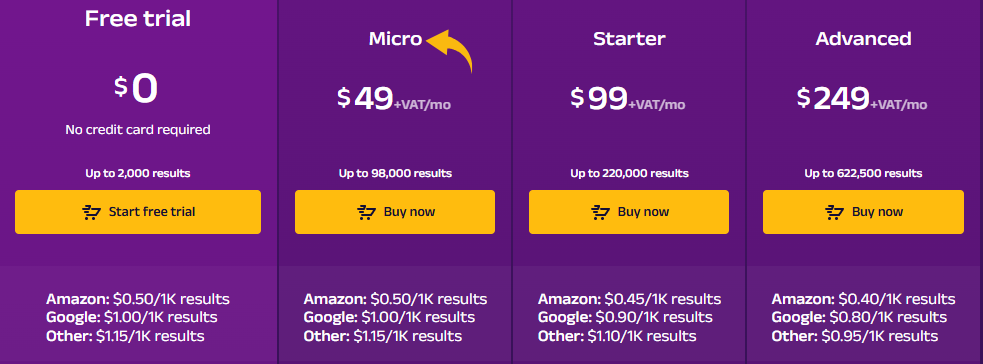

Preise

- Kostenlose Testversion: $0.

- Mikro: 49 $/Monat + MwSt.

- Anlasser: 99 $/Monat + MwSt.

- Fortschrittlich: 249 $/Monat + MwSt.

Pros

Nachteile

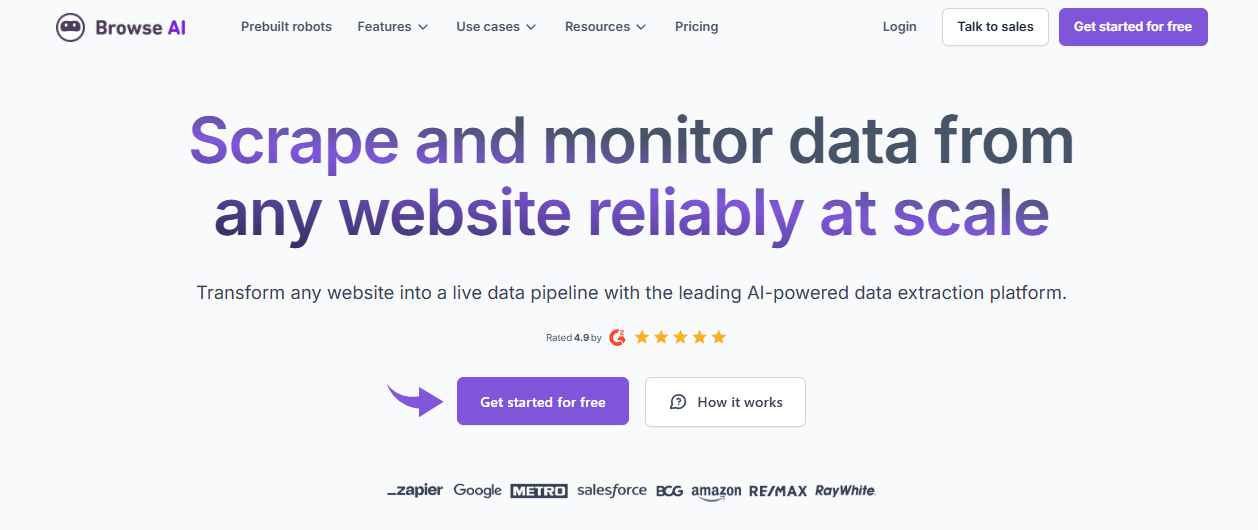

3. Durchsuchen Sie die KI (⭐4.0)

Suchen Sie nach einer No-Code-Lösung?

Browse AI ist die Antwort. Es wurde für Leute entwickelt, die keinen Code schreiben möchten.

Sie zeigen einfach auf die gewünschten Daten und klicken darauf.

Das Tool lernt, was es erfassen muss, und kann die Webseiten auf Änderungen überwachen.

Es ist super einfach zu verwenden und perfekt für Nicht-Entwickler.

Entfesseln Sie sein Potenzial mit unserem KI-Tutorial durchsuchen.

Unsere Meinung

Sparen Sie Zeit und erhalten Sie die Daten, die Sie benötigen? Browse AI kann Millionen von Websites verarbeiten. Sehen Sie, wie einfach Web Scraping sein kann.

Hauptvorteile

- Kein Code erforderlich: Über die Point-and-Click-Oberfläche kann jeder in wenigen Minuten einen Daten-Scraper erstellen.

- KI-gestützte Anpassungsfähigkeit: Das Tool passt sich automatisch an Änderungen im Layout einer Website an und stellt sicher, dass Ihre Daten immer konsistent sind.

- Über 7.000 Integrationen: Verbinden Sie Ihre Scraped-Daten ganz einfach mit Apps wie Google Sheets, Airtable und Zapier.

- Vorgefertigte Roboter: Greifen Sie auf eine Bibliothek vorgefertigter Roboter für gängige Aufgaben auf beliebten Websites zu und sparen Sie so noch mehr Zeit.

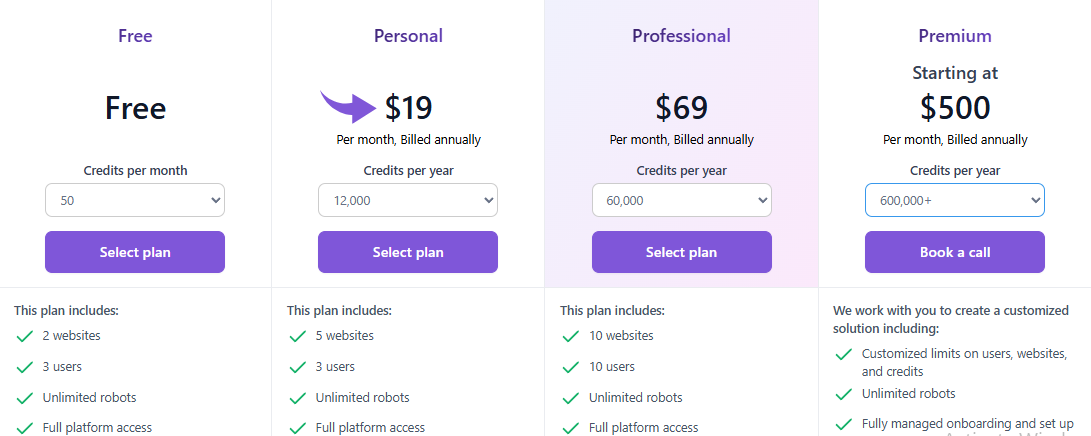

Preise

Alle Pläne werden jährliche Abrechnung.

- Frei: $0.

- Persönlich: 19 $/Monat.

- Professional: 69 $/Monat.

- Prämie: Ab 500 $/Monat.

Pros

Nachteile

4. Zyte (⭐3,8)

Zyte (ehemals Scrapinghub) ist ein etablierter Name in der Branche.

Ihre Zyte-API ist eine leistungsstarke Komplettlösung. Sie eignet sich hervorragend für die Verarbeitung dynamischer Websites und JavaScript-Rendering.

Sie verwalten die gesamte Infrastruktur, sodass Sie sich auf die Daten selbst konzentrieren können.

Es ist ein solides, zuverlässiges Web Schabwerkzeug für jedes Projekt.

Unsere Meinung

Holen Sie sich das zuverlässigste Web Daten mit der Zyte API. Erreichen Sie mit dieser hochwertigen Web-Scraping-API eine Datengenauigkeit von 99,99 % für Ihre Projekte und optimieren Sie noch heute Ihren Datenextraktionsprozess.

Hauptvorteile

- Automatische Entsperrung: Hören Sie auf, mit Proxys zu jonglieren. Die Zyte API ist ein leistungsstarkes automatisiertes Tool zur Handhabung von Sperren.

- Nahtlose Scrapy-Integration: Wenn Sie ein Entwickler sind, der das Scrapy-Framework verwendet, ist Zyte genau das Richtige für Sie.

- KI-gestützte Datenextraktion: Das Tool kann Daten automatisch identifizieren und analysieren, wodurch der Bedarf an manuellen Analyseregeln reduziert wird.

- Integrierter Headless-Browser: Sie benötigen keine Headless-Browser von Drittanbietern, da Zyte einen bereitstellt, der für Web Scraping im großen Maßstab optimiert ist.

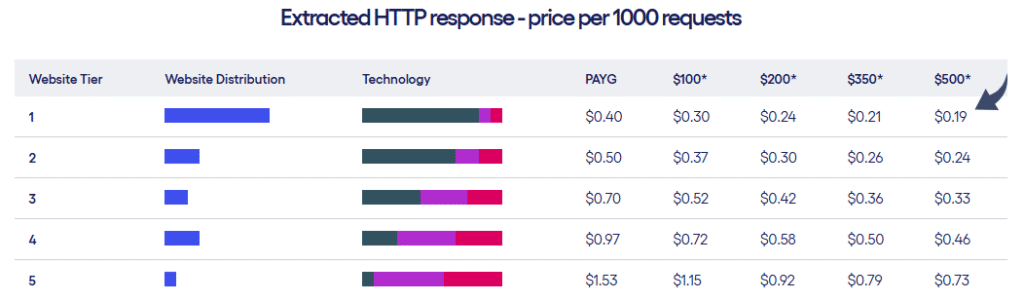

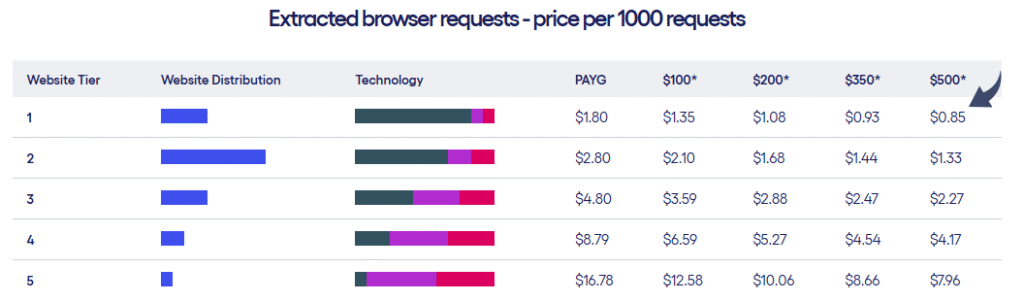

Preise

- Zyte bietet zwei Arten von Preisplänen basierend auf der Website-Stufe und der Anzahl Ihrer Anfragen.

Pros

Nachteile

5. Scrape Creators (⭐3,5)

Scrape Creators ist ein spezialisiertes Tool.

Der Schwerpunkt liegt auf dem Scraping von Daten aus sozialen Medien Plattformen.

Benötigen Sie Informationen von YouTube, Facebook oder TikTok?

Dies ist das richtige Werkzeug für Sie.

Die Daten werden als sauber strukturierte Daten im JSON-Format geliefert und sind für Sie sofort einsatzbereit.

Unsere Meinung

Sammeln Sie keine Social-Media-Daten mehr. Mit Scrape Creators erhalten Sie Echtzeitdaten von Plattformen wie Twitch und Pinterest. Schließen Sie sich Hunderten von Nutzern an, die bereits über 6 Millionen Anfragen gesammelt haben, und gewinnen Sie die nötigen Erkenntnisse.

Hauptvorteile

- Spezialisierte APIs: Bietet vorgefertigte Lösungen speziell für Social-Media-Plattformen.

- Keine API-Schlüssel erforderlich: Sie können die Notwendigkeit offizieller API-Schlüssel von Websites wie Twitch umgehen.

- Nutzungsentgelt: Sie zahlen nur für das, was Sie nutzen, und Ihr Guthaben verfällt nie.

- Umfangreiche JSON-Daten: Die APIs liefern saubere, strukturierte JSON-Daten, sodass Sie keine zusätzliche Analyse durchführen müssen.

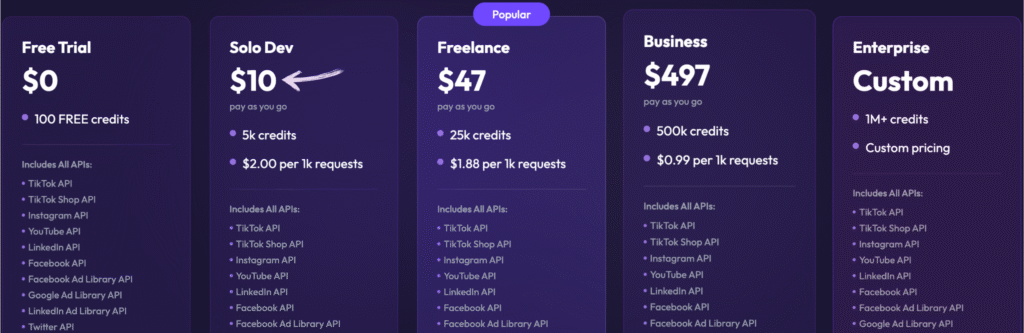

Preise

- Kostenlose Testversion: 0 $, 100 Credits gratis.

- Nur für Entwickler: 10 $ – Pay As You Go, 5.000 Credits.

- Freiberuflich: 47 $ – Pay As You Go, 25.000 Credits.

- Geschäft: 497 $ – Pay As You Go, 500.000 Credits.

- Unternehmen: $Individuelle Preise, 1 Mio.+ Guthaben.

Pros

Nachteile

6. ScrapeGraph AI (⭐3.2)

Dies ist für Entwickler, die KI lieben. ScrapeGraph AI ist eine Open-Source-Python-Bibliothek.

Es verwendet Large Language Models (LLMs), um Scraping-Pipelines zu erstellen.

Sie sagen ihm, was Sie wollen, und es baut den Scraper für Sie.

Dieses Tool ist einzigartig in der Art und Weise, wie es die Datenextraktion mit einer einfachen Eingabeaufforderung handhabt.

Unsere Meinung

Führende Experten (über 350) vertrauen ScrapeGraphAI aufgrund seiner robusten KI-gestützten Web-Scraping-Funktionen. Sichern Sie sich für die nächsten 48 Stunden ein Effizienz-Upgrade von 20 %.

Hauptvorteile

- Scraping natürlicher Sprache: Sie können ihm mithilfe einfacher, menschenähnlicher Eingabeaufforderungen mitteilen, was extrahiert werden soll.

- Open-Source-Bibliothek: Entwickler können die leistungsstarke Open-Source-Bibliothek für maximale Kontrolle nutzen.

- Markdownify-Funktion: Es kann ganze Webseiten in saubere, lesbare Markdown-Dokumente umwandeln.

- Agentischer Scraper: Die KI kann autonom durch Websites navigieren und mit ihnen interagieren, um komplexe Aufgaben mit mehreren Schritten zu erledigen.

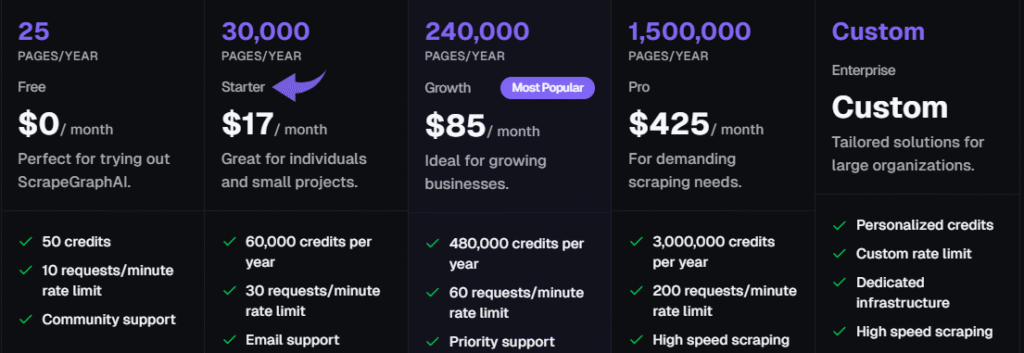

Preise

Alle Pläne werden jährliche Abrechnung.

- Frei: 0 $/Monat.

- Anlasser: 17 $/Monat.

- Wachstum: 85 $/Monat.

- Pro: 425 $/Monat.

- Unternehmen: Individuelle Preise.

Pros

Nachteile

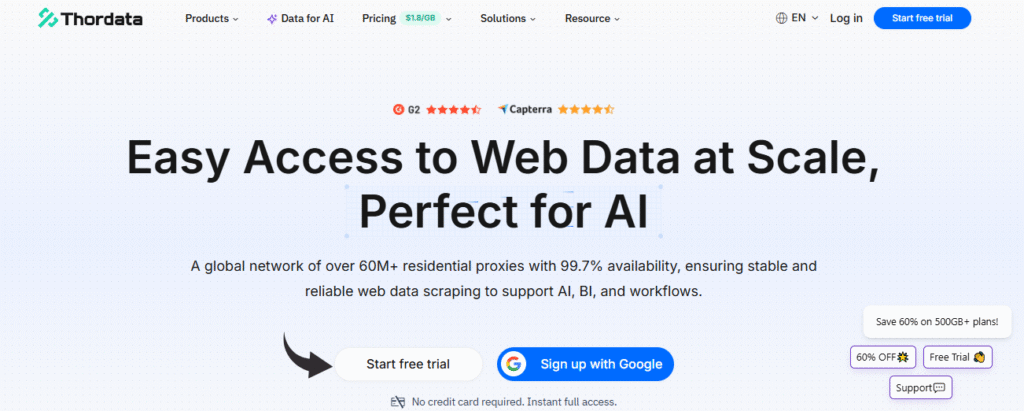

7. ThorData (⭐3.0)

ThorData ist eine voll funktionsfähige Proxy- und Scraping-Plattform.

Es wurde für Teams entwickelt, die saubere, zuverlässige Daten in großem Umfang benötigen.

Sie verfügen über ein riesiges Residential-Proxy-Netzwerk und eine Universal Scraping API.

Dies ist eine der robusteren Web-Scraping-APIs auf dem Markt.

Unsere Meinung

确信我们的清单是有帮助的。 Daten Der Verifizierungsprozess garantiert eine Erfolgsquote von 99,7 %. Mit 24/7-Live-Support und einer durchschnittlichen Antwortzeit von unter 3 Minuten können Sie sich auf die Verbindungsqualität verlassen. Sichern Sie sich über 60 Millionen IP-Adressen und sichern Sie Ihre Daten.

Hauptvorteile

- Riesiger IP-Pool: Bietet über 60 Millionen ethisch einwandfreie private IPs.

- Hohe Anonymität: Stellt mit seinen hochwertigen Proxys sicher, dass Ihre Scraping-Aktivitäten unentdeckt bleiben.

- Nutzungsentgelt: Die Abrechnung ist transparent; Sie zahlen nur für den von Ihnen genutzten Datenverkehr, nicht für fehlgeschlagene Anfragen.

- Eingebauter Schaber: Enthält einen No-Code-Web-Scraper und eine universelle API, sodass Sie für einfache Projekte kein separates Tool benötigen.

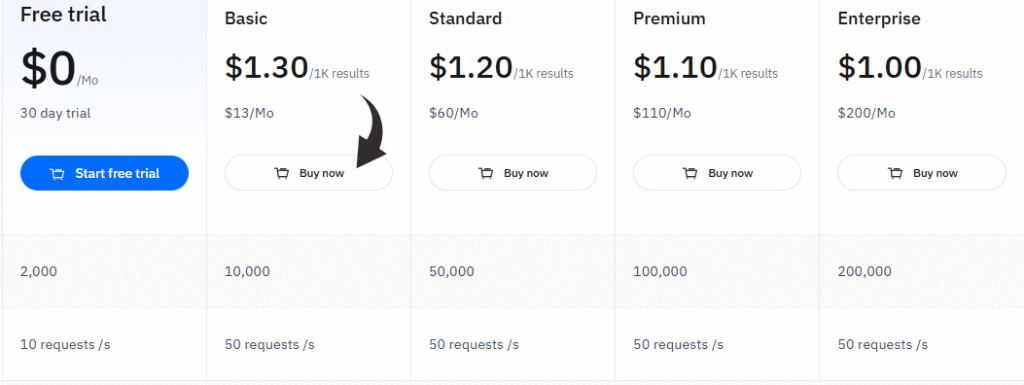

Preise

- Kostenlose Testversion: 0 $/Monat, 30 Tage Testversion.

- Basic: 13 $/Monat.

- Standard: 60 $/Monat.

- Prämie: 110 $/Monat.

- Unternehmen: 200 $/Monat.

Pros

Nachteile

Einkaufsführer

Wir haben jedes Web-Scraping-Tool einer gründlichen Überprüfung unterzogen und dabei mehrere Schlüsselfaktoren berücksichtigt.

Unser Ziel war es, Ihnen dabei zu helfen, eine Lösung zu finden, die Ihren Anforderungen am besten entspricht, unabhängig davon, ob Sie Entwickler, Datenanalyst oder Vermarkter sind.

Hier ist eine Aufschlüsselung unseres Forschungsprozesses:

- Preise: Wir haben die Kosten des Basispakets und der Premiumfunktionen jedes Produkts analysiert. Dabei haben wir unter anderem untersucht, wie viele API-Aufrufe, API-Guthaben und Anfragen Sie für Ihr Geld erhalten. Außerdem haben wir nach Optionen für unbegrenzte Bandbreite gesucht.

- Merkmale: Wir haben die Kernfunktionen jedes Dienstes genauer unter die Lupe genommen. Unser Fokus lag auf Schlüsselfunktionen wie JavaScript-Rendering, Headless-Browser-Unterstützung, automatischer IP-Rotation und robusten Anti-Bot-Maßnahmen. Außerdem haben wir die Fähigkeit der Dienste bewertet, strukturierte Daten zu extrahieren, dynamische Inhalte zu verarbeiten und spezielle Aufgaben wie SERP Scraping auszuführen.

- Leistung: Wir haben die Leistung der einzelnen Web-Scraping-Tools in der Praxis bewertet. Dabei haben wir die Erfolgsraten beim Scraping von Websites mit Anti-Bot-Bypassing geprüft. Außerdem haben wir untersucht, wie sie mit häufigen Herausforderungen wie JavaScript-Problemen und langsamen Proxys umgehen. Wir haben die Verfügbarkeit von Premium-Proxys und mobilen Proxys geprüft.

- Negative: Kein Tool ist perfekt. Wir haben die wichtigsten Nachteile jedes Dienstes identifiziert, wie z. B. mögliche IP-Sperren, IP-Banns oder eine komplexe Benutzeroberfläche. Wir haben auch festgestellt, ob ein Dienst Probleme mit der Verwaltung von Proxys, der Verarbeitung von API-Anfragen oder dem Umgang mit langsamen Proxys hatte.

- Support und Community: Wir haben den angebotenen Support untersucht. Wir haben auf engagierten Support, klare Dokumentation und eine Rückerstattungsrichtlinie geachtet. Eine gute Community und ein gutes Supportsystem sind entscheidend, um Probleme bei Scraping-Aufgaben zu lösen und Ihre API-Schlüssel optimal zu nutzen.

- Eignung des Anwendungsfalls: Schließlich haben wir uns überlegt, für welchen Benutzertyp oder welches Projekt sich die einzelnen Tools am besten eignen. Wir haben ihre Stärken für bestimmte Aufgaben, wie das Scraping von Konkurrenz-Websites oder die Handhabung JavaScript-lastiger Websites, sowie für spezifische Anwendungsfälle wie die Webdatenerfassung bewertet. So konnten wir feststellen, welcher Dienst für unterschiedliche Anforderungen am besten geeignet ist.

- Erweiterte Proxy-Verwaltung: Wir haben uns auf Tools konzentriert, die erweiterte Funktionen für die Proxy-Verwaltung bieten. Dazu gehören Dienste eines dedizierten Proxy-Anbieters, die eine automatische Proxy-Rotation ermöglichen. Dies ist entscheidend, um sicherzustellen, dass Sie Daten von verschiedenen Zielwebsites zuverlässig extrahieren können, ohne blockiert oder markiert zu werden.

- Vielfältige Scraping-Funktionen: Wir haben untersucht, wie jedes Tool mit unterschiedlichen Scraping-Anforderungen umgeht. Dabei wurde auch untersucht, wie sie verschiedene Proxys für verschiedene Scraping-Arten nutzen. Die Möglichkeit, zwischen Proxy-Rotationsmethoden und einer breiten Palette von Proxys zu wechseln, ist für komplexe Zielwebsites unerlässlich.

Zusammenfassung

Die Auswahl des richtigen Web-Scraping-Tools kann schwierig sein, aber jetzt kennen Sie die Fakten.

Von rotierenden Proxys bis hin zum Lösen von Captchas hat jeder Dienst seine eigenen Stärken.

Einige bieten eine kostenlose Stufe für den Einstieg, während andere umfangreiche kostenpflichtige Pläne für große Projekte haben.

Die Auswahl des genau richtigen Tools hängt von Ihren Zielen ab, unabhängig davon, ob Sie Entwickler sind oder Teil eines Marketingteams, das sich auf Wettbewerbsinformationen konzentriert.

Wenn Sie die verschiedenen Preismodelle verstehen und wissen, wie Sie eine bestimmte Programmiersprache mit einem Tool verwenden, können Sie für Ihr nächstes Projekt die richtige Wahl treffen.

Es kommt darauf an, die beste Übereinstimmung für Ihre spezifischen Anforderungen und die Ziel-URL zu finden, mit der Sie arbeiten.

Häufig Gestellte Fragen

Sind Web-Scraping-Tools gut für E-Commerce-Sites?

Ja, viele Tools eignen sich hervorragend für den E-Commerce und ermöglichen es Unternehmen, Wettbewerbsinformationen zu sammeln. Sie können dynamische Preis- und Produktdaten auf beliebten Websites problemlos verarbeiten.

Kann ich Daten in verschiedenen Formaten erhalten?

Ja, die meisten modernen Tools ermöglichen Ihnen das Herunterladen Ihrer Scraped-Daten in verschiedenen Formaten wie JSON, CSV und Excel, sodass sie sich problemlos in Ihre vorhandenen Arbeitsabläufe integrieren lassen.

Verfügen diese Tools über einen integrierten Scheduler?

Viele Scraping-Dienste verfügen über eine integrierte Planer. Auf diese Weise können Sie Ihre Scraping-Anforderungen automatisieren und Aufgaben zu bestimmten Zeiten ohne manuelle Eingabe ausführen, wodurch Sie Zeit sparen.

Ist es möglich, Telefonnummern zu scrapen?

Ja, mit der richtigen Auswahl eines soliden Tools können Sie mit dem Scraping nach bestimmten Daten wie Telefonnummern beginnen. Diese Tools verwenden verschiedene Methoden, um diese Informationen zu finden und zu extrahieren.

Was ist ein Headless-Chrome-Browser?

Ein Headless-Chrome-Browser läuft ohne visuelle Oberfläche. Er ist eine gute Wahl für Web Scraping, da er JavaScript rendern und mit dynamischen Inhalten interagieren kann, genau wie ein normaler Benutzer.