Haben Sie Schwierigkeiten, die stetig steigenden Anforderungen von KI- und Machine-Learning-Workloads zu bewältigen?

Fühlen Sie sich durch Ihre lokale Hardware eingeschränkt?

Die Frustration ist verständlich. Genau hier setzt RunPod an.

In diesem RunPod-Testbericht werden wir untersuchen, ob es sich wirklich um die beste GPU-Cloud-Lösung zur Leistungssteigerung Ihrer KI-Projekte handelt.

Sind Sie bereit, die Leistungsfähigkeit skalierbarer GPUs zu erleben? Über 10.000 Nutzer haben sich bereits für RunPod entschieden, um ihre KI/ML-Anforderungen zu erfüllen, und dabei über 500.000 Instanzen gestartet.

Was ist RunPod?

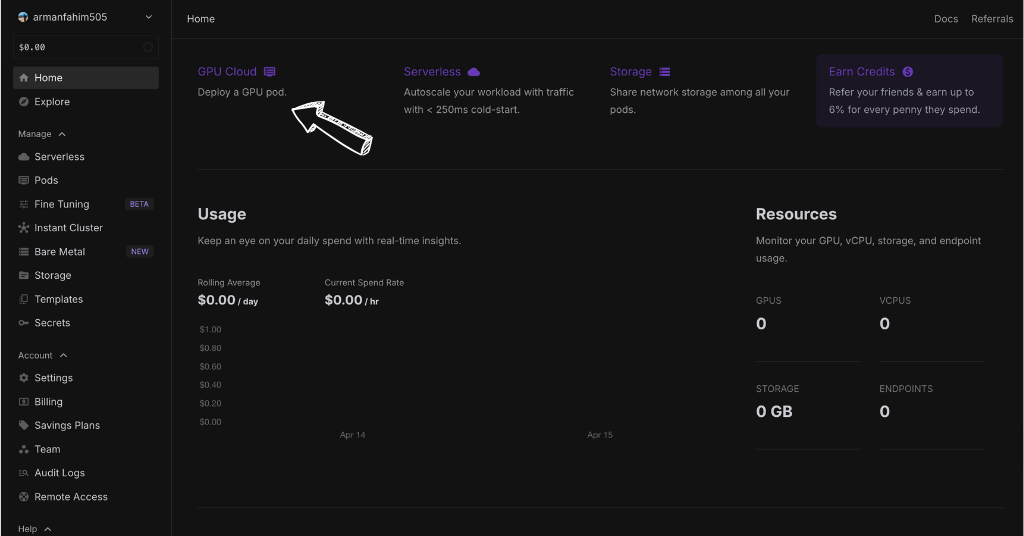

RunPod ist ein Ort, an dem Sie auf einfache Weise leistungsstarke Computer in der Cloud erstellen können.

Diese Computer verfügen über spezielle Bauteile, sogenannte GPUs, die sich hervorragend für mathematische Berechnungen, beispielsweise für KI, eignen.

Sie müssen sich keine Gedanken über die Einrichtung oder Verwaltung von Servern machen.

Sie wählen aus, was Sie benötigen, beispielsweise eine Kapsel mit der passenden Leistung.

Dann können Sie Ihre KI-Projekte sehr schnell auf diesem Pod bereitstellen.

RunPod hilft Ihnen auch beim Erstellen eines Endpunkts.

Das ist vergleichbar mit einer Webadresse, die es anderen Programmen oder Personen ermöglicht, Ihre KI-Modelle problemlos zu nutzen.

RunPod macht es Ihnen also leicht, leistungsstarke Computer für Ihre KI-Projekte zu nutzen, ohne sich mit komplizierten technischen Details auseinandersetzen zu müssen.

Wer hat RunPod entwickelt?

RunPod wurde von Zhen Lu gegründet, der auch der jetzige CEO ist.

Das Unternehmen wurde im Jahr 2022 gegründet.

Die Idee für RunPod entstand aus dem Bedürfnis nach einem einfacheren Zugang zu leistungsstarken Computern für KI-Arbeiten.

Zhen und sein Team wollten eine einfache Möglichkeit schaffen, mit der Menschen leistungsstarke Computer für ihre Bedürfnisse mieten können, ohne sich mit der Hardware herumschlagen zu müssen.

Ihre Vision war es, mächtige Berechnung Ressourcen, die allen zur Verfügung stehen.

Wir helfen ihnen, ihre KI-Projekte kostengünstig einzuführen und zu skalieren.

Die wichtigsten Vorteile von RunPod

- Einfache serverlose Bereitstellung: Führen Sie Ihre KI-Anwendungen aus, ohne Server verwalten zu müssen. Die serverlose Architektur von RunPod übernimmt das Backend, sodass Sie sich auf Ihren Code konzentrieren können.

- Vorgefertigte Vorlagen: Mit sofort einsatzbereiten Vorlagenbildern für gängige ML-Frameworks und -Tools gelingt der Einstieg schnell und spart Ihnen Zeit bei der Einrichtung.

- Skalierbare Inferenz: Skalieren Sie Ihre Inferenz-Workloads einfach, wenn die Nachfrage steigt, und stellen Sie so sicher, dass Ihre Anwendungen auch bei Spitzenlastzeiten reaktionsfähig bleiben.

- Flexibles Netzwerkvolumen: Dank flexibler Netzwerkvolumenoptionen können Sie die richtige Speichermenge für Ihr Rechenzentrum und Ihre Projektanforderungen auswählen.

- Globale Rechenzentrumsstandorte: Greifen Sie auf leistungsstarke Cloud-Computing-Ressourcen von verschiedenen Rechenzentrumsstandorten zu, reduzieren Sie die Latenz und verbessern Sie die Leistung.

- Detaillierte Protokollierung: Verfolgen Sie die Aktivitäten Ihrer Anwendung und beheben Sie Probleme effektiv mit umfassenden Protokolldateien.

- Kostengünstige Startup-Lösung: Startup-Unternehmen und einzelne Entwickler können zu wettbewerbsfähigen Preisen auf leistungsstarke GPUs zugreifen, wodurch die KI-Entwicklung demokratisiert wird.

- Skalierbare Unternehmenslösungen: Unternehmenskunden können die Infrastruktur von RunPod für groß angelegte ML-Implementierungen und anspruchsvolle Workloads nutzen.

- Nahtlose Docker-Integration: Mit Docker können Sie Ihre containerisierten Anwendungen einfach bereitstellen und so Portabilität und konsistente Umgebungen gewährleisten.

Beste Eigenschaften

RunPod verfügt über einige wirklich coole Tools, die die Arbeit mit KI deutlich vereinfachen und beschleunigen.

Diese Funktionen helfen Ihnen, leistungsstarke Computer in der Cloud unkompliziert zu nutzen.

Werfen wir einen Blick auf einige der besten Dinge, die RunPod bietet:

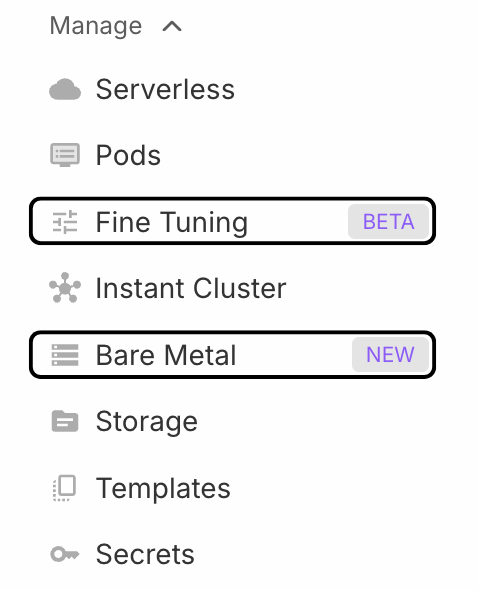

1. Schoten

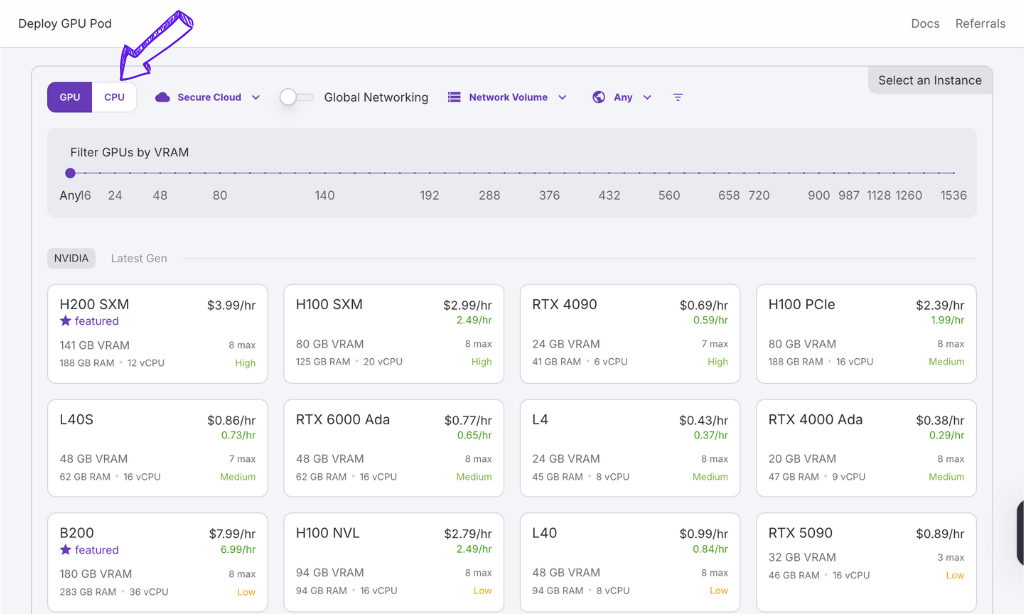

Mit RunPod können Sie eine Kapsel mieten, die wie Ihr eigener superschneller Computer in der Cloud ist.

Sie können den GPU-Typ auswählen, den Sie für Ihr Projekt benötigen.

Das bedeutet, dass Sie nur für den Strom bezahlen, den Sie tatsächlich verbrauchen.

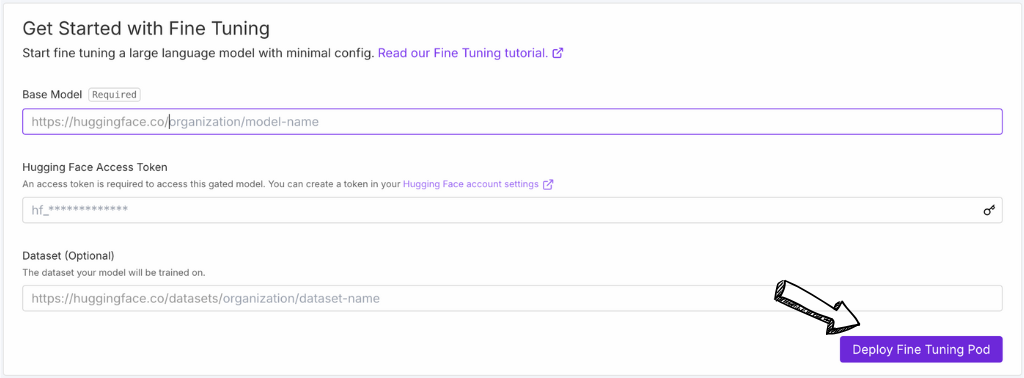

2. Feinabstimmung

Die Feinabstimmungsfunktion erleichtert es, KI-Modellen neue Dinge beizubringen.

Statt bei Null anzufangen, können Sie ein bestehendes Open-Source-Modell nehmen und es mit Ihren Daten trainieren.

RunPod bietet Ihnen die Werkzeuge, um dies effizient zu erledigen und Ihnen so Zeit und Mühe zu sparen.

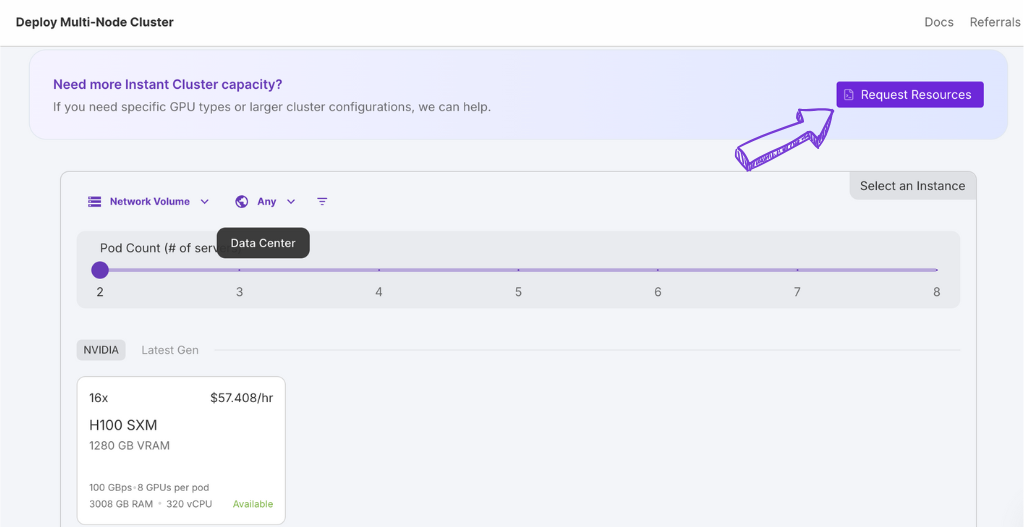

3. Sofortige Cluster

Brauchen Sie noch mehr Leistung?

Mit Instant Cluster können Sie schnell viele Pod-Computer verbinden.

Auf dieser Cloud-Plattform ist es, als ob Ihr Mini-Supercomputer in Sekundenschnelle einsatzbereit wäre.

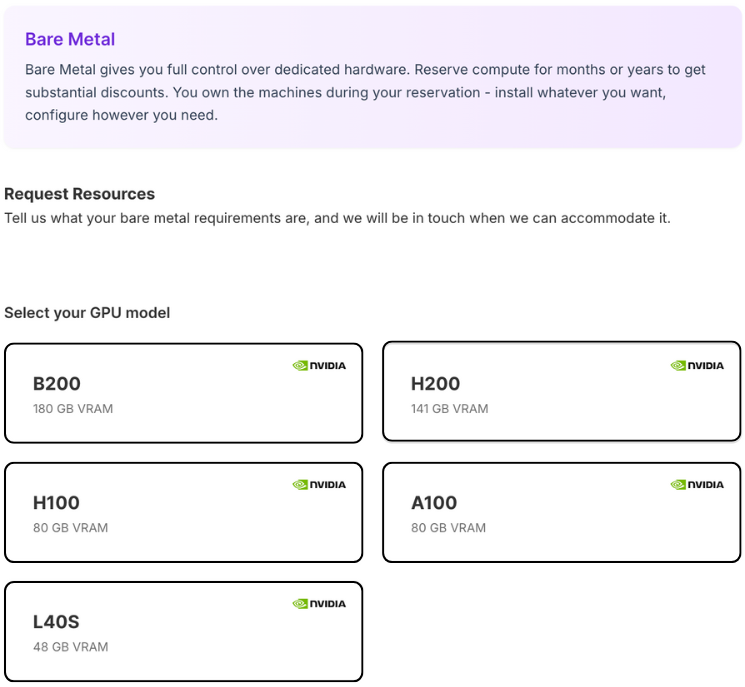

4. Blankes Metall

Für alle, die die volle Kontrolle wollen.

Bare Metal ermöglicht Ihnen den direkten Zugriff auf die Computerhardware.

Das bedeutet, dass Sie die uneingeschränkte Macht über alles haben.

So, als ob Sie Ihren physischen Server in einem Rechenzentrum hätten, nur ohne den Einrichtungsaufwand.

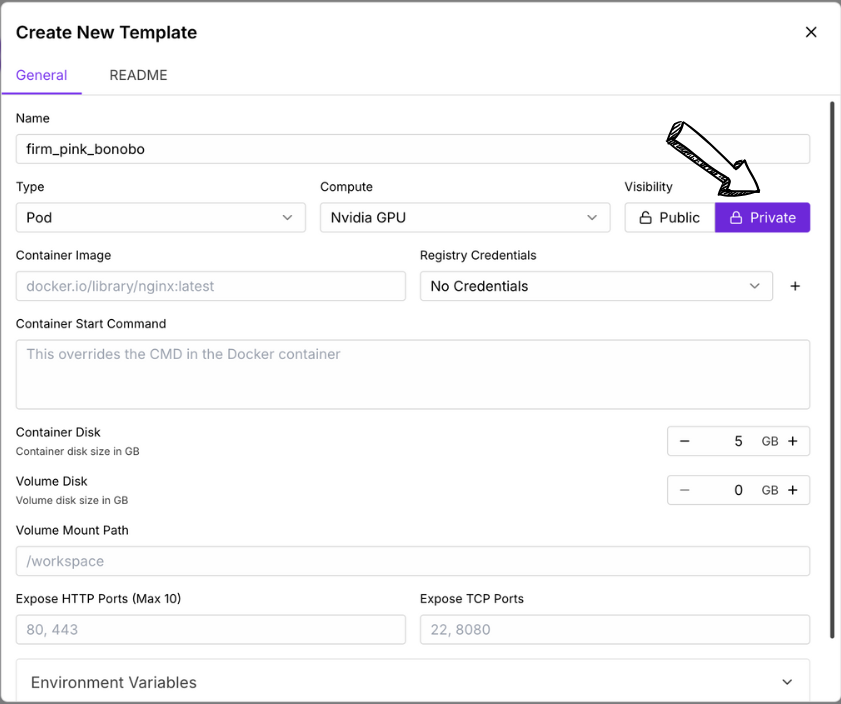

5. Vorlagengenerator

Möchten Sie Ihre Lieblingseinstellungen speichern?

Mit Template Maker können Sie Ihre eigenen Vorlagenbilder erstellen.

Das bedeutet, dass Sie Ihre gesamte Software und alle Einstellungen speichern können, sodass Sie beim nächsten Mal, wenn Sie eine ähnliche Konfiguration benötigen, diese wiederverwenden können.

Es ist im Handumdrehen einsatzbereit.

Preisgestaltung

| Planname | Ab |

| H100 NVL | $2.59 |

| H200 SXM | $3.59 |

| H100 PCle | $1.99 |

| H100 SXM | $2.69 |

| A100 PCle | $1.19 |

| A100 SXM | $1.89 |

Für und Wider

Vorteile

Nachteile

Alternativen zu RunPod

Während RunPod überzeugende Funktionen für GPU-Cloud-Computing bietet, gibt es mehrere andere Plattformen, die ähnliche Bedürfnisse abdecken.

Hier sind einige Alternativen, die Sie in Betracht ziehen könnten:

- Amazon EC2 (mit P-Instanzen) ist eine weit verbreitete Cloud-Plattform mit einem breiten Angebot an GPU-Instanzen. Sie verfügt über ein ausgereiftes Ökosystem und umfangreiche Services, kann aber für kleinere Startups komplexer und potenziell teurer sein.

- Google Cloud Platform (GCP – Compute Engine mit A100/H100): Ein weiterer bedeutender Cloud-Computing-Anbieter mit leistungsstarken GPU-Optionen und starker Integration seiner ML- und KI-Inferenzdienste. Ähnlich wie AWS bietet er eine breite Palette an Tools.

- Microsoft Azure (VMs der NV-Serie): Die Cloud-Plattform von Microsoft bietet verschiedene GPU-basierte virtuelle Maschinen, die für rechenintensive Aufgaben optimiert sind. Sie lässt sich gut in andere Microsoft-Produkte und -Dienste integrieren.

- Lambda Labs GPU Cloud ist auf GPU-Cloud-Computing spezialisiert. Das Unternehmen bietet häufig wettbewerbsfähige Preise und konzentriert sich auf Deep-Learning-Workloads. Es bietet sowohl On-Demand- als auch reservierte Instanzen an.

- Papierbereich: Es bietet eine benutzerfreundliche Oberfläche und verschiedene GPU-Optionen, darunter nutzungsbasierte Abrechnung und dedizierte Instanzen. Es ist bekannt für seine einfache Bedienbarkeit, insbesondere für die Entwicklung und den Einsatz von ML-Anwendungen.

- CoreWeave: Der Fokus liegt auf Hochleistungsrechnen und es werden leistungsstarke GPU-Instanzen angeboten, die für anspruchsvolle Unternehmens- und Forschungsanwendungen optimiert sind. Häufig wird die Kosteneffizienz bei groß angelegten Inferenz- und Trainingsanwendungen hervorgehoben.

Die Bewertung Ihrer spezifischen Bedürfnisse und der Vergleich mit diesen Plattformen wird Ihnen helfen, die beste Cloud-Plattform für Ihre KI-Projekte auszuwählen.

Persönliche Erfahrungen mit RunPod

Unser Team benötigte kürzlich eine robuste und kostengünstige Lösung für die Implementierung unseres neuesten KI-Modells.

Nachdem wir verschiedene Optionen geprüft hatten, entschieden wir uns, RunPod auszuprobieren.

Unsere Erfahrung war durchweg positiv, insbesondere hinsichtlich der folgenden Aspekte:

- Mühelose serverlose Endpunktbereitstellung: Die Einrichtung eines serverlosen Endpunkts für unser Modell war überraschend unkompliziert. Wir konnten unser trainiertes Modell schnell bereitstellen und über einen einfachen API-Aufruf zugänglich machen.

- Nahtlose Docker-Integration: Unser Modell war bereits mit Docker containerisiert, und RunPod ließ sich nahtlos integrieren. Das Deployment unseres Docker-Images war kinderleicht.

- Kosteneinsparungen: Im Vergleich zu einigen der größeren Cloud-Plattform-Optionen, die wir in Betracht gezogen haben, bot RunPod erhebliche Kosteneinsparungen bei den von uns benötigten GPU-Ressourcen.

- Einfacher Zugriff auf leistungsstarke GPUs: Wir konnten einen Pod mit der passenden GPU auswählen, die unseren Inferenzanforderungen entsprach, wodurch eine optimale Leistung ohne zu hohe Kosten gewährleistet wurde.

- Vereinfachtes Repository-Management: Die Integration unseres Modells aus unserem Repository (einer privaten GitLab-Instanz) war gut dokumentiert und einfach einzurichten.

Insgesamt bot uns RunPod eine flexible und kostengünstige Lösung.

Und eine effiziente Möglichkeit, unser KI-Modell über einen serverlosen Endpunkt bereitzustellen.

Sie nutzten die Leistungsfähigkeit ihrer GPUs und vereinfachten den Bereitstellungsprozess aus unserem bestehenden Repository.

Schlussbetrachtung

Ist RunPod also die richtige Wahl für Sie?

Wenn Sie leistungsstarke Computer in der Cloud für KI benötigen, ohne ein Vermögen auszugeben.

Loading...

Es ermöglicht einen einfachen Einstieg mit vorgefertigten Templates und serverlosen Optionen.

Sie können genau die benötigte Leistung auswählen und sogar superschnelle GPUs mieten.

Wenn Sie Ihre KI-Modelle auf unkomplizierte Weise einsetzen möchten und dafür hohe Rechenleistung benötigen, bietet RunPod eine gute Option.

Möchten Sie sehen, wie viel Sie sparen können und wie schnell Sie loslegen können?

Besuchen Sie RunPod noch heute und entdecken Sie die GPU-Optionen!

Häufig gestellte Fragen

Was genau ist RunPod?

RunPod ermöglicht es Ihnen, leistungsstarke Computer mit GPUs in der Cloud zu mieten. So lassen sich KI- und Machine-Learning-Aufgaben einfach ausführen, ohne dass Sie eigene, teure Hardware benötigen. Sie können Anwendungen serverlos bereitstellen oder ganze Pods mieten.

Was kostet ein RunPod?

Die Preise von RunPod hängen vom GPU-Typ und der Nutzungsdauer ab. Die Community Cloud ist oft günstiger, während die Secure Cloud eine stabilere Leistung bietet. Aktuelle Preisinformationen finden Sie auf der Website.

Ist RunPod einfach zu bedienen?

Ja, RunPod ist benutzerfreundlich gestaltet, insbesondere dank der vorgefertigten Templates und Serverless-Optionen. Einige Funktionen, wie beispielsweise Bare Metal, erfordern jedoch möglicherweise fortgeschrittenere technische Kenntnisse.

Welche GPUs bietet RunPod an?

RunPod bietet eine Vielzahl von GPUs an, von preisgünstigeren Optionen bis hin zu High-End-Karten wie A100 und H100, die für verschiedene KI-Inferenz- und ML-Workloads geeignet sind.

Kann ich Docker mit RunPod verwenden?

Ja, RunPod verfügt über eine nahtlose Docker-Integration, was die Bereitstellung containerisierter Anwendungen auf der Plattform vereinfacht.