Potrzebujesz danych z Walmartu — milionów produktów, ciągle zmieniających się cen i opinii klientów.

Próba zebrania tych danych ręcznie jest niemożliwa.

Tracisz czas na walkę z botami zamiast sprzedawać produkty.

Ustalenie złej ceny, nawet jednorazowo, może skutkować utratą sprzedaży i zysku.

Jeśli nie skorzystasz z dużego rabatu oferowanego przez konkurencję, stracisz pieniądze.

Potrzebujesz niezawodnego, zautomatyzowanego przepływu danych.

Jeśli Twoje decyzje strategiczne opierają się na starych wiadomościach, jesteś w bardzo niekorzystnej sytuacji. Dlatego potrzebujesz odpowiedniego narzędzia już teraz.

Sekret sukcesu w roku 2025 leży w automatyzacji gromadzenia danych.

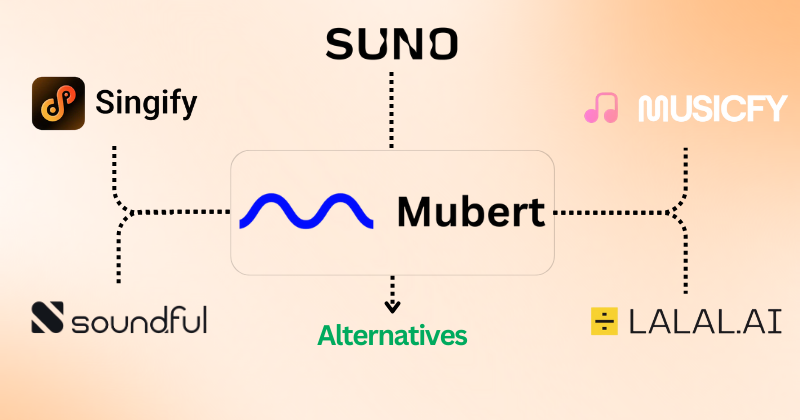

Potrzebujesz dedykowanego 7 najlepszych danych Walmart Skrobak która zajmie się wszystkimi problemami za Ciebie, przekształcając surowe dane w przejrzyste, przydatne informacje.

Jaki jest najlepszy program do zbierania danych w Walmart?

Wybór właściwego narzędzia może decydować o tym, czy unikniesz blokady, czy osiągniesz zyski.

Przyjrzeliśmy się temu, co najlepiej sprawdzi się w roku 2025. Skupiliśmy się na mocy, niezawodności i łatwości użytkowania.

Przestań martwić się systemami anty-botowymi.

Poniżej znajdziesz listę najważniejszych narzędzi, których potrzebujesz, aby osiągnąć swoje cele w zakresie handlu elektronicznego.

Użyj tej listy, aby wybrać narzędzie idealnie odpowiadające Twoim potrzebom.

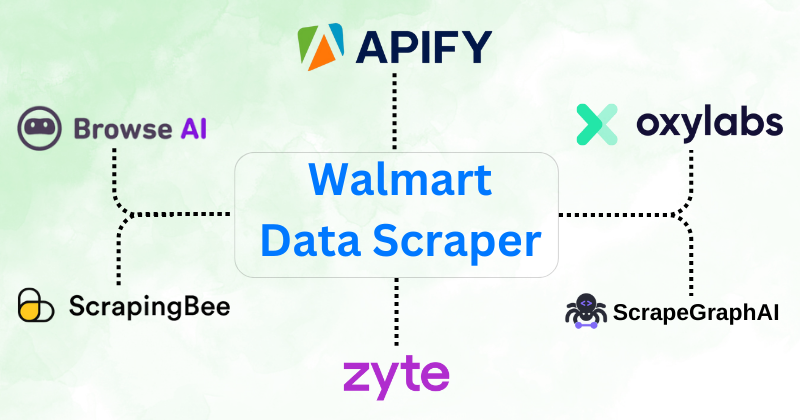

1. Jasne dane (⭐️4.6)

Bright Data jest liderem przedsiębiorstw.

Oferują ogromną i niezawodną platformę danych.

Ich sztuczną inteligencją jest Web Unlocker.

Automatycznie rozwiązuje CAPTCHA i obsługuje bloki.

Możesz łatwo uzyskać czyste dane z Walmartu. To działa w przypadku dużych projektów.

Nasze podejście

Nie trać godzin na ręczne wprowadzanie danych. Wybierz Bright Data i uzyskaj natychmiastowy dostęp do ponad 150 milionów serwerów proxy. Rozpocznij 7-dniowy bezpłatny okres próbny już dziś, aby osiągnąć 99,9% skuteczność w zbieraniu danych i zyskać przewagę konkurencyjną, której potrzebuje Twoja firma.

Kluczowe korzyści

Firma Bright Data jest znana ze swojej skali i skuteczności, które są kluczowe w przypadku monitorowania serwisu eBay na dużą skalę.

- Ponad 150 milionów adresów IP: Największa na świecie sieć serwerów proxy sprawia, że zawsze będziesz wyglądał jak prawdziwy użytkownik.

- 99,9% wskaźnik sukcesu: Gwarancja zbierania danych nawet na najtrudniejszych stronach produktowych.

- 7-dniowy bezpłatny okres próbny: Możesz w pełni przetestować ich system zanim zdecydujesz się na konkretny plan.

- API Web Unlocker: To narzędzie automatycznie obsługuje testy CAPTCHA i wykrywa boty.

- Brak gwarancji: Nie udzielają formalnej gwarancji, ale oferują stałe wsparcie zespołu wsparcia.

Wycena

Bright Data oferuje złożone, specyficzne dla produktu rozwiązania wycena.

Jest to rozwiązanie w zasadzie typu „płać, ile zużyjesz”, co czyni je elastycznymi, ale potencjalnie drogimi dla początkujących.

Zalety

Wady

2. Oxylabs (⭐️4.4)

Oxylabs jest znany ze swojej szybkości i jakości proxy.

Dysponują specjalnymi narzędziami dla witryn e-commerce, takich jak Walmart.

Oferują API w czasie rzeczywistym. Dzięki temu możesz śledzić zmiany cen. natychmiast.

Jest bardzo niezawodny i szybko dostarcza czystych, ustrukturyzowanych danych.

Nasze podejście

Odblokuj dane dzięki wiodącej usłudze proxy. Z ponad 175 milionami serwerów proxy domowych, 2 milionami dedykowanych serwerów proxy w centrach danych i 20 milionami serwerów proxy mobilnych, Oxylabs zapewnia adresy IP potrzebne do każdego projektu.

Kluczowe korzyści

- Asystent AI OxyCopilot: To narzędzie umożliwia generowanie żądań scrapowania przy użyciu prostego, naturalnego języka.

- Ogromna sieć proxy: Posiada jedną z największych pul serwerów proxy na świecie, obejmującą adresy IP ze 195 krajów.

- Gwarancja sukcesu: Oparte na sztucznej inteligencji odciski palców platformy i omijanie testu CAPTCHA gwarantują wysoki wskaźnik powodzenia nawet w przypadku najtrudniejszych witryn.

- Bezpieczeństwo klasy korporacyjnej: Platforma posiada certyfikat ISO/IEC 27001:2022, co gwarantuje wysoki poziom bezpieczeństwa i prywatności danych.

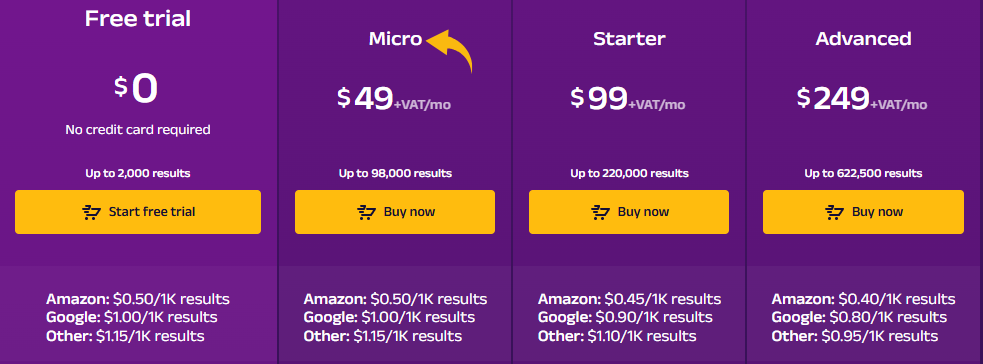

Wycena

- Bezpłatny okres próbny: $0.

- Mikro: 49 USD/miesiąc + VAT.

- Rozrusznik: 99 USD/miesiąc + VAT.

- Zaawansowany: 249 USD/miesiąc + VAT.

Zalety

Wady

3. Apify (⭐️4.2)

Apify to platforma w chmurze z wbudowanymi „Aktorami” do scrapowania.

Można uruchomić gotowy scraper Walmart bez kodu.

Ich wewnętrzne narzędzie działa jak prosty pilot oparty na sztucznej inteligencji.

Pomaga przekształcić surowe strony w czyste tabele danych.

Jest szybki i elastyczny, idealny do szybkich projektów.

Nasze podejście

Chcesz przekonać się na własne oczy o możliwościach Apify? Nasza platforma została wykorzystana do zeskanowania ponad 2,5 miliona stron internetowych i przetworzenia ponad 500 TB danych w ciągu jednego miesiąca. Gotowy do działania?

Kluczowe korzyści

- Ogromny rynek: W sklepie Apify Store dostępnych jest ponad 5000 gotowych do użycia programów do scrapowania i automatyzacji, zwanych aktorami.

- Maksymalna skalowalność: Zaprojektowane do zadań na poziomie korporacyjnym, umożliwia przetwarzanie na dużą skalę milionów stron.

- Przyjazne dla programistów: Udostępnia pakiet SDK typu open source i obsługuje niestandardowy kod w językach Python i JavaScript.

- Zaawansowane planowanie: Zautomatyzuj zadania scrapowania, aby były wykonywane w określonych godzinach lub odstępach czasu, bez konieczności wykonywania czynności ręcznych.

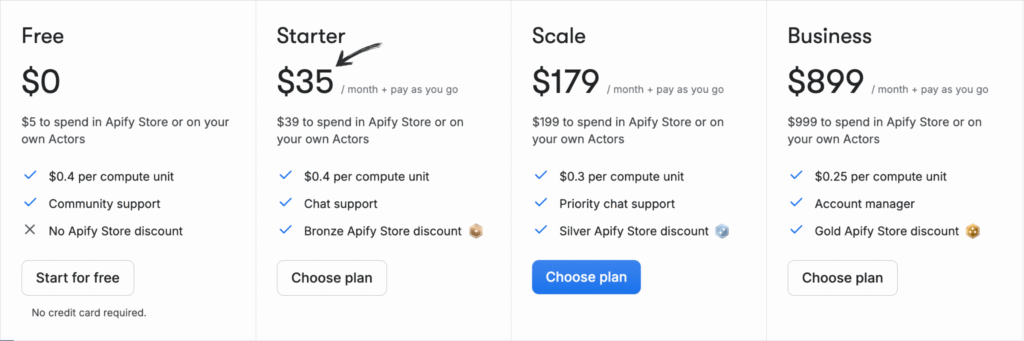

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: 0 zł/miesiąc + Płać zgodnie z zużyciem.

- Rozrusznik: 35 USD/miesiąc + płatność w miarę zużycia.

- Skala: 179 USD/miesiąc + Płać za zużycie.

- Biznes: 899 USD/miesiąc + płatność w miarę zużycia.

Zalety

Wady

4. Zyte (⭐️3.8)

Zyte to szanowana marka zajmująca się scrapowaniem. Ich API Zyte to inteligentny, oparty na sztucznej inteligencji (AI) pilot do scrapowania.

Automatycznie wybiera najlepszy serwer proxy i obsługuje wszystkie błędy.

Wysyłasz link do Walmartu, a oni odsyłają czyste dane. To eliminuje wszelkie problemy natury technicznej.

Nasze podejście

Uzyskaj najbardziej niezawodną sieć dane z API Zyte. Osiągnij 99,99% dokładności danych w swoich projektach dzięki temu wysokiej jakości API do scrapowania stron internetowych i usprawnij proces ekstrakcji danych już dziś.

Kluczowe korzyści

- Automatyczne odblokowywanie: Przestań żonglować serwerami proxy; Zyte API to potężne, zautomatyzowane narzędzie do obsługi banów.

- Bezproblemowa integracja ze Scrapy: Jeśli jesteś programistą korzystającym z frameworka Scrapy, Zyte będzie dla Ciebie idealnym rozwiązaniem.

- Ekstrakcja danych wspomagana sztuczną inteligencją: Narzędzie może automatycznie identyfikować i analizować dane, zmniejszając potrzebę ręcznego stosowania reguł analizy.

- Zintegrowana przeglądarka bez interfejsu: Nie ma potrzeby korzystania z przeglądarek bezgłowych innych firm, ponieważ Zyte udostępnia przeglądarkę zoptymalizowaną pod kątem scrapowania stron internetowych na dużą skalę.

Wycena

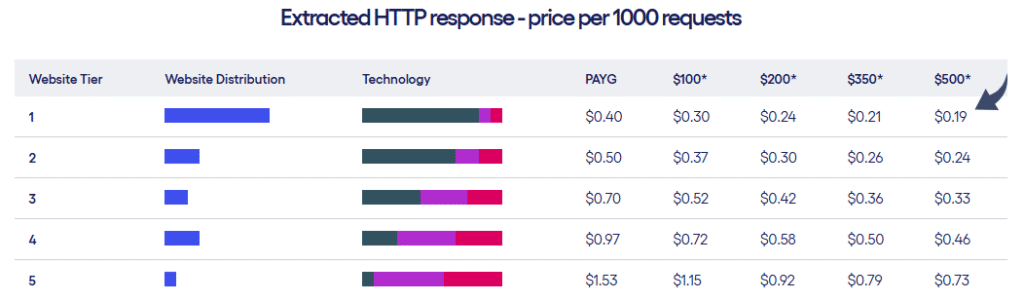

- Zyte oferuje dwa rodzaje planów cenowych w zależności od poziomu witryn i liczby żądań.

Zalety

Wady

5. Scrapingbee (⭐️3.6)

Scrapingbee kładzie nacisk na prostotę i łatwość użytkowania.

Oferuje proste API.

Zajmuje się rotacją serwerów proxy i rozwiązywaniem testów CAPTCHA w tle.

Dzięki temu uzyskasz dostęp do wszystkich szczegółów produktu, nawet tych, które ładują się za pomocą JavaScript.

Jest to szybkie i nieskomplikowane.

Nasze podejście

Zdobądź dane Potrzebujesz ich z ponad 98% stron internetowych. Potężne API do scrapowania stron internetowych ScrapingBee oferuje renderowanie JavaScript, API wyszukiwarki Google oraz możliwość ekstrakcji danych strukturalnych z dokładnością do 99,5% na stronach dynamicznych.

Kluczowe korzyści

- Zajmie się wszystkim za Ciebie: Zarządza automatycznie rotacją serwerów proxy i renderowaniem JavaScript.

- Proste API: Za pomocą jednego, prostego wywołania API otrzymasz czyste dane.

- 99,9% czasu sprawności: Platforma charakteryzuje się wysoką niezawodnością i stabilną wydajnością.

- Obszerna dokumentacja: Zawiera przejrzystą i wyczerpującą dokumentację z przykładami kodu dla wielu języków, co ułatwia rozpoczęcie pracy.

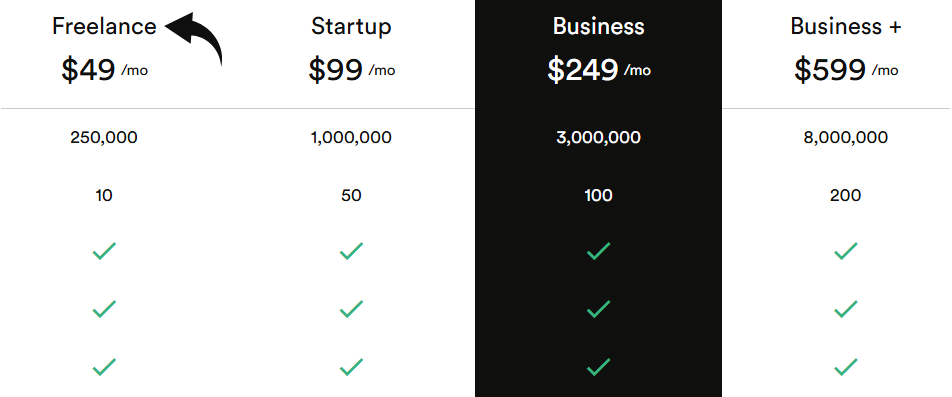

Wycena

Wszystkie plany będą rozliczane rocznie.

- Pracownik nieetatowy: 49 USD/miesiąc.

- Uruchomienie: 99 USD/miesiąc.

- Biznes: 249 USD/miesiąc.

- Biznes+: 599 USD/miesiąc.

Zalety

Wady

6. Przeglądaj AI (⭐️3.4)

Browse AI to narzędzie niewymagające kodu.

Możesz szkolić boty, klikając i pokazując im dane.

Działa jak autopilot IT do scrapowania.

Bot rejestruje Twoje działania i powtarza je zgodnie z harmonogramem.

Jest to rozwiązanie idealne dla małych zespołów, które nie lubią pisać kodu.

Nasze podejście

Chcesz zaoszczędzić czas i uzyskać potrzebne dane? Browse AI poradzi sobie z milionami stron internetowych. Zobacz, jak łatwe może być scrapowanie stron internetowych.

Kluczowe korzyści

- Kod nie jest wymagany: Dzięki interfejsowi typu „wskaż i kliknij” każdy może w ciągu kilku minut stworzyć narzędzie do pozyskiwania danych.

- Adaptacja wspomagana przez sztuczną inteligencję: Narzędzie automatycznie dostosowuje się do zmian w układzie witryny, zapewniając zawsze spójność danych.

- Ponad 7000 integracji: Łatwo połącz zebrane dane z aplikacjami takimi jak Arkusze Google, Airtable i Zapier.

- Gotowe roboty: Uzyskaj dostęp do biblioteki gotowych robotów przeznaczonych do wykonywania typowych zadań na popularnych stronach internetowych, oszczędzając jeszcze więcej czasu.

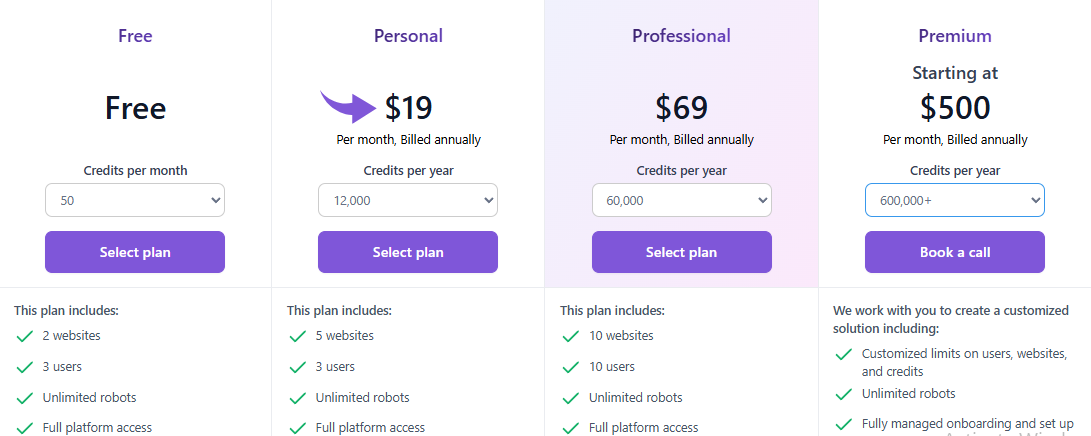

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: $0.

- Osobisty: 19 USD/miesiąc.

- Profesjonalny: 69 USD/miesiąc.

- Premia: Od 500 USD/miesiąc.

Zalety

Wady

7. Sztuczna inteligencja ScrapeGraph (⭐️3.2)

ScrapeGraph AI to nowość, która wykorzystuje wiele funkcji sztucznej inteligencji.

Zamienia strony internetowe w ustrukturyzowane wykresy umożliwiające inteligentną analizę.

Można użyć prostego języka, aby wskazać mu, jakie dane ma znaleźć.

Świetnie nadaje się dla użytkowników, którym zależy na zaawansowanej inteligencji danych.

Nasze podejście

Wiodący specjaliści (ponad 350 osób) zaufali ScrapeGraphAI ze względu na jego solidne, oparte na sztucznej inteligencji możliwości scrapowania stron internetowych. Zapewnij sobie 20% wzrost wydajności na kolejne 48 godzin.

Kluczowe korzyści

- Scraping języka naturalnego: Możesz wskazać mu, co ma wyodrębnić, używając prostych, zrozumiałych dla człowieka monitów.

- Biblioteka Open Source: Deweloperzy mogą wykorzystać jego wszechstronną bibliotekę typu open-source, aby uzyskać maksymalną kontrolę.

- Funkcja Markdownify: Potrafi konwertować całe strony internetowe na przejrzyste, czytelne dokumenty Markdown.

- Agentic Scraper: Sztuczna inteligencja potrafi autonomicznie poruszać się po stronach internetowych i wchodzić z nimi w interakcje, wykonując złożone, wieloetapowe zadania.

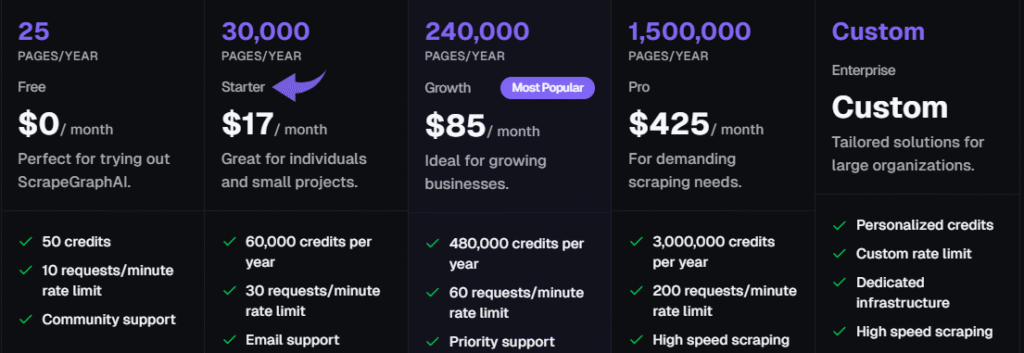

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: 0 zł/miesiąc.

- Rozrusznik: 17 USD/miesiąc.

- Wzrost: 85 USD/miesiąc.

- Zawodowiec: 425 USD/miesiąc.

- Przedsiębiorstwo: Indywidualne ceny.

Zalety

Wady

Na co zwrócić uwagę przy zakupie skrobaczki w Walmart?

Inwestując w narzędzie do web scrapingu Walmart, potrzebujesz czegoś więcej niż tylko prostego skryptu.

Potrzebujesz rozwiązania, które może obsługiwać zaawansowane środki ochrony przed botami, aby zapewnić płynne wyodrębnianie danych.

Zwróć uwagę na następujące kluczowe cechy:

- Antyblokada Zdolność: Scraper musi obsługiwać złożone zabezpieczenia w Walmart. Oznacza to inteligentną rotację proxy i możliwość imitowania prawdziwego agenta użytkownika, aby uniknąć blokady „robot czy człowiek?”.

- Dostęp do danych JSON: Strony Walmartu często korzystają z frameworka Next.js. Najlepsze narzędzia szybko pobierają wszystkie dane JSON osadzone w tagu skryptu (często __NEXT_DATA__) na stronie produktu Walmartu. Ta metoda to najszybszy sposób na uzyskanie kompletnych danych o produktach Walmartu.

- Dane o produktach strukturalnych: Celem jest uzyskanie wartościowych danych, a nie tylko surowego kodu. Twój web scraper Walmart powinien dostarczać czyste, gotowe do użycia dane o produktach (cena, nazwa, recenzje) dla każdego produktu Walmart.

- Niezawodne skalowanie do scrapowania stron internetowych: Musisz skalować swoje działania związane ze scrapowaniem danych, unikając ciągłych awarii. Wybierz dostawcę z dużą siecią serwerów proxy, aby obsłużyć dużą liczbę żądań scrapowania dla Walmartu bez blokowania Twojego adresu IP.

- Rozwiązania oparte na sztucznej inteligencji: Najwięksi dostawcy korzystają z funkcji wspomaganych przez sztuczną inteligencję (takich jak Web Unlocker czy wbudowana funkcja rozwiązywania testów CAPTCHA), aby utrzymywać niezawodne połączenia i automatycznie zarządzać złożonością procesu scrapowania stron internetowych.

Jakie korzyści może Ci przynieść narzędzie do scrapowania danych Walmart?

Korzystanie z narzędzia do zbierania danych Walmart nie ma na celu gromadzenia danych, lecz podejmowanie lepszych decyzji finansowych.

Dzięki niemu będziesz mieć możliwość zobaczenia, co robią najwięksi gracze na rynku e-commerce.

Zmiany cen w Walmart otrzymasz natychmiast.

Oznacza to, że nigdy więcej nie ustawisz ceny za wysoko lub za nisko.

Scraping pomaga również w zarządzaniu zapasami.

Możesz śledzić trendy w produktach i sprawdzać, co podoba się klientom.

Te cenne informacje pomogą Ci zaopatrzyć się we właściwe produkty we właściwym czasie.

Zasadniczo można przewidzieć, co sprzeda się następnym razem.

Krótko mówiąc, dobry scraper działa jak Twój zespół zajmujący się analizą rynku.

Daje Ci przewagę nad konkurencją, ponieważ udostępnia dokładne dane o produktach, recenzje i ceny.

Dzięki temu możesz przejść od zgadywania do podejmowania mądrych decyzji opartych na danych, które zwiększą Twoją sprzedaż.

Przewodnik kupującego

Przeprowadzając badania mające na celu znalezienie najlepszego produktu do scrapowania Walmartu, uwzględniliśmy te czynniki w celu ustalenia naszego rankingu.

Zapoznaliśmy się szczegółowo z wymaganiami technicznymi, aby zagwarantować zgodność i niezawodność wyodrębniania danych w różnych kategoriach.

- Ochrona przed botami i niezawodność: Przetestowaliśmy, jak każda usługa radzi sobie z blokadami i zabezpieczeniami antybotowymi. Najlepsze narzędzie musi korzystać z inteligentnych, rotacyjnych serwerów proxy, manipulować agentem użytkownika i akceptować nagłówek języka (np. en-us), aby strona wyglądała na ludzką. Sprawdziliśmy, czy usługa rzeczywiście może bezpośrednio pobierać dane, nie wywołując komunikatu „Proszę potwierdzić, że jesteś człowiekiem”.

- Ekstrakcja danych technicznych: Szukaliśmy narzędzi, które pomijają zawartość HTML i od razu przechodzą do czystego formatu JSON. Często wiąże się to z odczytem ukrytego tagu skryptu zawierającego ładunek __NEXT_DATA__, który zawiera wszystkie dane JSON. Zwróciliśmy uwagę na narzędzia, które wykorzystują przeglądarki bezgłowe do renderowania złożonego kodu JavaScript.

- Prostota dla programistów: W przypadku niestandardowego skryptu w Pythonie, szukaliśmy łatwości konfiguracji. Obejmowało to użycie poniższego polecenia do aktywacji środowiska Pythona i zainstalowanie niezbędnych bibliotek, takich jak Requests i BeautifulSoup. Sprawdziliśmy, jak łatwo programiści mogą wysyłać żądania HTTP za pomocą swojego klucza API.

- Obsługa błędów i jakość danych: Najlepsze narzędzia zapewniają wyraźne wykrywanie błędów raportowanieNa przykład monitorują kod statusu po poleceniu żądania importu. Kluczowym testem było to, jak dobrze radzą sobie z paginacją, aby przejść do następnej strony, oraz ile adresów URL produktów są w stanie przetworzyć (maksymalnie). Muszą dostarczać czyste, ustrukturyzowane dane dotyczące sprzedawcy.

- Biznes Skupienie wywiadu: Oceniliśmy narzędzia pod kątem ich zdolności do śledzenia cen i analizowania długoterminowych trendów rynkowych. Narzędzia oferujące wbudowany samouczek krok po kroku dotyczący typowych elementów strony produktu, takich jak wyszukiwanie danych w tagu span, uzyskały wyższą ocenę.

- Wsparcie i ceny: Na koniec przyjrzeliśmy się oferowanemu wsparciu (pomoc techniczna 24/7) i przejrzystości struktury cenowej (płatność za użytkowanie kontra subskrypcja).

Podsumowanie

Pokazaliśmy Ci 7 najlepszych narzędzi do scrapowania danych w Walmart.

Są gotowe do wykorzystania w Twoim biznesie.

Narzędzia te wykorzystują świetne funkcje, takie jak AI Copilot i inteligentny IT Autopilot.

Pomaga im to ominąć witrynę bezpieczeństwo łatwo.

Najważniejszy wniosek jest prosty: przestańmy gromadzić dane ręcznie.

Zamiast tego użyj tych profesjonalnych narzędzi.

Szybko dostarczają Ci czyste dane. Te dane pomagają Ci śledzić ceny i zmiażdżyć konkurencję.

Nasz zespół dokładnie sprawdził te narzędzia.

Oznacza to, że otrzymujesz niezawodne rozwiązanie, a nie tylko niestabilny skrypt Pythona, który często ulega awariom.

Czas na własny sukces w e-handlu.

Wybierz już dziś odpowiednią skrobaczkę z naszej listy.

Często zadawane pytania

Jakiego rodzaju dane mogę uzyskać, skanując stronę internetową Walmart?

Możesz zebrać wszystkie dane, w tym szczegóły produktów, stany magazynowe i dane z recenzji. Scraper zbiera konkretne informacje, których potrzebujesz, ze strony internetowej Walmart, często pobierając kluczowe informacje o sprzedawcach i cenach z wyników wyszukiwania.

Dlaczego muszę się martwić nagłówkiem agenta użytkownika?

Nagłówek agenta użytkownika pomaga witrynie Walmart zidentyfikować, kto wysyła żądanie (np. przeglądarka czy bot). Jeśli nagłówek jest nieobecny lub wydaje się być automatycznym skryptem, witryna prawdopodobnie zablokuje żądanie i zwróci fałszywy wynik, uniemożliwiając wyszukiwanie.

Jak najlepsze scrapery radzą sobie z zabezpieczeniami anty-botowymi?

Top scrapery wykorzystują techniki takie jak rotacja adresów IP i upewnienie się, że nagłówek Accept-Encoding jest poprawnie ustawiony. Starają się idealnie naśladować prawdziwą przeglądarkę, aby uzyskać dostęp do strony produktu. Jest to niezbędne do płynnego i niezawodnego wyodrębniania żądanych danych.

Czy można pozyskać opinie klientów?

Tak, zbieranie recenzji Walmartu to częsty powód zbierania danych. Narzędzie do zbierania danych może wyodrębnić tekst, oceny gwiazdkowe i daty recenzji. Dane te są kluczowe dla zrozumienia trendów rynkowych i nastawienia klientów do produktu Walmart.

Dlaczego ludzie skupiają się na zdobyciu pliku JSON?

Plik JSON często zawiera kompletne, ustrukturyzowane dane produktu, których przeglądarka używa do zbudowania strony produktu. Pobieranie tego pliku zamiast surowej zawartości HTML jest znacznie szybsze i zapewnia bardziej przejrzyste, gotowe do użycia dane do analizy, oszczędzając czas przetwarzania.