Potrzebujesz wartościowych leadów z serwisu LinkedIn, ale ręczne zbieranie danych jest powolne i żmudne.

Co gorsza, korzystanie z tanich i zawodnych narzędzi naraża całe Twoje konto na ryzyko ograniczenia.

Ciągle martwisz się, że Twoje główne źródło leadów zniknie. Ten strach jest realny.

Kruchy narzędzia do skrobania łatwo je uszkodzić, przez co tracisz czas na czyszczenie konta i ryzykujesz bolesną blokadą.

Po co ryzykować całą strategię generowania leadów dla kiepskiego narzędzia?

W tym artykule przedstawiamy 7 najlepszych narzędzi do scrapowania danych z LinkedIn na rok 2025. Przetestowaliśmy je pod kątem bezpieczeństwa, jakości danych i zaawansowanych funkcji AI.

Czytając ten artykuł, znajdziesz niezawodne narzędzie, które ochroni Twoje konto, jednocześnie dostarczając czyste, duże ilości danych, których potrzebujesz.

Gotowy na włączenie swojego silnika leadów?

Jaki jest najlepszy program do scrapowania danych z LinkedIn?

Wybór właściwego narzędzia do skrobania jest trudny.

Potrzebujesz czegoś wydajnego, co poradzi sobie ze złożoną ochroną przed botami.

Potrzebujesz również narzędzia, które za każdym razem dostarczy Ci czyste i ustrukturyzowane dane.

Przestań tracić czas na testowanie różnych opcji.

Przygotowaliśmy ranking 7 najlepszych platform, aby pomóc Ci wybrać platformę, która najlepiej odpowiada Twoim potrzebom w zakresie przetwarzania dużych, profesjonalnych danych.

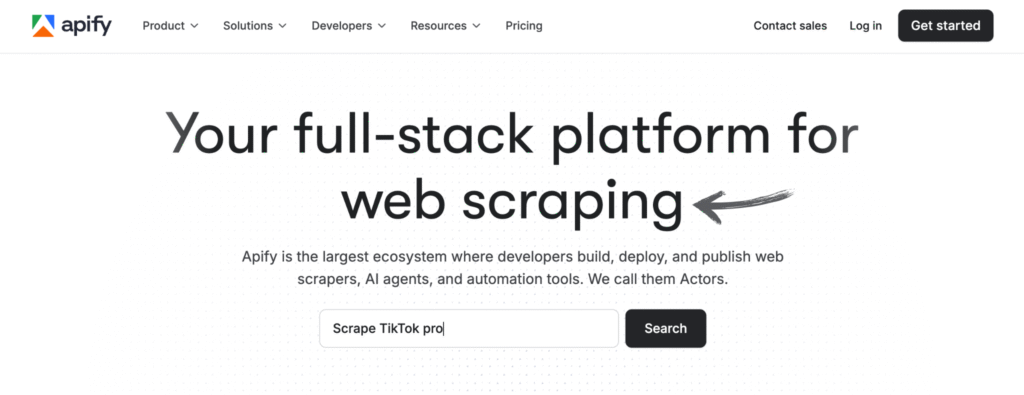

1. Apify (⭐️4.6)

Apify to kompleksowa platforma do tworzenia i uruchamiania narzędzi do scrapowania stron internetowych.

Oferuje tysiące gotowych „Aktorów” do obsługi zadań scrapowania i może przekształcić dowolną witrynę internetową w gotowy do użycia interfejs API.

Nasze podejście

Chcesz przekonać się na własne oczy o możliwościach Apify? Nasza platforma została wykorzystana do zeskanowania ponad 2,5 miliona stron internetowych i przetworzenia ponad 500 TB danych w ciągu jednego miesiąca. Gotowy do działania?

Kluczowe korzyści

- Ogromny rynek: W sklepie Apify Store dostępnych jest ponad 5000 gotowych do użycia programów do scrapowania i automatyzacji, zwanych aktorami.

- Maksymalna skalowalność: Zaprojektowane do zadań na poziomie korporacyjnym, umożliwia przetwarzanie na dużą skalę milionów stron.

- Przyjazne dla programistów: Udostępnia pakiet SDK typu open source i obsługuje niestandardowy kod w językach Python i JavaScript.

- Zaawansowane planowanie: Zautomatyzuj zadania scrapowania, aby były wykonywane w określonych godzinach lub odstępach czasu, bez konieczności wykonywania czynności ręcznych.

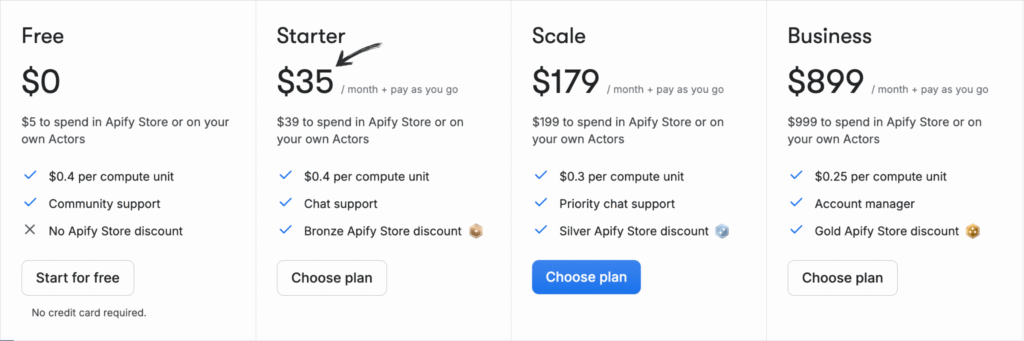

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: 0 zł/miesiąc + Płać zgodnie z zużyciem.

- Rozrusznik: 35 USD/miesiąc + płatność w miarę zużycia.

- Skala: 179 USD/miesiąc + Płać za zużycie.

- Biznes: 899 USD/miesiąc + płatność w miarę zużycia.

Zalety

Wady

2. ScrapingBee (⭐️4.4)

ScrapingBee to interfejs API do scrapowania stron internetowych, który zajmie się najtrudniejszymi częściami za Ciebie.

Zarządza rotacją serwerów proxy, przeglądaniem bez monitora i radzi sobie z blokadami, dzięki czemu możesz skupić się na uzyskiwaniu potrzebnych danych.

Nasze podejście

Zdobądź dane Potrzebujesz ich z ponad 98% stron internetowych. Potężne API do scrapowania stron internetowych ScrapingBee oferuje renderowanie JavaScript, API wyszukiwarki Google oraz możliwość ekstrakcji danych strukturalnych z dokładnością do 99,5% na stronach dynamicznych.

Kluczowe korzyści

- Zajmie się wszystkim za Ciebie: Zarządza automatycznie rotacją serwerów proxy i renderowaniem JavaScript.

- Proste API: Za pomocą jednego, prostego wywołania API otrzymasz czyste dane.

- 99,9% czasu sprawności: Platforma charakteryzuje się wysoką niezawodnością i stabilną wydajnością.

- Obszerna dokumentacja: Zawiera przejrzystą i wyczerpującą dokumentację z przykładami kodu dla wielu języków, co ułatwia rozpoczęcie pracy.

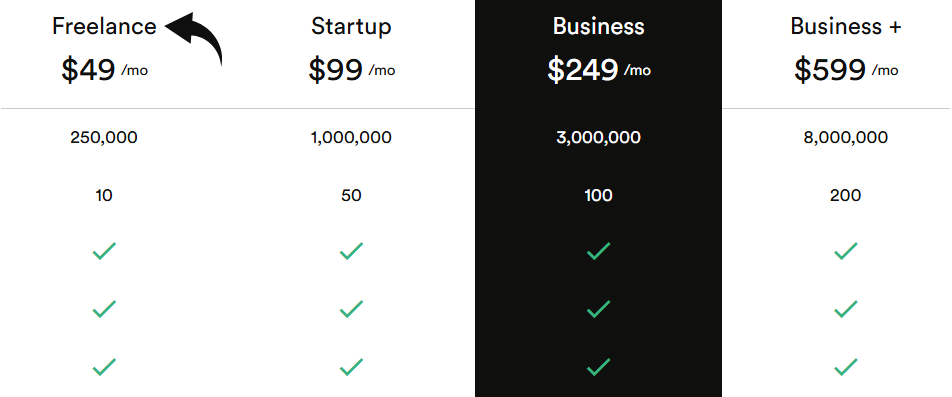

Wycena

Wszystkie plany będą rozliczane rocznie.

- Pracownik nieetatowy: 49 USD/miesiąc.

- Uruchomienie: 99 USD/miesiąc.

- Biznes: 249 USD/miesiąc.

- Biznes+: 599 USD/miesiąc.

Zalety

Wady

3. Przeglądaj AI (⭐️4.2)

To narzędzie niewymagające pisania kodu pozwala Ci przekształcić dowolną witrynę internetową w źródło danych.

Można go używać do monitorowania stron internetowych pod kątem zmian i uzyskiwania określonych informacji za pomocą jednego kliknięcia.

Nasze podejście

Chcesz zaoszczędzić czas i uzyskać potrzebne dane? Browse AI poradzi sobie z milionami stron internetowych. Zobacz, jak łatwe może być scrapowanie stron internetowych.

Kluczowe korzyści

- Kod nie jest wymagany: Dzięki interfejsowi typu „wskaż i kliknij” każdy może w ciągu kilku minut stworzyć narzędzie do pozyskiwania danych.

- Adaptacja wspomagana przez sztuczną inteligencję: Narzędzie automatycznie dostosowuje się do zmian w układzie witryny, zapewniając zawsze spójność danych.

- Ponad 7000 integracji: Łatwo połącz zebrane dane z aplikacjami takimi jak Arkusze Google, Airtable i Zapier.

- Gotowe roboty: Uzyskaj dostęp do biblioteki gotowych robotów przeznaczonych do wykonywania typowych zadań na popularnych stronach internetowych, oszczędzając jeszcze więcej czasu.

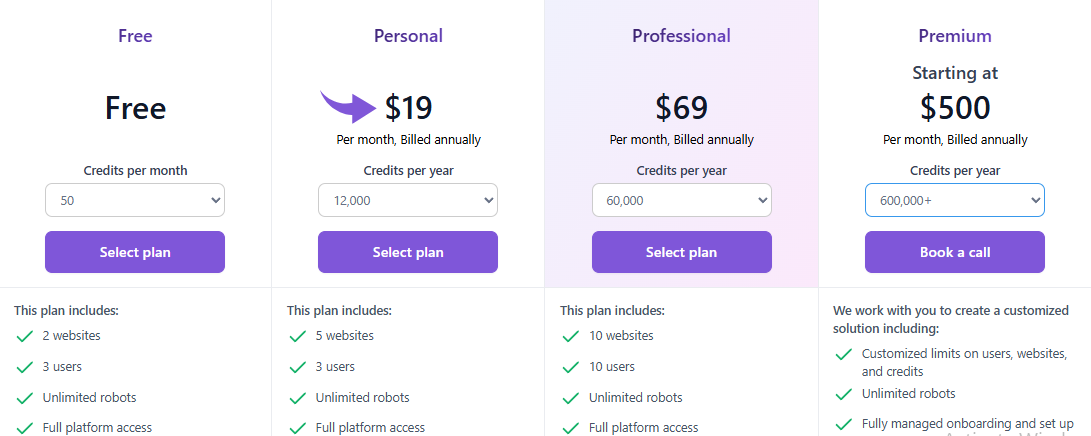

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: $0.

- Osobisty: 19 USD/miesiąc.

- Profesjonalny: 69 USD/miesiąc.

- Premia: Od 500 USD/miesiąc.

Zalety

Wady

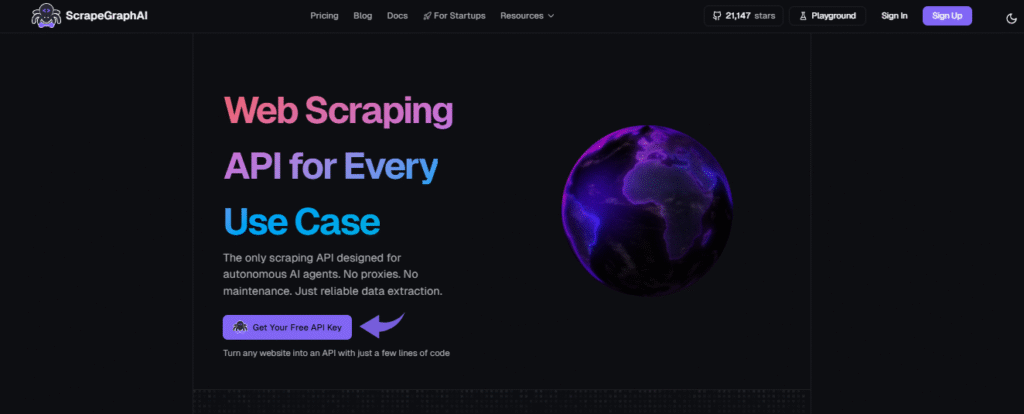

4. ScrapeGraphAI (⭐️3.8)

To narzędzie wykorzystuje sztuczną inteligencję do zrozumienia stron internetowych i pozyskiwania danych z prostego tekst rozkaz.

To świetny wybór, jeśli chcesz uzyskać dane bez kodowania.

Jest szybki i inteligentny.

Nasze podejście

Wiodący specjaliści (ponad 350 osób) zaufali ScrapeGraphAI ze względu na jego solidne, oparte na sztucznej inteligencji możliwości scrapowania stron internetowych. Zapewnij sobie 20% wzrost wydajności na kolejne 48 godzin.

Kluczowe korzyści

- Scraping języka naturalnego: Możesz wskazać mu, co ma wyodrębnić, używając prostych, zrozumiałych dla człowieka monitów.

- Biblioteka Open Source: Deweloperzy mogą wykorzystać jego wszechstronną bibliotekę typu open-source, aby uzyskać maksymalną kontrolę.

- Funkcja Markdownify: Potrafi konwertować całe strony internetowe na przejrzyste, czytelne dokumenty Markdown.

- Agentic Scraper: Sztuczna inteligencja potrafi autonomicznie poruszać się po stronach internetowych i wchodzić z nimi w interakcje, wykonując złożone, wieloetapowe zadania.

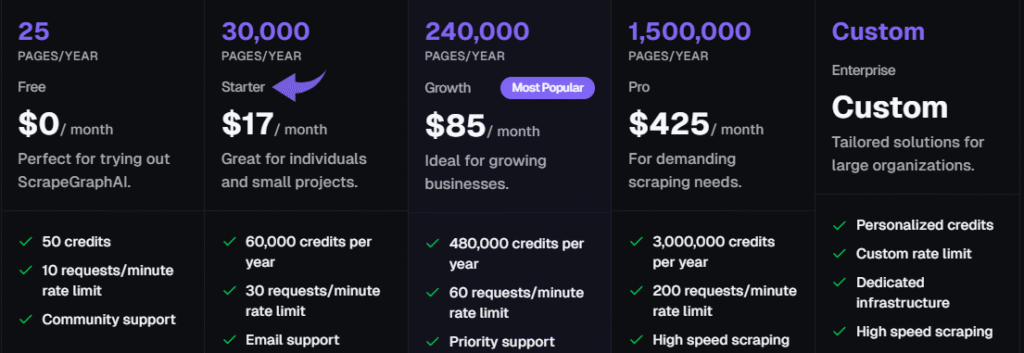

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: 0 zł/miesiąc.

- Rozrusznik: 17 USD/miesiąc.

- Wzrost: 85 USD/miesiąc.

- Zawodowiec: 425 USD/miesiąc.

- Przedsiębiorstwo: Indywidualne ceny.

Zalety

Wady

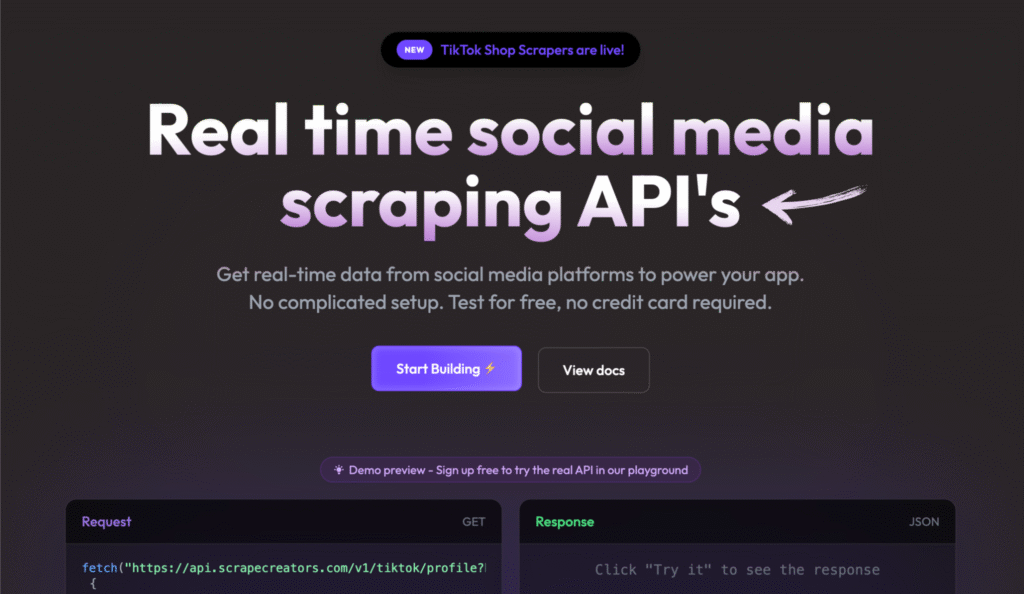

5. Twórcy scrapowania (⭐️3.6)

To potężne narzędzie, które w pierwszej kolejności opiera się na interfejsie API.

Jego celem jest pozyskiwanie w czasie rzeczywistym ustrukturyzowanych danych ze złożonych stron internetowych.

Zarządza środkami anty-botowymi i rotacją serwerów proxy w Twoim imieniu.

Nie musisz martwić się o kodowanie osobnego scrapera dla każdej zmiany na stronie.

Wysyłasz żądanie API i otrzymujesz czyste dane.

Jest to elastyczna opcja płatności za użytkowanie, przeznaczona dla programistów i użytkowników technicznych.

Nasze podejście

Nie musisz już męczyć się ze zbieraniem danych z mediów społecznościowych. Dzięki Scrape Creators uzyskasz dane w czasie rzeczywistym z platform takich jak Twitch i Pinterest. Dołącz do setek użytkowników, którzy zebrali ponad 6 milionów zapytań i uzyskaj potrzebne Ci informacje.

Kluczowe korzyści

- Specjalistyczne interfejsy API: Oferuje gotowe rozwiązania przeznaczone specjalnie dla platform mediów społecznościowych.

- Nie potrzeba kluczy API: Możesz ominąć konieczność posiadania oficjalnych kluczy API w przypadku witryn takich jak Twitch.

- Płać za zużycie: Płacisz tylko za to, z czego korzystasz, a Twoje środki nigdy nie wygasają.

- Bogate dane JSON: Interfejsy API udostępniają czyste i ustrukturyzowane dane JSON, dzięki czemu nie musisz wykonywać dodatkowego przetwarzania.

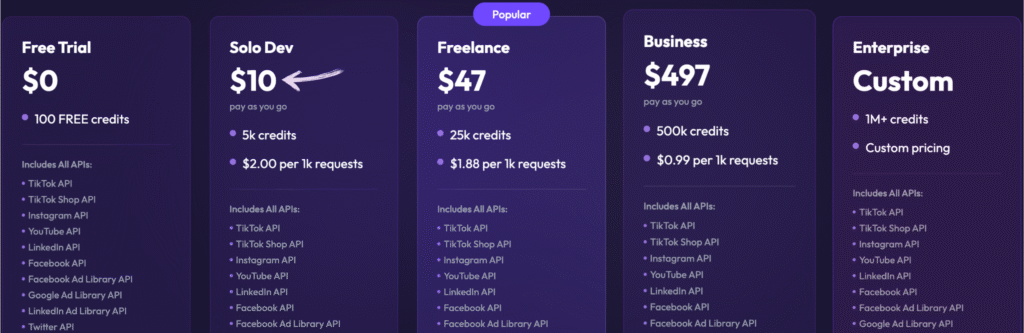

Wycena

- Bezpłatny okres próbny: 0, 100 darmowych kredytów.

- Solo Dev: 10 USD – Płać w miarę użytkowania, 5 tys. kredytów.

- Pracownik nieetatowy: 47 USD – Płać w miarę użytkowania, 25 tys. kredytów.

- Biznes: 497 USD – Płać w miarę użytkowania, 500 tys. kredytów.

- Przedsiębiorstwo: Cena niestandardowa, ponad 1 mln kredytów.

Zalety

Wady

6. ThorData (⭐️3.2)

To narzędzie jest obszerną, uniwersalną platformą do obsługi danych internetowych.

Jest to coś więcej niż tylko narzędzie do scrapowania danych z LinkedIn.

ThorData oferuje ogromną sieć ponad 60 milionów serwerów proxy.

To klucz do pozostania niewykrytym. Dostarczają specjalistyczne API, a nawet narzędzie do scrapowania bez kodu. budowniczy.

Deweloperzy i firmy wykorzystują go do automatyzacji gromadzenia danych na dużą skalę.

Oni zajmują się całą infrastrukturą, więc otrzymujesz tylko czyste dane.

Nasze podejście

Ciesz się niezrównanym bezpieczeństwem dzięki ThorData. To dane Proces weryfikacji gwarantuje 99,7% skuteczności. Dzięki całodobowemu wsparciu na żywo i średniemu czasowi reakcji poniżej 3 minut możesz być pewien jakości połączenia. Uzyskaj ponad 60 milionów adresów IP i zabezpiecz swoje dane.

Kluczowe korzyści

- Ogromna pula adresów IP: Oferuje ponad 60 milionów etycznie pozyskanych adresów IP.

- Wysoka anonimowość: Zapewnia, że Twoja aktywność scrapowania pozostanie niewykryta dzięki wysokiej jakości serwerom proxy.

- Płać za zużycie: Rozliczenia są przejrzyste: płacisz tylko za wykorzystany ruch, a nie za nieudane żądania.

- Wbudowany skrobak: Zawiera narzędzie do scrapowania stron internetowych bez kodu i uniwersalny interfejs API, dzięki czemu nie potrzebujesz osobnego narzędzia do prostych projektów.

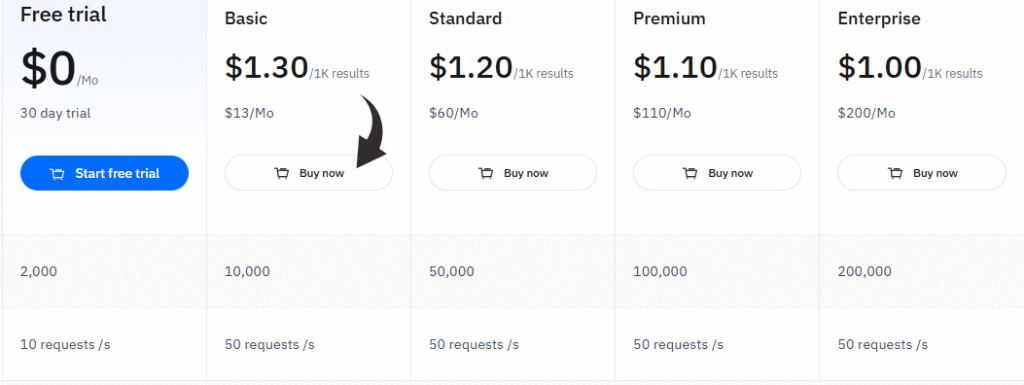

Wycena

- Bezpłatny okres próbny: 0 USD/miesiąc, 30-dniowy okres próbny.

- Podstawowy: 13 USD/miesiąc.

- Standard: 60 USD/miesiąc.

- Premia: 110 USD/miesiąc.

- Przedsiębiorstwo: 200 dolarów miesięcznie.

Zalety

Wady

7. Zyte (⭐️3.0)

Zyte to kompleksowy pakiet do scrapowania danych.

Zawiera funkcję Smart Proxy Manager, która wykorzystuje sztuczną inteligencję do automatycznego zarządzania blokadami, CAPTCHA i rotacją serwerów proxy.

Dzięki temu możesz skupić się na danych, a nie na zarządzaniu technicznym.

Jest to solidne rozwiązanie odpowiednie dla firm o dużych wymaganiach dotyczących danych.

Nasze podejście

Uzyskaj najbardziej niezawodną sieć dane z API Zyte. Osiągnij 99,99% dokładności danych w swoich projektach dzięki temu wysokiej jakości API do scrapowania stron internetowych i usprawnij proces ekstrakcji danych już dziś.

Kluczowe korzyści

- Automatyczne odblokowywanie: Przestań żonglować serwerami proxy; Zyte API to potężne, zautomatyzowane narzędzie do obsługi banów.

- Bezproblemowa integracja ze Scrapy: Jeśli jesteś programistą korzystającym z frameworka Scrapy, Zyte będzie dla Ciebie idealnym rozwiązaniem.

- Ekstrakcja danych wspomagana sztuczną inteligencją: Narzędzie może automatycznie identyfikować i analizować dane, zmniejszając potrzebę ręcznego stosowania reguł analizy.

- Zintegrowana przeglądarka bez interfejsu: Nie ma potrzeby korzystania z przeglądarek bezgłowych innych firm, ponieważ Zyte udostępnia przeglądarkę zoptymalizowaną pod kątem scrapowania stron internetowych na dużą skalę.

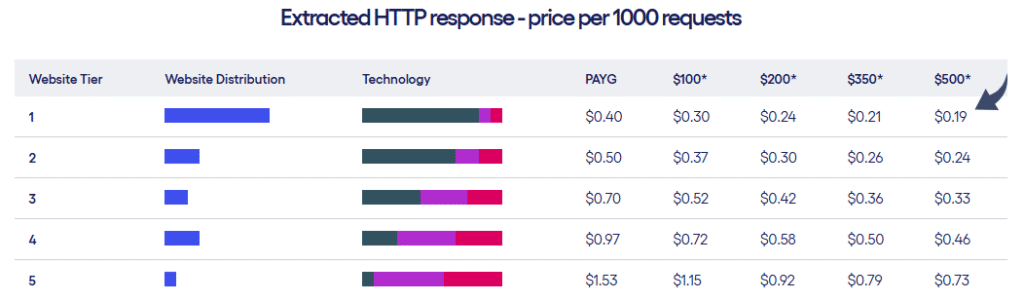

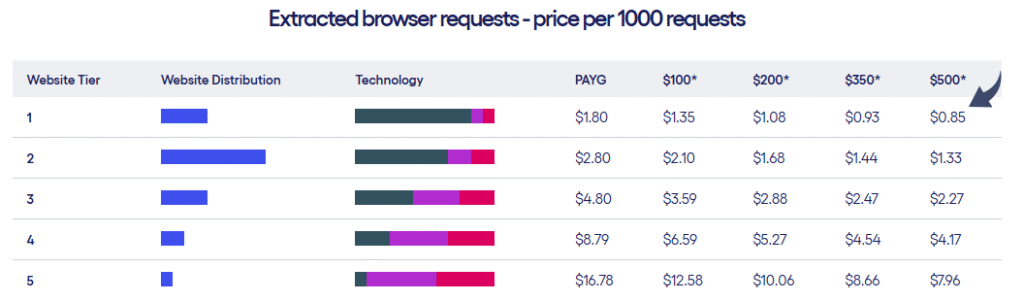

Wycena

- Zyte oferuje dwa rodzaje planów cenowych w zależności od poziomu witryn i liczby żądań.

Zalety

Wady

Na co zwrócić uwagę przy zakupie narzędzia do scrapowania danych z LinkedIn?

Wybór narzędzia do zarządzania danymi na poziomie przedsiębiorstwa jest poważny biznes.

Kupujesz infrastrukturę, a nie tylko jej rozszerzenie.

Twój wybór musi zapewnić bezpieczeństwo, szybkość i czyste dane dla Twojego systemu opartego na sztucznej inteligencji sięgać dalej niż ktoś coś lub analiza rynku.

Oto co odróżnia najlepsze narzędzia od pozostałych:

- Ochrona przed wykrywaniem i rotacja adresów IP: Narzędzie musi mieć ogromną sieć obracających się elementów Pełnomocnicy mieszkaniowiTo jest kluczowe. Używanie nowego, rzeczywistego adresu IP użytkownika dla każdego żądania sprawia, że Twoja aktywność wygląda na ludzką. To jest autopilot IT do działań antybanowych.

- Naśladowanie zachowań człowieka: Szukaj funkcji wykraczających poza powolne tempo. Narzędzie powinno naśladować rzeczywiste ruchy myszy, losowe prędkości przewijania i złożoną nawigację. Przewidywalne wzorce są blokowane; zachowania przypominające ludzkie są bezpieczne.

- Dynamiczna obsługa zawartości: Strony LinkedIn korzystają z dużej ilości JavaScriptu. Dobry scraper musi poprawnie renderować tę dynamiczną treść. Jeśli nie jest to możliwe, tracisz dostęp do kluczowych pól danych, takich jak pełna historia zatrudnienia czy umiejętności.

- Ustrukturyzowane dane wyjściowe: Dane nie mogą mieć postaci chaotycznego tekstu. Najlepsze narzędzia automatycznie analizują surowy kod HTML i generują czyste, ustrukturyzowane pliki JSON lub CSV. Dzięki temu dane są gotowe do użycia. CRM lub narzędzi AI Copilot natychmiast.

- Skalowalność i dostęp do API: Potrzebujesz niezawodnie obsługiwać setki tysięcy żądań. Rozwiązania API-first (takie jak nasze propozycje) są skalowalne. Pozwalają one na integrację gromadzenia danych bezpośrednio z systemami wewnętrznymi.

- Kompletność i świeżość danych: Narzędzie powinno gwarantować, że żądane dane (stanowisko, lokalizacja, wielkość firmy) będą spójnie przechwytywane i że dostarczane dane pochodzą z czasu rzeczywistego, a nie z nieaktualnej pamięci podręcznej.

Jakie korzyści mogą Ci przynieść narzędzia do scrapowania danych z serwisu LinkedIn?

Profesjonalne narzędzia do scrapowania danych z serwisu LinkedIn umożliwiają pozyskiwanie danych z serwisu LinkedIn, takich jak stanowiska pracy czy adresy URL profili, na potrzeby badań rynkowych.

Te narzędzia do zbierania profili w serwisie LinkedIn dostarczają zespołom sprzedaży i marketingu dokładne dane i cenne spostrzeżenia z danych publicznych.

Eksportuj nowe dane do pliku CSV, aby zapewnić bezproblemową integrację z Twoim CRM systemy.

To bezpieczny i zautomatyzowany sposób wykorzystania tej profesjonalnej sieci społecznościowej.

Przewodnik kupującego

Podczas badania najlepszego serwisu LinkedIn narzędzie automatyzacjioceniliśmy te krytyczne czynniki.

Nasza metodologia koncentruje się na bezpieczeństwie, funkcjonalności i gotowości przedsiębiorstw do wdrożenia przez użytkowników profesjonalnych:

- Bezpieczeństwo i zgodność: Sprawdziliśmy, czy narzędzie działa bezpiecznie, imitując zalogowane konto LinkedIn bez zgłaszania problemów. Kluczowym czynnikiem było przestrzeganie przepisów o ochronie danych podczas gromadzenia danych publicznie dostępnych.

- Możliwości kierowania: Oceniliśmy możliwości narzędzia w zakresie przeprowadzania ukierunkowanego wyszukiwania w serwisie LinkedIn i obsługi złożonych wyników wyszukiwania w serwisie LinkedIn. Obejmowało to analizę filtrów dla LinkedIn Sales Navigator, członków grup LinkedIn i stron firmowych.

- Jakość i wzbogacanie danych: Oceniliśmy, w jaki sposób narzędzie agreguje dane i dostarcza wysokiej jakości dane dotyczące profili i profili pracowników. Kluczowe wnioski obejmowały możliwość znalezienia zweryfikowanego adresu e-mail i zebrania danych firmograficznych.

- Zaawansowane funkcje i integracja: Priorytetem były dla nas narzędzia oferujące zaawansowane funkcje, takie jak wielokanałowe pozyskiwanie ofert pracy, scrapowanie ofert pracy i ogłoszeń o pracę oraz płynna, bezpośrednia integracja z innymi narzędziami i usługami w chmurze (takimi jak Arkusze Google). Szukaliśmy również dostępu do klucza API i obsługi scrapowania bez kodu.

- Skalowalność i zastosowanie w przedsiębiorstwach: Rozważaliśmy platformy zbudowane z myślą o skali, takie jak Jasne dane, które umożliwiają zbieranie danych z wielu profili i pozyskiwanie danych z profili za pomocą dostępu API. To decyduje, czy narzędzie jest odpowiednie dla inżynierów oprogramowania lub dużych zespołów narzędzi sprzedażowych.

- Ocena wartości (ceny i wsparcie): Oferujemy pełen zestaw funkcji, dostępność bezpłatnego planu i solidną obsługę klienta.

- Kompletność funkcji: Zadbaliśmy o to, aby scraper miał dostęp do wszystkich dostępnych danych potrzebnych do analizy trendów i dostarczał kompletne dane kontaktowe, co pozwala na spersonalizowane działania. Potwierdziliśmy możliwość scrapowania profili i firm, czyli tzw. scrapowania firm.

Podsumowanie

Dziś omówiliśmy sporo zagadnień.

Widziałeś 7 najlepszych platform do scrapowania danych z LinkedIn, stworzonych do zaawansowanej i bezpiecznej ekstrakcji danych.

Najważniejsza lekcja jest jasna: proste rozszerzenia przeglądarek są ryzykowne.

Najlepszymi narzędziami są interfejsy API klasy korporacyjnej, takie jak Bright Data i Oxylabs.

Korzystają z rozległych, rotacyjnych sieci proxy, aby zapewnić bezpieczeństwo Twojego konta.

Wybierając jedno z tych najwyżej ocenianych narzędzi, nie musisz już martwić się o otrzymanie bana.

Zaczniesz otrzymywać czyste, wysokiej jakości dane bezpośrednio do swoich systemów.

Dzięki temu Twój zespół sprzedaży może skupić się na sprzedaży, a nie na zbieraniu pieniędzy.

Nie ryzykuj swojego biznesu stawiając na tanie narzędzia.

Wybierz solidną platformę i bezpiecznie zautomatyzuj swój rozwój.

Często zadawane pytania

Jakiego rodzaju dane mogę uzyskać za pomocą narzędzia LinkedIn scraper?

Masz dostęp do niemal wszystkich publicznie dostępnych danych. Obejmuje to stanowiska, szczegóły dotyczące stron internetowych firm oraz zagregowane trendy branżowe. Wszystkie te dane idealnie nadają się do generowania leadów i badań rynku.

Czy pozyskiwanie danych z LinkedIn jest niezgodne z zasadami?

Tak, funkcje automatyzacji, które wyodrębniają wszystkie dane, naruszają Warunki korzystania z usługi LinkedIn. Sądy zezwalają jednak na scrapowanie danych dostępnych publicznie. Korzystaj z renomowanego narzędzia, takiego jak Bright Data, aby przestrzegać najlepszych praktyk i przepisów o ochronie danych.

Jak wykorzystać zebrane dane do celów informacyjnych?

Czy narzędzia do scrapowania mogą znaleźć adresy e-mail?

Tak. Wiele zaawansowanych narzędzi automatyzacji integruje się z usługami zewnętrznymi, takimi jak People Data Labs, w celu wyszukiwania i weryfikacji adresów e-mail. Narzędzia te wzbogacają wszystkie dane zebrane ze stron profilowych.

Dlaczego potrzebuję funkcji automatyzacji w badaniach rynku?

Funkcje automatyzacji pozwalają zbierać wszystkie dane potrzebne do analizy trendów i badań rynku znacznie szybciej niż metody manualne. Dzięki temu możesz monitorować konkurencję i śledzić trendy branżowe w czasie rzeczywistym, dostarczając natychmiastowych, cennych informacji.