Firecrawl to świetne narzędzie. Ale może być dla Ciebie zbyt kosztowne.

Być może potrzebujesz narzędzia o lepszych funkcjach.

Może chcesz mieć większą kontrolę nad swoimi danymi.

Może to spowolnić scrapowanie sieci.

Możesz przegapić kluczowe dane dla swoich projektów AI.

Znalezienie narzędzia, które jest łatwe w użyciu, tanie i wydajne, może być ogromnym bólem głowy.

Potrzebujesz lepszego sposobu na szybkie uzyskanie czystych danych internetowych.

Wykonaliśmy za Ciebie ciężką pracę.

Przyjrzeliśmy się 7 najlepszym alternatywom dla FireCrawl na rok 2025.

Czytaj dalej, aby znaleźć idealne narzędzia AI do scrapowania.

Jakie są najlepsze alternatywy dla FireCrawl?

Wiesz, że Firecrawl świetnie nadaje się do scrapowania stron internetowych z wykorzystaniem sztucznej inteligencji.

Ale czy jest to absolutnie najlepsze narzędzie do twój wymagania?

Znalezienie właściwego skrobak może przypominać labirynt lub pracę z autorem tekstów technicznych.

Chcesz pracować szybciej i mieć czystsze dane, nie wydając przy tym zbyt dużo pieniędzy.

Sprawdziliśmy dla Ciebie najlepsze platformy.

Oto nasza lista najlepszych alternatyw dla Firecrawl dostępnych obecnie na rynku.

1. Apify (⭐4.8)

Apify to kompleksowa platforma do scrapowania stron internetowych.

To nie tylko narzędzie; to cała chmura do pracy z danymi.

Deweloperzy kochają go za ogromną liczbę gotowych scraperów.

Możesz przekształcić dowolną stronę internetową w API. To świetne rozwiązanie do pozyskiwania danych dla modeli AI.

Nasze podejście

Chcesz przekonać się na własne oczy o możliwościach Apify? Nasza platforma została wykorzystana do zeskanowania ponad 2,5 miliona stron internetowych i przetworzenia ponad 500 TB danych w ciągu jednego miesiąca. Gotowy do działania?

Kluczowe korzyści

- Ogromny rynek: W sklepie Apify Store dostępnych jest ponad 5000 gotowych do użycia programów do scrapowania i automatyzacji, zwanych aktorami.

- Maksymalna skalowalność: Zaprojektowane do zadań na poziomie korporacyjnym, umożliwia przetwarzanie na dużą skalę milionów stron.

- Przyjazne dla programistów: Udostępnia pakiet SDK typu open source i obsługuje niestandardowy kod w językach Python i JavaScript.

- Zaawansowane planowanie: Zautomatyzuj zadania scrapowania, aby były wykonywane w określonych godzinach lub odstępach czasu, bez konieczności wykonywania czynności ręcznych.

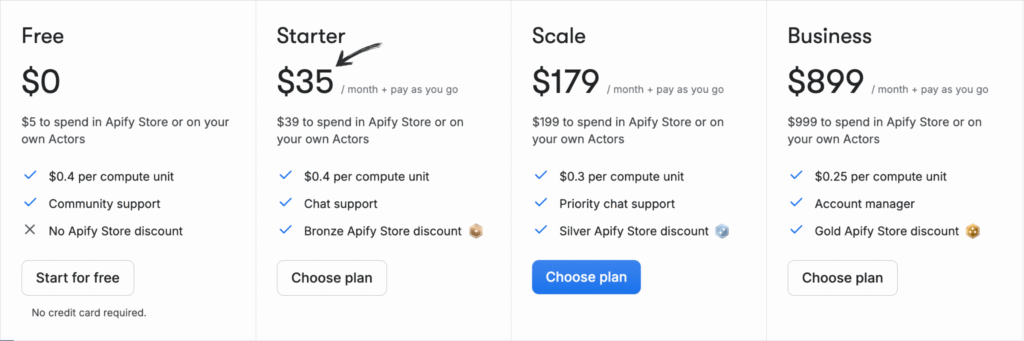

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: 0 zł/miesiąc + Płać zgodnie z zużyciem.

- Rozrusznik: 35 USD/miesiąc + płatność w miarę zużycia.

- Skala: 179 USD/miesiąc + Płać za zużycie.

- Biznes: 899 USD/miesiąc + płatność w miarę zużycia.

Zalety

Wady

2. ScrapingBee (⭐4.5)

Potrzebujesz prostego i skutecznego API? ScrapingBee jest rozwiązaniem.

Bardzo dobrze radzi sobie z obsługą serwerów proxy i JavaScript.

Ułatwia pozyskiwanie danych ze stron internetowych, które są podejrzane.

Szybko otrzymasz surowy kod HTML, którego potrzebujesz.

Nasze podejście

Zdobądź dane Potrzebujesz ich z ponad 98% stron internetowych. Potężne API do scrapowania stron internetowych ScrapingBee oferuje renderowanie JavaScript, API wyszukiwarki Google oraz możliwość ekstrakcji danych strukturalnych z dokładnością do 99,5% na stronach dynamicznych.

Kluczowe korzyści

- Zajmie się wszystkim za Ciebie: Zarządza automatycznie rotacją serwerów proxy i renderowaniem JavaScript.

- Proste API: Za pomocą jednego, prostego wywołania API otrzymasz czyste dane.

- 99,9% czasu sprawności: Platforma charakteryzuje się wysoką niezawodnością i stabilną wydajnością.

- Obszerna dokumentacja: Zawiera przejrzystą i wyczerpującą dokumentację z przykładami kodu dla wielu języków, co ułatwia rozpoczęcie pracy.

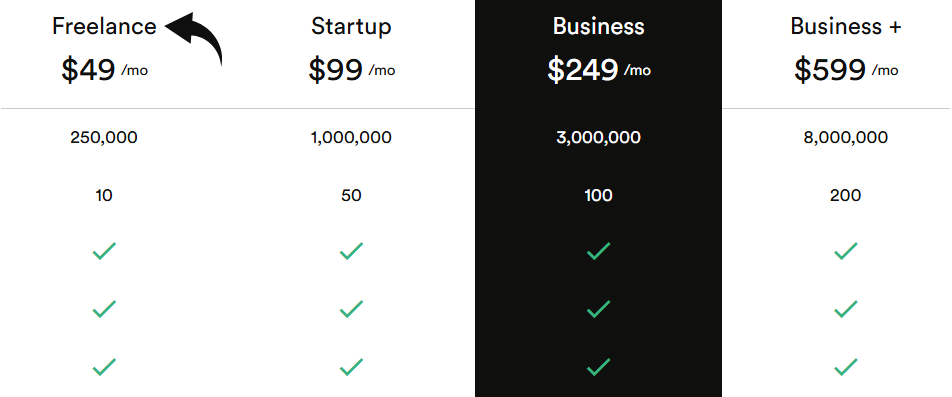

Wycena

Wszystkie plany będą rozliczane rocznie.

- Pracownik nieetatowy: 49 USD/miesiąc.

- Uruchomienie: 99 USD/miesiąc.

- Biznes: 249 USD/miesiąc.

- Biznes+: 599 USD/miesiąc.

Zalety

Wady

3. Oxylabs (⭐4.0)

Oxylabs to zaufany gigant danych. Wykorzystuje również sztuczną inteligencję w swoich narzędziach do scrapowania.

Ich siła leży w dostarczaniu ogromnych ilości czystych, zlokalizowanych danych.

Oni robić upewnij się, że nie zostaniesz zablokowany przez witryny internetowe.

Nasze podejście

Odblokuj dane dzięki wiodącej usłudze proxy. Z ponad 175 milionami serwerów proxy domowych, 2 milionami dedykowanych serwerów proxy w centrach danych i 20 milionami serwerów proxy mobilnych, Oxylabs zapewnia adresy IP potrzebne do każdego projektu.

Kluczowe korzyści

- Asystent AI OxyCopilot: To narzędzie umożliwia generowanie żądań scrapowania przy użyciu prostego, naturalnego języka.

- Ogromna sieć proxy: Posiada jedną z największych pul serwerów proxy na świecie, obejmującą adresy IP ze 195 krajów.

- Gwarancja sukcesu: Oparte na sztucznej inteligencji odciski palców platformy i omijanie testu CAPTCHA gwarantują wysoki wskaźnik powodzenia nawet w przypadku najtrudniejszych witryn.

- Bezpieczeństwo klasy korporacyjnej: Platforma posiada certyfikat ISO/IEC 27001:2022, co gwarantuje wysoki poziom bezpieczeństwa i prywatności danych.

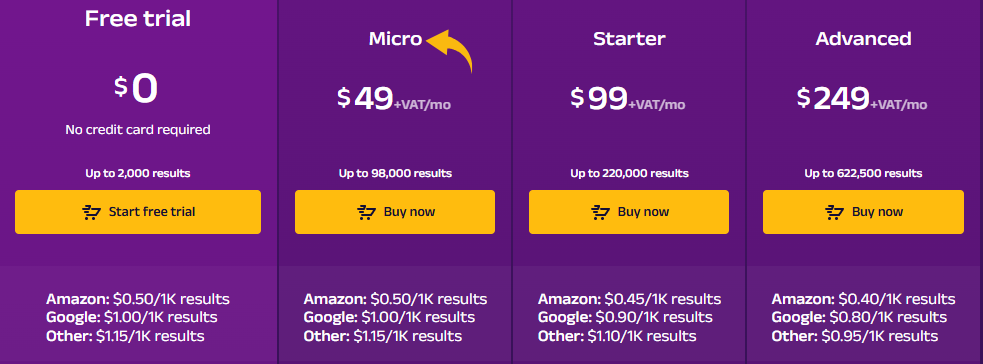

Wycena

- Bezpłatny okres próbny: $0.

- Mikro: 49 USD/miesiąc + VAT.

- Rozrusznik: 99 USD/miesiąc + VAT.

- Zaawansowany: 249 USD/miesiąc + VAT.

Zalety

Wady

4. ScrapeGraphAI (⭐3.8)

To narzędzie oparte na sztucznej inteligencji. Wykorzystuje podpowiedzi językowe do wyodrębniania ustrukturyzowanych danych.

Powiedz mu, czego chcesz, prostym językiem.

Doskonale nadaje się do szkolenia LLM-ów i tworzenia agentów AI.

Nasze podejście

Wiodący specjaliści (ponad 350 osób) zaufali ScrapeGraphAI ze względu na jego solidne, oparte na sztucznej inteligencji możliwości scrapowania stron internetowych. Zapewnij sobie 20% wzrost wydajności na kolejne 48 godzin.

Kluczowe korzyści

- Scraping języka naturalnego: Możesz wskazać mu, co ma wyodrębnić, używając prostych, zrozumiałych dla człowieka monitów.

- Biblioteka Open Source: Deweloperzy mogą wykorzystać jego wszechstronną bibliotekę typu open-source, aby uzyskać maksymalną kontrolę.

- Funkcja Markdownify: Potrafi konwertować całe strony internetowe na przejrzyste, czytelne dokumenty Markdown.

- Agentic Scraper: Sztuczna inteligencja potrafi autonomicznie poruszać się po stronach internetowych i wchodzić z nimi w interakcje, wykonując złożone, wieloetapowe zadania.

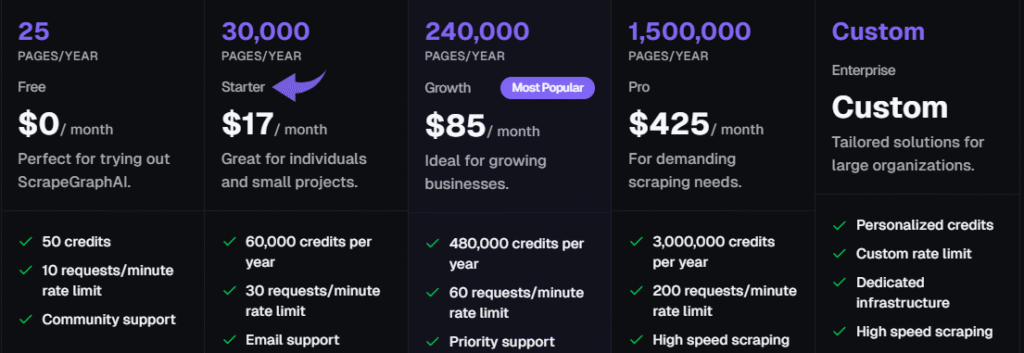

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: 0 zł/miesiąc.

- Rozrusznik: 17 USD/miesiąc.

- Wzrost: 85 USD/miesiąc.

- Zawodowiec: 425 USD/miesiąc.

- Przedsiębiorstwo: Indywidualne ceny.

Zalety

Wady

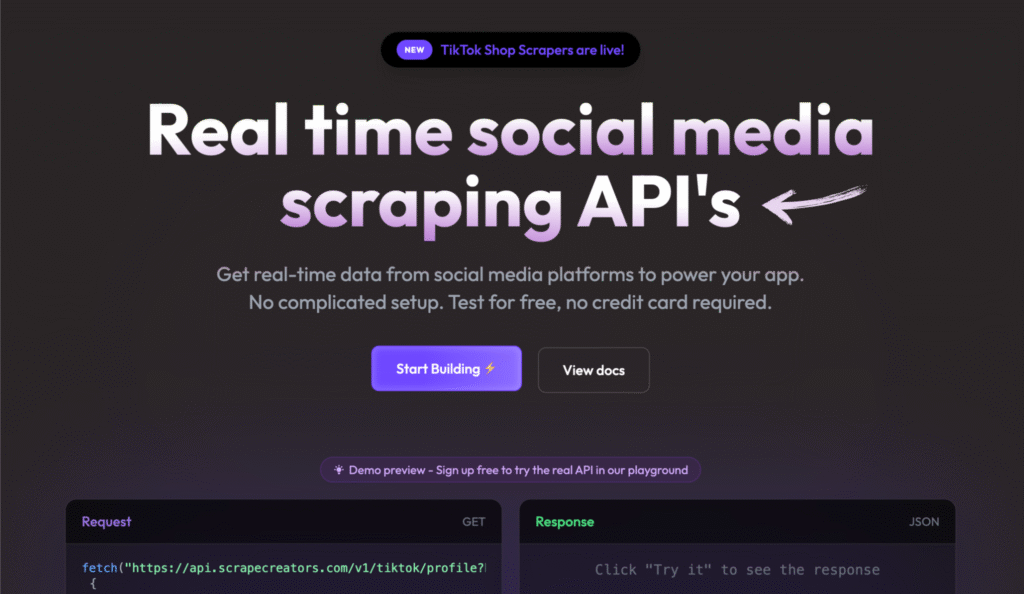

5. Twórcy scrapowania (⭐3.5)

Scrape Creators to prosty interfejs API danych.

Jest szczególnie silny w obsłudze media społecznościowe dane.

Jeśli musisz śledzić TikTok lub reklamy na Facebooku, to jest najlepszy wybór.

Oferują prosty model płatności „płać za zużycie”.

Nasze podejście

Nie musisz już męczyć się ze zbieraniem danych z mediów społecznościowych. Dzięki Scrape Creators uzyskasz dane w czasie rzeczywistym z platform takich jak Twitch i Pinterest. Dołącz do setek użytkowników, którzy zebrali ponad 6 milionów zapytań i uzyskaj potrzebne Ci informacje.

Kluczowe korzyści

- Specjalistyczne interfejsy API: Oferuje gotowe rozwiązania przeznaczone specjalnie dla platform mediów społecznościowych.

- Nie potrzeba kluczy API: Możesz ominąć konieczność posiadania oficjalnych kluczy API w przypadku witryn takich jak Twitch.

- Płać za zużycie: Płacisz tylko za to, z czego korzystasz, a Twoje środki nigdy nie wygasają.

- Bogate dane JSON: Interfejsy API udostępniają czyste i ustrukturyzowane dane JSON, dzięki czemu nie musisz wykonywać dodatkowego przetwarzania.

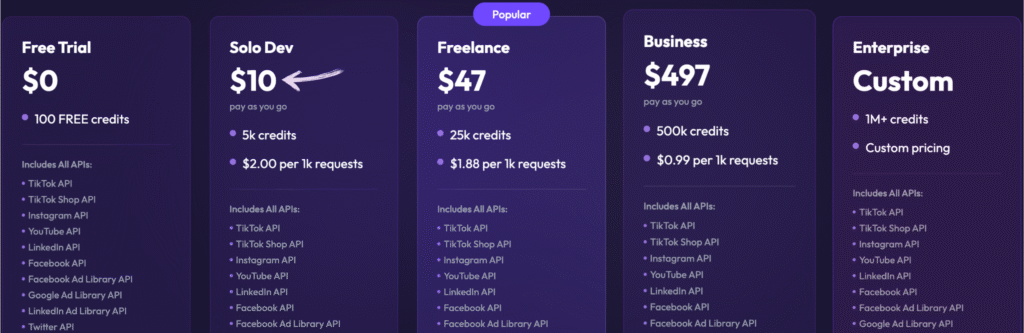

Wycena

- Bezpłatny okres próbny: 0, 100 darmowych kredytów.

- Solo Dev: 10 USD – Płać w miarę użytkowania, 5 tys. kredytów.

- Pracownik nieetatowy: 47 USD – Płać w miarę użytkowania, 25 tys. kredytów.

- Biznes: 497 USD – Płać w miarę użytkowania, 500 tys. kredytów.

- Przedsiębiorstwo: Cena niestandardowa, ponad 1 mln kredytów.

Zalety

Wady

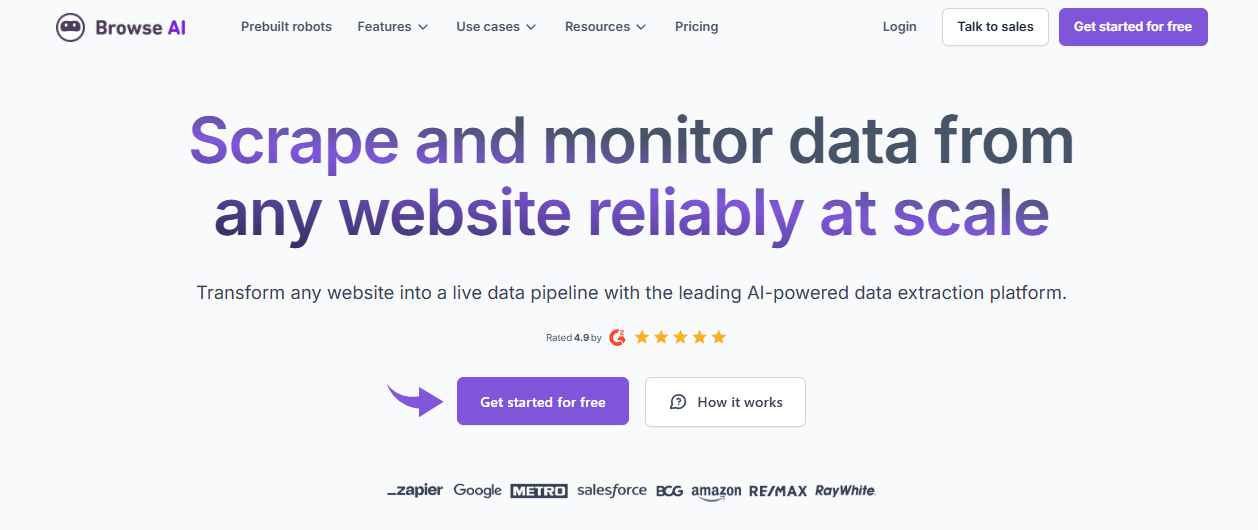

6. Przeglądaj AI (⭐3.2)

Nie lubisz pisać kodu? Browse AI to najlepsze narzędzie bez kodu.

Klikając na stronie internetowej, można nauczyć „robota”.

Świetnie nadaje się do śledzenia cen konkurencji lub tworzenia prostych monitorów.

Nasze podejście

Chcesz zaoszczędzić czas i uzyskać potrzebne dane? Browse AI poradzi sobie z milionami stron internetowych. Zobacz, jak łatwe może być scrapowanie stron internetowych.

Kluczowe korzyści

- Kod nie jest wymagany: Dzięki interfejsowi typu „wskaż i kliknij” każdy może w ciągu kilku minut stworzyć narzędzie do pozyskiwania danych.

- Adaptacja wspomagana przez sztuczną inteligencję: Narzędzie automatycznie dostosowuje się do zmian w układzie witryny, zapewniając zawsze spójność danych.

- Ponad 7000 integracji: Łatwo połącz zebrane dane z aplikacjami takimi jak Arkusze Google, Airtable i Zapier.

- Gotowe roboty: Uzyskaj dostęp do biblioteki gotowych robotów przeznaczonych do wykonywania typowych zadań na popularnych stronach internetowych, oszczędzając jeszcze więcej czasu.

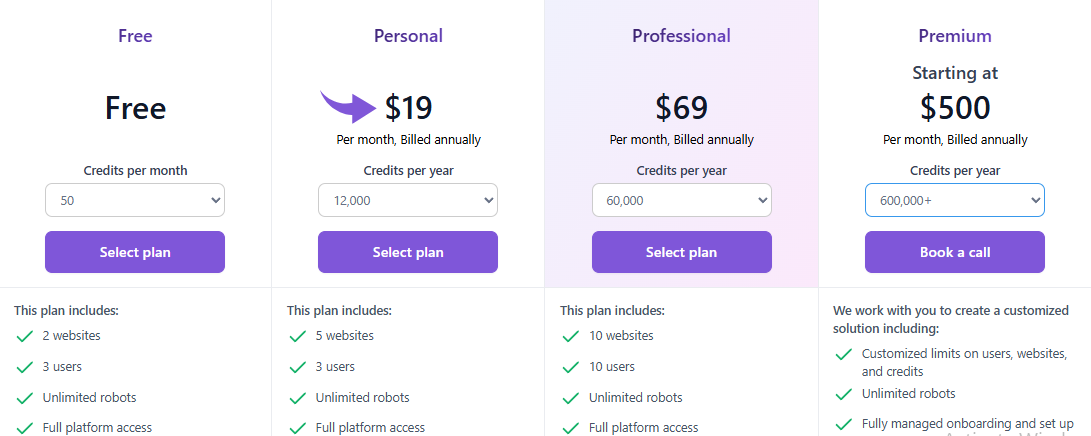

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: $0.

- Osobisty: 19 USD/miesiąc.

- Profesjonalny: 69 USD/miesiąc.

- Premia: Od 500 USD/miesiąc.

Zalety

Wady

7. Zyte (⭐3.0)

Zyte nazywał się dawniej Scrapinghub.

Jest w grze od dłuższego czasu.

Oferuje potężny interfejs API i hosting w chmurze dla niestandardowych scraperów.

Ich opatentowana sztuczna inteligencja pomaga Ci z łatwością omijać blokady stron internetowych.

Nasze podejście

Uzyskaj najbardziej niezawodną sieć dane z API Zyte. Osiągnij 99,99% dokładności danych w swoich projektach dzięki temu wysokiej jakości API do scrapowania stron internetowych i usprawnij proces ekstrakcji danych już dziś.

Kluczowe korzyści

- Automatyczne odblokowywanie: Przestań żonglować serwerami proxy; Zyte API to potężne, zautomatyzowane narzędzie do obsługi banów.

- Bezproblemowa integracja ze Scrapy: Jeśli jesteś programistą korzystającym z frameworka Scrapy, Zyte będzie dla Ciebie idealnym rozwiązaniem.

- Ekstrakcja danych wspomagana sztuczną inteligencją: Narzędzie może automatycznie identyfikować i analizować dane, zmniejszając potrzebę ręcznego stosowania reguł analizy.

- Zintegrowana przeglądarka bez interfejsu: Nie ma potrzeby korzystania z przeglądarek bezgłowych innych firm, ponieważ Zyte udostępnia przeglądarkę zoptymalizowaną pod kątem scrapowania stron internetowych na dużą skalę.

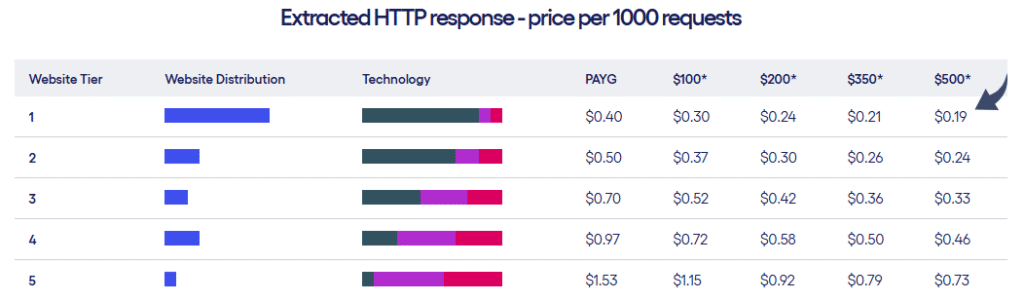

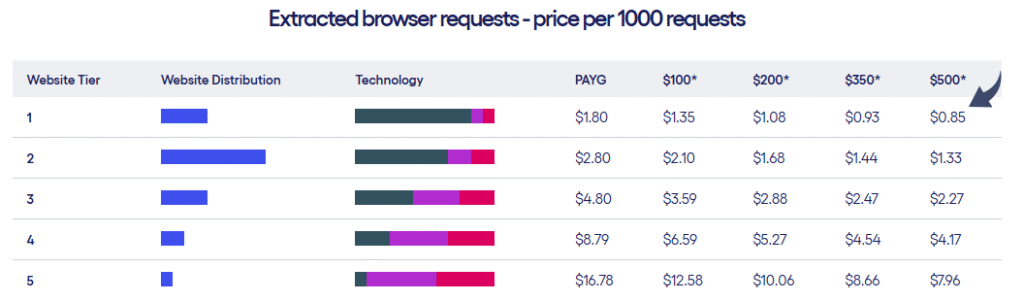

Wycena

- Zyte oferuje dwa rodzaje planów cenowych w zależności od poziomu witryn i liczby żądań.

Zalety

Wady

Przewodnik kupującego

Wiemy, że wybór odpowiedniego narzędzia ma kluczowe znaczenie dla Twoich potrzeb w zakresie danych.

Oceniając najlepsze alternatywy dla Firecrawl, skupiliśmy się na konkretnych czynnikach, które mają największe znaczenie dla naukowców zajmujących się danymi i biznes właścicieli aplikacji wykorzystujących sztuczną inteligencję.

Oto kroki i czynniki, które uznaliśmy za najważniejsze:

- Ekstrakcja danych wspomagana sztuczną inteligencjąCzy narzędzie wykorzystuje duże modele językowe (LLM) lub uczenie maszynowe do inteligentnego gromadzenia danych? Sprawdziliśmy zaawansowane funkcje, takie jak konwersja całych stron internetowych do czystego kodu Markdown lub ekstrakcja ustrukturyzowanych danych za pomocą komunikatów w języku naturalnym, co jest niezbędne do szkolenia sztucznej inteligencji i przepływów pracy z wykorzystaniem sztucznej inteligencji.

- Obsługa złożonych witryn internetowychCzy narzędzia do scrapowania stron internetowych radzą sobie z nowoczesnymi witrynami z dużą ilością JavaScriptu lub witrynami z dużą ilością JavaScriptu? Obejmuje to ocenę możliwości narzędzia w zakresie obsługi pełnej wersji przeglądarki. automatyzacja przetwarzać, obsługiwać odcisk palca przeglądarki i obsługiwać dynamiczną zawartość, którą zwykle można znaleźć na stronach internetowych, takich jak Mapy Google, w celu niezawodnego wyodrębniania danych.

- Skalowalność i niezawodność:Przyjrzeliśmy się infrastrukturze, w tym rotacji serwerów proxy i zarządzaniu sesjami, aby upewnić się, że narzędzie poradzi sobie z operacjami na dużą skalę i będzie Twoim podstawowym narzędziem. Narzędzia takie jak Jasne dane Są z tego znani. Przyjrzeliśmy się również wersji hostowanej i wersji hostowanej samodzielnie, która działa na własnej infrastrukturze, spełniając różne potrzeby.

- Doświadczenie programisty i elastyczność narzędziCzy to narzędzie to prosty interfejs API do scrapowania stron internetowych, czy kompletne rozwiązanie? Sprawdziliśmy, czy obsługuje zaawansowane elementy sterujące przeglądarki, umożliwia tworzenie niestandardowego kodu i zapewnia potok danych do eksportowania danych w wielu formatach. W przypadku opcji open source, szukaliśmy biblioteki Pythona o otwartym kodzie źródłowym lub darmowego narzędzia o otwartym kodzie źródłowym.

- Koszt i dostępnośćPorównaliśmy modele cenowe, szukając dobrego darmowego planu, przystępnych cenowo opcji i transparentności w zakresie cen dla przedsiębiorstw. Sprawdziliśmy również dostępność bezpłatnych okresów próbnych oraz to, czy platforma jest dostępna dla użytkowników z minimalną wiedzą techniczną lub umiejętnościami, a nie wymaga cen niestandardowych.

- Ekosystem i wsparcie:Czy platforma ma aktywne wsparcie społeczności, wysokiej jakości dokumentację techniczną pisarzi dodatkowe narzędzia do obsługi złożonych przepływów pracy? Przyjrzeliśmy się integracjom z bazami danych wektorowych i możliwościom takim jak generowanie rozszerzone o wyszukiwanie (RAG) czy lokalne wsparcie LLM. Szukaliśmy w szczególności tabeli porównawczej alternatyw dla FireCrawl lub prostego przykładu, aby ocenić ich kluczowe funkcje.

- Wydajność i efektywnośćJak szybko narzędzie może wykonywać żądania sieciowe i przetwarzać zawartość strony? Sprawdziliśmy, czy oferują biblioteki, w których można łatwo importować asyncio i oczekiwać na przeglądarkę, aby szybko pobrać potrzebne dane ze struktury strony, nie obciążając nadmiernie zasobów.

Podsumowanie

Wybór odpowiedniego narzędzia jest kluczowy przy poważnej pracy z danymi.

Pokazaliśmy Ci siedem świetnych alternatyw dla Firecrawl.

Wszystkie dobrze radzą sobie z danymi ze stron internetowych. Co najważniejsze, są zbudowane z wykorzystaniem nowoczesnych technologii. Narzędzia AI.

Oznacza to, że potrafią obsługiwać nowoczesne witryny, strony z dużą ilością JavaScriptu i szybko dostarczać czyste dane.

Nie zadowalaj się narzędziem, które Cię ogranicza.

Poświęciliśmy wiele godzin na badania, abyś Ty nie musiał tracić czasu ani pieniędzy.

Masz teraz najlepszą listę, która pomoże Ci dokonać mądrego wyboru dla Twoich projektów!

Często zadawane pytania

Czy te narzędzia AI do scrapowania stron internetowych obsługują wszystkie przeglądarki internetowe?

Większość narzędzi w chmurze jest niezależna od przeglądarki. Jednak narzędzia dla programistów, takie jak Playwright, obsługują wszystkie główne przeglądarki (Chromium, Firefox, WebKit), zapewniając pełną automatyzację przeglądarek.

Czy mogę uruchomić którykolwiek z tych programów do scrapowania bez połączenia z Internetem?

Tak, niektóre rozwiązania typu open source, takie jak Crawl4AI, są zaprojektowane tak, aby działać całkowicie offline, gdy na etapie ekstrakcji sztucznej inteligencji stosuje się modele lokalne (takie jak Ollama).

Które alternatywy dla Firecrawl oferują dużą bibliotekę gotowych narzędzi do scrapowania?

Apify to doskonały wybór. Oferuje ogromną bibliotekę ponad 9000 gotowych do użycia „aktorów” (scraperów), które można wdrożyć. natychmiast, oszczędzając Twój czas.

Czy służą one tylko do ekstrakcji danych, czy oferują również inne narzędzia?

Najlepsze platformy, takie jak Bright Data i Zyte, zapewniają kompleksowe warstwy infrastruktury. Oferują funkcje zapobiegające blokowaniu, sieci proxy i inne narzędzia do skalowania aplikacji AI.

Czy mogę zintegrować własne lokalne modele sztucznej inteligencji do analizy danych?

Tak, inne narzędzia, takie jak ScrapeGraphAI i Crawl4AI, są elastyczne. Umożliwiają łączenie modeli lokalnych i modeli LLM, dając pełną kontrolę nad procesem przetwarzania danych.