Czy chcesz uzyskać potrzebne dane bez zbędnych problemów?

To frustrujące, gdy spędzasz więcej czasu na zarządzaniu swoimi skrobak niż praca.

Niewłaściwe narzędzie może zamienić zwykłe zadanie w poważny obowiązek.

A co, gdybyś mógł znaleźć narzędzie do scrapowania stron internetowych, które idealnie odpowiadałoby Twoim potrzebom?

W tym artykule pokażemy Ci najlepsze Apify alternatywy, dzięki którym możesz przestać martwić się procesem scrapowania i zacząć skupiać się na tym, co naprawdę ważne.

Jakie są najlepsze alternatywy dla Apify?

Czy czujesz, że Twoja obecna konfiguracja web scrapingu Cię nie wystarcza?

Szukasz lepszego sposobu pozyskiwania danych z sieci?

Może masz już dość skomplikowanych konfiguracji i zaskakujących kosztów. Przygotowaliśmy listę najlepszych narzędzi, które oferują to samo, co Apify.

Znajdź tę właściwą dla siebie i zacznij scrapować pewnie.

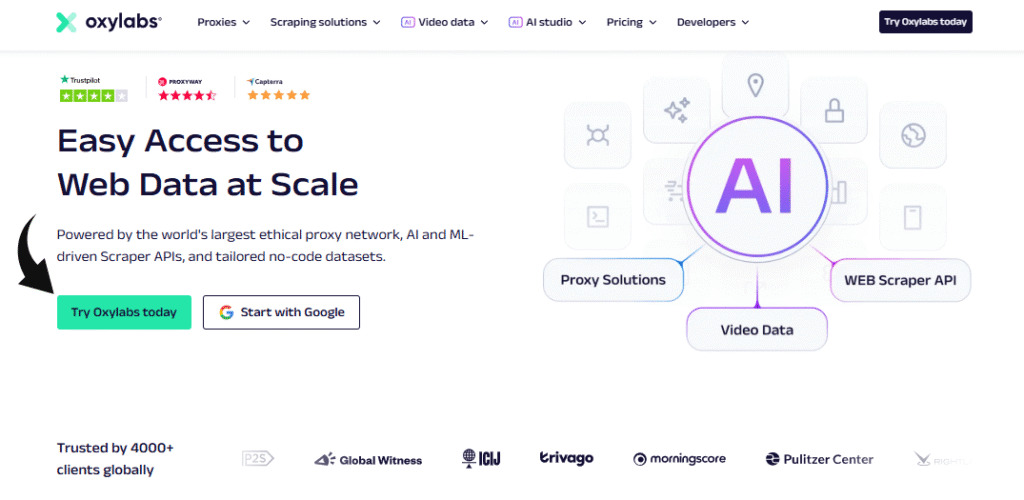

1. Oxylabs (⭐4,8)

Oxylabs to gigant w świecie scrapowania stron internetowych.

To świetny wybór, jeśli potrzebujesz dużej mocy i niezawodności przy ekstrakcji danych.

Oferują również API Web Scraper, które zajmie się wszystkimi trudnymi zadaniami, łącznie ze złożonym zarządzaniem serwerami proxy.

Ta chmurowa platforma do scrapowania stron internetowych może pomóc Ci wyodrębniać dane na dużą skalę i z dużą skutecznością.

Oferuje również konkretne rozwiązania dla Jasne dane, co czyni go dobrym wyborem dla projektów na poziomie korporacyjnym.

Nasze podejście

Odblokuj dane dzięki wiodącej usłudze proxy. Z ponad 175 milionami serwerów proxy domowych, 2 milionami dedykowanych serwerów proxy w centrach danych i 20 milionami serwerów proxy mobilnych, Oxylabs zapewnia adresy IP potrzebne do każdego projektu.

Kluczowe korzyści

- Asystent AI OxyCopilot: To narzędzie umożliwia generowanie żądań scrapowania przy użyciu prostego, naturalnego języka.

- Ogromna sieć proxy: Posiada jedną z największych pul serwerów proxy na świecie, obejmującą adresy IP ze 195 krajów.

- Gwarancja sukcesu: Oparte na sztucznej inteligencji odciski palców platformy i omijanie testu CAPTCHA gwarantują wysoki wskaźnik powodzenia nawet w przypadku najtrudniejszych witryn.

- Bezpieczeństwo klasy korporacyjnej: Platforma posiada certyfikat ISO/IEC 27001:2022, co gwarantuje wysoki poziom bezpieczeństwa i prywatności danych.

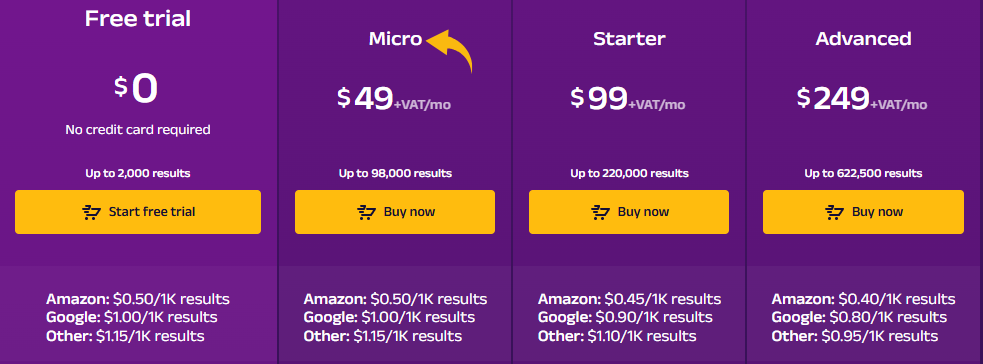

Wycena

- Bezpłatny okres próbny: $0.

- Mikro: 49 USD/miesiąc + VAT.

- Rozrusznik: 99 USD/miesiąc + VAT.

- Zaawansowany: 249 USD/miesiąc + VAT.

Zalety

Wady

2. ScrapingBee (⭐4.5)

ScrapingBee to proste i efektywne API do scrapowania stron internetowych.

Jest naprawdę łatwy w użyciu, nawet dla początkujących.

Zawiera również funkcje zapobiegające blokowaniu.

Platforma oferuje łatwy w obsłudze interfejs API, za pomocą którego deweloperzy mogą zbierać dane. Na początek dostępny jest nawet bezpłatny plan.

To solidna platforma do scrapowania stron internetowych, która pomaga ominąć trudne zabezpieczenia przed botami.

Nasze podejście

Zdobądź dane Potrzebujesz ich z ponad 98% stron internetowych. Potężne API do scrapowania stron internetowych ScrapingBee oferuje renderowanie JavaScript, API wyszukiwarki Google oraz możliwość ekstrakcji danych strukturalnych z dokładnością do 99,5% na stronach dynamicznych.

Kluczowe korzyści

- Zajmie się wszystkim za Ciebie: Zarządza automatycznie rotacją serwerów proxy i renderowaniem JavaScript.

- Proste API: Za pomocą jednego, prostego wywołania API otrzymasz czyste dane.

- 99,9% czasu sprawności: Platforma charakteryzuje się wysoką niezawodnością i stabilną wydajnością.

- Obszerna dokumentacja: Zawiera przejrzystą i wyczerpującą dokumentację z przykładami kodu dla wielu języków, co ułatwia rozpoczęcie pracy.

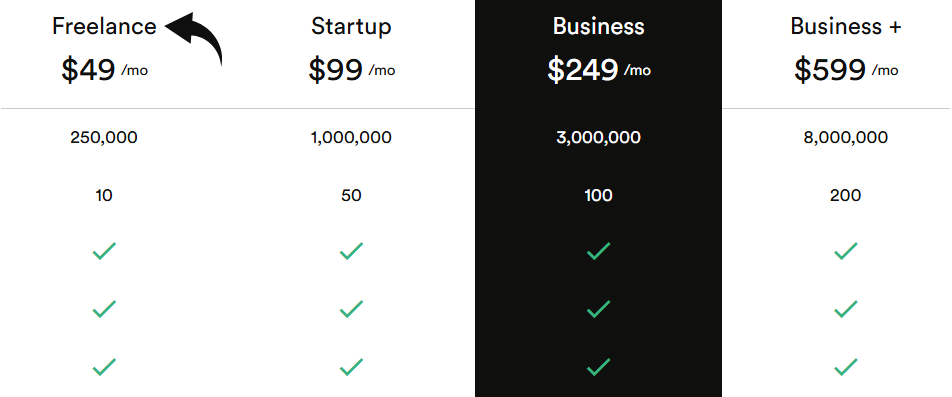

Wycena

Wszystkie plany będą rozliczane rocznie.

- Pracownik nieetatowy: 49 USD/miesiąc.

- Uruchomienie: 99 USD/miesiąc.

- Biznes: 249 USD/miesiąc.

- Biznes+: 599 USD/miesiąc.

Zalety

Wady

3. Przeglądaj AI (⭐4.0)

To świetna opcja, jeśli nie jesteś użytkownikiem technicznym.

Możesz użyć interfejsu „wskaż i kliknij”, aby wyszkolić robota. To idealne rozwiązanie do szybkiego pobierania istotnych danych z dowolnej witryny, nawet tej z dynamicznymi stronami.

Można również skonfigurować ją tak, aby monitorowała strony internetowe pod kątem zmian i zapisywała dane bezpośrednio w Arkuszach Google.

Nasze podejście

Chcesz zaoszczędzić czas i uzyskać potrzebne dane? Browse AI poradzi sobie z milionami stron internetowych. Zobacz, jak łatwe może być scrapowanie stron internetowych.

Kluczowe korzyści

- Kod nie jest wymagany: Dzięki interfejsowi typu „wskaż i kliknij” każdy może w ciągu kilku minut stworzyć narzędzie do pozyskiwania danych.

- Adaptacja wspomagana przez sztuczną inteligencję: Narzędzie automatycznie dostosowuje się do zmian w układzie witryny, zapewniając zawsze spójność danych.

- Ponad 7000 integracji: Łatwo połącz zebrane dane z aplikacjami takimi jak Arkusze Google, Airtable i Zapier.

- Gotowe roboty: Uzyskaj dostęp do biblioteki gotowych robotów przeznaczonych do wykonywania typowych zadań na popularnych stronach internetowych, oszczędzając jeszcze więcej czasu.

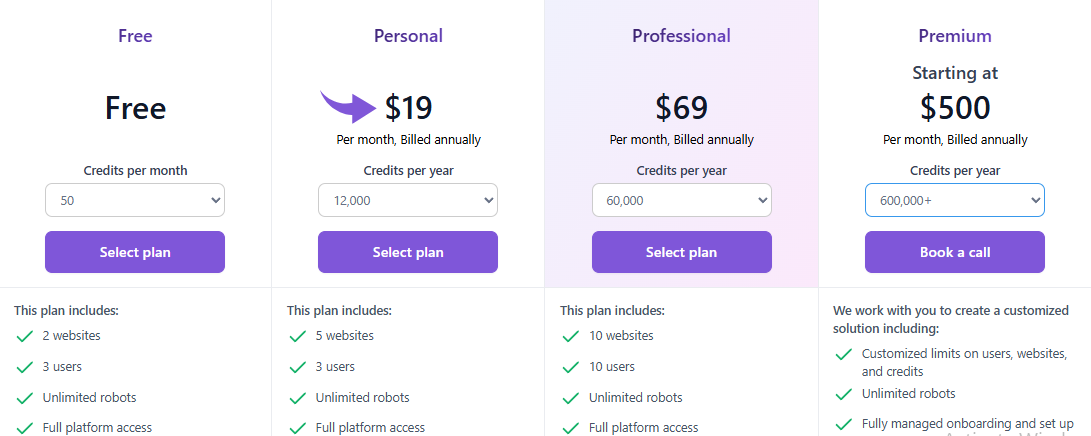

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: $0.

- Osobisty: 19 USD/miesiąc.

- Profesjonalny: 69 USD/miesiąc.

- Premia: Od 500 USD/miesiąc.

Zalety

Wady

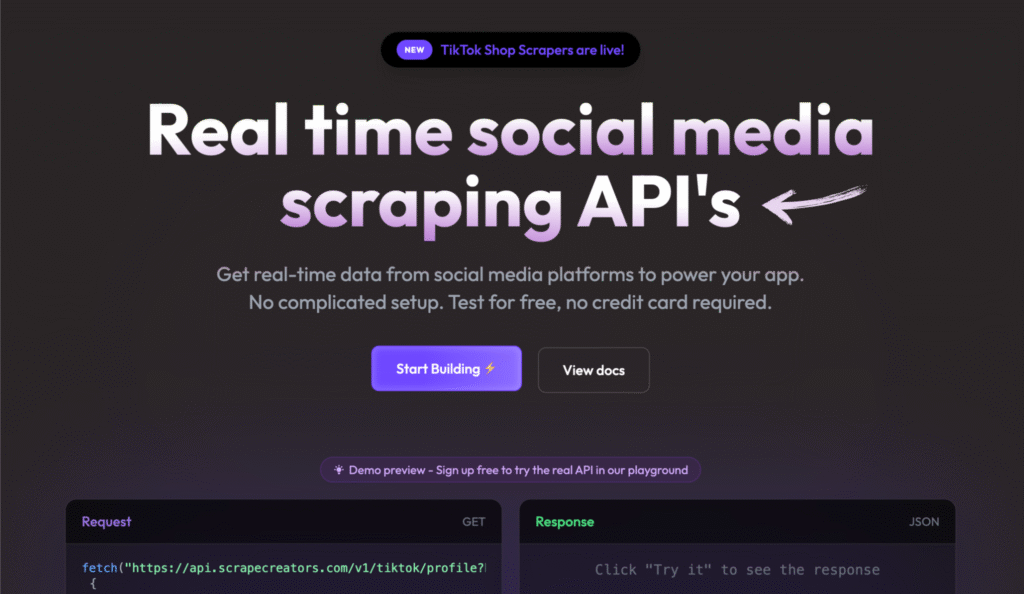

4. Twórcy scrapowania (⭐3.8)

Scrape Creators to specjalistyczne narzędzie. Zostało stworzone specjalnie dla media społecznościowe skrobanie.

Jeśli potrzebujesz danych z platform takich jak YouTube lub Instagram, to jest najlepszy wybór.

Posiada również model płatności „pay-as-you-go”, co oznacza, że płacisz tylko za to, z czego korzystasz.

Zebrane dane dostarczane są w czystym formacie, co oszczędza Ci mnóstwo pracy ręcznej.

Nasze podejście

Nie musisz już męczyć się ze zbieraniem danych z mediów społecznościowych. Dzięki Scrape Creators uzyskasz dane w czasie rzeczywistym z platform takich jak Twitch i Pinterest. Dołącz do setek użytkowników, którzy zebrali ponad 6 milionów zapytań i uzyskaj potrzebne Ci informacje.

Kluczowe korzyści

- Specjalistyczne interfejsy API: Oferuje gotowe rozwiązania przeznaczone specjalnie dla platform mediów społecznościowych.

- Nie potrzeba kluczy API: Możesz ominąć konieczność posiadania oficjalnych kluczy API w przypadku witryn takich jak Twitch.

- Płać za zużycie: Płacisz tylko za to, z czego korzystasz, a Twoje środki nigdy nie wygasają.

- Bogate dane JSON: Interfejsy API udostępniają czyste i ustrukturyzowane dane JSON, dzięki czemu nie musisz wykonywać dodatkowego przetwarzania.

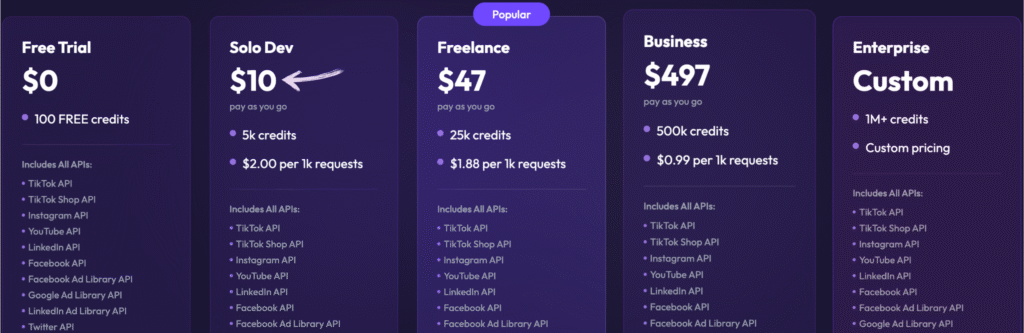

Wycena

- Bezpłatny okres próbny: 0, 100 darmowych kredytów.

- Solo Dev: 10 USD – Płać w miarę użytkowania, 5 tys. kredytów.

- Pracownik nieetatowy: 47 USD – Płać w miarę użytkowania, 25 tys. kredytów.

- Biznes: 497 USD – Płać w miarę użytkowania, 500 tys. kredytów.

- Przedsiębiorstwo: Cena niestandardowa, ponad 1 mln kredytów.

Zalety

Wady

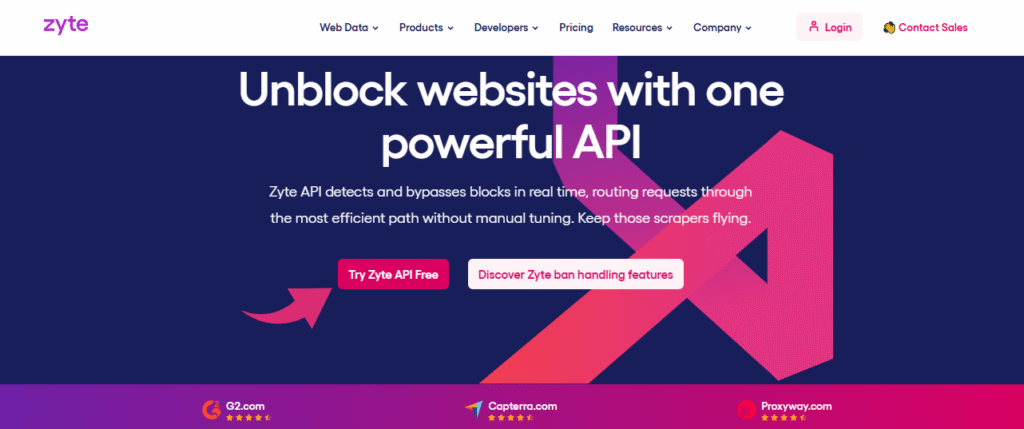

5. Zyte (⭐3,5)

Zyte to potężna i elastyczna platforma do scrapowania stron internetowych.

Świetnie sprawdza się w przypadku większych projektów. Posiada superinteligentne API, które automatycznie wybiera najlepszy sposób scrapowania witryny.

Oferuje również opcję pełnego serwisu, w ramach której zespół może zająć się wszystkim za Ciebie.

Platforma ta oferuje rozbudowane funkcje gromadzenia danych, a nawet specjalne narzędzia do pozyskiwania danych z Google Maps i innych popularnych usług.

Nasze podejście

Uzyskaj najbardziej niezawodną sieć dane z API Zyte. Osiągnij 99,99% dokładności danych w swoich projektach dzięki temu wysokiej jakości API do scrapowania stron internetowych i usprawnij proces ekstrakcji danych już dziś.

Kluczowe korzyści

- Automatyczne odblokowywanie: Przestań żonglować serwerami proxy; Zyte API to potężne, zautomatyzowane narzędzie do obsługi banów.

- Bezproblemowa integracja ze Scrapy: Jeśli jesteś programistą korzystającym z frameworka Scrapy, Zyte będzie dla Ciebie idealnym rozwiązaniem.

- Ekstrakcja danych wspomagana sztuczną inteligencją: Narzędzie może automatycznie identyfikować i analizować dane, zmniejszając potrzebę ręcznego stosowania reguł analizy.

- Zintegrowana przeglądarka bez interfejsu: Nie ma potrzeby korzystania z przeglądarek bezgłowych innych firm, ponieważ Zyte udostępnia przeglądarkę zoptymalizowaną pod kątem scrapowania stron internetowych na dużą skalę.

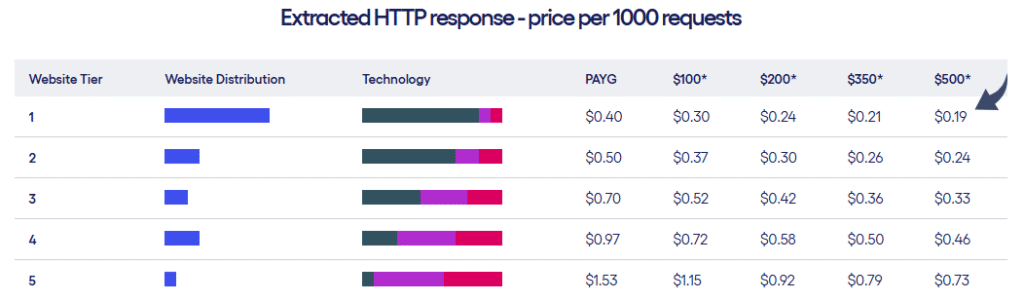

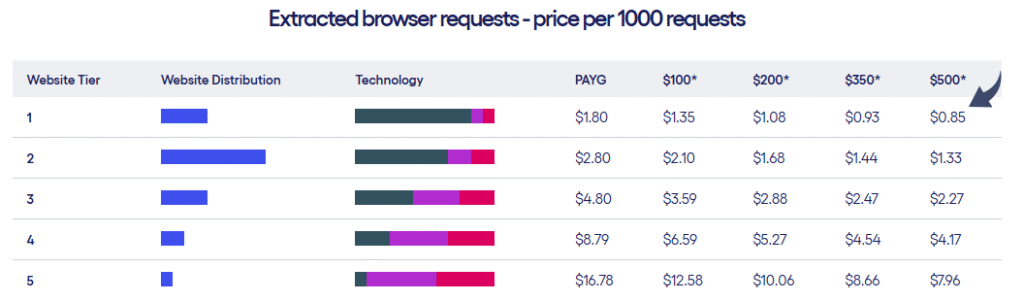

Wycena

- Zyte oferuje dwa rodzaje planów cenowych w zależności od poziomu witryn i liczby żądań.

Zalety

Wady

6. Sztuczna inteligencja ScrapeGraph (⭐3.2)

To naprawdę świetne narzędzie do ekstrakcji danych oparte na sztucznej inteligencji.

Po prostu powiedz mu, czego chcesz, prostym językiem.

Na przykład wyodrębnij z tej strony wszystkie nazwy produktów i ceny.

Resztą zajmie się sztuczna inteligencja.

To szybki sposób na zdobycie istotnych danych i uproszczenie całego procesu.

Nasze podejście

Wiodący specjaliści (ponad 350 osób) zaufali ScrapeGraphAI ze względu na jego solidne, oparte na sztucznej inteligencji możliwości scrapowania stron internetowych. Zapewnij sobie 20% wzrost wydajności na kolejne 48 godzin.

Kluczowe korzyści

- Scraping języka naturalnego: Możesz wskazać mu, co ma wyodrębnić, używając prostych, zrozumiałych dla człowieka monitów.

- Biblioteka Open Source: Deweloperzy mogą wykorzystać jego wszechstronną bibliotekę typu open-source, aby uzyskać maksymalną kontrolę.

- Funkcja Markdownify: Potrafi konwertować całe strony internetowe na przejrzyste, czytelne dokumenty Markdown.

- Agentic Scraper: Sztuczna inteligencja potrafi autonomicznie poruszać się po stronach internetowych i wchodzić z nimi w interakcje, wykonując złożone, wieloetapowe zadania.

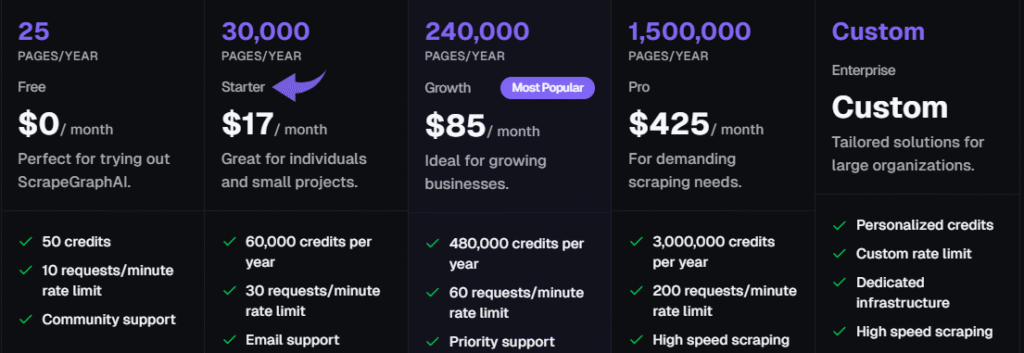

Wycena

Wszystkie plany będą rozliczane rocznie.

- Bezpłatny: 0 zł/miesiąc.

- Rozrusznik: 17 USD/miesiąc.

- Wzrost: 85 USD/miesiąc.

- Zawodowiec: 425 USD/miesiąc.

- Przedsiębiorstwo: Indywidualne ceny.

Zalety

Wady

7. ThorData (⭐3.0)

ThorData to kolejne solidne rozwiązanie do zarządzania serwerami proxy i ich pozyskiwania.

Świetnie nadaje się dla zespołów, które muszą zbierać dane z określonych krajów.

Posiada ogromną pulę adresów IP domowych i mobilnych.

Oferuje również nieograniczony plan dla dużych projektów, dzięki czemu jest doskonałym wyborem w przypadku gromadzenia danych na dużą skalę.

Oferują nawet narzędzie do scrapowania stron internetowych bez konieczności pisania kodu i gotowe zestawy danych.

Nasze podejście

Ciesz się niezrównanym bezpieczeństwem dzięki ThorData. To dane Proces weryfikacji gwarantuje 99,7% skuteczności. Dzięki całodobowemu wsparciu na żywo i średniemu czasowi reakcji poniżej 3 minut możesz być pewien jakości połączenia. Uzyskaj ponad 60 milionów adresów IP i zabezpiecz swoje dane.

Kluczowe korzyści

- Ogromna pula adresów IP: Oferuje ponad 60 milionów etycznie pozyskanych adresów IP.

- Wysoka anonimowość: Zapewnia, że Twoja aktywność scrapowania pozostanie niewykryta dzięki wysokiej jakości serwerom proxy.

- Płać za zużycie: Rozliczenia są przejrzyste: płacisz tylko za wykorzystany ruch, a nie za nieudane żądania.

- Wbudowany skrobak: Zawiera narzędzie do scrapowania stron internetowych bez kodu i uniwersalny interfejs API, dzięki czemu nie potrzebujesz osobnego narzędzia do prostych projektów.

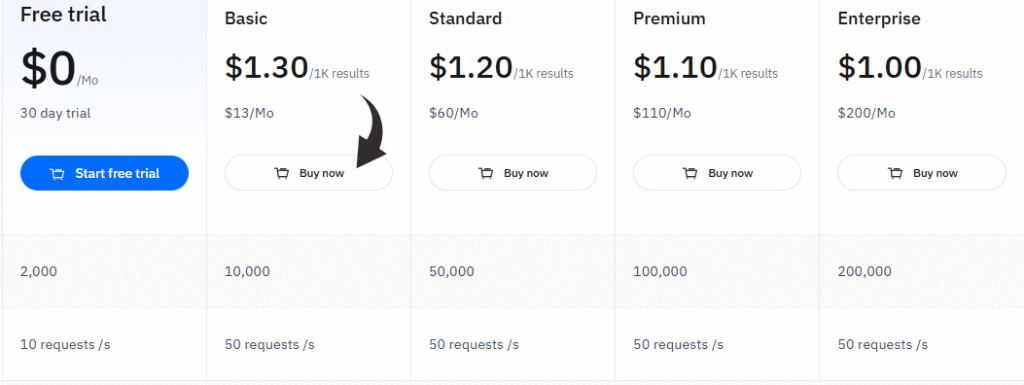

Wycena

- Bezpłatny okres próbny: 0 USD/miesiąc, 30-dniowy okres próbny.

- Podstawowy: 13 USD/miesiąc.

- Standard: 60 USD/miesiąc.

- Premia: 110 USD/miesiąc.

- Przedsiębiorstwo: 200 dolarów miesięcznie.

Zalety

Wady

Przewodnik kupującego

Wiemy, jak ważny jest wybór odpowiedniego narzędzia.

Dlatego zastosowaliśmy szczegółowy proces w celu znalezienia najlepszych opcji do tej listy.

Naszym celem było pomóc Ci znaleźć narzędzie do scrapowania stron internetowych, dzięki któremu scrapowanie stanie się łatwiejsze i skuteczniejsze.

Przyjrzyjmy się, w jaki sposób przeprowadziliśmy badania mające na celu znalezienie najlepszych produktów na rynku.

Nasz proces badawczy:

- Wycena:Przyjrzeliśmy się kosztom każdego narzędzia, w tym wszelkim opcjom planów bezpłatnych i różnym poziomom planów płatnych. Zastanawialiśmy się, co otrzymujesz za swoje pieniądze i czy model cenowy za korzystanie z proxy jest jasny i przewidywalny. Szukaliśmy również przejrzystych cen, aby ułatwić planowanie na potrzeby danych na dużą skalę.

- Cechy: Dogłębnie przeanalizowaliśmy możliwości każdego produktu. Szukaliśmy kluczowych funkcji, takich jak rotacja adresów IP, media społecznościowe scrapowanie i obsługa stron z dużą ilością kodu JavaScript, co jest kluczowe dla zapewnienia nieprzerwanego scrapowania. Oceniliśmy również zaawansowane funkcje, takie jak funkcje oparte na sztucznej inteligencji, wbudowane narzędzia automatyzacji i możliwość eksportowania danych w różnych formatach. Przyjrzeliśmy się szczegółowo, jak każde narzędzie pomaga gromadzić dane z wielu stron i obsługiwać dynamiczne witryny.

- Negatywy: Żadne narzędzie nie jest idealne. Zidentyfikowaliśmy potencjalne wady każdego produktu. Obejmowały one takie czynniki, jak trudna nauka obsługi klienta, ograniczenia w globalnej sieci proxy czy brak określonych funkcji. Rozważaliśmy również, czy narzędzie dobrze odpowiada konkretnym potrzebom, takim jak pozyskiwanie leadów czy badania rynku, oraz czy poradzi sobie ze scrapowaniem danych na dużą skalę.

- Wsparcie lub zwrot pieniędzy: Sprawdziliśmy, jaki rodzaj wsparcia jest dostępny. Sprawdziliśmy, czy oferują kompleksowe rozwiązanie, rzetelną obsługę klienta, fora społecznościowe i jasną politykę zwrotów. Dobry system wsparcia jest niezbędny do rozwiązywania problemów pojawiających się podczas scrapowania danych oraz do zarządzania złożonymi procesami scrapowania.

Naszym celem jest zaoszczędzenie Twojego czasu i pomoc w znalezieniu produktu, który naprawdę odpowiada Twoim potrzebom, niezależnie od tego, czy jesteś programistą, czy biznes szukam zadań automatyzacyjnych.

Podsumowanie

Wybór właściwego narzędzia do scrapowania stron internetowych to ważna decyzja, zwłaszcza jeśli jesteś użytkownikiem biznesowym.

Omówiliśmy najważniejsze funkcje niektórych z najlepszych alternatyw dla Apify, aby Ci pomóc robić najlepszy wybór.

Znalezienie narzędzia odpowiadającego Twoim potrzebom w zakresie danych jest kluczowe.

Niektóre narzędzia są idealne, jeśli nie masz umiejętności kodowania, inne zaś lepiej sprawdzą się dla programistów.

Pamiętaj, że wiele z tych platform pozwala na planowanie zadań i oferuje priorytetowe wsparcie w ramach płatnych planów.

Ceny mogą się różnić, dlatego sprawdź, od jakich cen zaczynają się płatne plany.

Zastanów się, czego potrzebujesz do swoich projektów, np. analizy nastrojów lub generowania leadów.

Następnie wybierz narzędzie, które oferuje najlepsze funkcje za najlepszą cenę.

Często zadawane pytania

Jaka jest różnica pomiędzy zautomatyzowanymi przepływami pracy a konfiguracją ręczną?

Zautomatyzowane przepływy pracy wykorzystują interfejs wizualny lub dostęp API do automatyzacji zadań. Jest to bardziej wydajne niż konfiguracja ręczna, która wymaga ciągłej konfiguracji. Można zbierać dane przy użyciu mniejszej liczby scraperów.

Jak wykorzystać web scraping do analizy konkurencji?

Web scraping dostarcza cennych, ustrukturyzowanych danych do analizy konkurencji. Pomaga zespołom sprzedaży monitorować ceny i usługi konkurencji na różnych stronach internetowych. Pozwala to na podejmowanie decyzji w oparciu o dane.

Jakie są typowe modele cenowe usług web scrapingu?

Typowy model cenowy opiera się na wykorzystaniu. Płacisz za zebrane dane. Wiele usług oferuje spersonalizowany plan cenowy dla dużych projektów, dzięki czemu płacisz tylko za to, z czego korzystasz.

Czy można użyć narzędzia web scraper do pobierania danych z dynamicznych witryn internetowych?

Tak, wiele nowoczesnych narzędzi obsługuje dynamiczne strony internetowe. Wykorzystują one przeglądarki bezgłowe do renderowania stron i potrafią obsługiwać złożony kod JavaScript. Pozwala to uzyskać ustrukturyzowane dane i doskonale nadaje się do scrapowania milionów punktów danych.

W jaki sposób agenci AI pomagają w scrapowaniu stron internetowych?

Agenci AI znacznie ułatwiają scrapowanie i automatyzację. Wykorzystują sztuczną inteligencję do zrozumienia stron internetowych i obsługi złożonego indeksowania sieci bez konieczności rozbudowanej konfiguracji. Można je zintegrować z innymi systemami, aby usprawnić procesy.