De wereld van webscraping kan behoorlijk lastig zijn, nietwaar?

Het verkrijgen van gegevens van websites betekent vaak dat je constant met IP-blokkeringen te maken krijgt.

Dit kan een enorm probleem zijn, dat u tijd en geld kost.

Dat is waar ScrapingBee om de hoek komt kijken. Maar is het wel echt de beste tool voor deze klus?

In deze ScrapingBee-review duiken we er diep in. We helpen je beslissen of het de juiste keuze is om je webscrapingprojecten in 2025 te stroomlijnen.

Lees verder om alles te weten te komen wat je moet weten. ⬇️

Krijg de gegevens Je hebt deze informatie nodig van meer dan 98% van de webpagina's. De krachtige web scraping API van ScrapingBee biedt JavaScript-rendering, de Google Search API en de mogelijkheid om gestructureerde data te extraheren met een nauwkeurigheid tot 99,5% op dynamische sites.

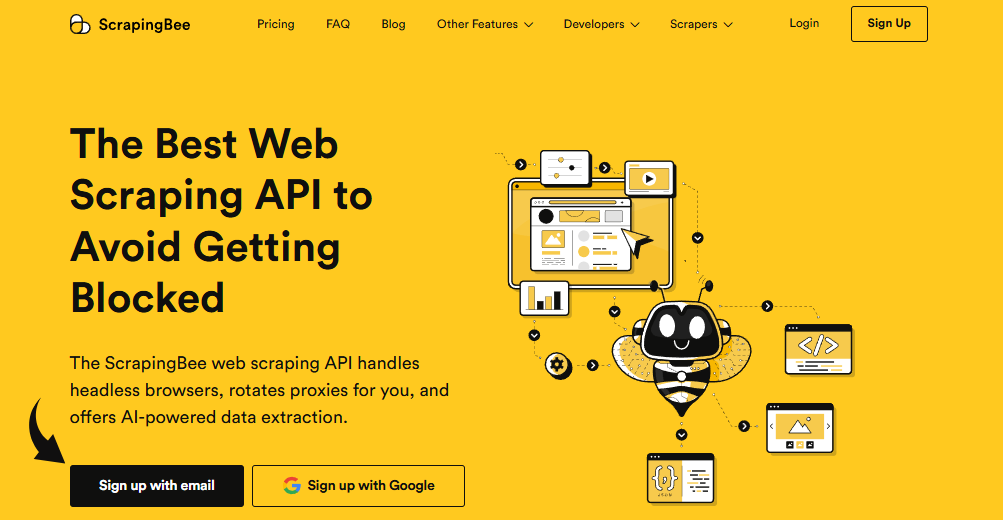

Wat is ScrapingBee?

De Scrapingbee web scraping API is een tool die het eenvoudig maakt om gegevens van het internet te halen.

Je hoeft geen expert te zijn of geavanceerde kennis van web scraping te hebben.

ScrapingBee neemt het lastige werk voor je uit handen, zoals het omgaan met proxy's, CAPTCHA's en JavaScript.

Zie het zo: in plaats van zelf een complex systeem te bouwen, vertel je ScrapingBee gewoon van welke website je gegevens wilt hebben.

De tool beheert vervolgens het volledige data-extractieproces, zodat u zonder gedoe gegevens kunt extraheren.

Het is een eenvoudige manier om informatie te verzamelen voor het bijhouden van zoekmachineposities.

Wie heeft ScrapingBee gemaakt?

ScrapingBee is gemaakt door Pierre de Wulf En Kevin Sahin.

Ze hebben het bedrijf opgericht omdat ze zagen hoe moeilijk webscraping-taken voor ontwikkelaars konden zijn.

Hun visie was om een eenvoudige en effectieve webscrapingtool te ontwikkelen.

Ze wilden een API voor ScrapingBee ontwikkelen die het technische werk zou afhandelen, zoals het beheren van proxy's en het verwerken van JavaScript-webpagina's.

Op deze manier konden gebruikers op een betrouwbare en anonieme manier de gestructureerde gegevens verzamelen die ze nodig hadden.

Ze wilden maken Webscraping is voor iedereen gemakkelijk te realiseren.

De belangrijkste voordelen van ScrapingBee

Als het gaat om webscraping, biedt ScrapingBee veel voordelen.

Het lost veel van de veelvoorkomende problemen op waar ontwikkelaars mee te maken krijgen, waardoor het data-extractieproces soepeler en betrouwbaarder verloopt.

- Omzeilt maatregelen tegen scraping: ScrapingBee maakt gebruik van roterende proxy's om te voorkomen dat je geblokkeerd wordt. Op deze manier komen je meerdere verzoeken niet van hetzelfde IP-adres.

- Verwerkt JavaScript-rendering: Het maakt gebruik van headless browsers om moderne webpagina's volledig te laden. Dit helpt je bij het scrapen van dynamische content die met een basisbrowser niet mogelijk is. schraper zou kunnen mislukken.

- Geeft toegang tot geografisch beperkte inhoud: Je kunt het wereldwijde proxynetwerk gebruiken om een website vanuit een ander land te bekijken. Hierdoor krijg je eenvoudig toegang tot geografisch beperkte content.

- Inclusief een Google Search API: Je kunt programmatisch zoekresultaten van Google ophalen met een speciale API. Dit is perfect voor SEO onderzoek of het bijhouden van ranglijsten.

- Biedt een eenvoudige gebruikersinterface: Het dashboard is eenvoudig en overzichtelijk, waardoor het gemakkelijk is om uw API-sleutels te beheren en uw gebruik te monitoren.

- Maakt het mogelijk om visuele archieven te creëren: Je kunt schermafbeeldingen van een volledige websitepagina maken. Dit is handig voor het creëren van visuele archieven of het bijhouden van ontwerpwijzigingen.

- Geen geavanceerde kennis vereist: Je hebt niet veel technische kennis nodig om het te gebruiken. De API is eenvoudig en makkelijk te leren.

- Elimineert technische problemen: Het neemt alle lastige aspecten van het scrapen voor je uit handen, zodat jij je kunt concentreren op je data in plaats van op het beheren van proxies en andere technische problemen.

Beste eigenschappen

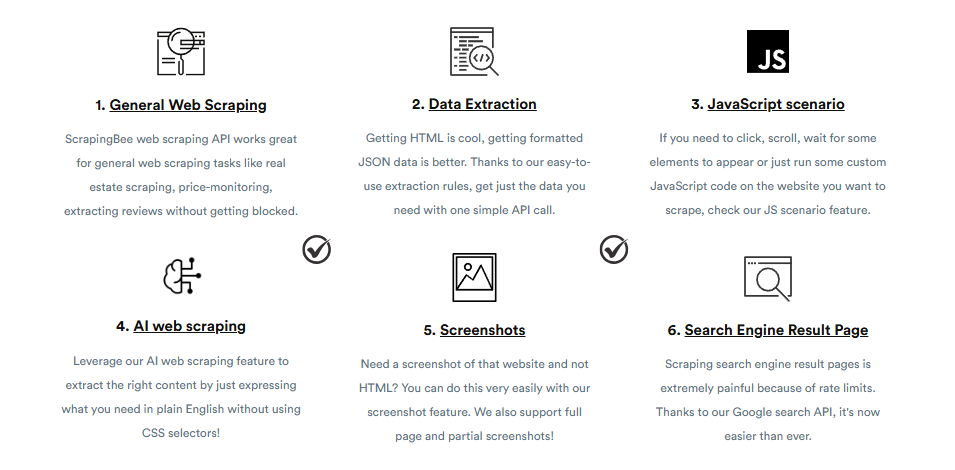

ScrapingBee biedt krachtige functies die verder gaan dan de basisprincipes van webscraping.

Deze gespecialiseerde tools zijn ontworpen om specifieke problemen op te lossen en het gemakkelijker te maken om precies de gegevens te verkrijgen die u nodig hebt, met name van lastig toegankelijke websites.

1. AI-webscraping

Je kunt gegevens van een website ophalen zonder dat je complexe code hoeft te schrijven.

Je hoeft alleen maar in begrijpelijke taal te beschrijven wat je wilt extraheren.

De AI begrijpt de pagina en vindt de gegevens voor je, zelfs als het ontwerp van de website verandert.

Dit betekent dat je niet hoeft te werken met ingewikkelde CSS-selectors of XPath.

2. Google Search API

Dit is een eenvoudige manier om zoekresultaten van Google te verkrijgen.

Je kunt de API vertellen waarnaar je wilt zoeken en de resultaten worden overzichtelijk weergegeven, zodat je ze direct kunt gebruiken.

Het voert alle anti-botmaatregelen van Google uit, zodat u altijd betrouwbare resultaten krijgt zonder geblokkeerd te worden.

3. Google Shopping Scraper

Deze functie is speciaal ontwikkeld voor het verzamelen van productinformatie van Google Shopping.

Het haalt gemakkelijk details op zoals productnamen, prijzen en beoordelingen, waardoor je geen eigen scraper hoeft te bouwen voor e-commercewebsites.

Dit kan u helpen de prijzen van concurrenten in de gaten te houden en een voorsprong op de markt te behouden.

4. JavaScript-webscraping

Veel moderne websites gebruiken JavaScript om content te laden, wat het scrapen ervan lastig kan maken.

ScrapingBee gebruikt een echte browser op de achtergrond om de pagina volledig te laden, zodat je gemakkelijk alle gegevens kunt ophalen, zelfs van dynamische websites.

Dit is essentieel voor het scrapen van single-page applicaties die zijn gebouwd met frameworks zoals React of Vue.js.

5. ChatGPT-scraper

Deze unieke functie stelt u in staat om automatisch te interageren met ChatGPT en de reacties ervan verzamelen.

Je kunt programmatisch prompts versturen en de output van de AI in een gestructureerd formaat ontvangen, wat ideaal is voor het bouwen van nieuwe AI-gestuurde applicaties.

Dit maakt handmatige kopieer- en plakworkflows overbodig en helpt je bij het schalen van je AI-interacties.

6. Google News Scraper API

Dit is een speciaal hulpmiddel om koppen en artikelen van Google News te verzamelen.

Het biedt realtime nieuwsgegevens in een gestructureerd formaat, waardoor het gemakkelijk is om actuele gebeurtenissen te volgen of mediaberichten over elk onderwerp te analyseren.

Je kunt een land selecteren om lokale nieuwsresultaten te krijgen.

7. Snelle data-scraping

ScrapingBee is ontworpen voor snelheid en efficiëntie.

De krachtige infrastructuur kan een groot aantal verzoeken tegelijk verwerken zonder vertraging, waardoor u snel en betrouwbaar grote hoeveelheden gegevens kunt verkrijgen.

Het heeft een bewezen staat van dienst op het gebied van snelle reactietijden, waardoor uw datapijplijnen soepel blijven draaien.

8. Programmatische screenshot-API

Met deze functie kunt u een schermafbeelding maken van elke webpagina.

Dit is handig voor het maken van visuele weergaven van websites, het volgen van veranderingen in de loop van de tijd, of het controleren of de verzamelde gegevens overeenkomen met wat een gebruiker zou zien.

Je kunt zelfs schermafbeeldingen van hele pagina's maken of van specifieke gedeeltes.

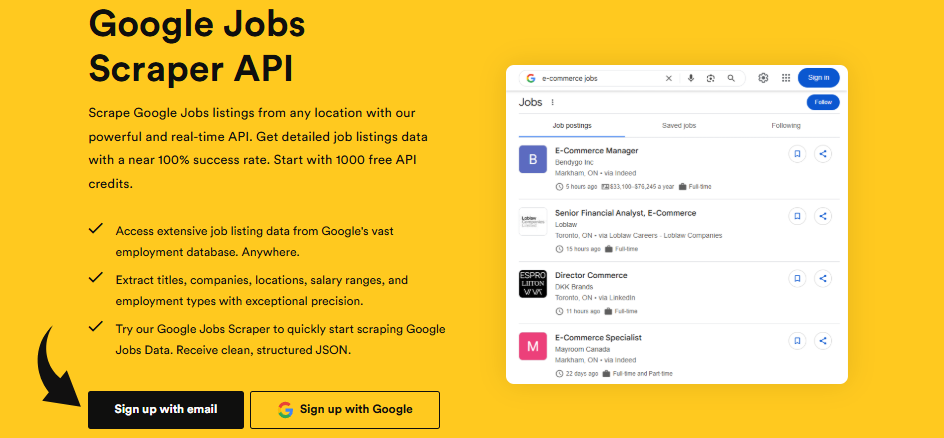

9. Google Jobs scrapen

Net als de andere scrapers die specifiek voor Google zijn ontwikkeld, is deze ontworpen om vacatures van Google Jobs te verzamelen.

U kunt met grote nauwkeurigheid details zoals functietitels, bedrijfsnamen en locaties extraheren.

Dit maakt het eenvoudig om trends in de arbeidsmarkt te volgen en onderzoek te doen naar de arbeidsmarkt.

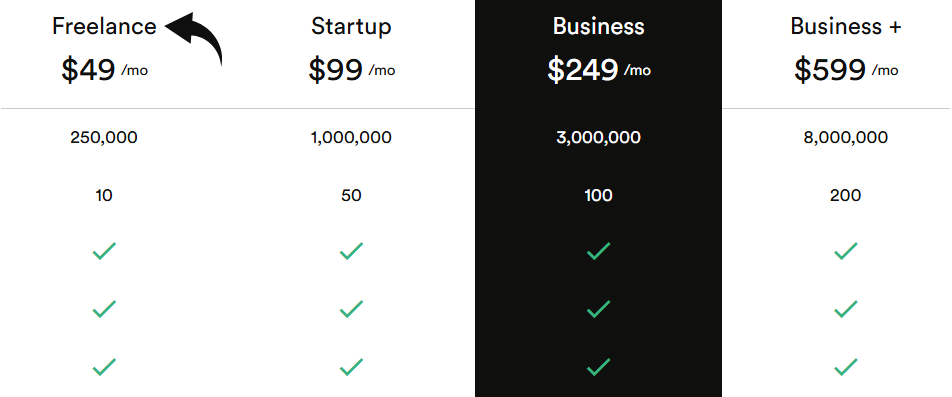

Prijzen

| Plannaam | Prijs (jaarlijks gefactureerd) |

| Freelance | $49/maand |

| Start-up | $99/maand |

| Bedrijf | $249/maand |

| Zakelijk+ | $599/maand |

Voordelen en nadelen

Voordelen

Nadelen

Alternatieven voor ScrapingBee

Als je op zoek bent naar een ander hulpmiddel voor je scrapingprojecten, zijn er veel alternatieven voor ScrapingBee beschikbaar.

Deze tools bieden een breed scala aan functies, van eenvoudige oplossingen zonder code tot krachtige platforms op bedrijfsniveau.

- ApifyDit platform biedt een breed scala aan kant-en-klare scrapers en automatiseringstools, waardoor het eenvoudig is om snel een project te starten.

- Scrapegraph AIDit is een open-source tool die gebruikmaakt van AI en grote taalmodellen (LLM's) om het scrapingproces te vereenvoudigen.

- Bright DataBright Data is een belangrijke speler op de markt en biedt krachtige proxynetwerken en diverse oplossingen voor gegevensverzameling voor grootschalige projecten.

- Blader door AIDeze tool, waarvoor geen code nodig is, gebruikt AI om je te helpen data te verzamelen en te monitoren met slechts een paar klikken, waardoor hij perfect is voor niet-programmeurs.

- OxylabsOxylabs staat bekend om zijn grote proxynetwerk en is een sterke optie voor complexe en grootschalige scrapingtaken die een hoge betrouwbaarheid vereisen.

- ThorDataDit platform biedt een enorme pool aan proxy's en een universele scraping-API, ontworpen voor het verzamelen van schone, landspecifieke gegevens op grote schaal.

- ZyteZyte, voorheen Scrapinghub, biedt een robuuste reeks tools, waaronder een krachtige API en ingebouwde compliancefuncties voor business intelligence.

- Webscraper ioDit is een populaire browserextensie waarmee je een scraper kunt bouwen met een muisklikinterface, zonder dat je hoeft te programmeren.

- HeliumschraperHelium Scraper is een desktoptool met een visuele interface, ontworpen voor gebruikers die data-extractie willen automatiseren zonder te programmeren.

- BrandweerkruipenDeze AI-gestuurde webcrawler is ontworpen voor AI-workflows en zet websites om in schone, gestructureerde data voor LLM's en andere AI-toepassingen.

Persoonlijke ervaring met ScrapingBee

Mijn team had een snelle manier nodig om gegevens te verzamelen voor een groot marktonderzoeksproject.

We moesten informatie van veel websites halen, en sommige daarvan waren moeilijk te scrapen.

We hebben besloten om de scraping-API van ScrapingBee te gebruiken om het werk te vereenvoudigen.

Het heeft ons geholpen de gewenste gegevens te verkrijgen zonder de gebruikelijke problemen.

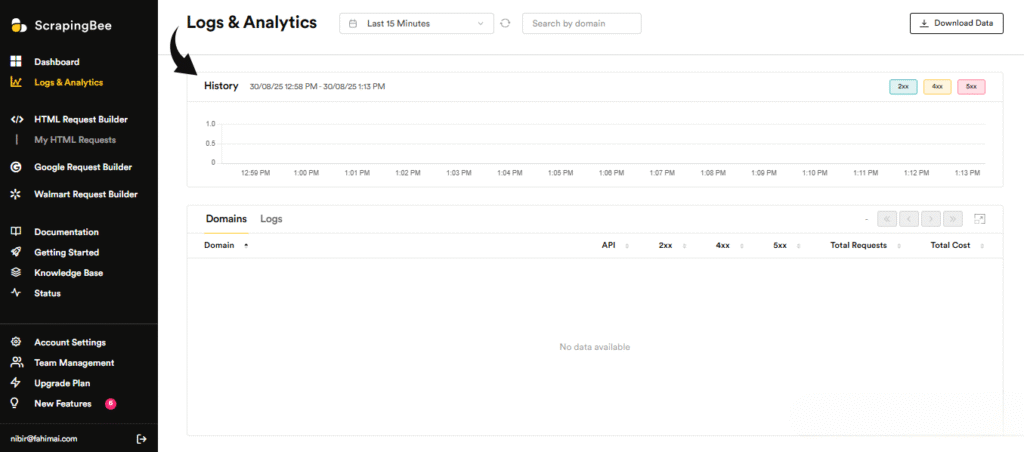

- API-toegangHet gebruik van de scraping-API was eenvoudig. We konden gegevens opvragen van de websites die we nodig hadden voor ons onderzoek. We konden onze API-credits en reguliere API-aanvragen gemakkelijk beheren via het dashboard.

- Residentiële en premium proxy'sDe websites die we probeerden te bereiken, probeerden ongewenst verkeer te blokkeren. Maar met residentiële en premium proxies leken onze verzoeken afkomstig te zijn van echte gebruikers.

- Ondersteuning voor headless browsersVeel van de websites maakten gebruik van veel JavaScript. Dankzij de ondersteuning voor headless browsers laadde ScrapingBee de volledige pagina net als een echte browser.

- AI-gestuurde data-extractieWe hebben de nieuwe, door AI aangedreven functie voor data-extractie gebruikt voor een aantal websites. We hoefden alleen maar in eenvoudige bewoordingen aan te geven welke gegevens we wilden, en de AI heeft ze voor ons gevonden.

- Google-zoekopdrachtWe hebben de tool ook gebruikt voor Google-zoekopdrachten. Hierdoor konden we snel en probleemloos veel zoekresultaten voor ons SEO-onderzoek verkrijgen.

- GegevensformatenWe vonden het prettig dat we de gegevens in verschillende formaten konden ontvangen. Dit maakte het gemakkelijk om de informatie in onze andere programma's te gebruiken.

- HTTP-headers aanpassenVoor sommige van de complexere websites moesten we ons voordoen als een specifiek type gebruiker. We konden eenvoudig HTTP-headers aanpassen om de gewenste inhoud te verkrijgen.

- RealtimegegevensEen enorm voordeel was de toegang tot realtime data en gebruiksmonitoring. We konden nieuwe informatie direct in de gaten houden zodra deze beschikbaar kwam.

- NalevingWe hebben er ook voor gezorgd dat we voldeden aan de wettelijke en compliance-eisen door alleen openbare data te scrapen. We wisten dat we de tool op de juiste manier gebruikten.

Tot slot

ScrapingBee is een uitstekende keuze voor marktonderzoek en andere activiteiten gericht op het verzamelen van gegevens.

Het maakt gebruik van een zeer geavanceerd mechanisme dat andere scrapers tegenhoudt, zoals het gebruik van premium proxies en slim proxybeheer.

Hiermee kun je websites scrapen zonder je zorgen te hoeven maken dat je geblokkeerd wordt.

Het werkt voor een eenvoudige zoekmachine of op beveiligde websites.

Je hoeft alleen maar API-verzoeken te doen, en de tool doet al het zware werk.

Hierdoor kunt u zich concentreren op de verwerking van uw gegevens in plaats van op CSS-selectors of het bestrijden van geavanceerde antibotsystemen.

Dankzij de gebruiksvriendelijkheid en de mogelijkheid om op meerdere platformen te werken, is ScrapingBee voor de meeste gebruikers een goede keuze.

Meld je aan voor een gratis proefperiode en ontvang 1.000 API-credits om te zien hoe eenvoudig het is om de gegevens te verkrijgen die je nodig hebt.

Veelgestelde vragen

Wat is het doel van de ondersteuning voor headless browsers?

De headless browser-ondersteuning van ScrapingBee is bedoeld voor het scrapen van websites met veel JavaScript en dynamische content. Het gedraagt zich als een echte gebruiker, zodat je kunt zien wat de client-side JavaScript laadt.

Hoe gaat het om met anoniem scrapen?

ScrapingBee fungeert als proxyprovider en proxyservice om anoniem scrapen te garanderen. Het roteert automatisch IP-adressen, waardoor uw API-aanroepen lijken te komen van verschillende locaties.

Kan het gebruikt worden voor zoekwoordonderzoek?

Ja, ScrapingBee is een uitstekend hulpmiddel voor zoekwoordonderzoekJe kunt de Google Search API gebruiken om websites van concurrenten te scrapen en gestructureerde zoekresultaten voor analyse te verkrijgen.

Wat zijn de grootste voordelen van het gebruik van AI-gestuurde tools?

AI-gestuurde tools zoals ScrapingBee vereenvoudigen het proces door complexe logica af te handelen. Hierdoor hoeft u niet langer zelf codefragmenten te schrijven voor verschillende websites.

Kan het visuele archieven creëren?

Ja, een belangrijk kenmerk is de mogelijkheid om visuele archieven te creëren. Je kunt schermafbeeldingen maken van volledige pagina's of specifieke onderdelen, wat erg handig is om veranderingen in gebruikersgedrag bij te houden.