AI と機械学習のワークロードの需要の増加に苦労していませんか?

ローカルハードウェアによって制限されていると感じていますか?

フラストレーションは現実です。そこでRunPodが登場します。

この RunPod のレビューでは、これが本当に AI の取り組みを強化するための最高の GPU クラウド ソリューションであるかどうかを検証します。

スケーラブルな GPU のパワーを体験する準備はできていますか? すでに 10,000 人を超えるユーザーが AI/ML のニーズに合わせて RunPod を選択し、500,000 を超えるインスタンスを起動しています。

RunPodとは何ですか?

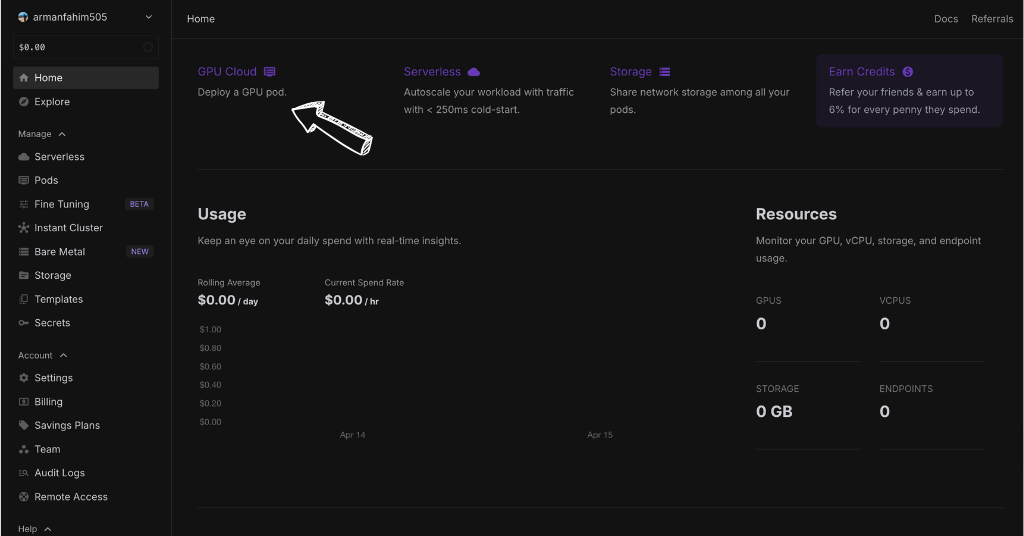

RunPod は、クラウド内に強力なコンピューターを簡単に作成できる場所と考えてください。

これらのコンピューターには、AI などの計算に非常に優れた GPU と呼ばれる特殊な部品が搭載されています。

サーバーの設定や管理について心配する必要はありません。

適切な電力のポッドなど、必要なものを選択します。

その後、このポッドに AI プロジェクトを迅速にデプロイできます。

RunPod はエンドポイントの作成にも役立ちます。

これは、他のプログラムやユーザーが AI モデルを簡単に使用できるようにする Web アドレスのようなものです。

つまり、RunPod を使用すると、複雑な技術的な手間をかけずに、強力なコンピューターを AI プロジェクトに簡単に使用できるようになります。

RunPodを作ったのは誰ですか?

RunPod は、現在の CEO である Zhen Lu によって設立されました。

同社は2022年に設立されました。

RunPod のアイデアは、AI 作業用の強力なコンピューターに簡単にアクセスできるようにする必要性から生まれました。

Zhen 氏と彼のチームは、ハードウェアの煩わしさなしに、人々が自分のニーズに合わせて強力なコンピューターをレンタルできる簡単な方法を作りたかったのです。

彼らのビジョンは、強力な コンピューティング 誰でも利用できるリソース。

AI プロジェクトを低コストで導入および拡張できるよう支援します。

RunPodの主なメリット

- 簡単なサーバーレスデプロイメント: サーバーを管理することなくAIアプリケーションを実行できます。RunPodのサーバーレスアーキテクチャがバックエンドを処理するため、コードの作成に集中できます。

- あらかじめ構築されたテンプレート: 一般的な ML フレームワークとツール用のすぐに使用できるテンプレート イメージを使用してすぐに開始し、セットアップ時間を節約できます。

- スケーラブルな推論: 需要の増加に合わせて推論ワークロードを簡単に拡張できるため、ピーク使用時でもアプリケーションの応答性が維持されます。

- 柔軟なネットワークボリューム: 適応性の高いネットワーク ボリューム オプションにより、データ センターとプロジェクトのニーズに合わせて適切な量のストレージを選択できます。

- グローバルデータセンターの所在地: さまざまなデータセンターの場所から強力なクラウド コンピューティング リソースにアクセスし、待ち時間を短縮してパフォーマンスを向上させます。

- 詳細なログ記録: 包括的なログ ファイルを使用して、アプリケーションのアクティビティを追跡し、問題を効果的にトラブルシューティングします。

- 費用対効果の高いスタートアップソリューション: スタートアップ企業や個人開発者は、競争力のある価格で強力な GPU にアクセスできるため、AI 開発が民主化されます。

- スケーラブルなエンタープライズ ソリューション: エンタープライズ クライアントは、大規模な ML 展開や要求の厳しいワークロードに RunPod のインフラストラクチャを活用できます。

- シームレスな Docker 統合: Docker を使用してコンテナ化されたアプリケーションを簡単にデプロイし、移植性と一貫性のある環境を確保します。

最高の機能

RunPod には、AI での作業をより簡単かつ迅速にする非常に優れたツールがいくつかあります。

これらの機能により、手間をかけずに強力なコンピューターをクラウドで使用できるようになります。

RunPod が提供する最高の機能のいくつかを見てみましょう。

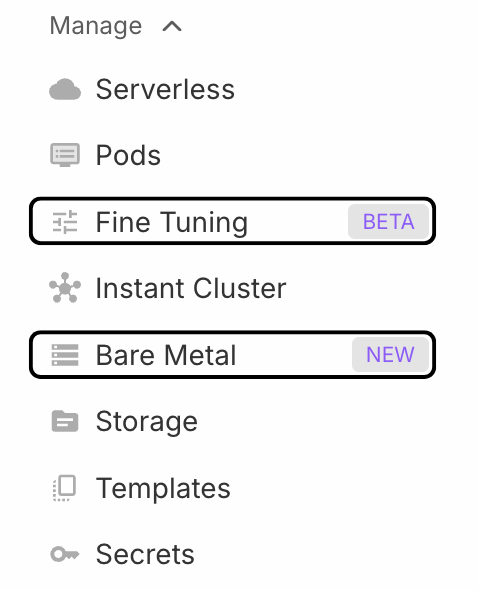

1. ポッド

RunPod を使用すると、クラウド内にある自分専用の超高速コンピューターのようなポッドをレンタルできます。

プロジェクトに必要な GPU のタイプを選択できます。

つまり、実際に使用した電力に対してのみ料金を支払うことになります。

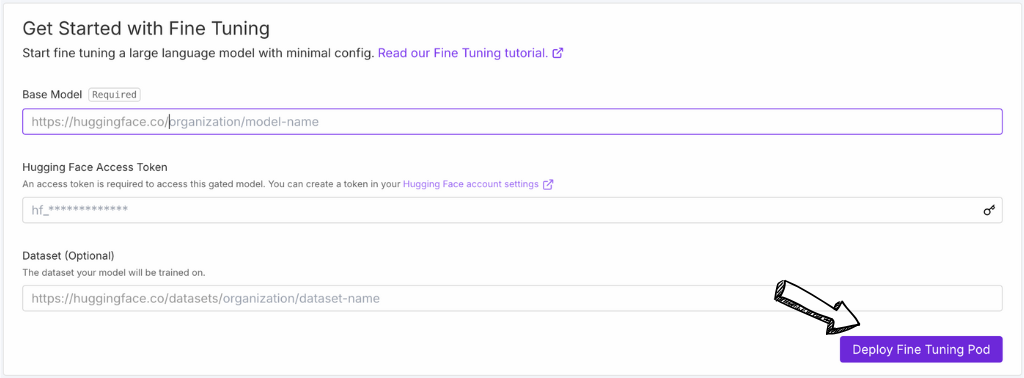

2. 微調整

微調整機能を使用すると、AI モデルに新しいことを教えるのが簡単になります。

ゼロから始める代わりに、既存のオープンソース モデルを取得し、それをデータでトレーニングすることができます。

RunPod は、これを効率的に行うためのツールを提供し、時間と労力を節約します。

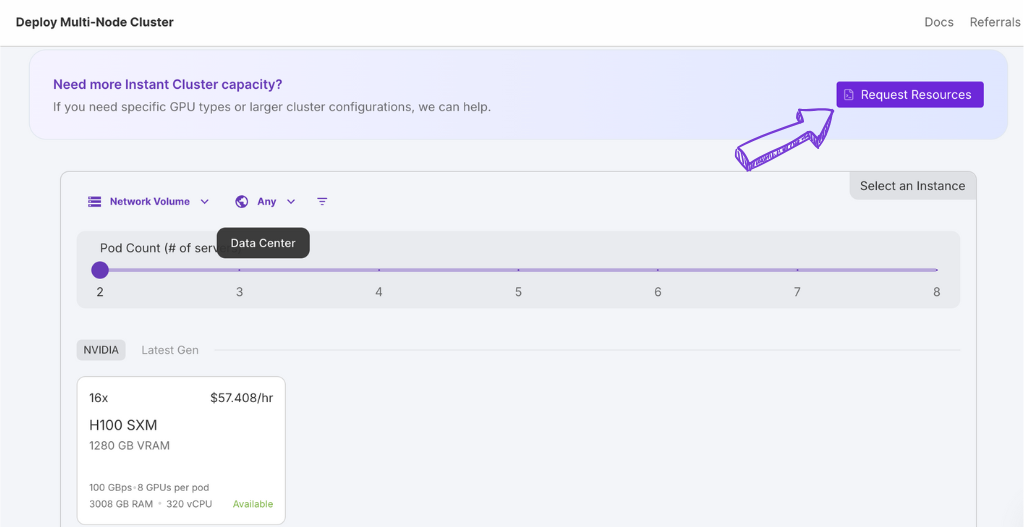

3. インスタントクラスター

さらにパワーが必要ですか?

Instant Cluster を使用すると、多数のポッド コンピューターをすばやく接続できます。

このクラウド プラットフォームでは、ミニ スーパーコンピューターを数秒で準備できるようなものです。

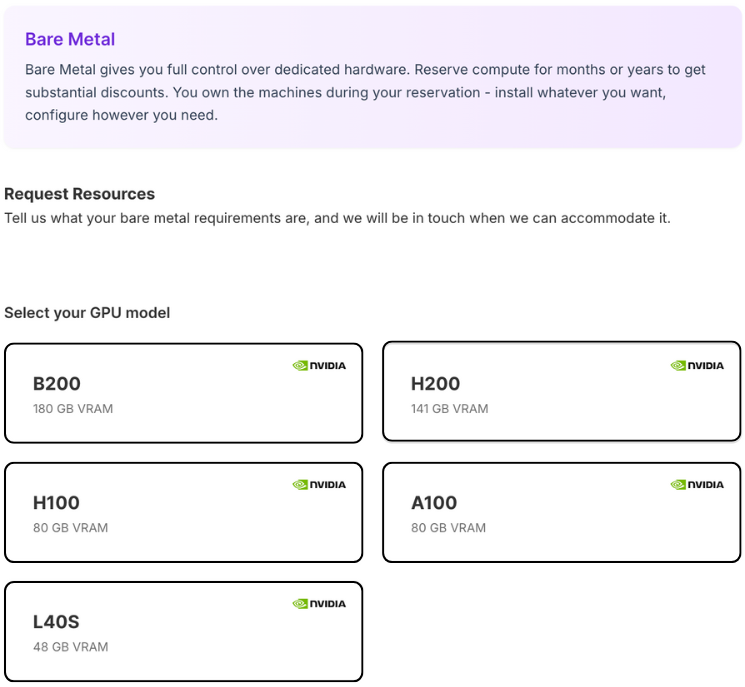

4. ベアメタル

完全な制御を望む人のために。

ベアメタルを使用すると、コンピューターのハードウェアに直接アクセスできます。

これは、あなたがすべてに対して完全な権限を持っていることを意味します。

データセンターに物理サーバーがあるのと同じですが、セットアップの手間はかかりません。

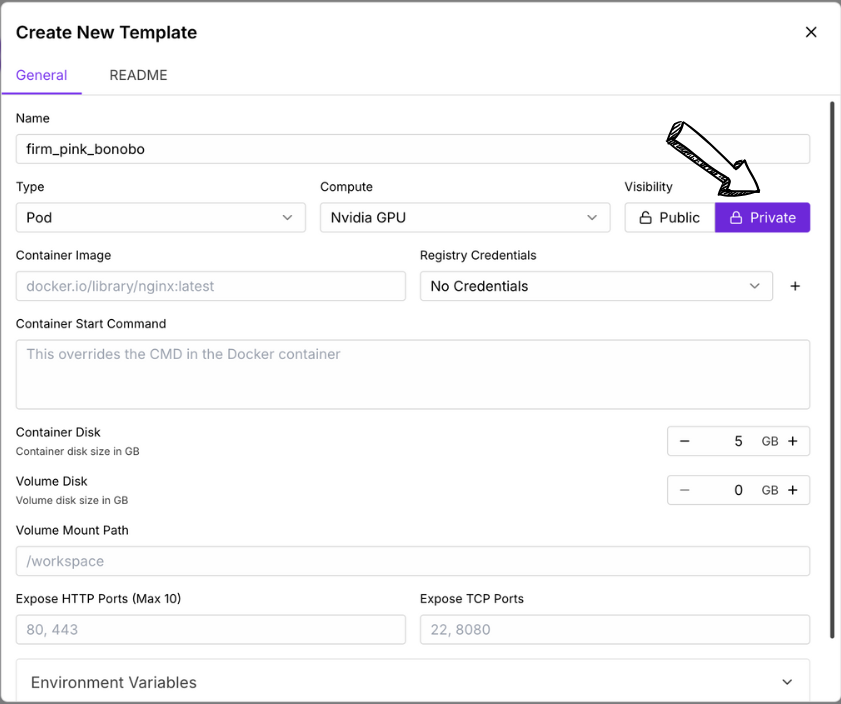

5. テンプレートメーカー

お気に入りの設定を保存しますか?

テンプレート メーカーを使用すると、カスタム テンプレート イメージを作成できます。

これは、すべてのソフトウェアと設定を保存できるため、次回同様の設定が必要になったときに、

すぐに準備完了です。

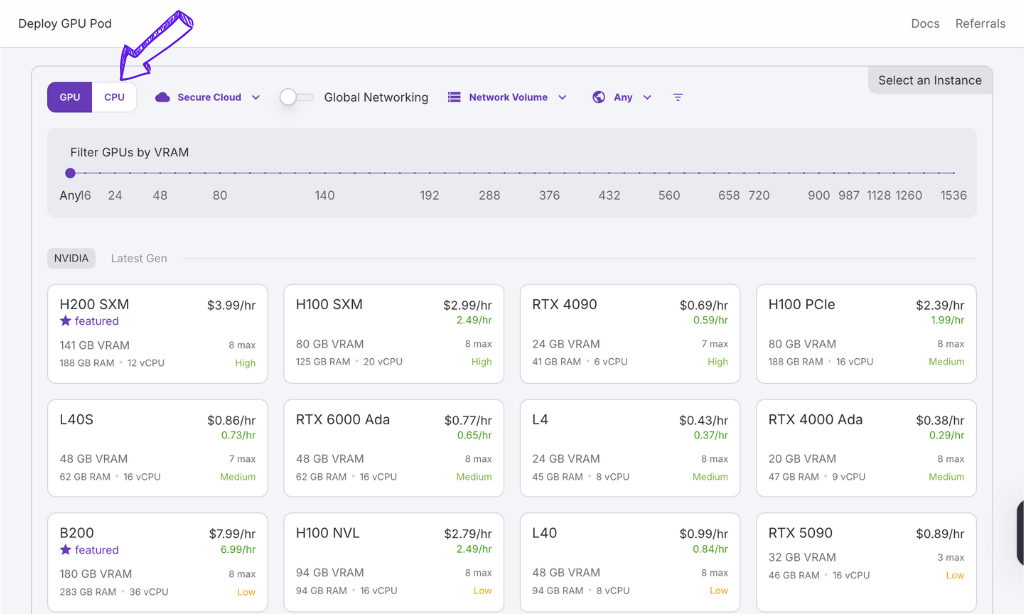

価格

| プラン名 | 開始価格 |

| H100 NVL | $2.59 |

| H200 SXM | $3.59 |

| H100 PCle | $1.99 |

| H100 SXM | $2.69 |

| A100 PCle | $1.19 |

| A100 SXM | $1.89 |

長所と短所

長所

短所

RunPodの代替品

RunPod は GPU クラウド コンピューティングに魅力的な機能を提供しますが、他にも同様のニーズに対応するプラットフォームがいくつかあります。

検討すべき代替案をいくつか示します。

- Amazon EC2(Pインスタンス付き) は、幅広いGPUインスタンスを提供する、広く利用されているクラウドプラットフォームです。成熟したエコシステムと幅広いサービスを誇りますが、小規模なスタートアップにとっては複雑で、価格が高くなる可能性があります。

- Google Cloud Platform (GCP – Compute Engine と A100/H100): 強力なGPUオプションと、機械学習およびAI推論サービスとの強力な統合を備えた、もう一つの大手クラウドコンピューティングプロバイダーです。AWSと同様に、幅広いツールスイートを提供しています。

- Microsoft Azure (NV シリーズ VM): Microsoftのクラウドプラットフォームは、計算負荷の高いタスクに最適化された様々なGPU仮想マシンを提供しています。他のMicrosoft製品やサービスとの連携も良好です。

- Lambda Labs GPUクラウド GPUクラウドコンピューティングに特化しています。競争力のある価格設定を特徴とし、ディープラーニングのワークロードに重点を置いています。オンデマンドインスタンスとリザーブドインスタンスの両方を提供しています。

- ペーパースペース: ユーザーフレンドリーなインターフェースと、従量課金制や専用インスタンスなど、多様なGPUオプションを提供します。特に機械学習の開発と展開において、その使いやすさで知られています。

- コアウィーブ: ハイパフォーマンスコンピューティングに特化し、要求の厳しいエンタープライズおよび研究ワークロード向けに最適化された強力なGPUインスタンスを提供しています。大規模な推論とトレーニングにおけるコスト効率の高さが評価されています。

特定のニーズを評価し、これらのプラットフォームと比較することで、AI プロジェクトに最適なクラウド プラットフォームを選択できるようになります。

RunPodの個人的な体験

私たちのチームでは最近、最新の AI モデルを導入するための堅牢でコスト効率の高いソリューションを必要としていました。

いくつかの選択肢を検討した後、RunPod を試してみることにしました。

私たちの経験は、特に以下の点において非常に肯定的なものでした。

- 簡単なサーバーレスエンドポイントのデプロイメント: モデル用のサーバーレスエンドポイントの設定は驚くほど簡単でした。トレーニング済みのモデルをすぐにデプロイし、簡単なAPI呼び出しでアクセスできるようになりました。

- シームレスな Docker 統合: 私たちのモデルはすでにDockerでコンテナ化されており、RunPodはこれに完璧に統合されていました。Dockerイメージのデプロイは驚くほど簡単でした。

- コスト削減: 私たちが検討したいくつかのより大規模なクラウド プラットフォーム オプションと比較して、RunPod は必要な GPU リソースに対して大幅なコスト削減をもたらしました。

- 強力な GPU への簡単なアクセス: 推論要件に一致する特定の GPU を搭載したポッドを選択できるため、過剰な出費なく最適なパフォーマンスを確保できました。

- 簡素化されたリポジトリ管理: リポジトリ (プライベート Gitlab インスタンス) からのモデルの統合は、十分に文書化されており、セットアップも簡単でした。

全体的に、RunPod は柔軟で手頃な価格のサービスを提供してくれました。

サーバーレス エンドポイントを使用して AI モデルをデプロイする効率的な方法。

彼らは GPU のパワーを活用し、既存のリポジトリからの展開プロセスを簡素化しました。

最後に

それで、RunPod はあなたにとって正しい選択でしょうか?

大金をかけずに AI 用の強力なクラウド コンピューターが必要な場合。

ぜひチェックしてみる価値があります。

事前に構築されたテンプレートとサーバーレス オプションを使用すると、簡単に始めることができます。

必要なパワーを正確に選択し、超高速 GPU をレンタルすることもできます。

AI モデルを簡単に導入し、本格的なコンピューティング能力が必要な場合は、RunPod が強力な選択肢となります。

どれだけ節約できるか、そしてどれだけ早く始められるか確認する準備はできていますか?

今すぐ RunPod にアクセスして、GPU オプションを調べてみましょう。

よくある質問

RunPod とは何でしょうか?

RunPodは、クラウド上でGPUを搭載したパワフルなコンピュータをレンタルできるサービスです。高価なハードウェアを所有することなく、AIや機械学習のタスクを簡単に実行できます。サーバーレスオプションを使用してアプリケーションをデプロイすることも、ポッド全体をレンタルすることも可能です。

RunPod の価格はいくらですか?

RunPodの料金は、GPUの種類と使用期間によって異なります。コミュニティクラウドの方が安価な場合が多く、セキュアクラウドの方が安定したパフォーマンスを提供します。最新の料金詳細は、ウェブサイトをご確認ください。

RunPod は使いやすいですか?

はい、RunPodは、特に事前に構築されたテンプレートとサーバーレスオプションを備え、ユーザーフレンドリーに設計されています。ただし、ベアメタルなどの一部の機能には、より技術的な知識が必要になる場合があります。

RunPod はどのような種類の GPU を提供していますか?

RunPod は、より手頃な価格のオプションから A100 や H100 などのハイエンド カードまで、さまざまな AI 推論および ML ワークロードに適したさまざまな GPU を提供しています。

RunPod で Docker を使用できますか?

はい、RunPod にはシームレスな Docker 統合が備わっており、コンテナ化されたアプリケーションをプラットフォーム上に簡単にデプロイできます。