Vous avez besoin de prospects qualifiés provenant de LinkedIn, mais la collecte manuelle de données est lente et fastidieuse.

Pire encore, l'utilisation d'outils bon marché et peu fiables expose l'ensemble de votre compte à un risque de restriction.

Vous craignez constamment que votre principale source de prospects ne disparaisse. Cette crainte est bien réelle.

Fragile outils de grattage Ils se cassent facilement, vous obligeant à perdre du temps à les nettoyer et vous exposant à un bannissement de compte douloureux.

Pourquoi risquer toute votre stratégie de génération de prospects avec un mauvais outil ?

Cet article présente les 7 meilleurs outils d'extraction de données LinkedIn pour 2025. Nous les avons testés en fonction de leur sécurité, de la qualité des données et de leurs puissantes fonctionnalités d'IA.

En lisant ceci, vous découvrirez l'outil fiable qui protège votre compte tout en vous fournissant les données propres et en grande quantité dont vous avez besoin.

Prêt à mettre en marche votre moteur principal ?

Quel est le meilleur outil d'extraction de données LinkedIn ?

Choisir le bon outil de grattage n'est pas chose facile.

Il vous faut un système puissant capable de gérer une protection anti-bot complexe.

Vous avez également besoin d'un outil qui fournisse systématiquement des données propres et structurées.

Arrêtez de perdre du temps à tester différentes options.

Nous avons classé les 7 meilleures plateformes pour vous aider à choisir celle qui correspond le mieux à vos besoins professionnels en matière de données à grande échelle.

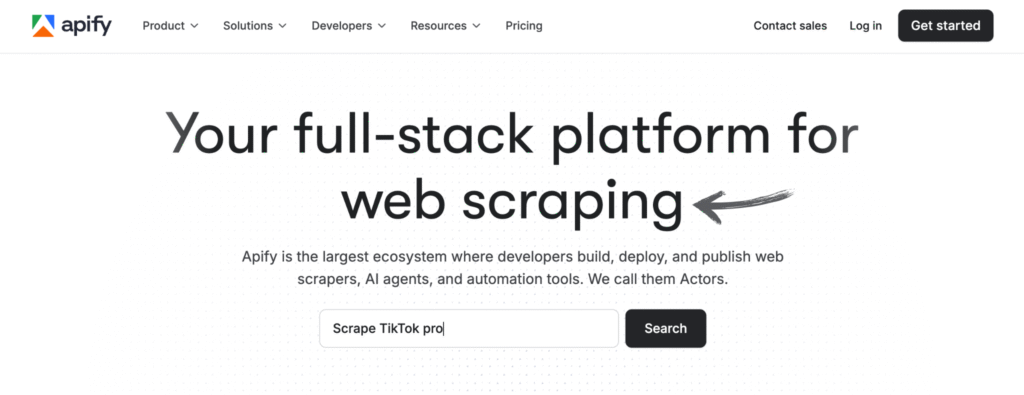

1. Apify (⭐️4,6)

Apify est une plateforme complète permettant de créer et d'exécuter des robots d'extraction de données Web.

Il offre des milliers d'« acteurs » pré-construits pour gérer les tâches de récupération et peut transformer n'importe quel site Web en une API en direct et prête à l'emploi.

Notre avis

Envie de constater par vous-même la puissance d'Apify ? Notre plateforme a permis d'extraire des données de plus de 2,5 millions de pages web et de traiter plus de 500 To de données en un seul mois. Prêt à vous lancer ?

Principaux avantages

- Marché massif : L'Apify Store propose plus de 5 000 outils d'extraction et d'automatisation prêts à l'emploi, appelés Actors.

- Évolutivité ultime : Conçu pour les tâches de niveau entreprise, il peut gérer des analyses à grande échelle de millions de pages.

- Adapté aux développeurs : Fournit un SDK open source et prend en charge le code personnalisé en Python et JavaScript.

- Planification avancée : Automatisez vos tâches de web scraping pour qu'elles s'exécutent à des heures ou à des intervalles spécifiques, sans aucune intervention manuelle.

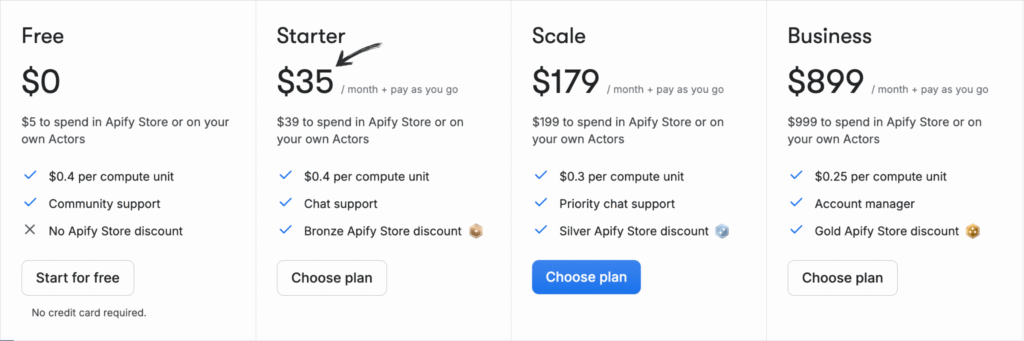

Tarification

Tous les plans seront facturé annuellement.

- Gratuit: 0 $/mois + Paiement à l'utilisation.

- Démarreur: 35 $/mois + Paiement à l'utilisation.

- Échelle: 179 $/mois + Paiement à l'utilisation.

- Entreprise: 899 $/mois + Paiement à l'utilisation.

Avantages

Cons

2. ScrapingBee (⭐️4,4)

ScrapingBee est une API de web scraping qui gère les aspects les plus complexes pour vous.

Il gère la rotation des proxys, la navigation sans interface graphique et la gestion des bloqueurs afin que vous puissiez vous concentrer sur l'obtention des données dont vous avez besoin.

Notre avis

Obtenez le données Vous avez besoin de données provenant de plus de 98 % des pages web. La puissante API de web scraping de ScrapingBee offre le rendu JavaScript, l'API de recherche Google et la possibilité d'extraire des données structurées avec une précision allant jusqu'à 99,5 % sur les sites dynamiques.

Principaux avantages

- Il s'occupe de tout pour vous : Il gère automatiquement la rotation des proxys et le rendu JavaScript.

- API simple : Vous obtenez des données propres en retour grâce à un simple appel API.

- Disponibilité de 99,9 % : La plateforme est reconnue pour sa grande fiabilité et ses performances constantes.

- Documentation exhaustive : Fournit une documentation claire et complète avec des exemples de code pour plusieurs langages, facilitant ainsi la prise en main.

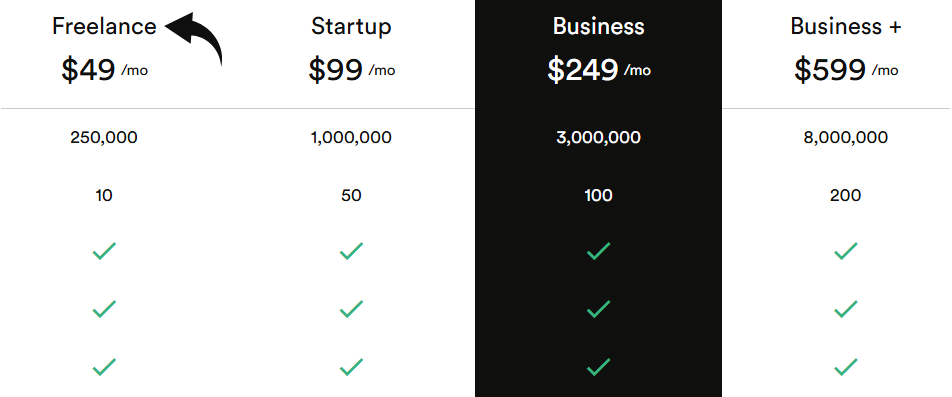

Tarification

Tous les plans seront facturé annuellement.

- Free-lance: 49 $/mois.

- Démarrer: 99 $/mois.

- Entreprise: 249 $/mois.

- Affaires+ : 599 $/mois.

Avantages

Cons

3. Parcourir l'IA (⭐️4,2)

Il s'agit d'un outil sans code qui vous permet de transformer n'importe quel site web en source de données.

Vous pouvez l'utiliser pour surveiller les modifications apportées aux sites web et extraire des informations spécifiques en un seul clic.

Notre avis

Prêt à gagner du temps et à obtenir les données dont vous avez besoin ? Browse AI peut traiter des millions de sites web. Découvrez la simplicité du web scraping.

Principaux avantages

- Aucun code requis : Son interface intuitive permet à n'importe qui de créer un outil d'extraction de données en quelques minutes.

- Adaptabilité basée sur l'IA : L’outil s’adapte automatiquement aux changements de mise en page d’un site web, garantissant ainsi la cohérence de vos données.

- Plus de 7 000 intégrations : Connectez facilement vos données collectées à des applications comme Google Sheets, Airtable et Zapier.

- Robots pré-assemblés : Accédez à une bibliothèque de robots préconfigurés pour les tâches courantes sur les sites web populaires, et gagnez ainsi encore plus de temps.

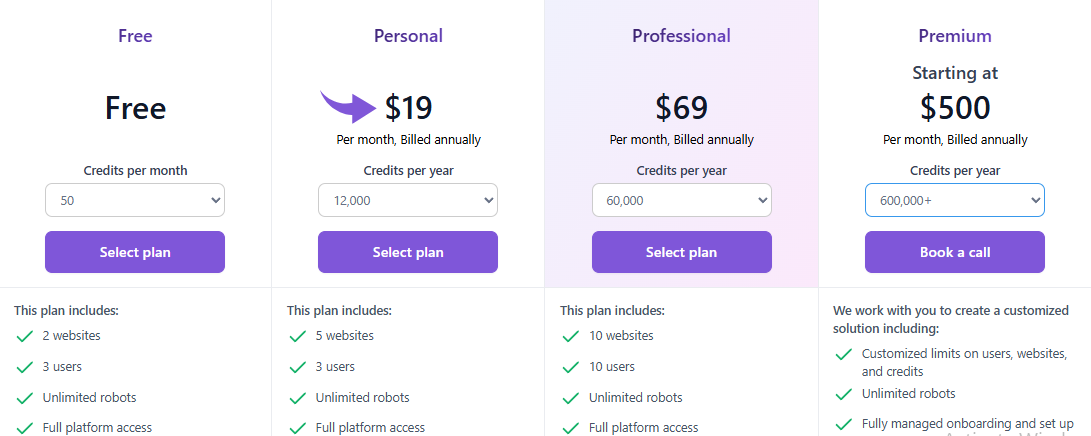

Tarification

Tous les plans seront facturé annuellement.

- Gratuit: $0.

- Personnel: 19 $/mois.

- Professionnel: 69 $/mois.

- Prime: À partir de 500 $/mois.

Avantages

Cons

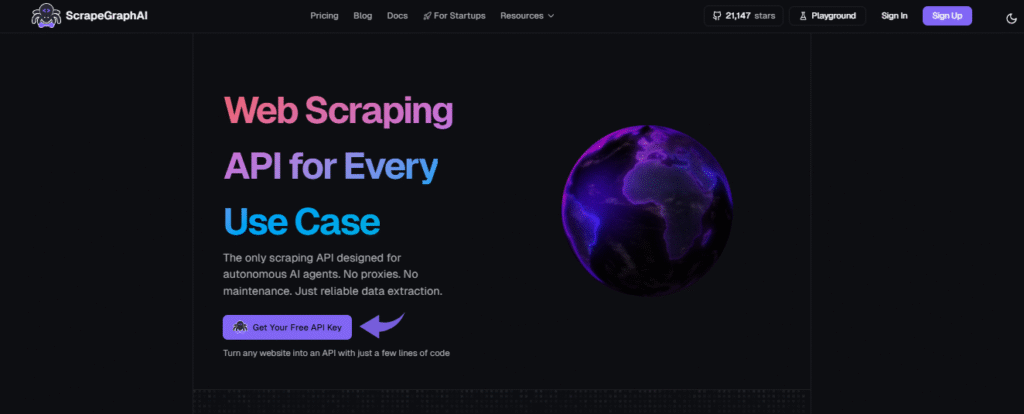

4. ScrapeGraphAI (⭐️3,8)

Cet outil utilise l'IA pour comprendre les pages web et extraire des données à partir d'un simple texte commande.

C'est un excellent choix si vous souhaitez obtenir des données sans aucune programmation.

C'est rapide et intelligent.

Notre avis

Plus de 350 professionnels de renom font confiance à ScrapeGraphAI pour ses puissantes capacités d'extraction de données web basées sur l'IA. Bénéficiez d'une amélioration de votre efficacité de 20 % pendant les prochaines 48 heures.

Principaux avantages

- Extraction de données en langage naturel : Vous pouvez lui indiquer les données à extraire à l'aide d'instructions simples et intuitives.

- Bibliothèque open source : Les développeurs peuvent utiliser sa puissante bibliothèque open source pour un contrôle maximal.

- Fonctionnalité Markdownify : Il peut convertir des pages web entières en documents Markdown propres et lisibles.

- Scraper agentique : L'IA peut naviguer et interagir de manière autonome avec les sites web pour accomplir des tâches complexes en plusieurs étapes.

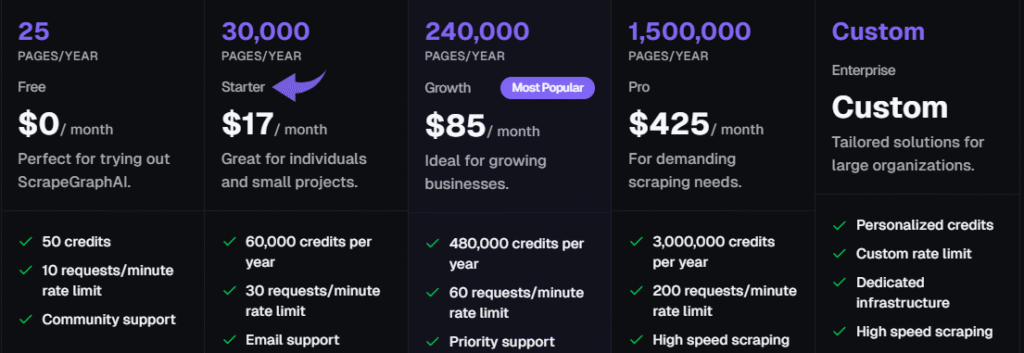

Tarification

Tous les plans seront facturé annuellement.

- Gratuit: 0 $/mois.

- Démarreur: 17 $/mois.

- Croissance: 85 $/mois.

- Pro: 425 $/mois.

- Entreprise: Tarification personnalisée.

Avantages

Cons

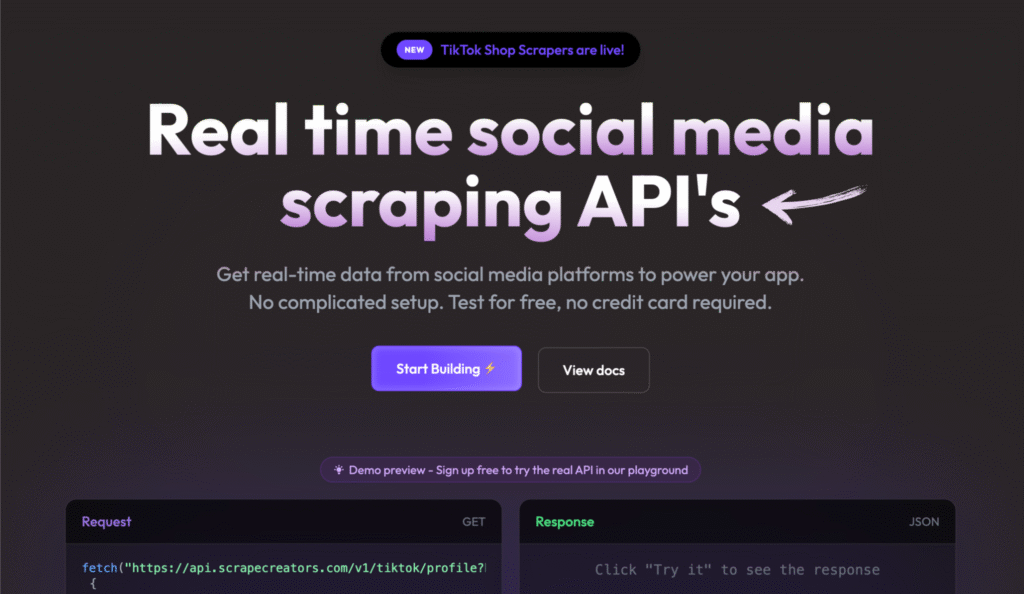

5. Créateurs de scraping (⭐️3,6)

Il s'agit d'un outil puissant, conçu selon une approche API-first.

Il est conçu pour obtenir des données structurées en temps réel à partir de sites web complexes.

Il gère pour vous les mesures anti-bots et la rotation des proxys.

Vous n'avez pas besoin de vous soucier de coder un scraper distinct pour chaque modification du site.

Vous envoyez une requête API, et elle vous renvoie des données propres.

Il s'agit d'une option flexible, à la carte, destinée aux développeurs et aux utilisateurs techniques.

Notre avis

Ne perdez plus de temps à collecter des données sur les réseaux sociaux. Avec Scrape Creators, obtenez des données en temps réel depuis des plateformes comme Twitch et Pinterest. Rejoignez les centaines d'utilisateurs qui ont déjà analysé plus de 6 millions de requêtes et exploitez les informations dont vous avez besoin.

Principaux avantages

- API spécialisées : Propose des solutions préconfigurées spécifiquement pour les plateformes de médias sociaux.

- Aucune clé API requise : Vous pouvez ainsi vous passer des clés API officielles fournies par des sites comme Twitch.

- Paiement à l'utilisation : Vous ne payez que ce que vous utilisez, et vos crédits n'expirent jamais.

- Données JSON riches : Les API fournissent des données JSON propres et structurées, vous évitant ainsi tout traitement supplémentaire.

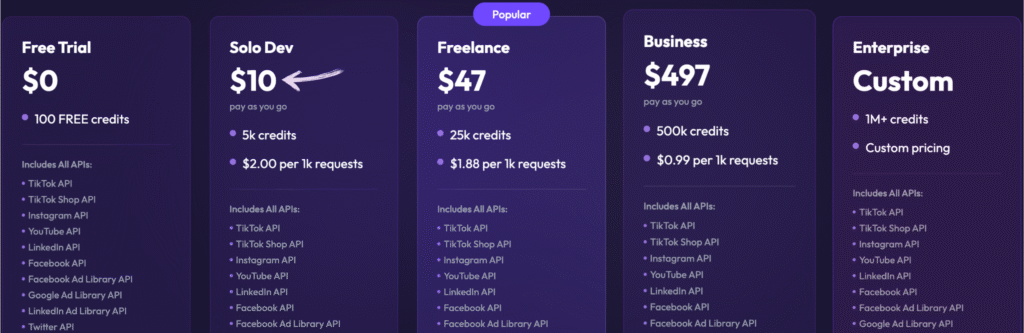

Tarification

- Essai gratuit : 0 $, 100 crédits gratuits.

- Développeur solo : 10 $ – Paiement à l'utilisation, 5k crédits.

- Free-lance: 47 $ – Paiement à l'utilisation, 25 000 crédits.

- Entreprise: 497 $ × Paiement à l'utilisation, 500 000 crédits.

- Entreprise: Tarification personnalisée, plus d'un million de crédits.

Avantages

Cons

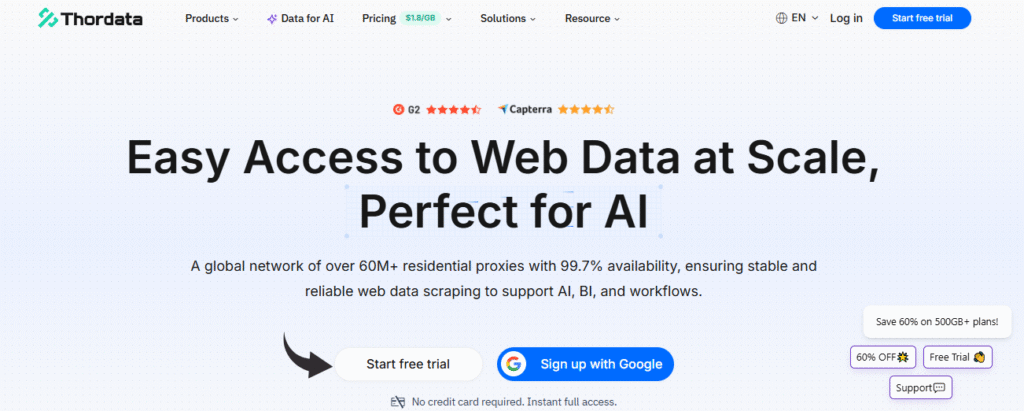

6. ThorData (⭐️3.2)

Cet outil est une plateforme tout-en-un de grande envergure pour les données web.

C'est bien plus qu'un simple outil d'extraction de données LinkedIn.

ThorData propose un vaste réseau de plus de 60 millions de proxys résidentiels.

C'est essentiel pour rester indétectable. Ils fournissent des API spécialisées et même un outil d'extraction de données sans code. constructeur.

Les développeurs et les entreprises l'utilisent pour automatiser la collecte de données à grande échelle.

Ils gèrent toute l'infrastructure, vous ne recevez donc que des données propres.

Notre avis

Bénéficiez d'une sécurité inégalée avec ThorData. données Le processus de vérification garantit un taux de réussite de 99,7 %. Avec une assistance en direct 24 h/24 et 7 j/7 et un temps de réponse moyen inférieur à 3 minutes, vous pouvez avoir confiance en la qualité de votre connexion. Bénéficiez de plus de 60 millions d'adresses IP et sécurisez vos données.

Principaux avantages

- Vaste pool d'adresses IP : Offre plus de 60 millions d'adresses IP résidentielles issues de sources éthiques.

- Anonymat élevé : Grâce à ses proxys de haute qualité, votre activité de scraping reste indétectable.

- Paiement à l'utilisation : La facturation est transparente ; vous ne payez que pour le trafic que vous utilisez, et non pour les requêtes ayant échoué.

- Scraper intégré : Inclut un outil d'extraction de données Web sans code et une API universelle, vous n'avez donc pas besoin d'un outil séparé pour les projets simples.

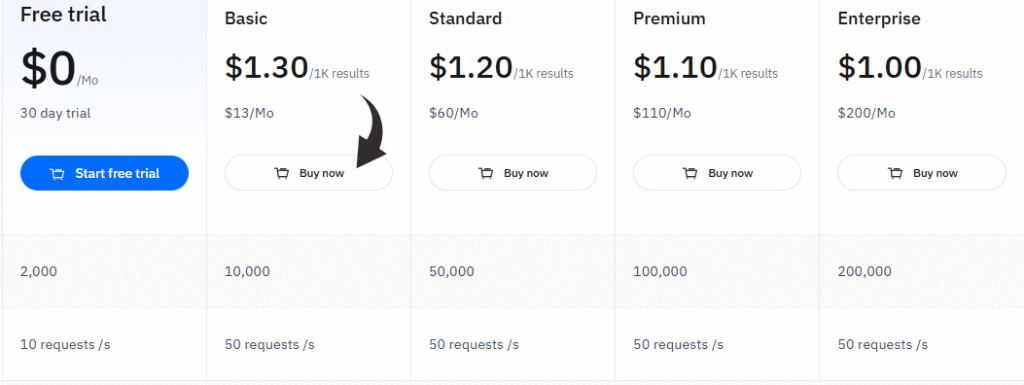

Tarification

- Essai gratuit : 0 $/mois, essai gratuit de 30 jours.

- Basique: 13 $/mois.

- Standard: 60 $/mois.

- Prime: 110 $/mois.

- Entreprise: 200 $/mois.

Avantages

Cons

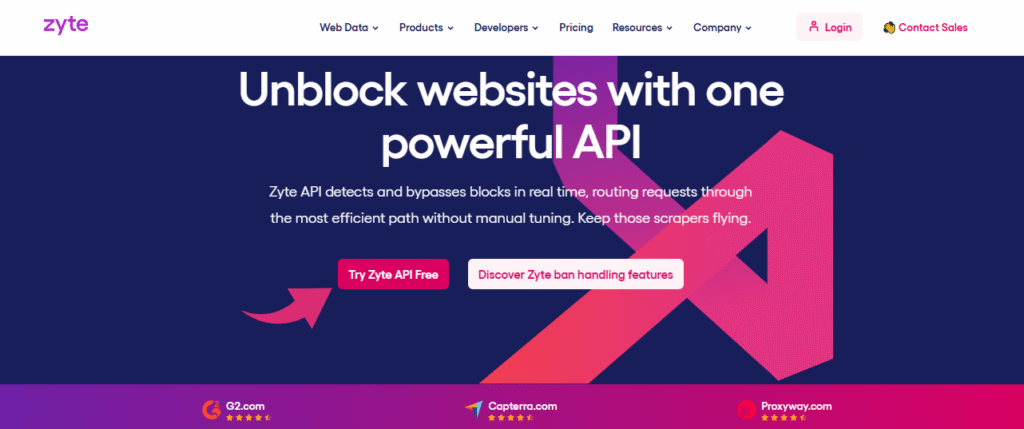

7. Zyte (⭐️3.0)

Zyte est une suite logicielle de scraping tout-en-un.

Il intègre le gestionnaire de proxy intelligent, qui utilise l'IA pour gérer automatiquement les bannissements, les CAPTCHA et la rotation des proxys.

Cela vous permet de vous concentrer sur les données, et non sur la gestion technique.

Il s'agit d'une solution robuste, adaptée aux entreprises ayant des besoins importants en données.

Notre avis

Obtenez le site web le plus fiable données Avec l'API Zyte, atteignez une précision de données de 99,99 % pour vos projets grâce à cette API de web scraping de haute qualité et optimisez votre processus d'extraction de données dès aujourd'hui.

Principaux avantages

- Déblocage automatique : Arrêtez de jongler avec les proxys ; l'API Zyte est un outil automatisé puissant pour gérer les bannissements.

- Intégration transparente de Scrapy : Si vous êtes un développeur qui utilise le framework Scrapy, Zyte s'intègre parfaitement.

- Extraction de données basée sur l'IA : Cet outil peut identifier et analyser automatiquement les données, réduisant ainsi le besoin de règles d'analyse manuelles.

- Navigateur sans interface graphique intégré : Pas besoin de navigateurs headless tiers, car Zyte en fournit un optimisé pour le web scraping à grande échelle.

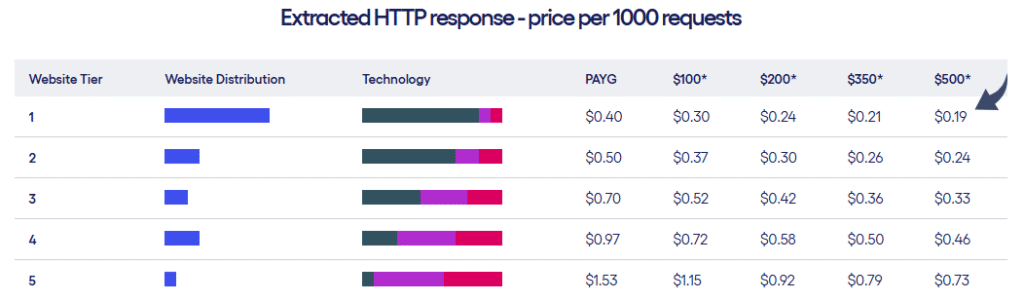

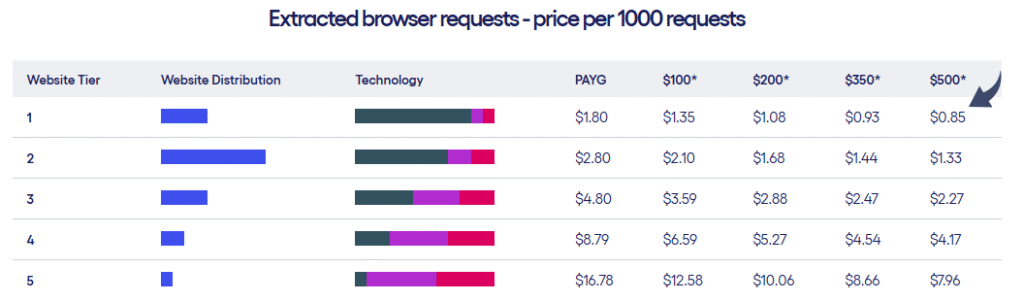

Tarification

- Zyte propose deux types de formules tarifaires en fonction du niveau de sites web et du nombre de requêtes effectuées.

Avantages

Cons

Quels sont les critères à prendre en compte lors de l'achat d'un outil d'extraction de données LinkedIn ?

Choisir un outil de données d'entreprise est une décision importante. entreprise.

Vous achetez une infrastructure, pas une simple extension.

Votre choix doit garantir la sécurité, la rapidité et la qualité des données pour votre système basé sur l'IA. sensibilisation ou une analyse de marché.

Voici ce qui distingue les meilleurs outils des autres :

- Antidétection et rotation IP : L'outil doit comporter un vaste réseau de rotors. Procurations résidentiellesC'est crucial. Utiliser une adresse IP réelle et différente pour chaque requête donne une apparence humaine à votre activité. C'est le système de sécurité informatique indispensable pour éviter les bannissements.

- Mimétisme du comportement humain : Recherchez des fonctionnalités qui vont au-delà de la simple lenteur. L'outil doit imiter les mouvements réels de la souris, les vitesses de défilement aléatoires et la navigation complexe. Les comportements prévisibles sont bloqués ; un comportement humain est autorisé.

- Gestion dynamique du contenu : Les pages LinkedIn utilisent beaucoup de JavaScript. Un bon outil d'extraction de données doit pouvoir interpréter correctement ce contenu dynamique. Dans le cas contraire, vous passerez à côté de champs de données essentiels comme l'historique professionnel complet ou les compétences.

- Sortie de données structurées : Les données ne peuvent pas se présenter sous forme de texte brut. Les meilleurs outils analysent automatiquement le code HTML brut et génèrent des fichiers JSON ou CSV propres et structurés. Vos données sont ainsi prêtes à être utilisées. CRM ou les outils AI Copilot instantanément.

- Évolutivité et accès API : Vous devez pouvoir exécuter des centaines de milliers de requêtes de manière fiable. Les solutions privilégiant les API (comme celles que nous recommandons) sont conçues pour évoluer. Elles vous permettent d'intégrer la collecte de données directement dans vos systèmes internes.

- Exhaustivité et fraîcheur des données : L'outil doit garantir que les données demandées (intitulé du poste, lieu, taille de l'entreprise) sont systématiquement collectées et que les données fournies sont en temps réel, et non issues d'un cache obsolète.

Comment les outils d'extraction de données LinkedIn peuvent-ils vous être utiles ?

Les outils professionnels d'extraction de données LinkedIn vous permettent de collecter à grande échelle des données LinkedIn telles que les intitulés de poste et les URL des profils LinkedIn à des fins d'études de marché.

Ces outils d'extraction de données de profils LinkedIn fournissent aux équipes commerciales et marketing des données précises et des informations précieuses à partir de données publiques.

Exportez les nouvelles données dans un fichier CSV pour une intégration transparente avec votre système. CRM systèmes.

Voici la méthode sûre et automatisée pour tirer parti de ce réseau social professionnel.

Guide d'achat

Lors de la recherche du meilleur LinkedIn outil d'automatisation, nous avons évalué ces facteurs critiques.

Notre méthodologie était axée sur la sécurité, la fonctionnalité et l'adéquation aux besoins des utilisateurs professionnels en entreprise :

- Sécurité et conformité : Nous avons vérifié le bon fonctionnement de l'outil en simulant un compte LinkedIn connecté sans déclencher d'alerte. Le respect des lois sur la protection des données lors de la collecte de données publiques a été un facteur déterminant.

- Capacités de ciblage : Nous avons évalué la capacité de l'outil à effectuer une recherche ciblée sur LinkedIn et à gérer des résultats de recherche complexes. Cela comprenait l'examen des filtres pour LinkedIn Sales Navigator, les membres des groupes LinkedIn et les pages d'entreprise.

- Qualité et enrichissement des données : Nous avons évalué la capacité de l'outil à agréger les données et à fournir des données de haute qualité sur les profils et les profils des employés. Parmi les principaux constats, citons la possibilité de trouver une adresse électronique vérifiée et de collecter des données firmographiques.

- Fonctionnalités avancées et intégration : Nous avons privilégié les outils offrant des fonctionnalités avancées telles que la prospection multicanale, l'extraction d'offres d'emploi et une intégration directe et fluide avec d'autres outils et le stockage cloud (comme Google Sheets). Nous avons également recherché un accès par clé API et la prise en charge des options d'extraction sans code.

- Évolutivité et utilisation en entreprise : Nous avons envisagé des plateformes conçues pour la mise à l'échelle, telles que Données clairesCes outils permettent de collecter des données provenant de plusieurs profils et d'extraire des informations de ces profils via une API. Cela détermine si l'outil convient aux ingénieurs logiciels ou aux grandes équipes en charge des outils de vente.

- Évaluation de la valeur (tarification et assistance) : Nous nous opposons à l'ensemble complet des fonctionnalités, à la disponibilité d'un forfait gratuit et à un support client robuste.

- État des fonctionnalités : Nous avons veillé à ce que l'outil d'extraction puisse accéder à toutes les données disponibles nécessaires à l'analyse des tendances et fournir des coordonnées complètes pour une prise de contact personnalisée. Nous avons confirmé sa capacité à extraire des profils et des données d'entreprises.

Conclusion

Nous avons parcouru beaucoup de terrain aujourd'hui.

Vous avez découvert les 7 meilleures plateformes d'extraction de données LinkedIn, conçues pour une extraction de données robuste et sécurisée.

La principale leçon est claire : les extensions de navigateur simples sont risquées.

Les meilleurs outils sont des API de niveau entreprise comme Bright Data et Oxylabs.

Ils utilisent des réseaux de proxy massifs et rotatifs pour assurer la sécurité de votre compte.

Choisir l'un de ces outils de premier ordre signifie que vous n'aurez plus à vous soucier d'être banni.

Vous commencez à recevoir des données propres et de haute qualité directement dans vos systèmes.

Cela permet à votre équipe commerciale de se concentrer sur la vente, et non sur la collecte de données.

Ne mettez pas votre entreprise en péril avec des outils bon marché.

Choisissez une plateforme robuste et automatisez votre croissance en toute sécurité.

Foire aux questions

Quel type de données puis-je obtenir grâce à un outil d'extraction de données LinkedIn ?

Vous pouvez accéder à la quasi-totalité des données publiques, notamment les intitulés de poste, les informations sur les sites web des entreprises et les tendances sectorielles agrégées. Ces données sont idéales pour générer des prospects et réaliser des études de marché.

Est-il interdit de récupérer des données LinkedIn ?

Oui, les fonctionnalités d'automatisation qui extraient toutes les données contreviennent aux conditions d'utilisation de LinkedIn. Cependant, la jurisprudence autorise le web scraping de données publiques. Utilisez un outil fiable comme Bright Data pour respecter les bonnes pratiques et la législation sur la protection des données.

Comment utiliser les données collectées pour la sensibilisation ?

Les outils de web scraping peuvent-ils trouver des adresses e-mail ?

Oui. De nombreux outils d'automatisation avancés s'intègrent à des services tiers comme People Data Labs pour trouver et vérifier les adresses e-mail. Ces outils enrichissent toutes les données collectées sur les pages de profil.

Pourquoi ai-je besoin de fonctionnalités d'automatisation pour les études de marché ?

Les fonctionnalités d'automatisation permettent de collecter beaucoup plus rapidement toutes les données nécessaires à l'analyse des tendances et aux études de marché qu'avec les méthodes manuelles. Vous pouvez ainsi surveiller vos concurrents et suivre les tendances du secteur en temps réel, et obtenir des informations précieuses et immédiates.